機器之心報道

編輯:小舟

人工智慧必須理解物體之間的潛在關係才能更好地與世界互動。

人們觀察場景通常是觀察場景中的物體和物體之間的關係。比如我們經常這樣描述一個場景:桌面上有一臺膝上型電腦,膝上型電腦的右邊是一個手機。

但這種觀察方式對深度學習模型來說很難實現,因為這些模型不瞭解每個物件之間的關係。如果不瞭解這些關係,功能型機器人就很難完成它們的任務,例如一個廚房機器人將很難執行這樣的命令:「拿起炒鍋左側的水果刀並將其放在砧板上」。

為了解決這個問題,在一篇 NeurIPS 2021 Spotlight 論文中,來自 MIT 的研究者開發了一種可以理解場景中物件之間潛在關係的模型。該模型一次表徵一種個體關係,然後結合這些表徵來描述整個場景,使得模型能夠從文字描述中生成更準確的影象。

論文地址:https://arxiv.org/abs/2111.09297

現實生活中人們並不是靠座標定位物體,而是依賴於物體之間的相對位置關係。這項研究的成果將應用於工業機器人必須執行復雜的多步驟操作任務的情況,例如在倉庫中堆疊物品、組裝電器。此外,該研究還有助於讓機器能夠像人類一樣從環境中學習並與之互動。

每次表徵一個關係

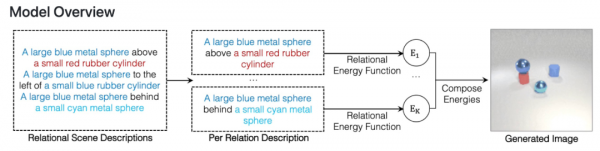

該研究提出使用 Energy-Based 模型將個體關係表徵和分解為非規一化密度。關係場景描述被表徵為關係中的獨立機率分佈,每個個體關係指定一個單獨的影象上的機率分佈。這樣的組合方法可以建模多個關係之間的互動。

該研究表明所提框架能夠可靠地捕獲和生成帶有多個組合關係的影象,並且能夠推斷潛在的關係場景描述,並且能夠穩健地理解語義上等效的關係場景描述。

在泛化方面,該方法可以推廣到以前未見過的關係描述上,包括物件和描述來自訓練期間未見過的資料集。這種泛化對於通用人工智慧系統適應周圍世界的無限變化至關重要。

以往的一些系統可能會從整體上獲取所有關係,並從描述中一次性生成影象。然而這些模型不能真正適應新增更多關係的影象。相比之下,該研究的方法將單獨的、較小的模型組合在一起,能夠對更多的關係進行建模並適應新的關係組合。

此外,該系統還可以反向工作——給定一張影象,它可以找到與場景中物件之間的關係相匹配的文字描述。該模型還可透過重新排列場景中的物件來編輯影象,使它們與新的描述相匹配。

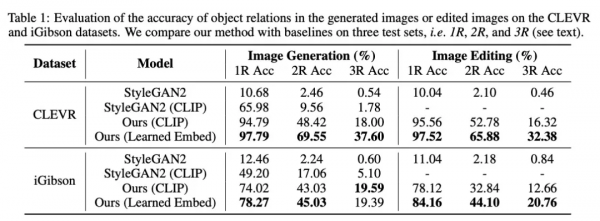

研究人員將他們的模型與幾種類似深度學習方法進行了比較,實驗表明在每種情況下,他們的模型都優於基線。

他們還邀請人們評估生成的影象是否與原始場景描述匹配。在描述包含三個關係的示例中,91% 的參與者認為該模型的效能比以往模型更好。

這些早期結果令人鼓舞,研究人員希望未來該模型能夠在更復雜的真實世界影象上執行,這需要解決物體遮擋、場景混亂等問題。

他們也期待模型最終能夠整合到機器人系統中,使機器人能夠推斷現實世界中的物體關係,更好地完成互動任務。

感興趣的讀者可以閱讀論文原文了解更多研究細節。