IT 作為一門專業學科的存在歸功於尋求從資訊中獲得競爭優勢的公司。今天,組織充斥著資料,但處理和分析資料的技術往往難以跟上每臺機器、應用程式和感測器發出的源源不斷的遙測資料的洪流。

事實證明,對於基於結構化資料庫的傳統資訊系統而言,非結構化資料的爆炸式增長尤其具有挑戰性,這引發了基於機器學習和深度學習的新演算法的開發。這反過來又導致組織需要為機器學習、深度學習和人工智慧工作負載購買或構建系統和基礎設施。

在今天的文章中,讓我們概述能夠使用 AI/機器學習和深度學習的基礎架構電腦配置要求

背景概述

這是因為幾何擴充套件的非結構化資料集、機器學習 (ML) 和深度學習 (DL) 研究的激增以及旨在並行化和加速 ML 和 DL 工作負載的成倍強大的硬體之間的聯絡激發了對企業 AI 的興趣應用程式。IDC 預測,到 2024 年 AI 將變得普遍,四分之三的組織都在使用 AI,其中 20% 的工作負載和 15% 的企業基礎設施將用於基於 AI 的應用程式。

企業將在雲上構建許多此類應用程式。但是,訓練和饋送此類演算法所需的大量資料、將資料移動並存儲在雲中的高昂成本以及對實時或近實時結果的需求,意味著許多企業 AI 系統將部署在私有的專用系統上。

在為人工智慧增強的未來做準備時,IT 必須應對許多架構和部署選擇。其中最主要的是人工智慧加速硬體叢集的設計和規範。由於其密度、可擴充套件性和靈活性,一種很有前景的選擇是超融合基礎設施 (HCI) 系統。雖然人工智慧最佳化硬體的許多元素都高度專業化,但整體設計與更普通的超融合硬體非常相似。

機器學習、人工智慧用例的流行基礎設施

大多數 AI 系統執行在 Linux VM 上或作為 Docker 容器執行。事實上,大多數流行的 AI 開發框架和許多示例應用程式都可以作為來自 Nvidia 和其他公司的預打包容器映像提供。

流行的應用程式包括:

- 計算機視覺,例如影象分類、物件檢測(在影象或影片中)、影象分割和影象恢復;

- 語音和自然語言處理、語音識別和語言翻譯;

- 文字到語音合成;

- 基於先前的使用者活動和參考提供評級和建議的個性化內容或產品的推薦系統;

- 內容分析、過濾和稽核;和

- 模式識別和異常檢測。

這些在各種行業中都有應用,例如:

- 金融服務公司的欺詐分析和自動交易系統;

- 線上零售個性化和產品推薦;

- 物理安全公司的監控系統;和

- 石油地質分析,用於天然氣和採礦公司的資源開採。

一些應用程式,例如網路安全和 IT 運營自動化系統 (AIOps) 的異常檢測,跨越多個行業,基於人工智慧的功能被納入各種管理和監控產品。

AI 應用需要大量儲存

將有一個用於 AI 和 ML 模型訓練的海量歷史資料儲存庫,以及用於模型推理和預測分析的高速傳入資料流。機器學習和人工智慧的資料集可以達到數百 TB 到 PB,通常是非結構化格式,如文字、影象、音訊和影片,但包括半結構化內容,如 Web 點選流和系統日誌。這使得這些資料集適用於物件儲存或 NAS 檔案系統。

AI 要求和核心硬體元素

機器和深度學習演算法以資料為基礎。資料選擇、收集和預處理,例如過濾、分類和特徵提取,是影響模型準確性和預測價值的主要因素。因此,資料聚合(整合來自多個來源的資料)和儲存是影響硬體設計的 AI 應用程式的重要元素。

資料儲存和 AI 計算所需的資源通常不會同步擴充套件。因此,大多數系統設計將兩者解耦,在 AI 計算節點中使用本地儲存設計為足夠大且足夠快以提供演算法。

機器和深度學習演算法需要大量的矩陣乘法和累加浮點運算。這些演算法可以並行執行矩陣計算,這使得 ML 和 DL 類似於畫素著色和光線跟蹤等圖形計算,這些計算由圖形處理器單元 (GPU)大大加速。

但是,與 CGI 圖形和影象不同,ML 和 DL 計算通常不需要雙精度(64 位)甚至單精度(32 位)精度。這允許透過減少計算中使用的浮點位數來進一步提高效能。因此,儘管近十年來早期的深度學習研究使用了現成的 GPU 加速卡,但領先的 GPU 製造商英偉達已經建立了一條單獨的資料中心 GPU 產品線,專為科學和人工智慧工作負載量身定製。

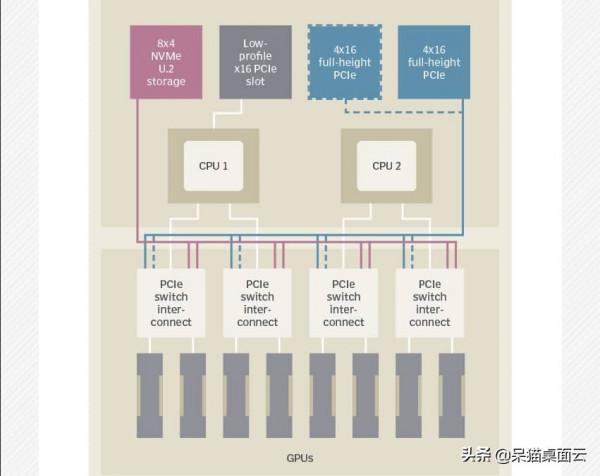

電腦配置要求和硬體

對AI效能最關鍵的電腦元件配置如下:

- 中央處理器: 負責操作 VM 或容器子系統,將程式碼分派到 GPU 並處理 I/O。當前產品使用第二代 Xeon Scalable Platinum 或 Gold 處理器,儘管使用第二代(羅馬)AMD Epyc CPU 的系統正變得越來越流行。當前一代 CPU 增加了可顯著加速 ML 和 DL 推理操作的功能,使其適用於利用先前使用 GPU 訓練的模型的生產 AI 工作負載。

- 圖形處理器: 處理 ML 或 DL 訓練和(通常)推理,這是基於學習自動分類資料的能力,通常使用 Nvidia P100(Pascal)、V100(Volta)或 A100(Ampere)GPU 進行訓練,以及 V100、A100或 T4(圖靈)進行推理。AMD 的 Instinct (Vega) GPU 在系統供應商中的滲透率並不高。然而,一些 OEM 現在提供 1U-4U 或 Open Compute Project 21 英寸外形的產品。

- 記憶體: AI 操作從 GPU 記憶體執行,因此係統記憶體通常不是瓶頸,伺服器通常具有 128 到 512 GB 的 DRAM。當前的 GPU 使用嵌入式高頻寬記憶體 (HBM) 模組(Nvidia V100 為 16 或 32 GB,A100 為 40 GB),它們比傳統的 DDR4 或 GDDR5 DRAM 快得多。因此,具有 8 個 GPU 的系統可能具有總計 256 GB 或 320 GB 的 HBM 用於 AI 操作。

- 網路: 由於 AI 系統通常聚集在一起以擴充套件效能,因此係統具有多個 10 gbps 或更高的乙太網介面。有些還包括用於叢集內通訊的 InfiniBand 或專用 GPU (NVLink) 介面。

- 儲存 IOPS:在儲存和計算子系統之間移動資料是 AI 工作負載的另一個性能瓶頸。所以大多數系統使用本地 NVMe 驅動器而不是 SATA SSD。

總結

GPU 一直是大多數 AI 工作負載的主力,英偉達透過 Tensor Cores、多例項 GPU(並行執行多個程序和 NVLink GPU 互連)等功能顯著提高了它們的深度學習效能。然而,對速度和 效率的日益增長的需求 催生了大量新的人工智慧處理器,如谷歌的 TPU、英特爾 Habana 人工智慧處理器、Tachyum 通用處理器、Wave AI SoC 或基於現場可程式設計門陣列 (FPGA) 的解決方案,如 Microsoft Brainwave、雲中人工智慧的深度學習平臺。

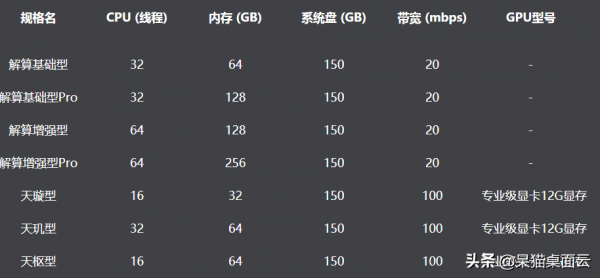

呆貓雲桌面多款高階機型選擇,輕鬆暢享高配

企業可以透過選擇正確的配置和系統元件,將任何超融合基礎設施或高密度系統用於 AI。不過隨著深度學習以及人工智慧對電腦的要求越來越高,還是推薦大家選擇呆貓雲桌面輕鬆解決電腦配置瓶頸,輕鬆辦公研究人工智慧和深度學習。

呆貓雲桌面後臺可配置的CPU機器數量上不封頂,同時針對GPU機型呆貓設有天璇型、天璣型、天樞型三種選項,所有GPU機型皆配備NVIDIA專業級頂配顯示卡。

呆貓雲桌面在科學計算、渲染、遊戲、辦公等應用場景下的表現自不必說,玩大型遊戲更是小菜一碟,擁有呆貓相當於把超級電腦放進口袋,隨時隨地都可暢享高配,滿足移動辦公、人工智慧、三維建模、視覺設計、影視製作、教育培訓、動畫渲染、娛樂暢玩等多場景應用。

更多資訊,繼續關注我吧,呆貓在手,輕鬆暢想高配電腦。