作者 | 李溪

編輯 | 餘快

2021年12月11日,由雷峰網 & AI 掘金志主辦的第四屆中國人工智慧安防峰會,在深圳正式召開。

本屆峰會以「數字城市的時代突圍」為主題,會上代表城市AIoT的14家標杆企業,為現場和線上觀眾,分享迎接數字城市的經營理念與技術應用方法論。

在上午場的演講環節上,華為機器視覺副總裁張愛軍為峰會帶來了精彩演講。

張愛軍提到,從2016年,華為就把整個企業的願景從豐富人們的溝通與生活變成把數字世界帶入每個人,每個家庭,每個組織,構建萬物互聯的智慧世界。

華為從技術角度進行了“智慧世界”的定義:一是萬物感知,二是萬物互聯,三是萬物智慧。

張愛軍指出,隨著互動方式將發生巨大變化,催生新型移動物聯網蓬勃發展,未來整個智慧世界最核心的資料互動主體將不再是人與人的互動,而是物與物的互動。機器視覺將成為5G時代的“智慧手機”,行業數字化感知入口。

對於當前產業發展歷程,張愛軍提出兩個觀點:

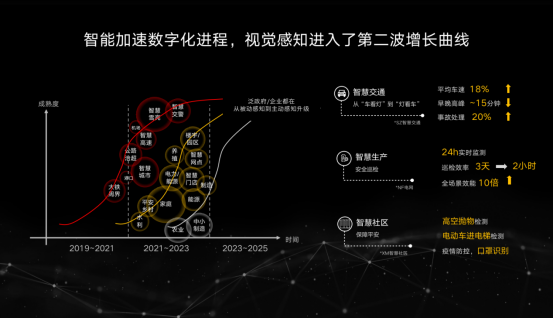

1、智慧感知的程序進入第二波增長曲線,未來感知系統會擁有主動的感知能力。

2、純粹的、被動的感知產業生態,可能會快速進入以企業生產業務流程為主導的感知體系,智慧感知進入千行百業將變成非常重要的模式。

張愛軍還分享了華為機器視覺的戰略:加速視覺感知進入企業生產流程,助力“智慧管理和運營”,支撐戰略落地上,華為有四個核心點。

一是關鍵技術。華為在計算機視覺賦能上的鏡頭、影象感測等都在進行關鍵技術研究。

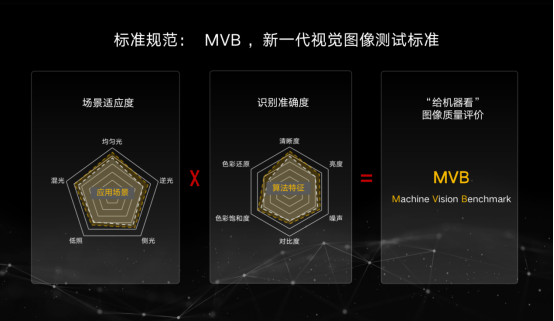

二是標準規範。標準規範最核心的是透過更加客觀數字化的模式來衡量一幅圖片、一段影片是不是真正有效的為未來的人工智慧和機器視覺來使用。

三是評價體系。手機行業的評測模式讓整個產業界非常有序發展。新的機器視覺產業需要類似的評價體系,讓智慧時代的影象質量評價更為客觀。

四是開放生態。提供一套生態架構,讓開發者便捷開發、一站式交易,自由的溝通和交流。

以下是張愛軍演講全文,雷峰網AI掘金志作了不改變原意的整理與編輯:

機器視覺和未來智慧世界/數字化轉型的關係是什麼?大家可能對此有各種各樣的理解,我想談談華為近期的思考。

華為的願景是“把數字世界帶入每個人、每個家庭、每個組織,構建萬物互聯的智慧世界”。

從技術角度,我們對智慧世界進行了三個萬物的定義: 一是萬物互聯,二是萬物智慧,三是萬物感知。

有人問資訊社會和智慧社會到底有什麼區別?我們在疊加人工智慧演算法過程中,很多時候沒有注意到,其實參與資訊社會和智慧社會的主體在發生巨大變化。

資訊社會是人和機器的互動,通常是人找到更多資料,無論是PC網際網路還是移動網際網路時代,都是如此。

未來在智慧世界裡最核心的資料互動的主體變成物和物的互動。當互動方式發生巨大變化,催生新型移動物聯網產業蓬勃發展。未來資料將基於不同的場景找到更多為人服務的模式。

所以,4G時代,智慧手機是移動網際網路的體驗入口、應用載體、讓人與人聯接。

我們認為未來在5G時代、真正的人工智慧時代,機器視覺將成為5G時代的“智慧手機”,行業數字化入口,成為資料載體,也成為承載物和物之間互動的主體。

在此背景下,我們需要構建應對未來智慧世界的感知平臺。為匹配未來智慧世界裡面對不同場景、不同業務能力的變化,構建更加靈活、多樣的全息感知平臺體系,好望提出了“軟體定義”架構,並明確了三個關鍵要素:

1. 專業的AI芯,為實現智慧化與數字化提供強力的算力引擎。

2. 開放的作業系統,才能真正融入到智慧世界的端雲協同業務體系中。

3. 豐富的生態,構建智慧世界我們需要與眾多合作伙伴共同攜手。

對於當前產業發展的歷程,我們有兩個觀點:

1、智慧感知進入了第二波增長曲線。

過去十年,隨著智慧城市、平安城市的建設,安防攝像頭已經被廣泛普及,這些攝像機更多給我們提供了被動感知的能力,提供的是事後檢視的能力。未來這些感知體系會擁有主動感知的能力。

2、從整個產業看,未來被動感知的產業生態可能會快速進入到以企業的生產業務流程為主導的感知體系,智慧感知進入千行百業將變成非常重要的模式。

我們知道,一家公司不可能適配所有企業場景。人工智慧最關鍵的資料的選擇不應該是由做演算法模型的科學家來實現,更多是由懂得場景和業務的工程師來實現的,但往往現實很殘酷,懂得場景和業務的工程師在演算法的快速開發上缺乏經驗。

因此如何讓懂行業know-how的人的想法快速變成演算法非常關鍵。

人工智慧時代新興低程式碼模式,已經極大提升了開發者的效率,但是對業務專家來講依然是很複雜的過程。

我們有一個樸素的想法,我們在這個過程中採用端雲協同的模式,提供從訓練到開發、部署的業務模型,真正實現業務閉環。

講一個我們與企業合作的故事,這個企業做的演算法精度大概在75%左右。他們找到華為,問能不能讓工程師自己開發,讓演算法的精度提升到85%或者90%。

這是個很簡單的問題,我們可以解決。我們基於華為的好望開發平臺,同時也給他們提供了人工智慧領域8個基礎模型,這是任何做視覺的人工智慧演算法模型都需要用到的模型,比如目標的跟蹤、目標的切割等等一系列的基礎能力,有了這些基礎能力,他們就可以透過資料有效訓練來快速構建場景需要的能力。

我們希望未來機器視覺加速視覺感知進入生產環節,能讓大型企業、店鋪等小微企業都能享受AI的能力。

目前很多需求在發生根本性的變化,以前只需要被動的感知能力,今天需要為企業生產提效提供決策的依據,我們認為感知能力變化最大的本質就是從“給人看”到“給機器看”。在這個過程中,所有技術要素、技術體系都需要圍繞給機器看來構建。

回顧產業發展歷程,行業客戶需求從安全防範上升到經營決策,華為從機器視覺四層需求理論出發,圍繞“1+3+N”的產業框架,持續打造創新產品,以“平臺+生態”重新定義商業模式、生態模式和解決方案架構。

好望以軟體定義攝像機、為核心構建了完整的業務閉環的端雲協同的產品能力,基於此產品能力,華為構建了完全開放的生態。我們並不希望一家包攬所有事情,希望的是在AI的時代與能力型夥伴一起,把你們的行業know-how變成你們的產品能力,在你們所熟知的行業進行銷售的模式。

這個產品體系如何支撐戰略落地?

一、關鍵的技術。這和虞晶怡教授今天講的未來談感知一定會談計算視覺一樣。計算視覺是很龐大的故事,華為在計算視覺有多年研究。為什麼華為的手機晚上照出來的照片比別人的好?這是計算視覺賦能。在一系列的鏡頭、Sensor、影象感測領域,我們都有關鍵技術的研究和積累,希望未來面向機器視覺、面向機器來構建機器能識別的技術要素。

二、標準規範。影片編解碼技術發展了近30年,當我們評價影片好壞時還是用主觀體驗來作為最重要的評判標準。但我們面向機器視覺,如果用同樣的模式評價影象標準是很困難的事情。

有一次我和中國圖形影象學會王院士交流,他提到,如果未來不能透過客觀的方式來評價視覺影象,對機器構建整個智慧世界有非常重大的影響。

圍繞給機器看的 “看、存、用”,華為機器視覺提出 SuperColor、SuperCoding、AI Turbo三大根技術,貫穿影片資料的全生命週期管理和使用。

同時,華為在聯合學界和業界夥伴共同提出面向機器的Machine Vision Benchmark標準規範。標準規範的核心是透過更加客觀、數字化的模式來衡量一幅圖片、一段影片是否有效為人工智慧和機器視覺所使用。圍繞標準的評價體系,好望攜手夥伴不斷探索自動化的測評流程,構建標準化的實驗室。

三、評價體系。圍繞這套標準體系,華為在和業界一起探索自動化的評測流程,華為墨子光學影象實驗室支援MVB自動化評測打分,可以自動化評測產品與標準要求的符合度,且能快速得出結果。

這套模式的啟發來自手機行業,我們發現手機行業的評測模式讓整個產業界非常有序發展。我們認為在新的機器視覺產業裡需要這樣的體系來幫助整個行業繁榮。

前面更多是從華為自身出發,往後我們要讓合作伙伴一起共創數字的未來,其中最關鍵的是要提供一套生態的框架,這個生態框架有三個核心能力。

一是提供一站式好望開發平臺,讓所有開發者的想法和行業know-how變成演算法;二是為夥伴提供一站式交易的平臺,華為把你開發出來的演算法帶貨到全球世界各地的專案,我們也希望夥伴在生態中形成網路,可以自行溝通和交流。三是形成端到端的產品體系。

在這個過程中我們構建了雲上開發一鍵式部署、協同推理,同時能夠在雲上進行端側遠端升級和遠端運維,是一套自動化的運維管理體系。

華為開源了深度學習框架MindSpore,它的能力在端側,無論是效能的要求,對資源的要求,還是整體上的能力相比其他框架更優。我們把開發的大量優秀的基礎模型貢獻出來,在產品能力上構建端邊雲協同的能力。

華為機器視覺致力於用智慧賦予機器“看”的能力,開啟“機器看世界”新時代,推動智慧社會快速到來,張愛軍表示:“好望希望在各個方面與夥伴們持續深化合作,在標準、認證、演算法開發等多個領域我們與夥伴攜起手來,共同構建智慧世界,一起共贏未來”。