機器之心專欄

作者:孫建新

該方法首次實現多個文字輸入的人臉合成,與單輸入的演算法相比生成的影象更加接近真實人臉。

文字人臉合成指的是基於一個或多個文字描述,生成真實自然的人臉影象,並儘可能保證生成的影象符合對應文字描述,可以用於人機互動,藝術影象生成,以及根據受害者描述生成犯罪嫌疑人畫像等。針對這個問題,中科院自動化所聯合北方電子裝置研究所提出了一種基於多輸入的文字人臉合成方法(SEA-T2F),並建立了第一個手工標註的大規模人臉文字描述資料集(CelebAText-HQ)。該方法首次實現多個文字輸入的人臉合成,與單輸入的演算法相比生成的影象更加接近真實人臉。相關成果論文《Multi-caption Text-to-Face Synthesis: Dataset and Algorithm》已被ACM MM 2021錄用。

- 論文地址:https://zhaoj9014.github.io/pub/MM21.pdf

- 資料集和程式碼已開源:https://github.com/cripac-sjx/SEA-T2F

圖1 不同方法的文字到人臉影象生成結果

相較於文字到自然影象的生成,文字到人臉生成是一個更具挑戰性的任務,一方面,人臉具有更加細密的紋理和模糊的特徵,難以建立人臉影象與自然語言的對映,另一方面,相關資料集要麼是規模太小,要麼直接基於屬性標籤用網路生成,目前為止,還沒有大規模手工標註的人臉文字描述資料集,極大地限制了該領域的發展。此外,目前基於文字的人臉生成方法[1,2,3,4]都是基於一個文字輸入,但一個文字不足以描述複雜的人臉特徵,更重要的是,由於文字描述的主觀性,不同人對於同一張圖片的描述可能會相互衝突,因此基於多個文字描述的人臉生成具有很重大的研究意義。

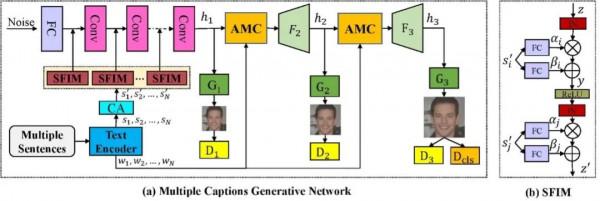

針對該問題,團隊提出了一個基於多輸入的文字人臉生成演算法。演算法採用三階段的生成對抗網路框架,以隨機取樣的高斯噪聲作為輸入,來自不同文字的句子特徵透過SFIM模組嵌入到網路當中,在網路的第二第三階段分別引入了AMC模組,將不同文字描述的單詞特徵與中間影象特徵透過注意力機制進行融合,以生成更加細密度的特徵。為了更好地在文字中學習屬性資訊,團隊設計了一個屬性分類器,並引入屬性分類損失來最佳化網路引數。

圖2 模型框架示意圖

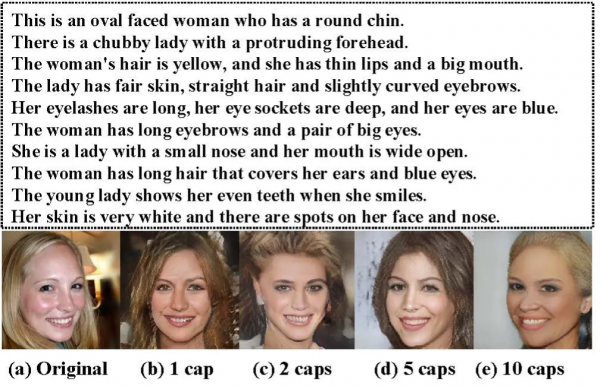

此外,團隊首次建立了一個大規模手工標註資料集,首先在CelebAMask-HQ資料集中篩選了15010張圖片,每個圖片分別由十個工作人員手工標註十個文字描述,十個描述按照由粗到細的順序分別描述人臉的不同部位。

實驗結果

團隊對提出的方法進行了定性和定量分析[5,6],實驗結果表明,該方法不僅能生成高質量的影象,並且更加符合文字描述。

圖3 不同方法比較結果

圖4 不同數量輸入的生成結果

表1 不同方法的定量比較結果

表2 消融實驗結果:前三行分別表示網路去除SFIM,AMC,和屬性分類損失。

參考文獻:

1. Osaid Rehman Nasir, Shailesh Kumar Jha, Manraj Singh Grover, Yi Yu, Ajit Kumar, and Rajiv Ratn Shah. 2019. Text2FaceGAN: face generation from fine grained textual descriptions. In IEEE International Conference on Multimedia Big Data (BigMM). 58–67.

2. Xiang Chen, Lingbo Qing, Xiaohai He, Xiaodong Luo, and Yining Xu. 2019. FTGAN: A fully-trained generative adversarial networks for text to face generation. arXiv preprint arXiv:1904.05729 (2019).

3. David Stap, Maurits Bleeker, Sarah Ibrahimi, and Maartje ter Hoeve. 2020. Conditional image generation and manipulation for user-specified content. arXiv preprint arXiv:2005.04909 (2020).

4. Weihao Xia, Yujiu Yang, Jing-Hao Xue, and Baoyuan Wu. 2021. TediGAN: Textguided diverse image generation and manipulation. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 2256–2265.

5. Tao Xu, Pengchuan Zhang, Qiuyuan Huang, Han Zhang, Zhe Gan, Xiaolei Huang, and Xiaodong He. 2018. Attngan: Fine-grained text to image generation with attentional generative adversarial networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 1316–1324.

6. Bowen Li, Xiaojuan Qi, Thomas Lukasiewicz, and Philip Torr. 2019. Controllable text-to-image generation. In Advances in Neural Information Processing Systems (NeuIPS). 2065–2075.