機器之心報道

編輯:杜偉、陳萍

特斯拉 AI 總監 Andrej Karpathy 連發多條推文表示,AI 不同領域(視覺、語音、自然語言等)正在打通,融合速度令人驚歎。

今日,特斯拉 AI 總監、Autopilot Vision 團隊領導人 Andrej Karpathy 在推特上發文,對 AI 領域正在進行中的融合(consolidation)表示驚歎。

他表示,「10 年前,視覺、語音、自然語言、強化學習等都是完全分離的,甚至沒有跨領域的論文。方法也完全不同,通常不是基於機器學習。」

從 2010 年開始,視覺、語言、自然語言、強化學習等領域的壁壘逐漸打破,它們開始轉向同一個技術方向,即機器學習,特別是神經網路。它們使用的網路架構具有多樣性,但至少論文開始讀起來更加相似,基本上都用到了大型資料集和網路最佳化。

隨著 AI 技術的發展,近兩年,不同領域模型架構似乎也變得相同起來。很多研究者開始專注於 Transformer 架構,在此基礎上做較小的改動以進行研究。

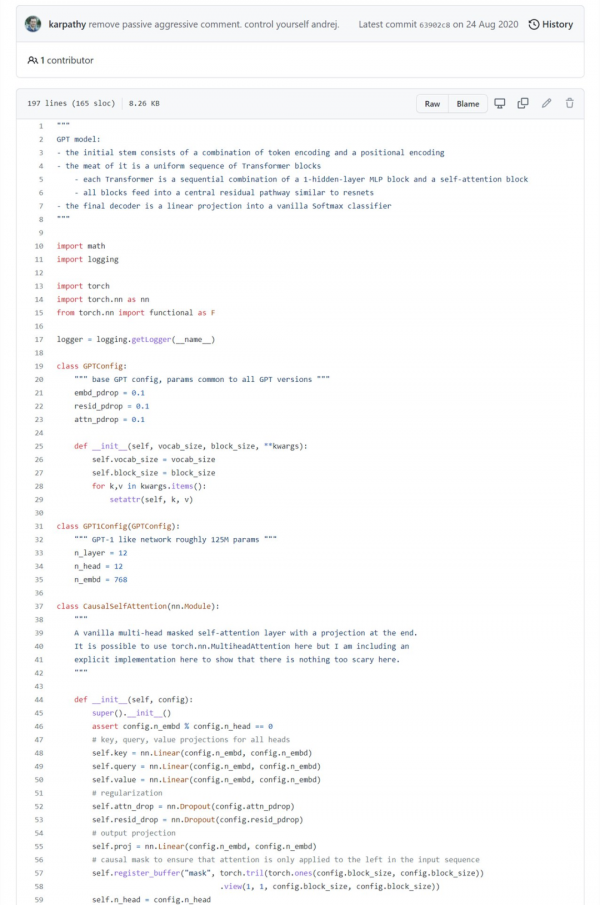

例如 2018 誕生的 GPT,1.17 億引數;2019 年 GPT-2,15 億引數;2020 年更是將其擴充套件到 1750 億引數 GPT-3。Karpathy 基於 PyTorch,僅用 300 行左右的程式碼就寫出了一個小型 GPT 訓練庫,並將其命名為 minGPT,這個 minGPT 能夠進行加法運算和字元級的語言建模,而且準確率還不錯。核心的 minGPT 庫包含兩個文件:mingpt/model.py 和 mingpt/trainer.py。前者包含實際的 Transformer 模型定義,大約 200 行程式碼,後者是一個與 GPT 無關的 PyTorch 樣板檔案,可用於訓練該模型。

部分程式碼截圖。

197 行完整程式碼:https://github.com/karpathy/minGPT/blob/master/mingpt/model.py

隨著模型架構的融合,現在,我們可以向模型輸入詞序列、影象 patch 序列、語音序列、強化學習序列(狀態、行為、獎勵)。我們可以在條件設定中新增任意 token,這種模式是極其簡單、靈活的建模框架。

即使是在某個領域(如視覺)內部,過去在分類、分割、檢測和生成任務上存在一些差異。但是,所有這些也正在轉換為相同的框架,例如 patch 的檢測 take 序列和邊界框的輸出序列。

現在,區別性特徵主要包括以下幾個方面:

1)資料

2)將自身問題對映到向量序列以及從向量序列映射出自身問題的輸入 / 輸出規範

3)位置編碼器的型別以及注意力 mask 中針對特定問題的結構化稀疏模式

所以,從技術上來說,AI 領域的方方面面,包括前景、論文、人才和想法突然之間變得極其相關。每個人基本上都在使用相同的模型,大多數改進和想法可以快速地在所有 AI 領域「複製貼上」(copy paste)。

正如其他很多人注意到並指出的那樣,新大腦皮質(neocortex)在其所有的輸入模態中也有一個高度統一的架構。也許自然界偶然發現了一個非常相似的強大架構,並以類似的方式複製了它,並只在一些細節上做了改變。

這種架構上的融合將使我們專注於軟硬體和基礎設施建設,進一步加速 AI 領域的進展。「無論如何,這是激動人心的時刻。」

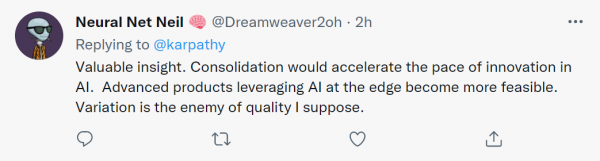

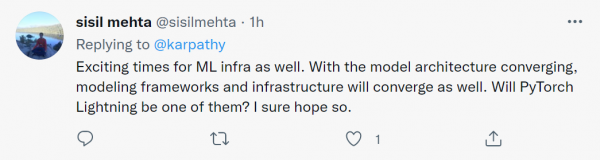

對於 Andrej Karpathy 描述的 AI 融合趨勢,網友也紛紛發表意見。

推特網友 @Neural Net Nail 表示,「這是一個有價值的見解。融合將加速 AI 領域的創新步伐,在邊緣端使用 AI 的尖端產品變得更加可行。我想,變化(variation)才是質量的最大敵人。」

網友 @sisil mehta 也認為,「ML 基礎設施迎來了激動人心的時刻。隨著模型架構的融合,建模框架和基礎設施也將融合。我當然希望 PyTorch Lightning 也會這樣。」

網友 @Marcos Pereira 表示,「一方面,處處都在用 transformers,我們已經遇到了障礙,需要創新;另一方面,處處都在用 transformers,所以跟上來吧。」

原文出自 @Andrej Karpathy 的推特:https://twitter.com/karpathy/status/1468370605229547522