預測是一件危險的事情,因為未來總是不可預知的,當我們需要做預測的時候,往往需要對大量已知的資料進行分析後才能做出一些可能比較靠譜的猜測,這一次,讓我們嘗試看看 NVIDIA 的下一代 GPU 可能會有哪些特性。

需要明確一點的是,我們這裡猜測的是 NVIDIA 的資料中心版 GPU,同等定位的產品就是現在的 A100,在數年前 NVIDIA 並沒有把資料中心 GPU 和 遊戲用 GPU 做明確的區分,但是隨著高效能伺服器市場的迅速增長,單獨設計一枚面向資料中心的 GPU 變得有利可圖而且是非常賺錢的事情,所以 P100、A100 這樣的產品也就被單獨推出了。

NVIDIA 的下一代資料中心 GPU 代號是 Hopper,型號為 H100,和現在基於巨型晶片的 A100 不同的是,NVIDIA 很可能會像 AMD MI200、Intel Xe-HPC 那樣採用小晶片 + MCM 的設,NVIDIA 目前將其稱作 GPM(GPU Modules)。

這並非毫無根據,事實上早在 2017 年 NVIDIA 研究院就發表了一篇名為 《MCM-GPU: Multi-Chip-Module GPUs for Continued Performance Scalability(MCM-GPU:用於效能可擴充套件的多晶片模組 GPU)》的論文,針對 MCM-GPU 提出了三種最佳化手段。

第一個最佳化手段是在流式多處理器和互聯節點之間引入名為 L1.5 Cache 的快取記憶體:

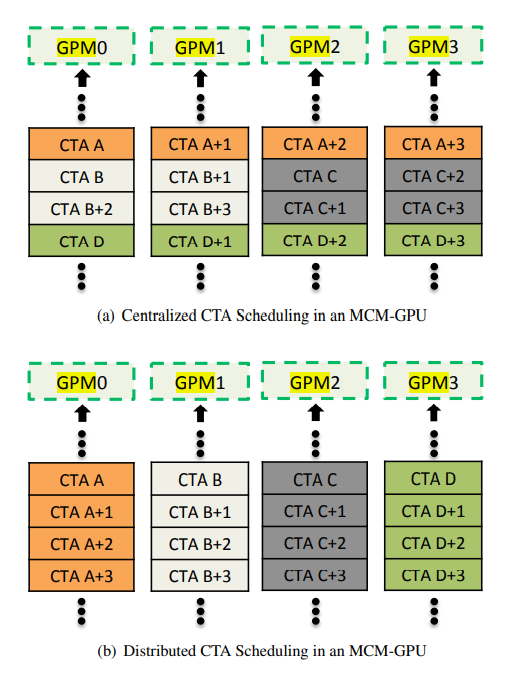

第二個最佳化手段是引入名為分散式排程的 CTA 排程能力:

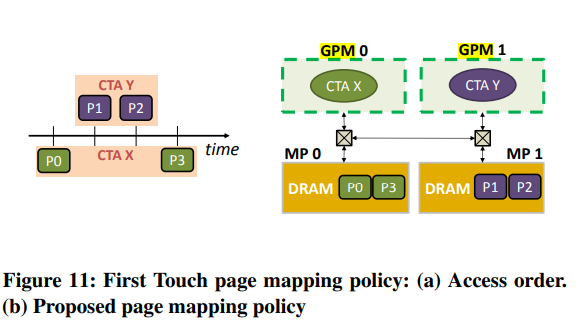

第三個最佳化手段是引入名為 Firest Touch(首次接觸)的 GPM 資料區域性性分割槽技術(能顯著提高層次化 Cache 的效率):

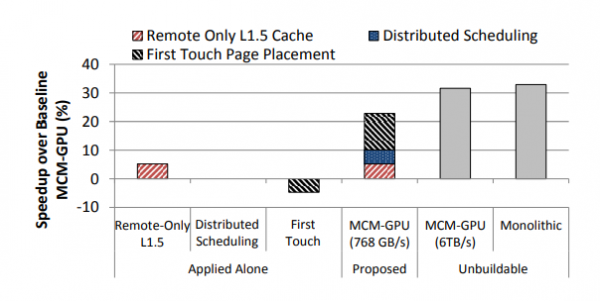

這三項技術都和提高 GMP 效率密切相關,但是單獨使用的效果遠不如三劍合一:

有鑑於此,我們可以預期 Hopper 如果採用上述的任何一種技術,往往意味著另外兩種技術也會被引入。

從論文以及結合 NVIDIA 的一些專利來看,NVIDIA GMP 作為 MCM-GPU 的一種技術路線,和 AMD 狂堆 Infinity Cache 以及 Intel 偏向於普通 MCM-GPU 的設計相比,更偏向於對一些精妙的細節雕琢力求以最小的成本實現最大的效能,這和 NVIDIA 一直以來的晶片設計哲學是一脈相承的,這樣的設計最終也會反映到軟體生態上,但是能否影響業界(GPU 行業)的 MCM-GPU 設計構成影響還有待觀察。