創造出具有智慧的機器,邁向通用AI是人類長期以來的夢想。當下的AI發展到了哪個階段?

作者 | 維克多

編輯 | 青暮

今年12月9日,第六屆全球人工智慧與機器人大會(GAIR 2021)在深圳正式啟幕,140餘位產學領袖、30位Fellow聚首,從AI技術、產品、行業、人文、組織等維度切入,以理性分析與感性洞察為軸,共同攀登人工智慧與數字化的浪潮之巔。

大會次日,IEEE/IAPR Fellow,京東集團副總裁,京東探索研究院副院長梅濤在GAIR大會上做了《從感知智慧到認知智慧的視覺計算》的報告,他指出視覺計算的感知研究雖然已經相對成熟,某些人工智慧(AI)任務已經能夠透過圖靈測試,例如在內容合成與影象識別,但在影片分析領域,影片資料內容多樣化以及影片語義的不清晰等原因導致該領域還存在大量挑戰性問題。

同時,在認知領域,視覺計算已經有一些進展,例如Visual Genome、VCR等資料集已經佈局結構知識建模;而在推理層面,國內學者已經嘗試透過聯合解譯和認知推理深入理解場景或事件。

以下是演講全文,AI科技評論做了不改變原意的整理:

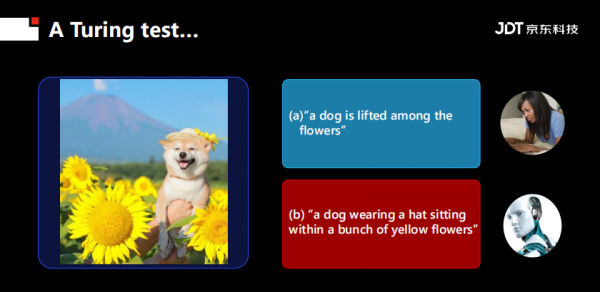

今天的演講題目是《從感知智慧到認知智慧的視覺計算》。在開始之前,先用兩個圖靈測試的例子大致說明AI的進展。

首先計算機視覺不僅在識別領域,在內容合成領域已經達到透過圖靈測試的標準。正如上圖所示,人類已經很難在一組圖片中將兩張機器合成的圖片挑選出來。

另外一個圖靈測試的例子是“看圖說話”:給定一張圖片,描述圖片的內容。下面兩句話分別由人(第一句)和機器(第二句)生成。很顯然,如果不仔細看圖片,可能會潛意識的認為機器比人寫的詳細。

1.a dog is lifted among the flowers

2. a dog wearing a hat sitting within a bunch of yellow flowers

如果仔細觀察圖片,就會發現確實有一隻手把小狗舉了起來。這也說明:不太經常發生的現象,機器很難描述,其原因和機器學習的內容相關,以及機器沒有邏輯推理能力。

透過上述兩個例子我們可以看出:在感知領域,AI已經超越人類;而在認知領域,它還欠缺一些火候。

1 計算機視覺的進展與挑戰

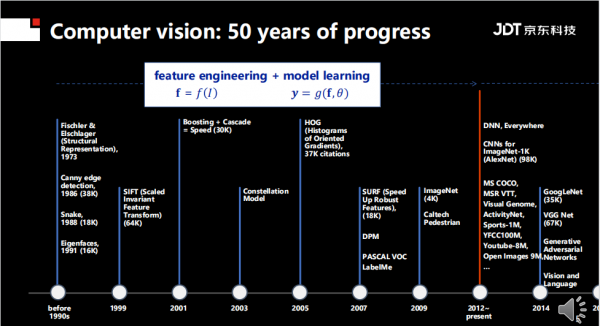

上圖是計算機視覺在過去五六十年取得的進展,2012年深度學習“大火”之前,計算機完成視覺任務通常有兩個步驟:特徵工程和模型學習。

特徵工程的特點是完全依靠人類智慧,例如設計Canny edge、Snak、Eigenfaces等引數特徵,同時這些方法已經獲得了大量的引用,Canny已經被引用了38000次,Snak 18000次,SIFT更是已經超過了64000次。

2012年之後,深度學習興起,顛覆了幾乎所有的計算機視覺任務。其特點是將傳統的特徵工程和模型學習合為一體,即能夠在學習的過程中進行特徵設計。

深度學習火熱的另一個標誌是每年有大量的論文投到計算機視覺頂會(CVPR、ICCV、ECCV等),同時如果這些方法表現“傑出”,就能夠獲得大量的流量,例如GoogleNet VGG在不到8年的時間裡獲得了10萬次引用;2015年的ResNet更是在更短的時間獲得了接近10萬次的引用。

這說明深度學習領域在飛速發展,而且進入這個領域的人越來越多。一方面不僅深度學習網路在不斷“更新換代”,影象、影片等資料集也在不斷增長,甚至有些資料集規模已經過億。

其中,深度學習的一個趨勢是“跨界”。在2019年,Transformer在自然語言處理領域的效能被證明“一枝獨秀”,現在已經有大量學者開始研究如何將其納入視覺領域,例如微軟亞洲研究院swin transformer相關工作獲得了ICCV的最佳論文獎。

上圖展示了隨著研究正規化的變化,資料集的變化趨勢。無論是資料集的類別還是資料集的規模都在不斷增大,有些資料集更是超過了10億級別。目前類別最多的是UCF101資料集,其中包括101個類。同時,大規模也帶來了一個弊端:一些高校和小型實驗室無法進行模型訓練。

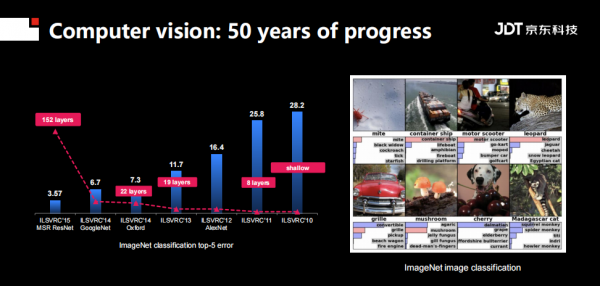

特定領域進展如何?在影象識別領域,最廣為人知莫過於ImageNet競賽。其任務是給定一張圖,預測出五個相關的標籤。隨著深度學習網路的層數越來越深,識別的錯誤率越來越低,到2015年, ResNet已經它達到了152層,並且已經超過了人類識別影象的能力。

在影片分析領域。Kinetics-400 影片分析任務反應了該領域的進展,從2017年和2019年出現了各種適合影片任務的神經網路,其網路大小、深度並不一致,而且從準確率、識別精度上看,也沒有一致的結果。換句話說,該領域存在大量的潛力(open question)。至於原因,個人認為有兩種:

1.影片內容非常多樣化,而且是時空連續的資料。

2.同樣的語義,在影片中會有不同的含義。例如不同語氣和不同表情下對同一個詞的輸出。

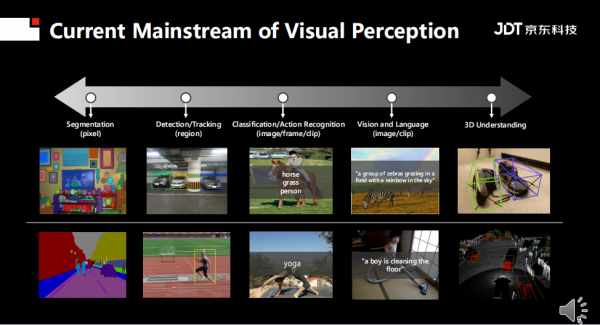

過去10~20年,視覺感知領域存在很多主題。如上圖所示,從最小力度的畫素級別到影片級別,基本上可以歸為幾大研究領域:語義分隔、物體檢測、影片動作行為識別、影象分類、Vision and language。其中,Vision and language最近五年比較火熱,其要求不僅從圖影片內容裡面生成文字描述,並且也可以反過來從文字描述生成影片或者圖片的內容。

總結起來,目前視覺研究的主要方向還是進行RGB影片和影象研究,在不遠的將來,成像的方式會發生變化,那時研究的資料將不僅是2D,更會過渡3D,甚至更多的多模態的資料。

在視覺理解領域,通用的視覺理解非常簡單:例如區分貓和狗,區分車和人。但在自然界裡,要真正的做到對世界的理解,其實要做到非常精細的粒度的影象識別。一個直觀的例子是鳥類識別,理想中的機器需要識別10萬種鳥類,才能達到人類對“理解世界”的要求。如果再精細一些,需要達到商品SKU細粒度識別。

注:一瓶200毫升和300毫升的礦泉水就是不同粒度的SKU。

過去幾年,京東在這方面做了一些探索。探索路徑包括:detection的方式,detection結合attention的方式,以及自監督的方式。涉及論文包括CVPR2019 的“Destruction and Construction Learning ”以及CVPR 2020的“Self-supervised”相關工作。

CVPR 2019:Destruction and Construction Learning for Fine-grained Image Recognition

論文地址:https://openaccess.thecvf.com/content_CVPR_2019/papers/Chen_Destruction_and_Construction_Learning_for_Fine-Grained_Image_Recognition_CVPR_2019_paper.pdf

CVPR 2020:Look-into-Object: Self-supervised Structure Modeling for Object Recognition

論文地址:https://arxiv.org/abs/2003.14142

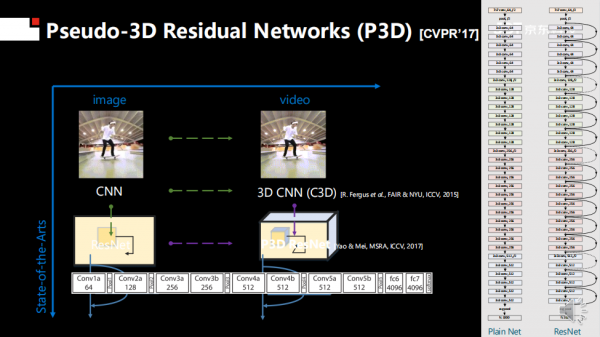

影片領域非常有挑戰,當年我想借鑑ResNet,畢竟在影象識別領域它是非常有創新的網路,因為其裡面包含skip level的調整。因此,當時我想把2D的CNN直接應用到3D領域。

其實,相關工作已經有人嘗試,但存在一定的困難。例如Facebook發現,如果沿著xyz三個軸進行卷積,引數會爆炸,所以很難提高模型效能。因此在2015年,Facebook只設計了一個11層的3D卷積網路。

我的嘗試是基於ResNet進行3D卷積設計,但也遇到了和Facebook同樣的困難,即引數爆炸。因此,在CVPR 2017年的一項工作中,我利用一個1*3*3的二維空間卷積和3*1*1的一維時域卷積來模擬常用的3*3*3三維卷積。

透過簡化,相比於同樣深度的二維卷積神經網路僅僅增添了一定數量的一維卷積,在引數數量、執行速度等方面並不會產生過度的增長。與此同時,由於其中的二維卷積核可以使用影象資料進行預訓練,對於已標註影片資料的需求也會大大減少。目前該論文引用超過1000次,得到了行業的認可。

CVPR 2017:Learning Spatio-Temporal Representation with Pseudo-3D Residual Networks

論文地址:https://arxiv.org/abs/1711.10305

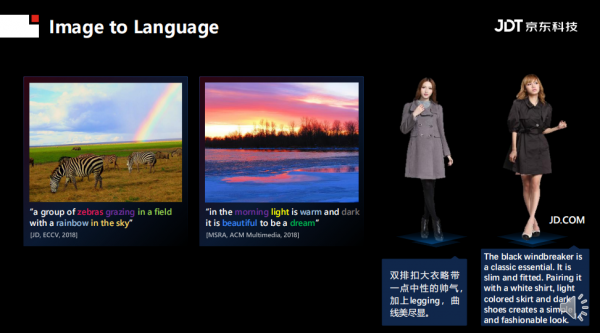

其他研究領域也有很多問題有待開發。例如在3D視覺研究方面,不僅需要語義分割,還需要估計物體的姿態;在Image to Language研究中,不僅需要給定一張圖片生成一段描述文字,還需要知道物體之間的空間關係語義關係。

2 視覺感知的應用

AI一直被認為是改變工業界的正規化,2019年PWC(麥肯錫)曾經發布過一個報告:AI對整個全球的經濟的貢獻,在2030年之前,每一年會是14%的提升。並且在中國,增長空間是26%。

將AI應用到工業界,基本需要滿足三個條件中的任何一個:降低成本、提高效率、提升使用者體驗。市值萬億美金級別的公司,例如微軟和蘋果,其共同的特點在於企業會全面、大規模、一次性的推廣AI技術。

大規模推廣AI技術時,誕生了許多很有意思的應用,例如“拍照購物”,核心技術是Photo-to-search,該領域已被深耕多年,但真正能發揮的場景是電商。以京東為例,它的拍照購物準確率以經比四年前提高許多,使用者轉化率提升了十幾倍。

另一個電商零售中的例子是“智慧搭配”,其目的不僅是讓AI推薦同款商品,還要讓AI提供穿搭建議。例如當用戶購買上衣時,AI自動搭配一個裙子或者一雙鞋,並且生成一段描述,告訴使用者“為何如此搭配”。該功能上線之後,其帶來的點選率超過了人工搭配。

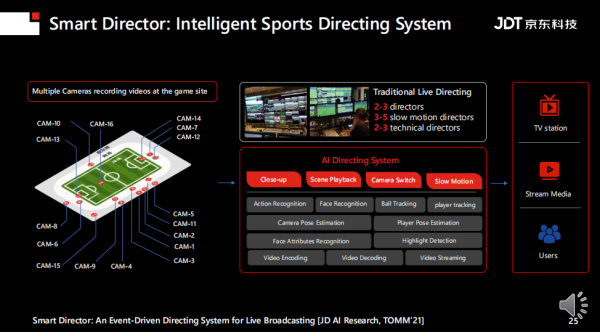

智慧導播應用也是AI比較擅長的。例如足球比賽中會有很多固定的相機,相機中的影片會傳遞到轉播車,然後會有20~30個工作人員不斷的製作影片,提供轉播流,每個人看到的轉播流都是相同的。所謂智慧導播是指:用AI學習人類導播的方式,然後根據每個使用者的喜好,輸出相應的內容。喜歡足球的使用者會著重推送精彩的射門、動作;喜歡球星的使用者會著重推薦球員的特寫,從而達到千人千面的效果。

智慧導播涉及的技術比較廣泛,例如:動作/事件識別、人臉識別、姿態估計、高光檢測、相機檢視切換等等。值得一提的是,二十年前,我在微軟實習時候,導師就安排過相應的任務,但是由於資料和算力的限制,沒有做到很好的效果。兩年前,我們才在京東上線該功能。

元宇宙的概念很火熱,京東也在數字人方面做了一些嘗試。日前也憑藉跨模態分析技術、多模態互動數字人技術分別斬獲ACM國際多媒體頂級會議的最佳演示獎(Demo)。

傳統的數字人只能進行“文字互動”,而今天的數字人希望能夠模擬真人進行對話,其特點在於形象、逼真、實時反應等等。目前,數字人技術已經成功在市長熱線中部署。

3 邁向通用AI

通用AI一直是人類的夢想,邁向通用AI的過程中,在視覺方面必須要從感知過度到認知,如此智慧視覺系統才能進行決策。

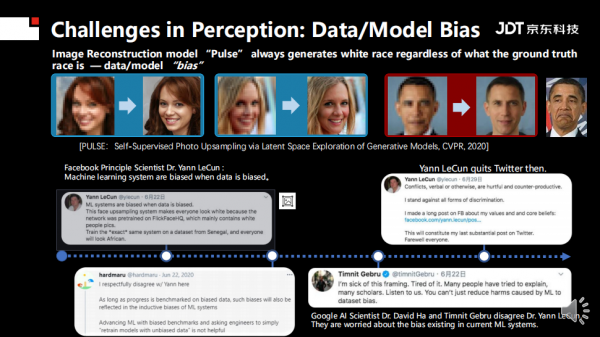

但其中會遇到很多挑戰,例如魯棒性,直接表現在自動駕駛領域,汽車相撞、識別錯誤等等都表明系統不夠魯棒。模型和資料偏見也是學界經常討論的焦點,前段時間AI領域的大牛Yann LeCun在推特上因為“偏見來自資料還是來自模型”的發言被diss退網。

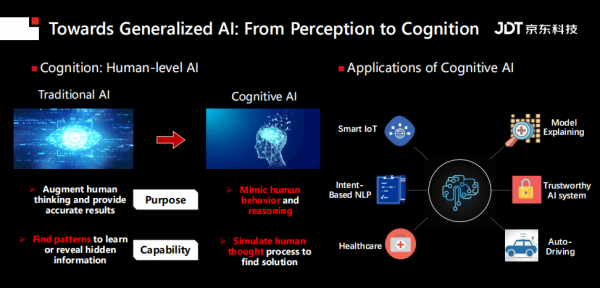

認知智慧和感知智慧的區別主要有兩點,在目標層面,傳統AI希望增強人類思維並提供準確結果,而認知AI希望模仿人類行為和推理;而在能力層面,傳統AI希望找到學習模式或揭示隱藏資訊;而認知AI希望能夠模型人類思維從而找到解決方案。顯然,認知AI將來會有很多用途,例如可信系統、模型解釋等等。

實現認知AI,有三個核心問題要解決:第一,需要考慮如何對結構知識進行建模;第二,如何讓模型可解釋;第三,如何讓系統擁有推理能力。

針對結構知識建模,學界目前已經有一些嘗試,例如斯坦福大學李飛飛開發的Visual Genome資料集,華盛頓大學釋出的VCR資料集等等。

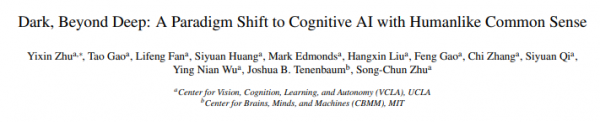

推理方面進展如何?北京通用AI研究院朱松純教授最近在《中國工程院院刊》中發表論文稱:透過 對一張簡單圖片的分解,計算機視覺系統應該能夠同時進行以下工作:1.重建3D場景估算相機引數、材料和照明條件;2.以屬性、流態和關係對場景進行層次分析;3.推理智慧體(如本例中的人和狗)的意圖和信念;4.預測它們在時序上的行為;5.恢復不可見的元素,如水和不可觀測的物體狀態等。

論文題目:Dark, Beyond Deep: A Paradigm Shift to Cognitive AI with Humanlike Common Sense

論文地址:https://arxiv.org/abs/2004.09044

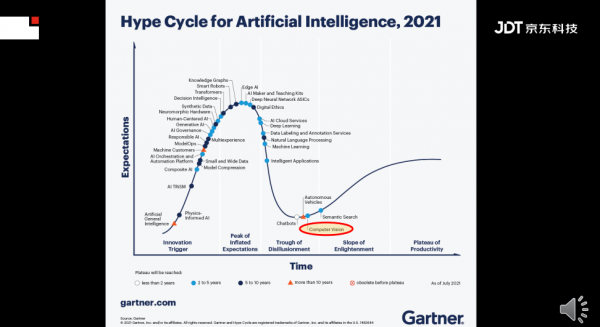

最後,以gartner的一張趨勢預見圖結束演講。每一個技術的開始都會經歷缺口、泡沫、泡沫破滅以及谷底、理性迴歸等幾個階段。正如上圖所示,通用AI裡面的可解釋性、可信任都還在爬升階段,而計算機視覺已經到了第四階段的尾聲,這意味著未來的兩三年,計算機視覺會邁向技術成熟階段,而且會得到大規模的商用,普惠人類生活。

GAIR 2021大會首日:18位Fellow的40年AI歲月,一場技術前沿的傳承與激辯

2021-12-10

致敬傳奇:中國並行處理四十年,他們從無人區探索走到計算的黃金時代 | GAIR 2021

2021-12-09

時間的力量——1991 人工智慧大辯論 30 週年紀念:主義不再,共融互生|GAIR 2021

2021-12-12

未來已來,元宇宙比你想象中來得更早丨GAIR 2021

2021-12-12