A/B測試也被稱為對照實驗,起源於醫學研究領域,本質為分離式組間實驗。那麼,在網際網路行業是如何應用實現快速增長的呢?

在產品迭代過程中,我們有很多的想法和方案,但是沒有辦法確定哪一個更好,所以把方案做成A和B,並且將使用者進行均分,在使用者特徵相同的情況下,分別進行A和B的方案,根據使用者真實資料進行評估,選出最優方案。

這就是網際網路的A/B實驗。

用一個具體案例進行分析。

這是一個團購APP的產品貨架,也是流量最大的頁面入口,我們想要最佳化標題文案,將“優惠團購”改成“限時特惠”,看看是否能夠提升點選量。

於是,我們就進行了A/B實驗,最後得出的結論是改動文案整體上沒有太大效果。但是對於單價較高的娛樂產品來說,點選量提高了;但對於單價較低的餐飲產品來說,點選量沒有變化。

產品團隊也從中得到啟發,單純的文字遊戲已經不能刺激到消費者了。於是我們做了一個新測試,突出折扣力度。

原始的版本只是凸顯了原價和優惠價,現版本把折扣力度擺出來,明明白白告訴消費者打了多少折實際優惠。透過A/B測試,發現原來這樣的改動更能刺激使用者,整體點選率上升3%,客單價高的娛樂類提升更為明顯為4.5%,甚至連之前沒有打動的餐飲類客戶也提升了1.6%,總結髮現相比文案,使用者對數字/價格更敏感。

所以,覆盤這個例子可以得知,我們需要透過A/B實驗,用自己的產品和真實使用者檢驗自己的策略,這樣才能得到增長實踐中最有用的資訊。

而位元組跳動在發展的過程中積累了很多產品和運營的增長方法論,也希望透過火山引擎這樣一個平臺輸出給大家。

火山引擎是位元組跳動旗下的企業級技術服務平臺,將位元組跳動快速發展過程中積累的增長方法、技術工具和能力開放給外部企業,提供雲、AI、大資料技術等系列產品和服務,幫助企業在數字化升級中實現持續增長。

位元組內部是如何增長的呢?

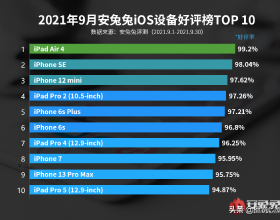

首先我們自己每釋出一款新的APP,其名字都要打N個包去各大應用市場跑A/B測試,把產品的決策權交給使用者。張一鳴同學有句話說的就是:“哪怕你有百分之九十九點九的把握確定,那就是最好的名字,那測一下又有什麼關係呢?”

抖音和頭條的名字也是透過A/B測試來的,但抖音並不是當時下載啟用的第一名,但是產品團隊覺得抖音這個名字更貼合產品定位和調性,就用了抖音這個名字。

上面這個故事幾乎每天發生在位元組跳動,如今,A/B測試平臺已經服務了超過五百條內部業務線,實際累計超過80萬個實驗,日增實驗1500+,能夠同時支撐超過一萬個核心產品以及其他產品線的實驗同時執行。

小到對外投放的一條推送文案,大到技術底座的升級,推薦演算法的最佳化,功能的迭代,我們都是會先透過A/B測試跑出一個正向的效果,才會推廣到全量使用者。

增長駭客的創始人Sean Ellis說過:“如果你不做實驗的話,我們可能就不會有增長。”

意思就是,我們每發版一個APP,會有很多部門推出的功能同時上線,如果不做實驗,就不知道業務指標的波動是受了哪個功能影響。

還有一種情況,當我們的業務處於上升期,儘管我們什麼都不做,業務指標還是會上升。那我們的迭代真的能帶來實際增長嗎?

其實業務發展的邏輯就像是馬拉松,需要低損耗地朝正確方向持續小跑。

透過小流量去測試使用者,能夠加速產品的迭代,小步快跑積少成多。同時透過A/B測試保證資料是穩定且有效的,降低決策風險,保證眼前的路不是下坡路。

下圖中的資料增長閉環,產品和運營人都不陌生。

舉一個具體例子,為什麼支付頁的轉化率低?很多人覺得就是透過分析資料猜測原因,選一個看似最能解決問題的可能就直接上線。在沒有A/B測試的情況下,這看似是資料驅動決策,實際上還是經驗驅動決策。

如果是我們,我們會怎麼解決?

首先會提出假設,是使用者不喜歡我們的UI風格嗎?還是覺得支付流程過長?那透過設計不同UI風格,精簡支付流程,同時讓這兩個方案進行A/B測試,讓使用者真實的行為告訴我們,更喜歡哪個方案。

解讀實驗報告的過程也是在解密功能對使用者行為影響的過程。

A/B測試能夠加深我們對產品和使用者的認知,糾正過去錯誤的理解和偏見。

所以資料驅動這個圓環不停旋轉起來,沉澱下來的就是新的經驗新的認知,也提高了業務團隊的決策能力。

所以A/B對於位元組不僅是工具,可以說一種業務文化,這種經驗和文化不斷的傳播,大帶小、老帶新,就形成了公司內部的正迴圈。

前面溝通了這麼多A/B的價值,A/B實驗具體可以在哪些場景下使用?

以電商使用者為例,如下圖所示,這是電商產品拉新、獲取、啟用、到最後流失的整個留存曲線。在這其中有幾個拐點,產品和運營的工作就是運營和增長的手段在拐點來臨之前把他們拉回,A/B測試所運用的地方也是這些拐點之前。

舉個例子,在做廣告投放時,可以透過不同的落地頁進行轉化對比,提升投放的ROI。使用者吸引來之後,要對他進行啟用,可以發優惠券,優惠券的金額根據資料對比實驗決定。

成為了活躍使用者之後,使用者只有在體驗過產品的核心功能並認可產品的價值才會真的留下成為一個活躍使用者,這個階段會做產品實驗比如最佳化搜尋、下單流程、支付流程等。

電商希望更多使用者的能更快地匹配到更合適的商品、這樣不僅能讓使用者在app停留更久,也能促進高頻高質量的消費,就要推薦演算法提升粘性,就會用到推薦演算法調優實驗。

- 針對老使用者,可以開發針對性的個性推送提升復購;

- 針對沉睡使用者,可以進行定向圈人開push實驗進行召回喚醒。

這就是A/B測試在整個使用者生命週期中的作用。

舉一個實戰案例,來講述下A/B實驗是如何在支付環節提升收益的。

這是一個租車APP,使用者在結算頁面需要支付租金和押金。押金比租金要高很多,這兩個金額同時支付對於使用者的心理成本很大,所以支付頁面的轉化率很低。

我們提出一個想法,把押金和租金的支付頁面分開,明確告訴使用者押金支付完可以退,是否能提升下單。

也有人擔心這樣拆分支付流程變長,使用者會流失。

但是透過A/B測試,發現改動之後下單轉化率提升了7%。雖然支付流程變長了,但是降低了使用者的心理阻力。

有了最佳化場景,想做A/B實驗,但具體的頁面應該如何最佳化呢?

我們提出了LIFT模型,並且從中總結了一個公式:

使用者動機=使用者感受到的價值/收益–使用者感受到的成本

我們要做的就是放大收益,縮小成本。

還是以電商產品為例,價值主張就是希望買到物美價廉的商品。如何放大這個價值呢?如果我是一個美妝愛好者,那就需要把營銷的重點放在美妝品類,並且讓我清楚地第一眼就知道這是一個關於美妝的營銷活動。

以上就是需要提升的因素,而焦慮性和注意力都是需要降低的因素。

比如焦慮性,說一個大家不一定注意到的焦慮感來源,如果UI頁面的色彩對比過於明顯,對比度過高,從心理學層面來說會對使用者造成一定程度的視覺焦慮。透過最佳化UI頁面,可以減少焦慮和分散注意力的情況。

位元組做了80w+實驗,從前期的A/B小白到後期輸出成熟的A/B測試平臺,我們也是親身踩坑,總結出了以下經驗,實驗常見的8個錯誤認知:

有些同學為了校驗分流服務是否正常喜歡開aa實驗,但是在檢驗假設的過程中,我們會犯第一類錯誤——我的策略沒有用,但實驗結果顯示我的策略有用。

在95%的置信水平下這類錯誤出現的機率是5%,即我們開100次AA實驗,然後觀測某個指標,可能會有5次得到顯著的結果。這是由於不可避免的抽樣誤差所導致的。發生AA置信的情況屬於正常現象,A/B測試平臺會保證分流和統計服務的可靠性,請你儘管大膽假設,小心實驗。

另外,實驗不顯著就不停止實驗。理論上任何一點差異只要樣本足夠多,都能檢測出差距,A/B實驗中,無論A策略與B策略多麼相像,他們終歸是不一樣的。理論上來說,只要樣本足夠多(比如無窮多時),最後實驗結果都會形成統計顯著。但這種顯著有意義嗎?比如我的實驗開啟了整整10年,新策略使指標提升0.001%。

那這樣的實驗意義大嗎?

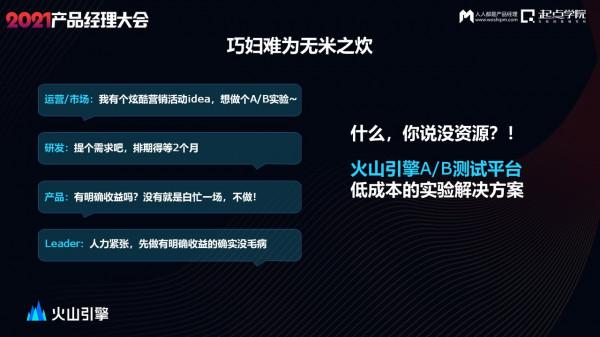

既然A/B測試這麼有效,但是公司開發資源緊缺,這可怎麼辦?

位元組早期A/B測試也是沒有產品化平臺的,後續為了降低我們自己做實驗的成本,開發了火山引擎A/B測試平臺,一個低成本的實驗解決方案。

比如運營人常用的落地頁實驗,將不同樣式的落地頁連結放上去,就能對比看出不同落地頁的轉化效果。

視覺化實驗,如果只是想改動頁面的中文案、圖片、顏色等,可以透過視覺化實驗調整UI頁面。

push實驗,這也是運營最常用的實驗。測試推送的時間、推送的文案、推送的策略等,找到最佳的轉化方案。

這還不夠,用技術和演算法實現了實驗智慧化,希望能夠徹底把人力從瑣碎的工作中解脫出來。

因此我們推出了動態調優的智慧實驗,其原理就是多臂老虎機。

這種實驗無需A/B測試,根據使用者實時反饋智慧分配,並保障收益最大化,可以對大部分運營實驗實現智慧化,運營推送文案賽馬、落地頁動態優選、廣告投放策略優選、活動頁面樣式調整呢可以 做MVT多變數組合智慧優選,優勢非常明顯。

我用一個遊戲的例子介紹智慧化實驗是怎麼回事。

為了保持使用者粘性,遊戲一般有完善的使用者激勵體系,這款遊戲app在運營初期設計了一套發元寶來啟用使用者的方案。早中晚發放三次元寶,每次會發push通知使用者進行召回。

運營精心設計挑出了最滿意四組文案。

這時他犯了難,如果開ab實驗呢就需要一週,耽誤事,而且使用者量也不大,能回收的資料也不多影響實驗效果靠人經驗拍決策質量最不穩定,因此我們就推薦他智慧化實驗完美地解決了這個問題。

實驗開啟後無需操作和關注資料,abcd四組文案在每一次下發後都會實時收集反饋,自動根據上一輪的結果決定下一輪發什麼,效果好的就加大流量效果差的就幹掉,中規中矩的就給一少量流量留用觀察,輪過幾輪的迴圈推送,最終從均分,變成了絕大多數流量分給B和D脫穎而出並且旗鼓相當,A文案慘遭淘汰。最終效果相比均分,ctr提升9.2%,一定程度上實現了千人千面。

一旦實驗增多,人力無法協調,智慧動態調優實驗就是一個解放人力的好方案。

實驗上線後,如何解讀實驗結果呢?目前結果如何,誰好誰壞好多少,哪一天出結果?

例如,今天廣州市的使用者,在不同版本之間的轉化率表現是怎麼樣的,方便我們更快速決策,知道我實驗整體的結果和ROI,讓我們的決策鏈更清晰完整。

實現以上實驗想法的一站式全棧多場景實驗平臺,他具有哪些能力呢?

線上有多端的觸點,多端sdk用來上報使用者行為資料,根據實驗的需要也可以從客戶端或服務端實現分流,用以滿足不同場景做實驗的需求。

同時還需要有正交和互斥分流來保證分流的科學性。

說完分流,在不同的場景做實驗,想要快速上線。程式設計實驗、視覺化實驗、多連結實驗、推送實驗等都是能幫助產品和運營減少成本,快速上線實驗的場景實驗模板。

接著實驗上線後,科學易懂的實驗報告幫助解讀實驗資料,為業務做決策參考。

但是,A/B測試只是一個小流量的測試,產品推廣到全量使用者很有可能會產生效能崩潰、產品功能bug等問題。

Feature Flag智慧釋出可以幫助從小流量A/B測試驗證成功的結果,絲滑穩定地過渡到全量使用者中,為我們的產品迭代保駕護航。

綜上,A/B測試有這些核心價值:

- 業務創新:透過持續的功能最佳化打磨,累積創新效果,逐步形成迄今最優的產品形態。

- 降本增效:降低試錯成本,降低技術資源投入。例如UI互動最佳化,可直接透過視覺化實驗,無需申請研發資源,快速上線。

- 收益提升:最佳化產品購買流程/文案可直接帶來可觀的經濟收益。

- 管理提效:業務部門精準衡量新策略/功能,對大盤整體的業績貢獻度,為管理層向上彙報提供準確的資料依據和科學度量。

我們總結了一個增長實踐的地圖。

火山引擎在產品運營方面是如何實現增長的呢?

從頂層目標【提升app活躍】進行拆解,得到提升主動自然訪問和被動運營訪問兩個路徑,自然訪問透過完善產品功能體驗,加強福利權益,創意互動等去支撐自然訪問的提升,運營訪就涉及精細化觸達,透過觸點,內容和策略的管理來實現提升被動開啟的次數。

再透過不同的策略以及方法論,實現roi和規模的最大化,

這些其實都離不開強大的資料基座能力、資料分析,增長策略(包含ab測試),以及建模能力。

從下至上,達到提升活躍的最終目的。

我們的初心和願景均是鼓勵大膽創新,透過嚴謹的邏輯和工具小心求證,方能收穫增長。