機器之心專欄

加州大學洛杉磯分校、MIT、斯坦福等

來自MIT-IBM 沃森人工智慧實驗室首席科學家淦創團隊提出了新一代視覺推理資料集,該資料集提出了基於區域性(part)的視覺推理,並融合了五類人類認知推理任務:概念型推理,關係型推理,類比型推理,數學推理和物理推理。

人類視覺感知的一個關鍵點是將視覺場景解析為物體,並進一步解析為物體的各個區域性,從而形成部分 - 整體層次結構。這種層級結構可以誘匯出豐富的語義概念和關係,從而在解釋和組織視覺資訊方面,以及視覺感知和推理的泛化方面發揮著重要作用。然而,現有的視覺推理資料集主要關注整個物體,而不是物體中的區域性。由於更細粒度的概念、更豐富的幾何關係和更復雜的物理關係,基於部分 - 整體層次結構的視覺推理比以物體整體為中心的推理更具挑戰性。

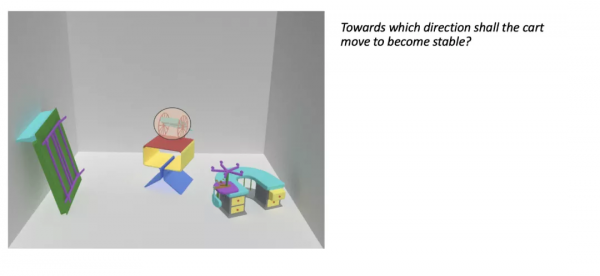

因此,為了更好地闡釋和理解基於區域性的概念和關係,本文引入了一個新的名為 PTR 的大規模診斷型視覺推理資料集。PTR 包含大約七萬 RGBD 合成影象,帶有關於語義例項分割、顏色屬性、空間和幾何關係以及某些物理屬性(例如穩定性)的物體和區域性標註。這些影象配有五種型別的問題:概念型推理,關係型推理,類比型推理,數學推理和物理推理。這些型別均來自於人類認知推理的重要方面,但在以往的工作中並沒有被充分探索過。

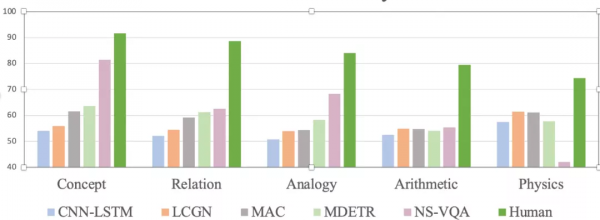

本文在這個資料集上檢驗了幾個最先進的視覺推理模型。研究者觀察到它們的表現遠遠不及人類表現,特別是在一些較新的推理型別(例如幾何,物理問題)任務上。該研究期待這個資料集能夠促進機器推理向更復雜的人類認知推理推進。

- 論文地址:http://ptr.csail.mit.edu/assets/ptr.pdf

- 專案主頁:http://ptr.csail.mit.edu

1 背景介紹

視覺推理要求機器透過觀察給定的場景來回答推理問題。近年來,由於在自然資料中存在大量的噪聲和偏差,研究人員合成數據集。合成數據集的生成是完全可控的,因此研究者更容易診斷推理模型中的不足。CLEVR[1] 是這類資料集中的代表。然而,各類視覺推理模型在 CLEVR 上的準確率已經趨近飽和,這是因為 CLEVR 資料集的推理侷限於感知層面,遠遠落後於人類在認知層面的推理能力。因此,本文提出了新一代視覺推理資料集,專注於對人類來說相對容易,但在機器推理領域還沒有被充分發掘的新任務。

同時,之前的視覺推理資料集主要關注物體的整體特徵,而不太強調詳細的區域性理解。然而,心理學證據表明,人類會將視覺場景解析為部分 - 整體層次結構。因此,本文提出的資料集主要專注於整體 - 部分關係的推理。

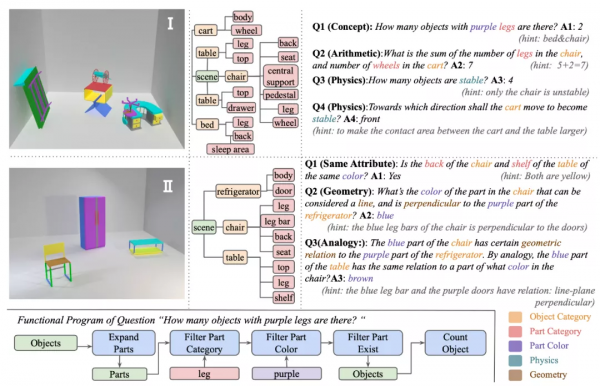

圖二:PTR 資料集介紹

2 資料集介紹

PTR 資料集有七萬的 RGBD 圖片和 70 萬基於這些圖片的問題。本文作者提供了詳細的圖片標註,包括語義例項分割、幾何、物理狀態的標註。資料集的生成採取了精細的偏差和噪聲控制。

下圖總結了 PTR 資料集涵蓋的概念。

圖三:PTR 資料集中的概念

可以看出,PTR 資料集具有豐富的認知層面的概念和關係。在物體整體方面,具有空間關係、物理狀態等概念,在區域性方面,有幾何關係等概念。整體 - 部分的加入大大增加了視覺推理的層次性和豐富性。

PTR 資料集包含了五類問題:概念型推理,關係型推理,類比型推理,數學推理和物理推理。

2.1 概念型推理

主要考察機器對於整體 - 部分的概念和關係的理解。

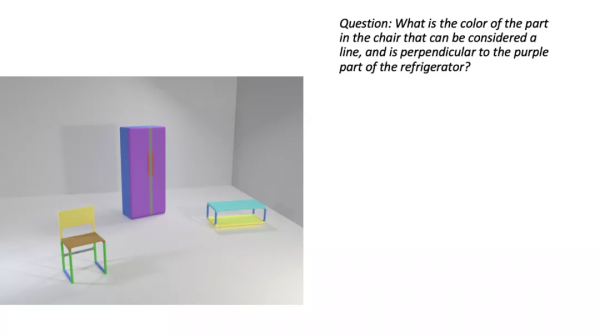

2.2 關係型推理

主要考察機器對於物體之間的空間關係,和區域性之間的幾何關係的理解。

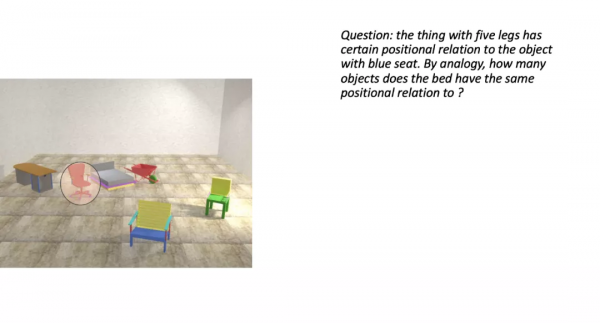

2.3 類比型推理

主要考察機器能否將物體之間 / 區域性之間的關係遷移到其他物體 / 區域性上。

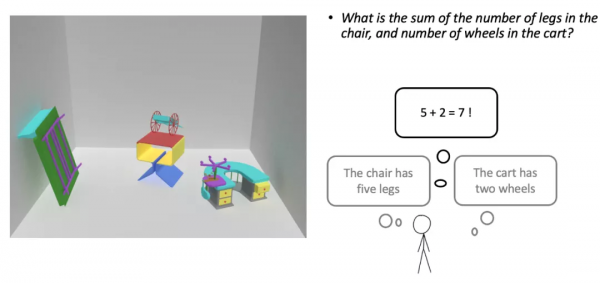

2.4 數學推理

主要考察機器能否對場景進行數學推理。

2.5 物理推理

主要考察機器能否對物體的物理狀態作出判斷。

3 實驗部分

本文檢驗了幾個 SOTA 視覺推理模型在該資料集上的效果,包括 NS-VQA[2], MDETR[3], MAC[4] 等。

圖四:實驗結果

從結果可以看出,視覺推理模型的效果要遠遠低於人類表現。其中 NS-VQA 用到了 ground-truth 分割、語義等訓練模型。然而,在較難的問題例如物理、幾何上面效果仍然很差。

為進一步研究該結果來源於感知上的不正確還是認知推理上的能力欠缺,本文對 NS-VQA 模型進行了消融研究。

圖五:NS-VQA 模型的消融研究

結果表明,即便擁有完美的感知能力並給予該模型所有需要的物體、區域性分割,模型在幾何、類比、物理問題上效果依舊不樂觀。

實驗表明,該研究資料集對未來機器如何進行和人類一樣的認知推理,特別是在一些比較難的物理、集合問題上進行推理,提出了非常重要的方向。

[1] CLEVR: A Diagnostic Dataset for Compositional Language and Elementary Visual Reasoning. Justin Johnson, Li Fei-Fei, Bharath Hariharan, C. Lawrence Zitnick, Laurens van der Maaten, Ross Girshick

[2] Neural-Symbolic VQA: Disentangling Reasoning from Vision and Language Understanding. Kexin Yi*, Jiajun Wu*, Chuang Gan, Antonio Torralba, Pushmeet Kohli, Joshua B. Tenenbaum

[3] MDETR -- Modulated Detection for End-to-End Multi-Modal Understanding

Aishwarya Kamath, Mannat Singh, Yann LeCun, Gabriel Synnaeve, Ishan Misra, Nicolas Carion

[4] Compositional Attention Networks for Machine Reasoning. Drew A. Hudson, Christopher D. Manning