編輯:LRS

【新智元導讀】強化學習的AI在對抗遊戲中表現十分強力,但被虐的只有人類玩家。如果這麼強的AI做了隊友又該怎麼樣?MIT最近研究表明,AI和人類玩家之間的配合可以說是沒有配合了,根本看不懂隊友給的各種暗示資訊!

強化學習的AI在圍棋、星際爭霸、王者榮耀等遊戲以絕對的優勢碾壓了人類玩家,也證明了思維能力可以透過模擬來得到。

但如果這麼強的AI成為了你的隊友,能被帶飛嗎?

MIT林肯實驗室的研究人員最近的在紙牌遊戲Hanabi(花火)中人類和AI agenet之間的合作研究結果表明,儘管RL agent的個人表現能力十分出色,但當跟人類玩家一起匹配的時候,卻只會讓人直呼太坑。

https://arxiv.org/pdf/2107.07630.pdf

Hanabi是一個需要玩家之間互相溝通合作取勝的遊戲,在這個遊戲中,人類玩家更喜歡可預測的基於規則的AI系統,而非黑盒的神經網路模型。

一般來說,最先進的遊戲機器人使用的演算法都是深度強化學習(deep reinforcement learning)。首先透過在遊戲中提供一個agent和一組可能的候選action集合,透過來自環境的反饋機制來進行學習。在訓練過程中,還會採用隨機的探索action來最大化目標,從而獲得最優的action序列。

深增強學習的早期研究依靠人類玩家提供的遊戲資料進行學習。最近研究人員已經能夠在沒有人類資料的情況下,純粹依靠自我博弈來開發RL agent。

MIT 林肯實驗室的研究人員更關注讓如此強大的AI 如何成為隊友,這項工作也能讓我們進一步瞭解是什麼阻礙了強化學習的應用只能侷限於電子遊戲,而無法擴大到現實應用中。

最近的強化學習研究大多應用於單人遊戲(Atari Breakout 打磚塊)或者對抗性遊戲(星際爭霸,圍棋),其中AI 主要的對手是人類玩家或者是其他的AI 機器人。

在這些對抗中,強化學習取得了空前的成功,因為機器人對這些遊戲並沒有一些先入為主的偏見和假設,而是從零開始學習打遊戲,並以最好的玩家資料進行訓練。

事實上,AI學會打遊戲以後,甚至還會自己創造一些技巧。一個有名的例子是DeepMind的alphago在它的比賽中下了一步棋,但分析師當時認為這一步棋是一個錯誤,因為它違背了人類專家的直覺。

但同樣的舉動卻帶來了不一樣的結果,AI最後憑藉這手成功擊敗了人類。所以當RL agent與人類合作時,研究人員認為同樣的聰明才智也可以發揮作用。

在MIT研究人員的實驗中選擇了紙牌遊戲Hanabi,其中包括兩到五名玩家,他們必須合作以特定的順序出牌。Hanabi 很簡單,但它也是一個需要合作和有限的資訊的遊戲。

Hanabi遊戲發明於2010年,由二到五個玩家參與,玩家需以正確的順序一起打出五種不同顏色的牌。遊戲特點:所有玩家都可以看到對方的牌,但卻看不到自己的牌。

根據遊戲規則,玩家可以互相提示自己手裡的牌(但僅限於牌的顏色或數字),讓其他玩家可以推斷他們應該出什麼牌,但提示的次數是有限制的。

正是這種高效溝通的行為使Hanabi具備了一種科學魅力。例如,人類可以很自然地理解其他玩家的提示,哪張卡片是可出的,但是機器本質上無法理解這些提示。

到目前為止人工智慧程式已經可以在玩Hanabi花火遊戲時贏得很高分數,但只限於與其他類似的智慧機器人一起玩。在不熟悉其他玩家的遊戲風格或者有「臨時」(從未一起玩過的)玩家的情況下,對程式的挑戰最大,也更接近真實情況。

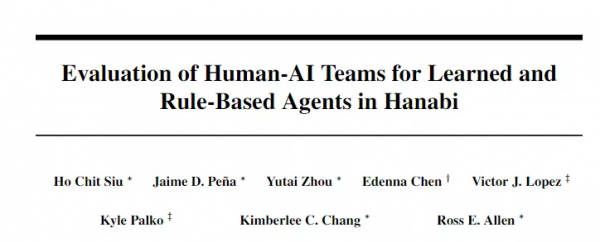

近年來,幾個研究團隊探討了可以玩Hanabi的AI機器人的發展,其中一些強化學習agent使用符號AI。

AI的評估主要採用他們的效能,包括self-play(和自己玩),cross-play(和其他型別的agent一起玩),Human-play(和人類合作)。

和人類玩家之間的cross-play,對於衡量人與機器之間的合作尤為重要,也是論文實驗的基礎。

為了檢驗人工智慧協作的有效性,研究人員使用了SmartBot,這是一種基於規則的self-play人工智慧系統,還有一種在跨遊戲和RL演算法中排名最高的模型Hanabi機器人Other-Play。

在實驗中,人類參與者與AI agent一起玩了幾次Hanabi遊戲,每次隊友的AI都不相同,實驗人員並不知道在和哪個模型一起玩。

研究人員根據客觀和主觀指標評估了人類AI合作的水平。客觀指標包括分數、錯誤率等。主觀指標包括人類玩家的經驗,包括他們對AI團隊成員的信任和舒適程度,以及他們理解AI動機和預測其行為的能力。

兩種人工智慧模型的客觀表現無顯著差異。但研究人員預計,人類玩家對Other-Play有更積極的主觀體驗,因為他們接受過與其他玩家合作的訓練。

根據對參與者的調查,與基於規則的SmartBot Agent相比,經驗豐富的Hanabi玩家在其他遊戲RL演算法方面的經驗較少,成功的一個關鍵點是為其他玩家提供偽裝線索的技能。

例如,說「一個方塊」卡放在桌子上,你的隊友手裡拿著兩個方塊。當你指著卡片說「這是兩張」或「這是一個正方形」時,你暗地裡告訴你的隊友玩這張卡片,而不告訴他關於卡片的全部資訊。一個經驗豐富的玩家會立刻就能夠領會這個提示。但向AI 隊友提供相同型別的資訊證明要困難得多。

一個參與者表示,我已經給了隊友很明顯的提示了,但他根本就沒用,我不知道為什麼。

一個有趣的現實是,Other-play一直在避免建立「秘密」的約定,他們只是在執行self-play時開發的這些預定規則。這使得Other-play成為其他AI演算法的最佳隊友,儘管AI演算法並不是其訓練計劃的一部分。但研究人員認為,這是他在訓練過程中已經假設了會遇到哪些型別的隊友。

值得注意的是,Other-play假設隊友也針對zero-shot 協調進行了最佳化。相比之下,人類Hanabi玩家通常不會使用這種假設進行學習。

遊戲前常規設定和遊戲後覆盤是人類Hanabi玩家的常見做法,使人類學習更容易獲得few-shot協調的能力。

研究人員表示,目前的研究結果表明,人工智慧的客觀任務表現(self-play和cross-play)在與其他AI模型合作時,可能與人類的信任和偏好無關。

這就產生了一個問題:哪些客觀指標與主觀的人類偏好相關?

鑑於訓練基於RL的agent所需的資料量巨大,訓練環中的人是不可行的。因此,如果我們想訓練被人類合作者接受和評估的AI agent,我們需要找到可訓練的,可以替代或與人類偏好密切相關的目標函式。

同時,研究人員也說明,不要將Hanabi實驗的結果外推到他們無法測試的其他環境、遊戲或領域。

論文還承認了實驗中的一些侷限性,研究人員正在努力解決這些侷限性。例如,受試者群體很小(只有29名參與者),並且偏向於精通Hanabi的人,這意味著他們已經預先定義了AI團隊成員的行為期望,並且更有可能對RL agent有負面體驗。

然而,研究結果對未來加強學習研究具有重要意義。

如果最先進的RL agent甚至不能在一個限制性和窄範圍的遊戲中成為一個可以接受的合作者,那麼我們真的應該期待同樣的RL技術在應用於更復雜、更微妙、更具後果性的遊戲和現實世界的情況時只是可以用。

在技術和學術領域,關於強化學習的爭論很多,而且確實如此,研究結果也表明不應將RL系統的顯著效能視為在所有可能的應用中都能獲得相同的高效能。

在學習型智慧體在複雜的人類機器人互動等情況下成為有效的合作者之前,需要更多的理論和應用工作。

參考資料:

https://arxiv.org/pdf/2107.07630.pdf