曉查 發自 凹非寺

量子位 報道 | 公眾號 QbitAI

Facebook AI(bushi),更準確地說是Meta AI,剛剛釋出了自監督語音處理模型XLS-R,共支援128種語言。

這項技術與Meta公司最新“元宇宙”願景緊密相關。

相互交談是人們互動的一種自然方式,隨著語音技術的發展,未來的虛擬世界可以使用我們技術進行互動,虛擬體驗將與物理世界融為一體。

說人話,就是讓母語不同的人在元宇宙里社交:一位說著英語,一位說著漢語,兩人可以靠XLS-R在元宇宙中無障礙對話。

實際效果如何呢?

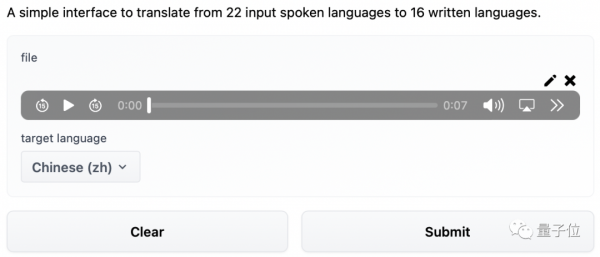

MetaAI在HuggingFace上釋出了試用版語音直譯模型,支援從22種語言轉換到16種語言,我們先來試試它的英譯中效果。

(雖然翻譯腔較濃,但仍算準確,7秒鐘的句子完成翻譯僅1.53秒)

我們知道,世界上的語言有上千種,要用AI實現這些語言的互通並非易事。

一般語料庫的豐富程度決定了語言翻譯模型的質量,語音翻譯一般集中於幾個資源多大語種之間。但是由於小語種往往語料匱乏,使用這類母語的人往往很難獲得較高的AI翻譯質量。

XLS-R透過自監督技術對10倍的語音資料進行訓練,大大改善了以前的多語言模型,尤其是小語種的處理。

XLS-R的原理

XLS-R基於Facebook去年釋出的wav2vec 2.0技術。

wav2vec 2.0與BERT類似,是透過預測音訊mask部分的語音單元來訓練的。它們的區別是,語音音訊是一種連續的訊號,不能輕易清晰地分割成單詞或其他單位。

wav2vec 2.0透過學習25毫秒長的基本單元來解決這個問題,以便能夠學習高階上下文表示。

在僅擁有一小時的標記訓練資料的情況下,wav2vec 2.0能通過後續無監督的訓練資料,在LibreSpeech測試基準的100小時子集上達到SOTA水平。

之後,Facebook又推出了完全無監督的高效能語音識別模型wav2vec-U,它純粹從錄製的語音音訊和未配對的文字中學習。

為了wav2vec-U讓學習識別音訊錄音中的單詞,Facebook訓練了一個GAN。生成器根據嵌入在自監督表示中的每個音訊段,預測與語言中的聲音對應的音素。

而鑑別器負責評估預測的音素序列是否真實。最初,轉錄非常糟糕,但隨著時間的推移,隨著鑑別器的反饋,轉錄變得準確。

透過這種方式,它學會了區分生成器的語音識別輸出和真實文字。

Facebook在此基礎上推出了包含53種語言的XLSR。

而最新發布的XLS-R有128種語言之多,語種數量是XLSR的兩倍多,資料量更是後者10倍——共計長達43.6萬小時的語音。

XLS-R共有20億引數,它在測試的37種語言中,表現優於大多數語種先前的工作。甚至在寮國語等小語種識別上,也能低於之前的錯誤率。

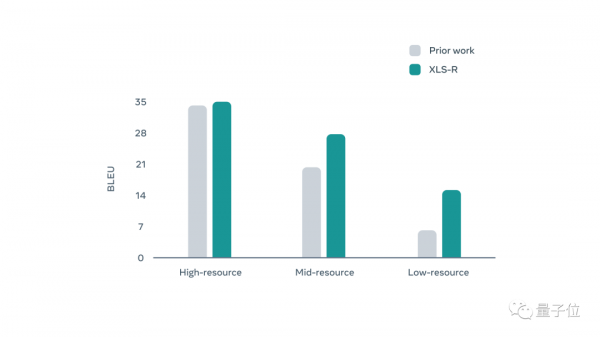

此外XLS-R也讓低資源語言與英語之間的翻譯大幅改進,例如從印度尼西亞語到英語的翻譯,其中BLEU(雙語互譯質量評估)的準確性平均翻了一番。

CoVoST-2語音翻譯基準測試中,XLS-R在21個英語翻譯方向上比之前技術平均提高了7.4 BLEU。

從下圖中可以看出,XLS-R對低資源語種的提升尤為明顯。

微調XLS-R

XLS-R只是一個預訓練模型,為了能更好地服務於具體任務,還需要對模型進行微調。

Hugging Face官方提供了詳細的微調教程。

此外官方還提供不同引數規模的語音識別模型,以及15種語言與英語之間的互譯模型,供使用者下載。

傳送門

官方部落格:

https://ai.facebook.com/blog/xls-r-self-supervised-speech-processing-for-128-languages/

GitHub頁:

https://github.com/pytorch/fairseq/tree/main/examples/wav2vec/xlsr

論文地址:

https://arxiv.org/abs/2111.09296v1

試用網頁地址:

https://huggingface.co/spaces/facebook/XLS-R-2B-22-16

微調方法簡介:

https://huggingface.co/blog/fine-tune-xlsr-wav2vec2

— 完 —

量子位 QbitAI · 頭條號簽約

關注我們,第一時間獲知前沿科技動態