在過去的 10 年裡,效能最好的人工智慧系統,比如智慧手機上的語音識別器或谷歌最新的自動翻譯器,都是由一種稱為「深度學習」的技術產生的。

深度學習實際上是一種稱為神經網路的人工智慧方法的新名稱,70 多年來一直時興時衰。神經網路最初是由 Warren McCullough 和 Walter Pitts 於 1944 年提出的,這兩位芝加哥大學的研究人員於 1952 年搬到麻省理工學院,他們有時被稱為第一個認知科學系的創始成員。

神經網路是神經科學和計算機科學的一個主要研究領域,直到 1969 年,根據計算機科學的傳說,他們被麻省理工學院的數學家 Marvin Minsky 和 Seymour Papert 「扼殺」了。一年後,Marvin Minsky 和 Seymour Papert 成為麻省理工學院新的人工智慧實驗室的聯合主任。

該技術隨後在 20 世紀 80 年代復興,在新世紀的第一個十年再次陷入衰退,並在第二個十年如火如荼地迴歸,主要是由於圖形晶片處理能力的提高。

麻省理工學院麥戈文腦科學研究所研究員、麻省理工學院大腦、思想和機器中心、麻省理工學院腦與認知科學教授 Tomaso Poggio 說:「有一種觀點認為科學中的想法有點像病毒的流行。 顯然有五六種基本的流感病毒株,而且顯然每一種都會在大約 25 年內迴歸。人們被感染後會產生免疫反應,因此在接下來的 25 年內不會被感染。然後新的一代,將被同一株病毒感染。

在科學中,人們會愛上一個想法,為之興奮,將其錘死,然後免疫——他們厭倦了它。所以思想應該有同樣的週期性!」

重大事項

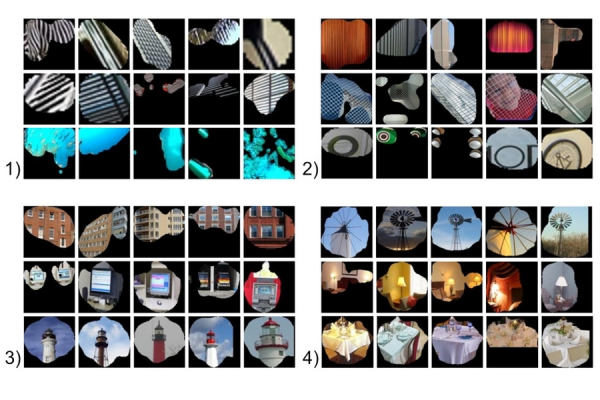

神經網路是進行機器學習的一種手段,計算機透過分析訓練示例來學習執行某些任務。通常,這些示例已經預先進行了手工標記。例如,物件識別系統可能會收到數千張帶有汽車、房屋、咖啡杯等標籤的影象,它會在影象中找到與特定標籤一致相關的視覺模式。

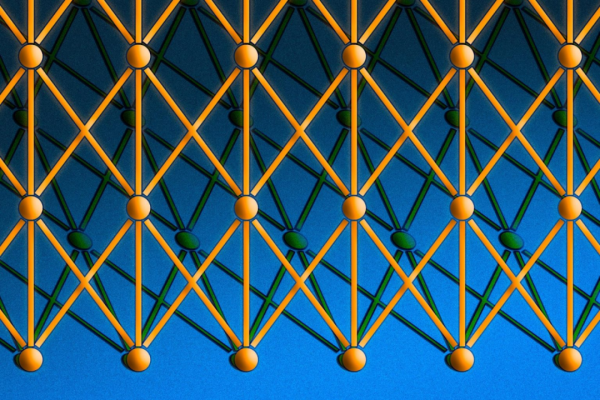

神經網路以人腦為模型,由數千甚至數百萬個緊密互連的簡單處理節點組成。今天的大多數神經網路都被組織成節點層,它們是「前饋」的,這意味著資料只能在一個方向上透過它們。一個單獨的節點可以連線到它下面一層的幾個節點,從那裡接收資料,並連線到它上面一層的幾個節點,向那裡傳送資料。

對於每個傳入的連線,節點將分配一個稱為「權重」的數字。當網路處於活動狀態時,節點在其每個連線上接收不同的資料項(不同的數字),並將其乘以相關的權重。然後將結果乘積加在一起,產生一個數字。如果該數字低於閾值,則節點不會將資料傳遞到下一層。如果數量超過閾值,則節點「觸發」,這在當今的神經網路中,通常意味著沿其所有輸出連線傳送數字,加權輸入的總和。

在訓練神經網路時,所有權重和閾值最初都設定為隨機值。訓練資料被饋送到底層(輸入層)它通過後續層,以複雜的方式相乘和相加,直到最終到達輸出層,徹底改變。在訓練期間,權重和閾值會不斷調整,直到具有相同標籤的訓練資料始終產生相似的輸出。

頭腦和機器

McCullough 和 Pitts 在 1944 年描述的神經網路有閾值和權重,但沒有分層,研究人員也沒有指定任何訓練機制。McCullough 和 Pitts 表明,原則上,神經網路可以計算數字計算機可以計算的任何函式。結果是神經科學而不是計算機科學:重點是表明人腦可以被認為是一種計算裝置。

神經網路仍然是神經科學研究的寶貴工具。例如,用於調整權重和閾值的特定網路佈局或規則,再現了觀察到的人類神經解剖學和認知特徵,這表明它們捕獲了大腦如何處理資訊的某些資訊。

1957 年,康奈爾大學心理學家 Frank Rosenblatt 展示了第一個可訓練的神經網路——感知器。感知器的設計與現代神經網路的設計非常相似,只是它只有一層,權重和閾值可調,夾在輸入層和輸出層之間。

在 1959 年之前,感知器一直是心理學和計算機科學新興學科的活躍研究領域,當時 Minsky 和 Papert 出版了一本名為《感知器》的書,該書表明在感知器上執行某些相當常見的計算會非常耗時。

「當然,如果你採用稍微複雜一點的機器——比如兩層,所有這些限制都會消失,」Poggio 說。但當時,這本書對神經網路研究產生了寒蟬效應。

「你必須把這些事情放在歷史背景下,」Poggio 說。「他們在爭論程式設計——像 Lisp 這樣的語言。不久之前,人們還在使用模擬計算機。當時根本不清楚程式設計要走的路。我認為他們有點過火了,但像往常一樣,這不是黑白分明的。如果你認為這是模擬計算和數字計算之間的競爭,他們在為當時正確的事情而戰。」

週期性

然而,到 20 世紀 80 年代,研究人員已經開發出修改神經網路權重和閾值的演算法,這些演算法對於具有不止一層的網路來說足夠有效,消除了 Minsky 和 Papert 確定的許多限制,該領域迎來了復興。

但從理智上講,神經網路有一些不令人滿意的地方。足夠的訓練可能會將網路的設定修改為可以對資料進行有用的分類,但這些設定意味著什麼?物件識別器正在檢視哪些影象特徵,它如何將它們拼湊成汽車、房屋和咖啡杯的獨特視覺特徵?檢視單個連線的權重並不能回答這個問題。

近年來,計算機科學家開始想出巧妙的方法來推斷神經網路採用的分析策略。但在 20 世紀 80 年代,網路的策略難以理解。所以在世紀之交,神經網路被支援向量機取代,支援向量機是一種基於一些非常簡潔「優雅」的數學的機器學習替代方法。

最近神經網路的復興——深度學習革命——得益於計算機遊戲行業。當今影片遊戲的複雜影象和快速節奏需要能夠跟上的硬體,結果就是圖形處理單元 (GPU),它在單個晶片上封裝了數千個相對簡單的處理核心。研究人員很快就意識到 GPU 的架構與神經網路的架構非常相似。

現代 GPU 使 20 世紀 60 年代的單層網路和 20 世紀 80 年代的兩到三層網路發展為今天的 10 層、15 層甚至 50 層網路。這就是「深度學習」中的「深度」所指的——網路層的深度。目前,深度學習幾乎在人工智慧研究的每個領域都為效能最佳的系統負責。

引擎蓋下

網路的不透明性仍然令理論家感到不安,但在這方面也取得了進展。除了指導大腦、思維和機器中心 (CBMM) 外,Poggio 還領導該中心的智慧理論框架研究專案。最近,Poggio 和他的 CBMM 同事釋出了一個由三部分組成的神經網路理論研究。

https://cbmm.mit.edu/research/thrusts/theoretical-frameworks-intelligence

第一部分發表在《國際自動化與計算雜誌》(International Journal of Automation and Computing)上,討論了深度學習網路可以執行的計算範圍,以及深度網路何時比淺層網路更具優勢。

https://link.springer.com/article/10.1007/s11633-017-1054-2

第二部分和第三部分已作為 CBMM 技術報告發布,解決了全域性最佳化問題;或保證網路找到最符合其訓練資料的設定、過度擬合;或者網路變得如此適應其訓練資料的細節以致無法推廣到相同類別的其他例項的情況。

http://cbmm.mit.edu/sites/default/files/publications/CBMM-Memo-067.pdf

還有很多理論問題有待回答,但 CBMM 研究人員的工作,可以幫助確保神經網路最終打破使它們在七十年內受到青睞和失寵的世代迴圈。

dryy:

https://scitechdaily.com/deep-learning-ai-explained-neural-networks/

--ScienceAI(Philosophyai)