“透過面部和眼部微小運動,即可操控周邊電子裝置;無需攝像頭,戴著 VR 頭盔就能實時捕捉面部表情、追蹤面部動態及眼部動態;即便佩戴著口罩,也能讓別人看到你的嘴部活動。” 這是由美國田納西大學劉健教授團隊、聯合德州大學阿靈頓分校 VP Nguyen 教授團隊聯合研發的耳戴式裝置 BioFace-3D。

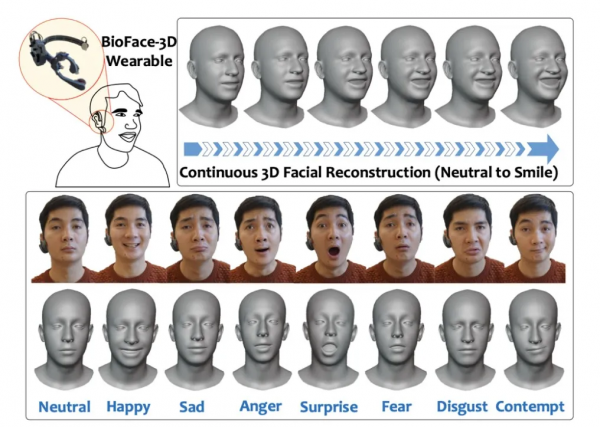

圖 | BioFace-3D 耳戴式裝置(來源:MobiCom 2021)

日前,該團隊設計出一款全新耳戴式裝置,可持續收集使用者生物資訊,並可對其面部活動進行 3D 準確還原[1]。據其介紹,這是第一款基於生物訊號、並能準確、持續、無侵入式地進行面部追蹤和還原的耳戴式裝置。

圖 | 基於耳戴式裝置的多種表情面部還原(來源:MobiCom 2021)

日前,相關論文以《BioFace-3D:透過輕型單耳生物感測器連續進行三維面部重建》(BioFace-3D: Continuous 3D FacialReconstruction Through Lightweight Single-ear Biosensors)為題,發表在計算機網路及移動計算領域國際頂級會議 ACM MobiCom2021 上,美國田納西大學劉健教授課題組 MoSIS Lab 博士生武藝擔任第一作者。

他認為,基於攝像頭的傳統面部追蹤系統存在許多限制,進而會帶來諸多不便:“攝像頭是獲取面部資訊時最直觀的使用方法。但是,必須保證光照充足,臉部也要時刻對準鏡頭,並且鏡頭必須沒有遮擋。

此外,攝像頭的高功耗和隱私安全也亟待解決,這導致攝像頭在某些場景很難投入使用,比如漆黑環境中、人物戴著口罩時、以及體驗 VR 遊戲需要進行大量身體活動時。”

圖 | 基於攝像頭的面部動態捕捉系統的諸多限制(來源:MoSIS Lab@UTK)

基於此,該團隊設計出首款可擺脫這些限制、並能持續進行面部追蹤還原的耳戴式裝置。耳機中包含一個接地電極插槽,並與環繞在腦後的頭帶整合。針對不同的頭型,他們設計了大中小三種尺寸的原型。

頭帶中還包含一個電路盒,用來儲存各種硬體。耳戴式裝置的所有元件均由 PLA (聚乳酸)的 3D 列印技術製造而成,因此機身重量較輕。BioFace-3D 主要基於德州儀器 ADS1299 晶片的生物放大器電路、OpenBCI 公司的 Cyton Board、以及粘在使用者面板上的氯化銀電極表面電極,上面還集成了藍芽模組。

其原理是,當臉部做活動時,肌肉會進行收縮從而產生微弱的電訊號,在醫學上這叫肌電圖(EMG)。該耳戴式裝置上的生物感測器,在捕捉到這些電訊號並經過放大器放大後,可透過藍芽將訊號發給計算機。接著,計算機上的深度學習演算法即可開始工作,持續不斷地將未經處理的生物訊號、以每秒 20 幀的速度轉換為 53 個表現面部特徵的特徵點。

不同面部動作,會牽扯到不同肌肉組織,從而產生不同的肌電圖。而深度學習演算法可精確捕捉到這些差別,藉此還原出使用者的面部表情。在經過卡爾曼濾波的處理後,這些面部特徵點經由一個事先訓練好的頭部模型,即可轉化為 3D 的虛擬形象。

圖 | 不同的面部動作對應不同的肌肉組織(來源:MobiCom 2021)

研究中,該團隊召集 16 名志願者,來參與測試該耳戴式裝置。實驗結果表明,在平均 1.85 毫米的絕對誤差下,該裝置可準確還原 53 個表現使用者表情的面部特徵點,這可與大多數最先進的基於攝像機的解決方案相媲美。

當用戶戴上口罩,該系統仍能以 1.93 毫米的絕對誤差對面部做以準確還原。在實驗結束後,武藝還讓志願者填寫體驗問卷,結果顯示有 13 名參與者對該裝置持積極態度並願意使用它。此外,該系統的功耗為 118 毫瓦,在一塊鋰電池的作用下可連續 8 小時採集併發送生物訊號。

圖 | 使用者調查問卷的結果(來源:MobiCom 2021)

透過生物訊號,可生成 53 個特徵點的座標

回憶研究流程,其表示第一步是獲取高信噪比的生物訊號,來保證使用者面部資訊可被有效捕捉到。同時為提高使用者體驗,不僅要保證生物感測器的數量儘可能地少,還要保證這些感測器可被設定在非敏感面部區域。

測試之後,該團隊將 5 個生物感測器設定在佩戴者耳部附近,該區域可在不犧牲信噪比的同時提高使用體驗。基於這五個生物感測器的位置,他們完成了耳戴式裝置的設計和 3D 列印工作。

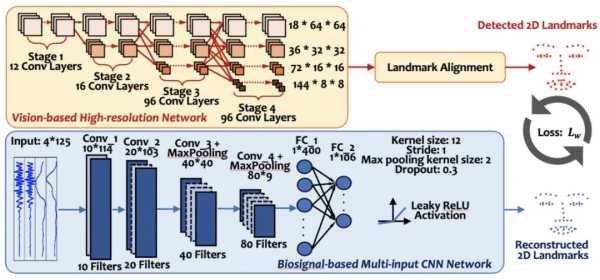

下一步是透過構建演算法,來從未處理的生物訊號中,準確地還原面部特徵點。這時就得用到深度學習,它能透過演算法找出不同訊號之間的聯絡,從而達成人類無法做到的事情。

要想把模型訓練成功,首先要收集大量生物訊號、以及與之對應的面部特徵點的真值。在採集生物訊號的同時,武藝等人使用攝像頭記錄下使用者面部活動,進而透過預先訓練好的高精度視覺神經網路,來從視覺訊號中獲取面部特徵點的真值。

經過反覆測試,該系統最終選擇了基於含有 98 個面部特徵點的 WFLW 資料集訓練的視覺模型,並從 98 個特徵點中選擇 53 個代表性特徵點, 包含眉毛、眼睛、鼻子和嘴巴,並可展現出 8 種不同的面部表情,如無表情、高興和生氣等。這些提取出來的特徵點座標,將用來訓練以生物訊號為輸入的神經網路。

在測試階段,該系統不僅無需使用攝像頭,而且僅憑生物訊號即可生成 53 個特徵點的座標,即可達成和基於攝像頭的方法相媲美的效果。

由於持續收集的生物訊號,從本質上來說就是時間序列,為此該團隊設計了基於一維卷積的神經網路,以此來將生物訊號以每秒 20 幀的速度轉換為 53 個特徵點。武藝表示,從未處理的時間序列訊號中,一維卷積神經網路可快速提取代表性特徵,並進行高效準確的面部還原。

圖| 從預先訓好的視覺神經網路中提取真值,再透過以生物訊號為輸入的網路進行還原(來源:MobiCom 2021)

在一塊英偉達 2080Ti 顯示卡的運作下,神經網路能以 0.033 毫秒一幀的速度,迅速生成面部特徵點。為保證生成的 3D 臉部動畫的穩定性,該系統對生成的面部特徵點序列,進行了卡爾曼濾波,以提升 3D 動畫的最終視覺效果,即視覺觀感更順滑。經過濾波後的特徵點,會經過預先訓練好的模型生成對應的虛擬形象。

可用於阿茲海默症的早期預警等

該裝置可擺脫必須在使用者面前放一臺攝像頭的限制,涉及的系統也能和諸多新興技術進行有效結合。例如,該系統可作為 VR 頭盔的擴充套件,就算你戴著 VR 頭盔也可被實時獲取面部表情。

把這些表情實時匯入 VR 社交軟體中,即可將表情還原出來,並能提升沉浸感,從而讓虛擬世界更真實。

類似地,在疫情期間即使大家都戴口罩,該系統也可捕捉到人們的表情。也可作為人機互動的無聲語音介面,讓使用者透過做表情就能給電子產品發出指令。

該裝置也有用於健康監控的潛在能力,透過長期監測使用者表情,即可評估其認知功能,進而可用於阿茲海默症的早期預警。

據悉,此次論文也是武藝博士期間以一作身份發表的首篇頂會論文。在提交論文的截稿日幾天前,他經歷了一個小插曲:字號用錯了。MobiCom 要求 10 號字型及以上,而臨到頭他才發現一直使用 9 號字。如果沒有發現及時,論文很有可能被拒稿,並導致團隊努力付之東流。為此,武藝和團隊連夜進行大幅刪減、修改,趕在截稿日前一天完成全部論文寫作。他說這個插曲給自己敲響了永生難忘的警鐘。

武藝和該論文的另一位作者李倬航,目前均是田納西大學 EECS 系的博士生, 在劉健教授課題組 MoSIS Lab 攻讀博士學位。他倆從本科時便是同學,均畢業於電子科技大學,碩士則畢業於羅格斯大學計算機工程系。

未來,該專案團隊計劃將透過設計定製型資料收集板,來進一步提高系統的能源效率,也將使用更緊湊的模擬和更少的通道。團隊還計劃開發一個與主要 AR/VR 平臺(如 OpenVR)相容的 API 庫和一款 App,以便去支援各種移動裝置。