10 月 30 日下午,2021 WeDataSphere 社群大會在深圳灣科技生態園創新廣場順利舉行。現場,開源界大咖、WeDataSphere 社群貢獻者和維護者,以及近兩百位開源愛好者,大家共聚一堂,交流技術,共論開源之道。

據悉,本次大會不僅邀請到開放原子開源基金會 TOC 主席堵俊平,而且包括 WeDataSphere 社群發起人邸帥、天翼雲大資料平臺技術專家王小剛、薩摩耶雲資料業務部總監易小華和四位微眾銀行大資料平臺工程師均到場。作為開源大資料行業的觀察者和實踐者,他們紛紛發表了精彩的演講內容。

1堵俊平:Hadoop 沒死,開源大資料基於技術和潮流在不斷演進

堵俊平是開源大資料行業的“老兵”,他開場先帶領大家回顧了開源大資料最近十幾年的發展。

在 20 世紀 90 年代,隨著網際網路的快速發展,資料快速增長,但以前的技術手段無法解決新問題。後來,谷歌基於搜尋引擎的多年實踐提出“三駕馬車”,即 GFS、MapReduce 和 BigTable。這“三駕馬車”給 Hadoop 創始人 Doug Cutting 很大的啟發,於是,他在 2006 年寫出第一個 Hadoop 引擎。這算是業界開源大資料的起點。

Hadoop 橫空出世後,被很多網際網路公司和科技公司紛紛採用,因為大家的需求類似——怎麼以更低成本提升硬體利用效率,從而最大化地發揮資料價值。之後,Hadoop 在 2008 年從 Apache 畢業,這成為標誌性事件。再過一年,第一款大資料雲服務在 AWS 上線,這意味著開源大資料走向雲時代。

此後,Hadoop 生態加速發展,除了 Hadoop,又有了 Spark、Flink 等。 到 2.0 時代,Yarn 從 Hadoop 中分離, 它把資源管理跟上層的應用排程做了兩層分離,這樣,在 Hadoop 底層,Yarn 更像一個通用平臺,上面是更多的引擎,整個體系可以不斷演進。3.0 時代,Hadoop 開始與更多的技術相結合。

縱觀整個開源大資料的生態系統,既有新的大資料專案在不斷孵化,又有一些式微的開源專案。總體上,它根據技術和潮流的方向不斷演進,而非一成不變的靜態系統。

大體而言,這個領域的技術有以下趨勢:一是統一的 SQL,即 Unified SQL。二是批流的統一。生態趨勢上,開源大資料不斷衍生和迭代,Hadoop 也沒有死,但如果把 Hadoop 視為開源大資料生態體系,那麼它仍在蓬勃發展,只是引擎沒人在用。

除了回顧開源大資料的發展歷程,堵俊平還分享了自己對開源的看法。開源專案有多個角色,包括開發者、使用者、廠商和基金會等,每個角色只要持續參與進來,從中找到價值,生態就會持續演進。

2邸帥:企業資料平臺的建設應該量體裁衣,因地制宜

作為 WeDataSphere 社群發起人、微眾銀行大資料平臺團隊負責人,邸帥分享了 “WeDataSphere 大資料平臺套件的建設思路和開源歷程”。

為什麼要建資料平臺?邸帥認為這是由於兩方面的需要:一是在機構或公司,它是商業化挑戰的需要;二是技術挑戰的需要。從容量、效能、效率和成本方面,企業要考慮以什麼樣的技術形式解決構建資料平臺的問題。

他表示,資料平臺對於企業,猶如血液迴圈系統之於人體。

那麼,企業如何建設資料平臺?借用《平臺革命》一書,平臺最核心的價值是促成很多最核心的互動,即“參與者 + 價值單元 + 過濾器 =>核心互動”。而最能體現平臺價值的能力是吸引、促進和匹配。在資料領域,問題在於怎樣提供更好的資料工具和服務,促使資料平臺完成吸引、促進和匹配。

無論是鋼鐵俠的 AI、雲上數倉(比如 Snowflake)或 Gartner 十大資料和分析趨勢,在邸帥看來,每個公司或團隊真正需要的資料平臺應該要量體裁衣,因地制宜,根據自己的情況找到比較好的解決方案。

以量體為例,企業需要在資料管理能力層面、資料平臺能力層面和資料應用情況方面摸清現狀,從而確立自己的目標。

邸帥表示,“我最想表達的是,如何建設好資料平臺,要從資料管理、資料平臺、資料應用三個層面摸清現狀,然後基於 WeDataSphere + 其他優秀開源專案提供的“布料”來“量體裁衣”。我們 WeDataSphere 的建設思路最核心的三點是:首先方向選擇是主力投入上層功能工具系統的建設和開發,底層引擎層更多是做補充,比如 bug 修復。然後兩個最核心的設計要點是“一站式”和“全連通”。“

在 WeDataSphere 建設思路上,他指出:資料平臺範圍龐大,團隊規模資源有限,要想做出特色和優勢,須從產品架構設計,和多團隊共建模式上進一步最佳化。借用微眾銀行副行長兼資訊長馬智濤先生的一句話就是“小刀鋸大樹,必須靠方法。”具體而言,一是透過合理的構建功能工具整合開發框架和中介軟體層,獲得更極致的連通、解耦、易擴充套件、高度複用能力,簡化整體架構和呼叫關係,大幅降低新功能工具開發和平臺運維成本;二是基於“開源”吸引一切可以團結的力量,多方聯合共建。

在社群建設層面,微眾銀行、天翼雲、仙翁科技、薩摩耶雲、Boss 直聘的團隊聯合開發了 Streamis。同時,今年,微眾銀行與合作伙伴還構建了兩個大的專案:Exchangis 1.0和 DataModelCenter。

對於 WeDataSphere 的未來,邸帥表示,首先做得更深,其次做得更廣。

3尹強:Apache Linkis 是站在四個巨人肩膀上的開源工具

在 WeDataSphere 中,計算中介軟體 Linkis 解決前臺各種工具、應用,和後臺各種計算儲存引擎間連線簡化和複用問題,是非常重要的一環。尹強是 Apache Linkis PPMC,他分享了 Linkis 的建設及開源思路。

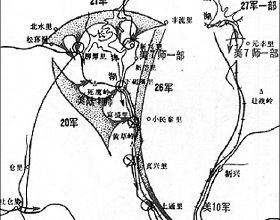

先說說大資料平臺面臨的計算治理問題。大資料平臺不斷髮展,底層有很多的計算儲存引擎,上層有很多的應用工具,包括批次計算、互動式計算、流式計算、資料分析工具、資料治理工具等。平臺元件越來越多,開發維護愈加困難。這樣的背景下,Linkis 誕生,主要解決上層應用工具和底層儲存引擎之間關於“連通、擴充套件、管控、編排、複用等‘計算治理‘問題”。

針對此問題,目前主要有四個開源社群解決方案:一是 Apache Livy,透過提供 REST 服務,它能簡化使用者與 Spark 叢集的互動。同時,它聚焦於“連線”能力。透過 Job 或程式碼片段,簡化 Spark 任務提交。

二是 Apache Zeppelin,它是基於 Web 的互動式資料分析 Notebook,聚焦於“擴充套件”能力。獨有的 Interpretor 架構,可快速對接新的大資料引擎。

三是 Netflix Geine,它是分散式作業編排引擎,聚焦於“管控”能力。強大的標籤體系,支援按需路由作業到不同的 Hadoop 叢集。

四是 openLooKeng,它是一款高效能資料虛擬化引擎,提供統一 SQL 介面,具備跨資料來源 / 資料中心分析能力。聚焦於“編排”能力。透過編排 SQL,支援跨資料中心、跨雲的異構資料來源查詢。

在尹強看來,這四個解決方案各自特點非常突出,比如 Apache Livy 在連線上做得很好。但是,它們又有不足,因此企業級大資料平臺呼喚“既具備擴充套件又具備管控,還具有編排、連通、複用能力的中介軟體”。Linkis 是一款站在巨人肩膀上的開源工具,可以極大簡化大資料平臺的架構,降低開發和運維的複雜度。為什麼這麼說?

Linkis 構建解耦計算中介軟體層,具備連通、擴充套件、管控,、編排和複用能力。連通上,告別應用孤島,它可以打通使用者資源 & 執行時環境。擴充套件上,透過實現 Linkis EngineConnPlugin,完成新引擎適配,統一解決高併發、高可用、多租戶等問題。管控上,它具備基於標籤的多級精細化資源控制和回收能力,可以實現多級精細化引數化配置控制。編排上,它基於 Orchestrator 服務的雙活策略設計和混算策略設計。複用上,它大大降低上層應用 / 工具開發後臺程式碼量,並基於 Linkis 快速高效打造資料平臺工具套件。

最後,尹強談到了 Apache Linkis 的開源情況和未來規劃。從 2019 年 7 月,Linkis 第一個開源版本釋出,去年 12 月,社群主導的第一個版本釋出。此後,它不斷迭代和發展,於 2021 年 7 月進入 Apache 基金會孵化器,並在 9 月榮獲 2021 屆開源產業大會“OSCAR 尖峰開源專案和開源社群”獎項。

至於未來,一方面是它在 Apache 基金會好好孵化;另一方面,最佳化社群運營,與生態相關頂級專案建立更緊密合作,同時,產品迭代加速。

4王小剛:WeDataSphere 開源元件在天翼雲大資料平臺產品中的應用

作為天翼雲大資料平臺團隊技術專家,王小剛分享了 WeDataSphere 開源元件在天翼雲大資料平臺產品中的應用。

首先談到為什麼會與 WeDataSphere 結緣?他解釋:內因是電信集團進行“雲改數轉”戰略,天翼雲過去的叢集存在建設分散,整體資源複用率低,以及資料加工指令碼管理混亂,故障頻發等問題。外因在於,CDH、HDP 合併,商業版軟體訂閱費用昂貴,技術繫結,同時,市場缺乏優質的同類開源產品。我們拿自己開刀花了一年多時間從 CDH 商業版升級到 Hadoop 最新版,但光去 CDH 還不夠,核心是使用者需要統一的大資料平臺。我們同時圍繞 Hadoop 最新版,擁抱開源、打造自主可控、技術領先、安全穩定的大資料平臺。

之所以瞭解 WeDataSphere,主要在於 Linkis。“當時,看到它的時候感覺很新鮮,並且和我們的思路一致,它已經開源,平臺完善度高,社群也很活躍。它可封裝,可水平復制,一站式,非常開放。對我們來說,改造成本適中,運維和維護成本較低。所以,我們選了 Linkis“。

在王小剛看來,Linkis 有強大的入口能力,這正是他們所需的,用它來隔離底層複雜性,保證持續智慧最佳化的可能性。其次,Linkis 奉行開放開源的策略,親切且先進的架構設計,有相對完善的文件,這些對於開發者來說都是非常友好的。

並且,他們展示了基於 Linkis 持續在做的一些工作,比如更完善的容器化、更大規模的驗證、資料來源管理、資料整合能力、實時計算能力等,以及後續希望實現跨叢集作業提交、SQL 路由、安全能力等等。

在具體實踐上,用他的話說:先“玩”起來,深度試用,與內部底座進行整合;然後,逐步完善,修復 bug;接著,針對遇到的一些問題進行較為深度的二次開發;最後就是擁抱開源與社群共建,現在我們已經完全深度參與社群,和社群小夥伴們分工合作,共同研發。

而說到使用者體驗側,王小剛提到,隨著大資料平臺的不斷普及,各層級的使用者也日益增多,市場主流產品存在一定同質化現象,而在這其中,往往使產品能夠脫穎而出的,就是使用者易用性的提升。天翼雲在這塊也做了很多嘗試,包括新手引導、產品即文件(產品內建的智慧使用者手冊)、換膚(Dark 模式)、介面最佳化設計等,都是以使用者體驗為核心進行最佳化和打磨。

其中,新手引導主要解決使用者首次進入大資料平臺的操作問題,幫助使用者以輕量化的形式,快速上手常用的功能按鍵,熟悉產品的介面操作使用。

產品即文件是內建的彈出式幫助中心,主要協助使用者解決當前頁面 / 功能模組的上手痛點,包括對於該模組的功能介紹,典型步驟介紹,常見問題等。該功能試圖排除使用者在使用中碰到的 80% 以上的問題,切實給客戶提供使用幫助。

Dark 模式是針對開發人員和大資料平臺使用者專門打造的護眼模式介面面板,基於原配色深度最佳化,符合開發者的使用和互動習慣,增加開發效率。

最後,隨著平臺已經擁有越來越多的試用和正式使用者,小剛提到,持續圍繞“客戶成功”這一核心理念來打造產品,是我們始終貫徹的。團隊堅持“使用者至上、開放共贏、坦誠清晰”,將整個團隊也打造成一個產品,給使用者帶來最好的體驗。作為一隻充滿活力,開源開放的大資料平臺團隊,希望未來能繼續和社群的小夥伴一起把 DataSphere Studio 打造的更友好易用。

5王和平:使用者需要一站式互動體驗的開源資料分析工具

作為 DataSphere Studio 核心開發 ,王和平現場分享了《WeDataSphere 資料分析工場的建設和開源思路》。

他首先介紹了開源資料分析工具的選型思路。在構建資料分析時,使用者面臨的痛點有哪些?王和平表示,一是資料從哪來、資料安全怎麼保證,二是資料怎麼分析,怎樣進行模型訓練,三是資料質量怎麼把控,四是分析出的結果如何彙報,五是資料排程怎麼做。最後,這麼多工具,如何給使用者帶來一站式的互動體驗。

對於使用者面臨的挑戰,業界都有相應的工具去解決問題,比如資料分析工具執行互動式分析和模型訓練以及任務排程,還有資料交換工具、資料治理工具等。

目前,業界有很多開源的資料交換工具,例如 DATAX、DataX Web、Dbus 和 Exchangis。在資料分析工具上,業界也有 Apache Zeppelin、Scriptis 和 Hue。同樣,業界的開源資料治理工具有 pydqc、Apache Atlas、Deequ、Data Hub、GriFFin 和 Qualitis。開源排程工具,業界有 Dolphin Scheduler、XXL、Apache Airflow 和 Schedulis。

雖然工具不少,但是對一個數據分析師來說,它可能並沒有真正解決問題。並且,問題還有缺乏標準規範,工程管理體系不統一,使用者許可權不統一,UI 不統一;應用孤島,資源物料不互通,執行時上下文不互通。此外,重複造輪子。

為解決這些問題,DataSphere Studio 誕生,它具備一站式、全連通、全流程、可插拔和強管控特點,可以覆蓋需求、設計、開發、測試到生產所有階段,一條工作流串通所有應用工具,上層新工具只需實現 AppConn 外掛,便可快速打通其他工具。並且,基於工作空間的多租戶隔離,實現以租戶為單位進行統一的許可權管控、成員管理和協同開發等。

王和平說:“DataSphere Studio 有一個 AppConn,它去做連線,整合其他優秀的開源產品或工具。如果其他開源工具希望整合進來,有三層規範:一層是 SSO 規範,二層是工程組織結構規範(角色規範、工程規範),三層是應用開發流程規範。“

6周可:資料治理的六大痛點

周可是微眾銀行大資料平臺工程師,他分享了《WeDataShpere 資料治理工場實踐之路》。

目前,企業在資料治理上遇到的痛點有:

- 一、主資料管理缺失。資料零散、碎片化,資料重複利用和共享存在障礙,存在冗餘資料,增加資料使用成本;缺乏全生命週期的主資料管理流程和工具。

- 二、資料資訊存在孤島。資料分散,形成資訊孤島,共享困難;無法清楚的知道企業裡面有哪些資料?無法知道資料的具體結構?儲存在什麼地方?資料的屬主是誰?

- 三、資料關係難追蹤。資料是從哪裡來的?資料之間有什麼關係?資料是如何在企業內的各系統間傳遞的?

- 四、資料質量不高。業務理解與實際開發脫節,資料質量問題突出;缺乏有效的方法和工具提升資料質量。

- 五、資料安全管控不全面。資料安全等級 / 敏感資料無法自動識別;資料安全風險無法及時發現;資料安全脫敏缺少有效的審計,無法確認資料是否合規使用。

- 六、資料標準不統一,不規範。資料多樣化,缺少統一標準,整合困難;資料裡面的同一個術語存在不同的解釋,理解困難。

針對這些問題,開源社群有三種解決方案:

第一種,Pull-based Architecture,特點是較少的元件依賴、一個團隊可以搞定,代表性的開源產品有 Amundsen、Metacat、WhereHows。

第二種,Push-based Architecture,特點是統一接入方式、可程式設計,Marquez 是代表性的開源產品。

第三種,Event-sourced Architecture,特點是元資料可實時更新、元資料模型是開放的,方便拓展。其典型開源產品有 Apache Atlas、DataHub、OpenMetadata。

在資料質量方面,開源社群也有一些解決方案,主要有 Apache Griffin、Great Expectations 和 AWS Deequ。

從個人角度,周可分享了開源產品選型思路。一方面是技術特性,它是否滿足場景需求、是否有完善的技術體系、技術產品的穩定性怎麼樣;另一方面,還需要考慮時間成本與人力成本、是否配置維護團隊、新 feature 的開發模式。因此,某種意義上,需要做取捨。

回到 WeDataSphere,周可闡述了 WeDataSphere 在這方面的實踐。

目前,隨著網際網路技術的發展,各大金融機構積累了海量豐富的資料,對資料的管理和應用能力已經成為其核心競爭力之一。同時,大資料的發展帶來了企業對個人隱私資訊的過度採集和使用的問題。並且,監管部門也對金融資料治理提出了更高的要求。現在,加強資料治理不僅是銀行自身發展的需要,也是行業政策規範的重點。

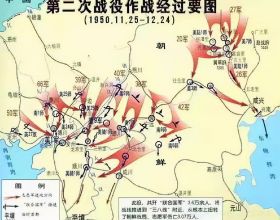

據悉,WeDataSphere 在資料治理上經過三個階段。

第一階段,平臺化。基於 WeDataSphere 大資料平臺,提升資料處理能力和應用效率。

第二階段,工具化。Data Governance Studio 實現資料管理線上化,並推進安全、質量、成本管控,管好資料。

第三階段,資產化。資料中臺、自動化取數服務。同時,促進資料應用,積累沉澱有價值的資料,實現資料資產化。

周可指出,治理基線在於不僅完善資料治理制度,明確資料授權管理及資料認責、資料分級體系,保護使用者隱私,而且規範資料架構,明確資料生命週期管理要求,有力支撐資料應用。

具體說來,資料治理工場 (Data Governance Studio) 要解決資料標準、資料字典、資料訪問控制、資料脫敏、資料血緣、資料質量六大問題,為多資料來源提供端到端資料治理能力。那麼,其基礎是建立資料目錄,指引資料的獲取、訪問和使用,輔助資料的有效利用,工具化落地資料管理規範。資料目錄可以解決資料在哪裡、資料去何處、資料誰在管和資料誰要用的問題。

為了構建好統一的資料目錄,內部要先建設元資料中介軟體,從全域性視角管理資料狀況。有了元資料目錄,就可以形成自動化審批流程,從而在運維裡實現自動化處理。有了資料目錄,可以實現資料授權統一管理,確保資料合規使用,有跡可循。

7易小華:WeDataShpere 在薩摩耶雲的應用

易小華是薩摩耶雲資料業務部總監,他分享了《WeDataShpere 在薩摩耶雲的應用》。

薩摩耶雲作為中國領先的獨立雲服務科技解決方案供應商,以人工智慧、大資料、移動網際網路和雲計算等核心技術能力為支援,透過深度應用 AI 決策,自主研發一系列 SaaS 產品組合及數智薩摩耶雲平臺,為各行各業的客戶提供端到端雲原生科技解決方案,包括:金融雲解決方案、產業雲解決方案、信用雲解決方案。

對薩摩耶雲來說,使用 WeDataShpere 之前,流程是業務部門向大資料團隊提需求,大資料團隊評估需求,然後是排期開發,大資料團隊交付成果,最後業務部門驗收。當時,資料團隊負責公司十幾個部門資料分析類需求,但團隊規模有限,除了資料類需求,他們還要進行大資料平臺的高可用維護、資料倉庫迭代開發維護等。往往存在一定的業務開發類需求需要排隊等待排期,與業務要求的快速上線相違背。這是資料團隊人力資源上的挑戰。

其次,薩摩耶雲總部位於深圳,分別在上海、長沙等城市設有職場,這讓面對面溝通存在一定困難,這也是團隊在溝通方面遇到的挑戰。

此外,大資料元件眾多,這導致形成了大量資料應用孤島,計算和儲存資源使用也不合理。

經過調研後,薩摩耶雲最終選擇 WeDataSphere。易小華說:“我們也看過其他的同類產品,不是付費,就是功能不完善,社群不活躍,以及國內使用者少,開源版本問題較多。”

為什麼選擇 WeDataShpere?原因主要有五點:

- 第一,WeDataSphere 提供原始碼,社群非常活躍,響應速度很快;

- 第二,它可以提供本地化部署,能滿足資料安全合規需求;

- 第三,WeDataSphere 能進行定製化開發和功能擴充套件;

- 第四,它能解決業務資料的開發痛點;

- 第五,WeDataSphere 能解決業務自主上線排程的痛點。

除此之外,WeDataSphere 在國內使用者較多,認可度較高;提供中文文件,還有微信群線上服務。同時,它用於微眾銀行內部,在不斷迭代。

2020 年 5 月,薩摩耶雲正式上線 WeDataSphere,包括視覺化、質量監控系統、計算系統、工作流系統和開發系統以及排程。同時,讓 WeDataSphere 0.9 版本分別適配內部使用的 CDH 5.14.4 和 CDH 6.3.2。

易小華表示,在使用開源版本過程中,他們發現很多 bug,各元件累計修復了 100+bug。並且,他們還修改了介面風格、圖示和文字描述,方便業務人員使用,從而更適合薩摩耶雲。

據易小華介紹,業務主要用到資料開發、資料工作流、資料排程和報表視覺化等功能,提高資料開發效率 400%+。

薩摩耶雲還與微眾銀行、天翼雲等聯合研發基於 Linkis 1.0 版本的實時開發元件 Streamis,其中,微眾銀行負責專案整體協調與把控,微眾銀行與 Boss 直聘負責 StreamPlugin 和 Stream WorkFlow 模組,天翼雲則負責 Stream JobManager 前端,Stream JobManager 後端由仙翁科技負責,薩摩耶雲則負責 Stream Datasource 模組。五方利用騰訊會議、企業微信和微信群每週開一次週會,同步進度,共同解決問題。比如,在開發 streamis-datasource-transfer 模組對接 linkis 資料來源時,缺少 linkis-datasource 模組,無法推進開發測試,後經微眾側協調,與天翼雲團隊多方共同推進,解決 streamis 依賴 linkis-datasource 問題。

從 2020 年 5 月上線到現在,WeDataSphere 在薩摩耶雲十幾個部門得到應用,覆蓋使用者超 300 人,涵蓋風控部門、營銷獲客部門和研發部門以及職能部門。

在易小華看來,雖然薩摩耶雲使用 WeDataSphere 的時間不長,但是團隊技能得到很大提升。以前,他們團隊人員主要做業務指令碼的開發,透過引入 WeDataSphere,提升了團隊人員的 Java 應用開發能力。同時,團隊具備一戰式資料應用開發、整合和治理平臺的建設能力,提升了實時計算平臺建設能力,比如 Prophecis 二次開發能力。

他說:“向優秀團隊學習架構設計、溝通、編碼、問題定位等,這進一步提升了我們團隊成員的技能。同時,積極參與開源社群,提高了團隊影響力和公司口碑。”

在業務層面,透過使用 WeDataSphere,藉助開源社群,幫助業務提升資料開發和模型開發效率,降低了業務成本。實時資料使用能力提升,“以前,最快的是 10 分鐘才能使用資料,現在基本達到秒級”,幫助業務更快響應。

“我們做業務資料中臺和 AI 中臺,WeDataSphere 是我們中臺重要的技術元件。“他補充道。

8吳梓煜:在 WeDataSphere 中構建機器學習工場 Prophecis Studio

作為當天活動的最後一位分享嘉賓,微眾銀行大資料平臺工程師吳梓煜分享了《在 WeDataSphere 中構建機器學習工場 Prophecis Studio 之旅》。

吳梓煜指出,近年來,隨著企業數字化轉型,金融、零售等行業積累了大量的業務資料。如何從資料中發現價值,輔助業務進行決策,這是各行各業都在探索的。在技術層面,高效能計算、智慧化演算法等技術的快速發展,也為企業從海量資料中低成本地發現數據價值提供了技術可行性。但是,在機器學習應用實際落地過程中,企業依然面臨一系列挑戰,包括資料接入難、應用碎片化、工程化複雜、模型部署複雜。

而 MLOps 是一種機器學習工程文化和手段,旨在統一機器學習系統開發 (Dev) 和機器學習系統運營 (Ops)。對企業來說,MLOps 實施意味著將在機器學習系統構建流程的所有步驟(包括整合、測試、釋出、部署和基礎架構管理)中實現自動化和監控。

目前,業界已經有開源的 MLOps 方案。吳梓煜介紹了三種主流的開源 MLOps 方案。第一種是 Kubeflow。它是一個基於 Kubernetes 構建的端到端生產級別機器學習平臺,基於雲原生的方案,覆蓋了機器學習從模型訓練、模型開發、模型部署等整個機器生命週期。其主要包括 Notebooks、Pipeline、AutoML、Serving、Arena 等元件。

第二種方案是 MLFlow,它是一款開源端到端機器學習生命週期管理工具,基於 Python 開發,輕量級方案,專注於解決 ML 開發中的 Tracking、工程管理、模型管理與部署等痛點,主要包含 Tracking、Projects、Models 等模組。

第三種方案是天樞人工智慧開源平臺,國產開源機器學習平臺,提供了包括資料處理、模型開發、模型訓練和模型管理等功能,方便使用者一站式構建 AI 演算法,底層基於 kubernetes,工作鏈較完善。

對此,WeDataSphere 提出 Prophecis Studio 機器學習工場,它是一站式機器學習平臺,主要包含 MLLabis、Machine Learning Flow、Model Factory、Application Factory 等模組。

據悉,Prophecis Studio 集資料匯入、模型開發、分散式模型訓練、模型部署等功能於一體,基於 Kubernetes 提供計算叢集的多租戶管理能力,為使用者提供機器學習應用開發的一站式體驗。

它致力於打通 MLOps 與 WeDataSphere 資料元件的結合,幫助使用者更快、更便捷、更智慧的挖掘和提升資料價值。

具體實踐中,第一個模組是機器學習開發環境,依託 Notebook Controller 管理 Notebook,同時,微眾開發了 Notebook Server,各個租戶的資源透過名稱空間隔離,Controller 將 Notebook 建立到對應租戶的名稱空間中。

第二個模組是機器學習分散式建模服務,主要是打通機器學習,把資料拉取、機器學習模型訓練、模型儲存、模型版本管理和映象構建以及模型部署全部打通,集合在一個模組裡。

第三個模組是機器學習模型工廠。據悉,模型工廠基於開源模型部署工具 Seldon Core 進行構建,提供機器學習模型管理、模型部署測試、模型映象打包、模型報告等功能,“我們對其做了定製和拓展”。

最後是機器學習應用工廠。吳梓煜介紹,Prophecis AF 是基於青雲開源的 KubeSphere 進行構建的機器學習應用工廠,Kubersphere 是一款集分散式、多租戶、多叢集、企業級能力的開源容器平臺。首先是監控和告警,吳梓煜表示,把它與公司內部 CMDB 系統和 IMS 系統打通,支援容器例項自動關聯內部應用資訊。其次,是資源管理,支援限制 Namespace GPU 資源配額。第三是持久化儲存,對接內部的共享儲存和 MySQL。

9寫在最後

因為開源,大家相識;因為 WeDataSphere,大家相聚。無論是開源大咖,還是 WeDataSphere 貢獻者和維護者,亦或是廣大社群參與者和開源愛好者,大家因熱愛技術,踐行開源之道,匯聚於此。