雲計算的靈活、安全與超算的極致效能,能否完美融合到一起?

對於很多企業使用者來說,由於技術架構方面的壁壘,長期以來,雲和超級計算兩種服務往往只能二選一,不能兼得。但近日,NVIDIA打破了這一說法。

NVIDIA網路事業部宋慶春表示:“透過NVIDIA雲原生超級計算(Cloud Native Supercomputing)技術,可以讓資料中心擁有了超算技術的高效能,同時把雲資料中心的靈活性和安全性帶進了超算平臺。”

NVIDIA網路事業部宋慶春

那麼,NVIDIA如何將超算中心與雲更好的結合在一起的呢?

會計算的網路,讓資料在哪計算就在那

如何把各種雲原生的裝置高效的連線起來,是讓超級算力走入千萬資料中心首要解決的挑戰。

NVIDIA提供了一個嶄新的解決思路:“資料在哪,計算就在那”。

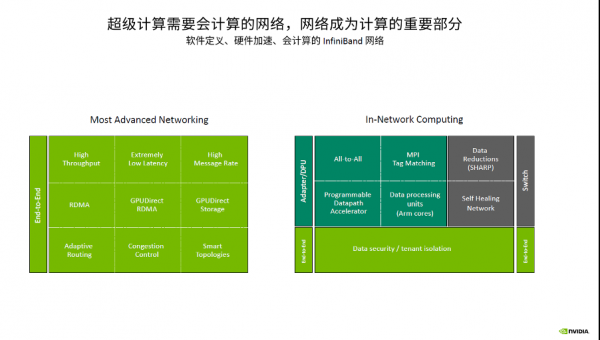

要實現這一解題思路,就需要藉助InfiniBand網路來實現。InfiniBand是會計算的網路,不管是在InfiniBand的網絡卡上、DPU上還是交換機上,都賦予更強勁的針對不同業務的引擎,這樣可以把不同的業務模型和通訊模型的計算放到卡上或者交換機上。

同時,InfiniBand網路可以很容易擴充套件到幾萬、幾十萬、上百萬的節點,可以採用不同的拓撲方案而不需要擔心拓撲中出現死鎖和網路風暴的問題,而且InfiniBand的動態路由可以讓網路的利用效率變得非常高。

並且InfiniBand網路可以即插即用。在InfiniBand網路中,你不用對交換機或網絡卡做任何特殊設定,不需要做IP設定等。可以說,InfiniBand網路天生就是非常適合雲原生架構的網路。

為了給企業客戶提供更好的應用InfiniBand網路支撐, NVIDIA推出了Quantum-2平臺,宋慶春表示:“Quantum-2是一個會計算的網路,真正契合了超級計算和雲原生對網路的需求,我們的目標是實現資料在哪裡,計算就在那裡。”

據介紹,NVIDIA Quantum-2平臺有三個非常重要的產品,分別是Quantum-2交換機、CONNECTX-7 InfiniBand網絡卡和基於BlueField-3的InfiniBand DPU,這三款產品擁有多租戶、效能隔離、擁塞控制、超高精度計時器等關鍵功能。

Quantum-2平臺不但能夠實現GPU Direct RDMA對AI業務至關重要的技術,增加了PDA (Programmable Datapath Acclerator)來對特定流量進行程式設計和加速,而且還對各種通訊模型進行了專門最佳化,提高了Allreduce 和 All-to-All等通訊時的通訊效率。

在微軟Azure公有云上的測試顯示,因為採用了InfiniBand動態路由和擁塞控制技術,實現了雲上效能的保障。同時,成功的將不同的業務之間進行效能隔離,讓一個業務不會影響到其他的業務,實現了真正的完全的Bare-metal的效能。

3U一體,給雲原生架構賦予無限算力資源

未來,隨著資料中心的發展,需要將計算移至接近資料的位置。

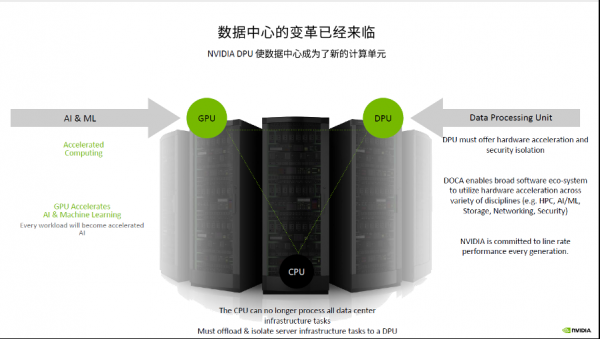

DPU的出現,為使用者提供了另外一個對業務效能進行最佳化的思路。透過更明細的分工來實現效率的提升、實現總體系統的成本最最佳化,DPU來執行通訊框架,CPU和GPU執行浮點計算,透過DPU加速HPC業務中的通訊,實現了計算和通訊的重疊。

DPU是集資料中心基礎架構於晶片的通用處理器。從DPU概念的提出者NVIDIA的現有技術發展趨勢來看,未來的技術發展趨勢將會是高度整合化的片上資料中心的模式(Data Center Infrastructure on a chip),即一個GPU、CPU、DPU共存的時代。

NVIDIA佈局的資料中心從核心到邊緣(Edge)都採用了統一的一個計算架構——CPU、GPU、DPU,如圖所示,形成了“3U”一體架構。3U一體的統一計算單元架構將會讓管理程式、排程程式都會變得非常容易。

宋慶春解釋說,在這種新的3U一體的資料中心架構之下,將傳統Infrastructure的操作都放到了BlueField DPU上,由DPU執行通訊框架、儲存框架、安全框架和業務隔離等,將Host裡面的CPU和GPU資源統統釋放給應用,透過這一架構可以讓業務效能得到更優的發揮,甚至比在Bare-metal狀況下它的效能還會有更好的提升。

比如iAlltoall是在HPC應用、AI做推薦時的經常會用到的通訊模型。透過用DPU和CPU實現計算和通訊的重疊,讓iAlltoall效能得到44%的提升。iAllgather是做大規模模型訓練時用到的一個通訊模型,透過DPU和CPU計算通訊的Overlap,能夠讓iAllgather效能提升36%。

宋慶春表示,DPU的出現彌補了資料中心Infrastructure加速能力不足的問題,讓資料中心成為新的計算單元,給資料中心算力最佳化提供了全新的資源。因此,3U一體已經成為資料中心的一個必然的架構,而且,在這樣一個必然的架構中透過DPU、CPU和GPU的分工合作實現一個數據中心中最優的效能。

雲原生軟體定義安全為零信任提供安全保障

隨著資料的傳輸越來越快,越來越複雜,傳統的方式或者工具已經沒有辦法滿足現在資料中心的安全需求。

在傳統的資料中心,發現一個漏洞,可能需要超半年的時間,而要修復這個漏洞需要超過兩個多月的時間,這個對於基於零信任(Zero-trust)的前提下是絕對不可接受的,這說明整個資料中心是非常不安全的。

如何解決這個問題?

在今年秋季GTC上,NVIDIA釋出了 DOCA 1.2。DOCA 1.2是專門面向零信任(Zero-trust)的安全框架,提供了Load Balancers、DPI、 IPS、IDS、下一代防火牆,設計安全軟體的使用者或者安全軟體的供應商,可以直接透過DOCA API呼叫在GPU裡的硬體加速引擎,讓資料中心更安全。

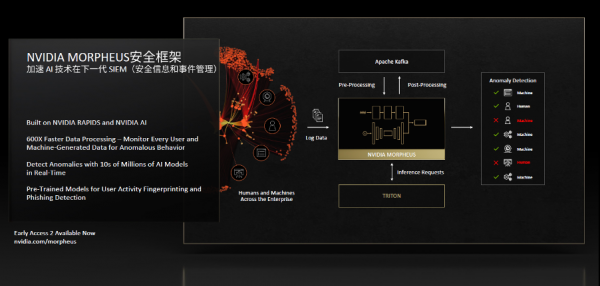

黃仁勳專門針對Morpheus安全框架進行了講解。他表示,Morpheus是對未來的資料中心提供了一個更新的思路,透過Morpheus可以利用AI的方式進行安全防禦,而不必根據傳統的安全顧問對於惡意攻擊或者是其他安全特定模型的識別來進行有限的安全防禦,利用AI深度學習的方式可以讓資料中心得到全方的保護。

透過Morpheus、透過AI對於安全的保障,可以實現600倍快的資料處理的速度,Morpheus可以透過DPU抓取到的資料特徵生成百萬、千萬級別的模型數量,然後在資料中心裡面去進行匹配,實現資料中心的異常情況全面監控。

而且用Morpheus時,不用去定義這個行為是惡意還是善意的,只看你這個行為是正常的還是異常的,只要是異常行為這時候就會去監控和識別,判斷它到底是一個合理還是不合理的行為。

宋慶春表示,在跟Morpheus的整合上,不管是NVIDIA 的乙太網還是InfiniBand網路都實現了和Morpheus的整合,特別在InfiniBand網路的UFM Cyber-AI和Morpheus的聯合,不但實現了對網路中異常行為的識別處理,同時也實現了對於未來網路中有可能出現的異常情況進行推測,做一些預防性的保護。

NVIDIA 讓超級算力飛入“尋常百姓家”

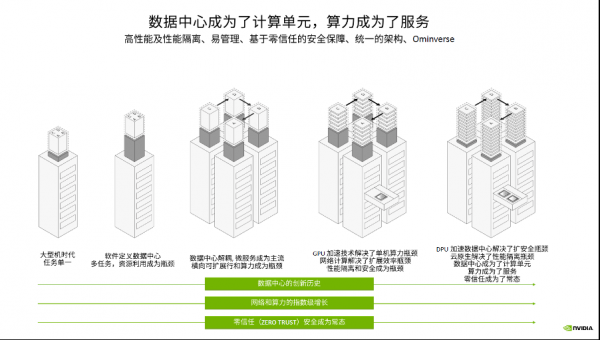

隨著Transformers模型的出現,現在的資料中心對算力的需求變得越來越大,要執行大的模型就需要更多的GPU,資料並行和模型並行在未來工作訓練中同時使用將成為一個趨勢。如何既保持很高的算力,又保證業務的安全性,雲原生技術對這樣一個趨勢是必不可少的。

同時從Inference角度看, Inference依然需要很高的算力。因為隨著現在模型越來越大,這時候需要跨伺服器、跨Node做Inference。為了讓Inference效率更高,Inference走向分散式也慢慢出現了,這也需要更高算力和更高的通訊能力。

隨著training和Inference技術的發展,AI將成為資料中心裡最主流的應用之一,現在資料中心逐漸成為了計算單元,算力成為了服務。

超級計算中心要像一般的資料中心一樣為大量的使用者提供服務,就需要解決資料中心提供商所要解決的問題,如在零信任的環境下為租戶提供服務、同時對大量的使用者提供服務、確保每個租戶之間的安全隔離等。

雲原生超級計算(Cloud Native Supercomputing)技術的出現,為解決超算中心面臨的挑戰提供瞭解決方案。透過NVIDIA GPU可以解決超算中心的算力瓶頸,透過InfiniBand網路可以解決擴充套件效率的瓶頸,透過NVIDIA DPU可以解決效能隔離和資料安全的瓶頸。

未來,資料中心中CPU、GPU、DPU,3U一體缺一不可,這是資料中心成為計算單元的基礎,也是算力成為服務的基礎,真正讓超級算力飛入雲資料中心。