機器之心報道

編輯:張倩

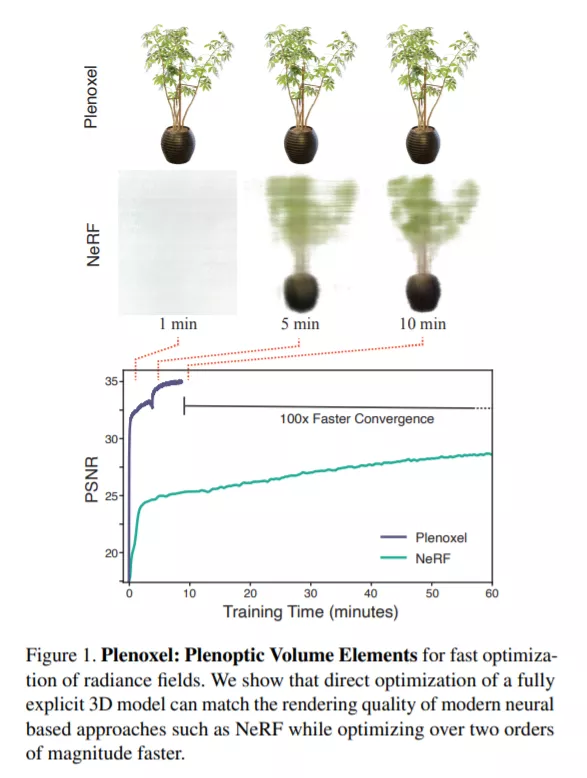

沒有了神經網路,輻射場(Radiance Fields)也能達到和神經輻射場(Neural Radiance Fields,NeRFs)相同的效果,但收斂速度快了 100 多倍。

2020 年,加州大學伯克利分校、谷歌、加州大學聖地亞哥分校的研究者提出了一種名為「NeRF」的 2D 影象轉 3D 模型,可以利用少數幾張靜態影象生成多視角的逼真 3D 影象。其改進版模型 NeRF-W (NeRF in the Wild)還可以適應充滿光線變化以及遮擋的戶外環境,分分鐘生成 3D 旅遊觀光大片。

NeRF 模型 demo。

NeRF-W 模型 demo。

然而,這些驚豔的效果是非常消耗算力的:每幀圖要渲染 30 秒,模型用單個 GPU 要訓練一天。因此,後續的多篇論文都在算力成本方面進行了改進,尤其是渲染方面。但是,模型的訓練成本並沒有顯著降低,使用單個 GPU 訓練仍然需要花費數小時,這成為限制其落地的一大瓶頸。

在一篇新論文中,來自加州大學伯克利分校的研究者瞄準了這一問題,提出了一種名為 Plenoxels 的新方法。這項新研究表明,即使沒有神經網路,從頭訓練一個輻射場(radiance field)也能達到 NeRF 的生成質量,而且最佳化速度提升了兩個數量級。

- 論文連結:https://arxiv.org/pdf/2112.05131.pdf

- 專案主頁:https://alexyu.net/plenoxels/

- 程式碼連結:https://github.com/sxyu/svox2

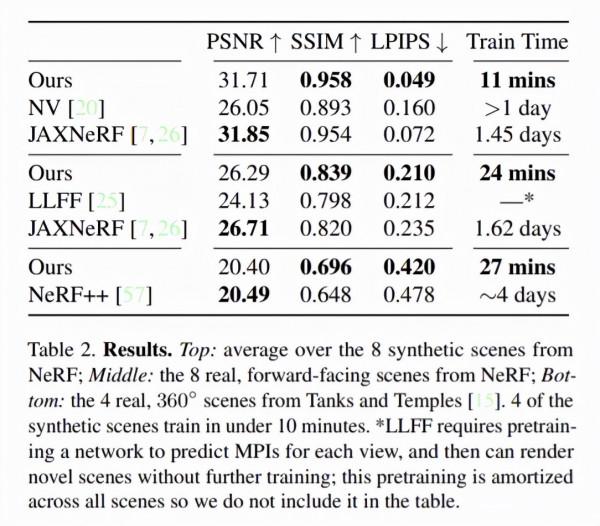

他們提供了一個定製的 CUDA 實現,利用模型的簡單性來達到可觀的加速。在有界場景中,Plenoxels 在單個 Titan RTX GPU 上的典型最佳化時間是 11 分鐘,NeRF 大約是一天,前者實現了 100 多倍的加速;在無界場景中,Plenoxels 的最佳化時間大約為 27 分鐘,NeRF++ 大約是四天,前者實現了 200 多倍的加速。雖然 Plenoxels 的實現沒有針對快速渲染進行最佳化,但它能以 15 幀 / 秒的互動速率渲染新視點。如果想要更快的渲染速度,最佳化後的 Plenoxel 模型可以被轉換為 PlenOctree(本文作者 Alex Yu 等在一篇 ICCV 2021 論文中提出的新方法:https://alexyu.net/plenoctrees/)。

具體來說,研究者提出了一個顯式的體素表示方法,該方法基於一個不含任何神經網路的 view-dependent 稀疏體素網格。新模型可以渲染逼真的新視點,並利用訓練檢視上的可微渲染損失和 variation regularizer 對校準的 2D 照片進行端到端最佳化。

他們把該模型稱為 Plenoxel(plenoptic volume elements),因為它由稀疏體素網格組成,每個體素網格儲存不透明度和球諧係數資訊。這些係數被 interpolated,以在空間中連續建模完整的全光函式。為了在單個 GPU 上實現高解析度,研究者修剪了空體素,並遵循從粗到細的最佳化策略。雖然核心模型是一個有界體素網格,但他們可以透過兩種方法來建模無界場景:1)使用標準化裝置座標(用於 forward-facing 場景);用多球體影象圍繞網格來編碼背景(用於 360° 場景)。

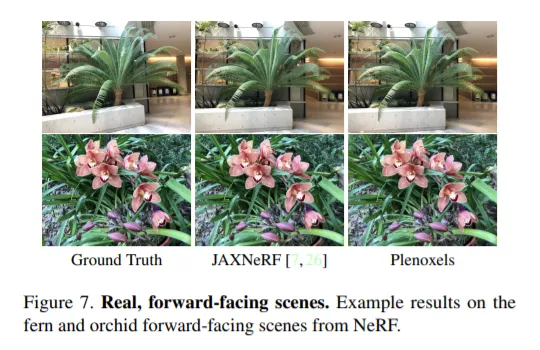

Plenoxel 在 forward-facing 場景中的效果。

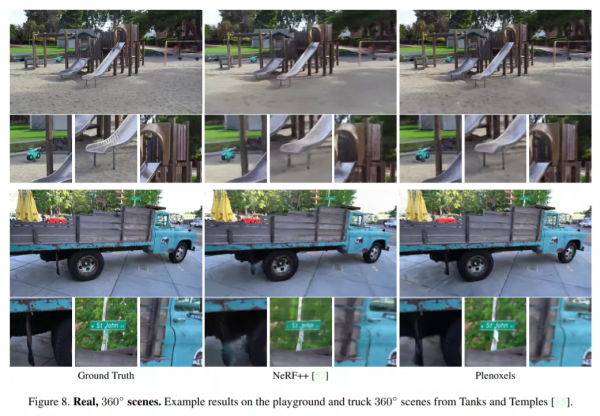

Plenoxel 在 360° 場景中的效果。

該方法表明,我們可以使用標準工具從反問題中進行逼真體素重建,包括資料表示、forward 模型、正則化函式和最佳化器。這些元件中的每一個都可以非常簡單,並且仍然可以實現 SOTA 結果。實驗結果表明,神經輻射場的關鍵要素不是神經網路,而是可微分的體素渲染器。

框架概覽

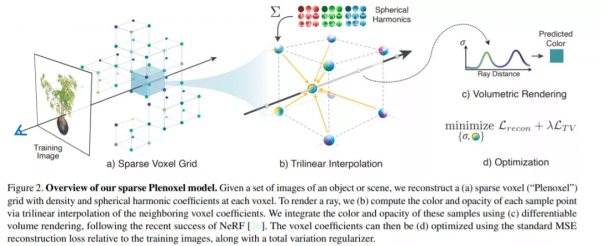

Plenoxel 是一個稀疏體素網格,其中每個被佔用的體素角儲存一個標量不透明度σ和每個顏色通道的球諧係數向量。作者將這種表徵稱為 Plenoxel。任意位置和觀察方向上的不透明度和顏色是透過對儲存在相鄰體素上的值進行三線性插值並在適當的觀察方向上評估球諧係數來確定的。給定一組校準過的影象,直接使用 training ray 上的渲染損失來最佳化模型。模型的架構如下圖 2 所示。

上圖 2 是稀疏 Plenoxel 模型框架的概念圖。給定一組物體或場景的影象,研究者在每個體素處用密度和球諧係數重建一個:(a)稀疏體素(Plenoxel)網格。為了渲染光線,他們(b)透過鄰近體素係數的三線性插值計算每個樣本點的顏色和不透明度。他們還使用(c)可微體素渲染來整合這些樣本的顏色和不透明度。然後可以(d)使用相對於訓練影象的標準 MSE 重建損失以及總 variation regularizer 來最佳化體素係數。

實驗結果

研究者在合成的有界場景、真實的無界 forward-facing 場景以及真實的無界 360° 場景中展示了模型效果。他們將新模型的最佳化時間與之前的所有方法(包括實時渲染)進行了對比,發現新模型速度顯著提升。定量比較結果見表 2,視覺比較結果如圖 6、圖 7、圖 8 所示。

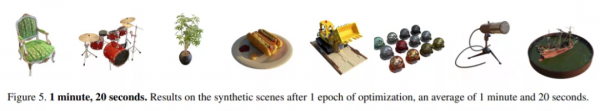

另外,新方法即使在最佳化的第一個 epoch 之後,也能獲得高質量結果,用時不到 1.5 分鐘,如圖 5 所示。