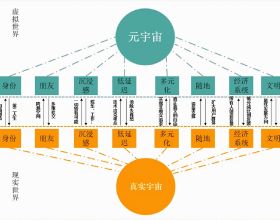

導讀:最近,元宇宙火了!

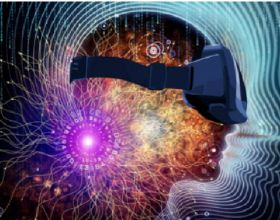

“元宇宙”是美國科幻小說家尼奧·斯蒂文森1992年在《雪崩》中提出的概念,書中設定現實世界中的人在網路世界中都有一個分身,這個由分身組成的世界就是“元宇宙”。如今,隨著虛擬現實技術的發展,元宇宙逐漸從科幻走入現實。

本文將介紹虛擬現實的核心概念、行業應用以及相關的開發技術。

作者:王寒 張義紅 王少笛

來源:華章科技

01 什麼是虛擬現實

我們通常所說的“虛擬現實”一詞其實包含了多個技術分支,如AR/VR/MR等。

AR是Augmented Reality的縮寫,通常被稱為增強現實。AR的定義很廣泛,技術種類眾多。目前主流的AR是指透過裝置識別和判斷(二維、三維、GPS、體感、面部等識別物)將虛擬資訊疊加在以識別物為基準的某個位置,並顯示在裝置螢幕上,從而實時互動虛擬資訊。

VR是Virtual Reality的縮寫,通常被稱為沉浸式虛擬現實。VR為使用者提供了完全沉浸式的體驗,使使用者有一種置身於真實世界的感覺,是一種高階的、理想化的虛擬現實系統。

除了我們通常瞭解的AR和VR這兩個名詞之外,行業內其實還有MR和XR的說法。MR是Mixed Reality的縮寫,即混合現實,指的是合併現實和虛擬世界而產生的新的視覺化環境。在新的視覺化環境裡,物理和數字物件共存,並實時互動。

XR是Extended Reality的縮寫,即擴充套件現實。實際上,XR是AR/VR/MR等各種形式的虛擬現實技術的總稱。它分為多個層次,包括從透過有限感測器輸入的虛擬世界到完全沉浸式的虛擬世界。

2014年,Facebook對Oculus的收購盤活了整個行業。2019年,Facebook推出的Oculus Quest讓無數人眼前一亮,可謂“當前VR一體機產品中的翹楚”。2020年9月,Facebook釋出Oculus Quest2,並宣佈在2021年全面停產Oculus Rift PCVR系列產品。

2015年,微軟釋出第一代HoloLens全息眼鏡,在單一機身中融合了CPU、GPU和全息處理器,並在2019年推出更為強大的HoloLens 2。

在2017年的WWDC上,蘋果推出了專門為打造增強現實體驗而開發的框架ARKit,以及面向AI的CoreML。同年,Google推出了和蘋果ARKit功能相似的ARCore。

2019年9月,華為在旗艦手機Mate 30 Pro的釋出會上重磅推出了自家的VR眼鏡產品,為業界所看好。

可以預見,未來的虛擬現實產品將不再區分AR/VR/MR,而是一種融合性的產品。與此同時,虛擬現實的實時掃描、環境感知和渲染技術將需要藉助人工智慧技術,特別是計算機視覺和深度學習的幫助。

虛擬現實技術自誕生以來應用於多個領域—從軍事到航空航天,從教育到娛樂遊戲,從醫療到旅遊,等等。從目前來看,融合了5G/AI等技術的AR/VR裝置有望取代智慧手機的計算模組。

02 虛擬現實的技術基礎

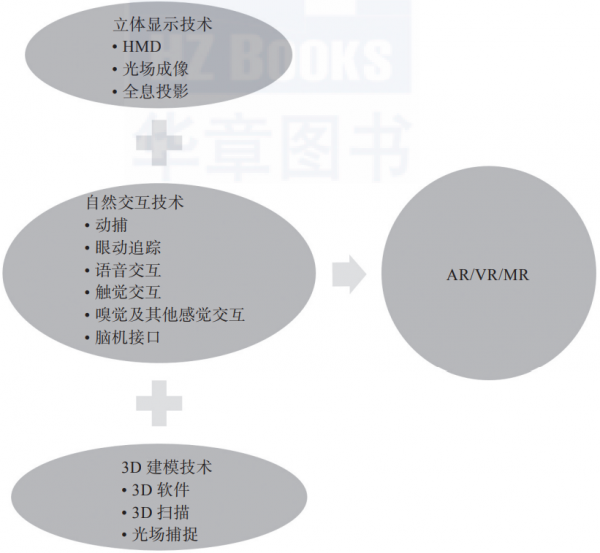

虛擬現實是一種綜合性技術,由三大類技術組成,分別是立體顯示技術、3D建模技術和自然互動技術,如圖1-1所示。

本節將向大家簡單介紹以上3種技術的相關知識。

1. 立體顯示技術

立體顯示技術以人眼的立體視覺原理為依據。因此,研究人眼的立體視覺機制、掌握立體視覺的規律,對設計立體顯示系統是十分必要的。如果想在虛擬世界看到立體的效果,就需要知道人眼立體視覺產生的原理,然後再用一定的技術透過顯示裝置還原立體效果。

1)HMD技術

HMD(頭戴顯示)技術的基本原理是讓影像透過稜鏡反射之後,進入人的雙眼在視網膜上成像,營造出在超短距離內看超大螢幕的效果,而且具備足夠高的解析度。

頭戴顯示器通常擁有兩個顯示器,而兩個顯示器由計算機分別驅動向兩隻眼睛提供不同的影象,再透過人的大腦將兩個影象融合以獲得深度感知,從而產生立體的影象。

主流的沉浸式虛擬現實頭戴裝置,包括Oculus Rift、Oculus Quest、HTC Vive、Sony Playstation VR、3Glasses、Pico VR等,大多基於雙顯示屏技術。

那麼,微軟的黑科技產品HoloLens又是基於什麼原理呢?

先來看看HoloLens,它相當於Google Glass的升級版,可以看作是Google Glass和Kinect的合體產品。它內建了獨立的計算單元,透過處理從攝像頭所捕捉的各種資訊,藉助自創的HPU(全息處理晶片),透過層疊的彩色鏡片建立虛擬物體影像,再借助類似Kinect的體感技術,讓使用者從一定角度和虛擬物體進行互動。

依靠HPU和層疊的彩色鏡片,HoloLens可以讓使用者感覺到這些全息影象直接投射到了現實場景中的物體上。當用戶移動時,HoloLens藉助廣泛應用於機器人和無人駕駛汽車領域的SLAM(同步定位與建圖)技術來獲取環境資訊,並計算出玩家的位置,保證虛擬畫面的穩定。

2)全息投影技術

全息投影技術可以分為投射全息投影和反射全息投影兩種,是全息攝影技術的逆向展示。和傳統立體顯示技術利用雙眼視差的原理不同,全息投影技術可以透過將光線投射在空氣或者特殊的介質(如玻璃、全息膜)上呈現3D影像。人們可以從任何角度觀看影像,得到與現實世界中完全相同的視覺效果。

目前,我們看到的各類表演中所使用的全息投影技術都需要用到全息膜或玻璃等特殊的介質,需要提前在舞臺上做各種精密的光學佈置。這類表演的效果絢麗無比,但成本高昂、操作複雜,需要操作人員進行專業訓練。

3)光場成像技術

神秘的Magic Leap採用了所謂的“光場成像”技術。從某種意義上來說,該技術可以算作“準全息投影”技術。其原理是用螺旋狀振動的光纖形成影象,並直接讓光線從光纖彈射到人的視網膜上。

簡單來說,就是用光纖向視網膜直接投射整個數字光場(Digital Lightfield),產生所謂的“電影級現實”(Cinematic Reality)。

2. 3D建模技術

為了打造完美的虛擬現實體驗,我們需要從零開始構建虛擬世界,或將現實生活中的場景轉化成虛擬世界的一部分。那麼,這種虛擬世界如何構建呢?

目前來說,3D建模主要透過3D軟體、3D掃描和光場捕捉等方式來實現。

1)3D軟體建模

簡單來說,3D軟體建模就是透過各種三維設計軟體在虛擬的三維空間構建出具有三維資料的模型。這個模型又被稱作3D模型,可以透過3D渲染技術以二維的平面圖像呈現出來,或是透過計算機模擬,或是透過3D列印裝置構建。

除了遊戲之外,3D軟體建模還廣泛應用在影視、動畫、建築和工業產品的設計中。目前在遊戲、影視和動畫領域,最常用的3D設計軟體包括3Ds Max、Maya、zBrush、Cinema4D、Blender、Softimage等,而在建築和工業產品設計中,最常用的是AutoCAD、Rhino等。

單純使用3D軟體建模的問題在於,一方面高度依賴建模師個人的技能熟練度,另一方面對於現實世界的很多場景、物體和人物無法做到精準還原,很容易進入“恐怖谷”的瓶頸之中。

2)3D掃描建模

在構建虛擬現實世界時,除了使用常規的3D建模技術和實景拍攝技術之外,我們還可以使用3D掃描技術將真實環境、人物和物體進行快速建模,將實物的立體資訊轉化成計算機可以直接處理的數字模型。

3D掃描器是利用3D掃描技術將真實世界的物體或環境快速建立數字模型的工具。3D掃描器有多種型別,通常可以分為兩大類:接觸式3D掃描器和非接觸式3D掃描器。

3)光場捕捉建模

光場捕捉建模技術最早應用於Ren Ng創辦的Lytro,它透過在單個感測器前放置微透鏡陣列實現多個視角下畫面的採集,但這種方案會導致解析度大大降低。

近幾年,還有一種方案被Facebook Reality Labs、微軟MR工作室、上海疊境、深圳普羅米修斯和微美全息等公司採用,即使用上百個相機的多相機陣列和深度相機組成內環抓拍系統,並對物件進行全方位拍攝,透過高速處理的AI演算法和動態融合的系統實時合成物件的立體模型。

需要注意的是,使用3D掃描和光場捕捉建模技術所獲取的3D模型與動作動畫仍然需要使用主流的3D設計軟體進行後期處理。使用3D掃描或光場捕捉技術可以大大提高3D建模效率,減少前期工作量,並實現更為真實的效果。

3. 自然互動技術

隨著VR/AR時代的來臨,傳統的互動方式已經遠遠不能滿足人們的需求。因此,模仿人類本能的自然互動技術成為虛擬現實技術的重要基礎。虛擬現實要實現完美的沉浸感,需要用到哪些自然互動技術呢?

1)動捕

為了實現和虛擬現實世界中場景和人物的自然互動,我們需要捕捉人體的基本動作,包括手勢、表情和身體運動等。

實現手勢識別、表情、動捕的主流技術分為兩大類,一類是光學動捕,一類是非光學動捕。光學動捕技術包括主動光學動捕和被動光學動捕,而非光學動捕技術包括慣性動捕、機械動捕、電磁動捕和超聲波動捕。

2)眼動追蹤

眼動追蹤的原理其實很簡單,就是使用攝像頭捕捉人眼或臉部的影象,然後用演算法實現人臉和人眼的檢測、定位與跟蹤,從而估算使用者的視線變化。目前,我們主要使用光譜成像和紅外光譜成像兩種影象處理方法,前一種需要捕捉虹膜和鞏膜之間的輪廓,後一種則需要跟蹤瞳孔的輪廓。

3)語音互動

在和現實世界互動的時候,除了眼神、表情和動作互動外,還有語音互動。一個完整的語音互動系統包括對語音的識別和對語義的理解兩大部分,不過人們通常用“語音識別”一詞來概括。語音識別包含了特徵提取、模式匹配和模型訓練三方面的技術,涉及的領域包括訊號處理、模式識別、聲學、聽覺心理學、人工智慧等。

4)觸覺互動

觸覺互動技術又被稱作所謂的“力反饋”技術,在遊戲行業和虛擬訓練中一直有相關的應用。具體來說,它會透過向用戶施加某種力、震動等,讓使用者產生更加真實的沉浸感。觸覺互動技術可實現在虛擬世界中創造和控制虛擬的物體,比如遠端操控機械或機器人,甚至模擬訓練外科實習生進行手術。

5)嗅覺及其他感覺互動技術

在虛擬現實的研究中,對視覺和聽覺互動的研究一直佔據主流地位,對其他感覺互動技術的研究則相對被忽視。目前,已經有一些研究機構和創業團隊在著手解決這些問題。

6)腦機介面

腦機介面(Brain Computer Interface,BCI)就是大腦和計算機直接進行互動,有時候又被稱為意識–機器互動、神經直連。腦機介面是人或者動物的大腦和外部裝置建立直接連線的通道,分為單向腦機介面與雙向腦機介面。

- 單向腦機介面只允許單向的資訊通訊,比如只允許計算機接收大腦傳來的命令,或者只允許計算機向大腦傳送訊號(比如重建影像)。

- 雙向腦機介面則允許大腦和外部計算機裝置實現雙向的資訊交換,比如Neurosky(神念科技)的Brainlink。它可以採集大腦產生的生物電訊號,並透過esense演算法獲取使用者的精神狀態引數(專注度、放鬆度)等,實現基於腦電波的人機互動,或是俗稱的“意念控制”。

Neuralink公司屬於侵入式技術的代表,其產品透過在大腦中植入微型電極和晶片,收集人腦1500個點產生的神經元訊號。Neuralink公司使用了一種被稱為“神經織網”的技術,該技術透過一種特製的“縫紉機”將只有頭髮絲1/10粗細的線植入大腦,這種線可以像人的神經一樣高速傳輸各種資料。

雖然植入式技術的難度更大,但在資訊的捕捉和傳遞方面更加精準、可靠,發展空間不可限量。按照馬斯克的想法,腦機介面裝置的短期目標是治療一些常見的腦部疾病,終極目標則是讓人類和人工智慧技術融合,實現人機互動。

關於作者:王寒,資深蘋果平臺開發者、國內較早的iOS與VR/AR應用開發者、騰訊課堂講師、知乎專欄“靈貓學程式設計”作者、蠻牛遊戲開發專欄作者。著有《Cocos2D權威指南》《虛擬現實:引領未來的人機互動革命》《Unity AR/VR開發:從新手到專家》等書。

張義紅,香港理工大學博士,東華大學資訊學院副院長、副研究員,主要研究方向為增強現實、影象處理與模式識別。

王少笛,魔琺科技技術負責人、虛擬數字人探索者、國內首批虛擬現實愛好者、知乎專欄“動作捕捉技術”作者。曾任職於賽隆空間科技,擔任產品設計與開發總負責人,主要面向市場主流裝置(HTC VIVE、Oculus、Hololens等)開發教育類相關應用。

本文摘編自《Unity AR/VR開發:實戰高手訓練營》,經出版方授權釋出。

推薦語:全面的Unity3D技能,讓小白讀者也能輕鬆上手AR/VR開發。