機器之心原創

撰文:吳昕

小冰全新數字孿生虛擬人的最大技術亮點在於其虛實難分的視覺效果,背後離不開小冰深度神經網路渲染技術。而且,這樣一個真正端到端實時線上系統,也是業內還從來沒出現過的。其產業意義在於,虛擬人自此不再停留在簡單的宣傳層面,而是落地成為一種工業化、商業化輸出,切實改變某個產業及其部署的具體場景。

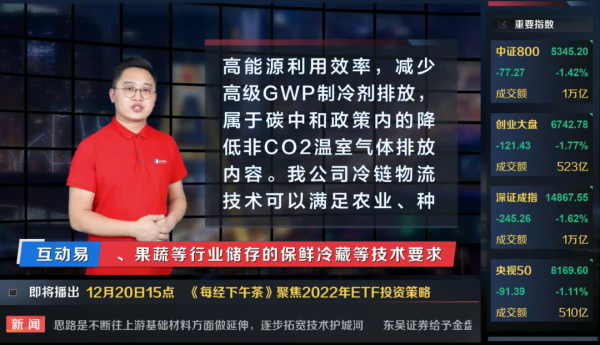

「節目 24 小時都在做,半夜也直播,你們得給主播多少加班費?」每日經濟新聞一億多的財經使用者中,終於有人按捺不住疑問,「到底哪些地方是 AI 做的?」

此時,距離兩位每經知名財經主播數字孿生虛擬人 N 小黑、N 小白上線直播已經過去 70 多天。上次,全民被「蒙」還是英偉達釋出會上閃現幾秒的虛擬「黃仁勳」。

事實上,螢幕上所有內容都是出自 AI 之手。除了 7×24 連續播報的主播,背景播放的影片,包括金融資訊,都是 AI 做的。

「這套東西在業內還從來沒出現過。」小冰公司營運長、人工智慧創造力實驗室負責人徐元春說。

一、何以虛實難辨?

N 小黑雙手自然擺放身前,播報內容不同,他的眼睛、嘴唇和口型也會隨之變化,眉毛甚至臉部肌肉也會微妙運動。

虛實難分的視覺效果,離不開小冰深度神經網路渲染技術(Xiaoice Neural Rendering, XNR)。與傳統計算機圖形技術不同,這種渲染技術透過資料驅動而非物理定律獲得渲染函式,其函式一般用深度神經網路透過學習構建。

它使得數字人的面容、表情、肢體動作等在內的整體自然度大幅度提升。尤其是整個嘴型的驅動,以及嘴部動作和整個眼部臉部肌肉的協同。

具體來說,小冰團隊首先需要訓練兩個專家模型。一個是在大資料上訓練語音專家模型,它能理解人類語音。

另一個是在目標主播資料上訓練嘴形專家模型,學習目標主播嘴形與表情以及語音之間的關係。

比如,主播說「我」、「我愛祖國」,與眼睛會有怎麼樣的聯動關係、與臉部肌肉有什麼聯動的關係。團隊會做一個模型去來學習訓練這個過程。

接下來,團隊還要訓練人臉渲染模型,輸入是語音,渲染出正確的人臉。該訓練過程受到之前兩個專家模型的監督,以保證渲染質量。

最後是驅動過程,輸入語音,形成完整的主播影片。

小冰數字孿生主播 N 小黑。

其實,「虛擬人」表現性一直是個很大的技術挑戰。人眼對錶情的識別能力強, 「虛擬人」一旦動起來就很容易被識破。

一些常見的市面技術打造出來的虛擬主播,形象通常比較呆板,肌肉、眼睛也不動,只適合播報一些快訊、天氣預報。

我們希望使用者使用這項技術時,不排斥,也不覺得不自然。「這在數字虛擬技術上是一個非常大的挑戰。」徐元春說。

當一些人士開始疑問哪些部分源自 AI 時,已經說明人們在過去一段時間已經不知不覺地接受了新技術。「這是一個非常好的 measurement,」在徐元春看來,也正是這個專案的標杆意義所在。

值得注意的是,小冰團隊採用的神經網路渲染技術,與今天風靡的 3D 建模技術路徑不同。

後者需要在每次製作內容的時候,在綠幕前進行動作捕捉,再進行模型繫結,然後形成生成影片,進行後期渲染。

這種生產模式其實和好萊塢電影的生產方式其實是一樣的,只不過標準可能會低一些、內容時長會短一些。

這種技術邏輯優勢在於只要願意砸錢,可以打造非常多樣的場景,但問題在於,生產成本會非常的高、製作週期也會比較長。而且,無法做到實時大量生產內容。這些因素也嚴重阻礙了該技術邏輯廣泛賦能 2B 行業。

相比之下,小冰全新數字孿生虛擬人技術的打造成本和週期都大為降低。

據徐元春介紹,專案的訓練資料來自 N 小黑(@N 小黑財經)和 N 小白(@每經小白基金),採集完一個人影片資料、處理好後,用小冰團隊的模型,大概一週時間就能訓練出一個比較高質量的虛擬數字人形象,然後驅動「他」完成播報,製作內容。

如果採用 3D 建模技術,僅建模就一個多月。這還不算後續流程所需時間。整個專案運作下來,幾個月的週期都還算快的。

二、首次實現採編播全流程自動化

市面上做很多虛擬人的技術,往往都停留在了一個離線的狀態或者叫半離線的狀態。

比如,在網上他有他的圖片,有他的海報,但其實你並不會看到他,那可能你會看到他的一段廣告的影片,但也就僅此而已。

某公司做了一個虛擬人,播報了一段東西,然後上線,賺取了一些流量。這種技術更像是一種宣傳,並沒有真正改變某個產業及其部署的場景。

而 7×24 小時持續播報,內容都是實時生成的 N 小黑們,正在改變今天內容生產和分發的方式:

只要輸入播報內容,系統會自動將文字資訊轉化為聲音,經過預訓練的模型,驅動虛擬人形象、表情,最終生成完整的直播影片推流,全過程不再需要人工參與。

N 小黑們不會因為主持人的生病或者其他原因缺席工作,導致內容生產斷掉。人類生產內容都會有瑕疵或都會有錯誤,AI 會完全按照原來既定文字內容去生產。

這樣一個真正端到端實時線上系統,也是業內還從來沒出現過的。徐元春說,他們不再是一個簡單的宣傳,而是一種工業化、商業化輸出。

事實上,透過小冰框架實現影片採編播全流程的無人化操作,也是源自幾年前的「腦洞」—— 有沒有可能以 AI 的方式,幫每日經濟新聞做成一個類似彭博資訊那樣的 24 小時財經電視節目?

當時,每日經濟新聞金融資訊均由小冰人工智慧技術自動生成,在中英文雙語資訊同步生成的同時,已實現秒級速度的自動化全平臺推送。每日經濟新聞也因此可以面向全球客戶和使用者提供金融資訊服務。

但小冰團隊希望可以走得更遠,做一些更具開創性技術,賦能這個行業,也因此一路披荊斬棘。

小冰已經可以實現各種上市企業公告秒級的形成摘要。為了實現虛擬播報,還需要其他資料。比如,怎麼將每日經濟新聞提供的資料埠和摘要技術結合到一起,然後,再和數字人的形象結合到一起?

螢幕上,數字主播不只是在播新聞,旁邊還有一個背景影片也在播出新聞,這也需要影片混合生成技術的支援。

你要讓這個節目可看,就不能只有兩個人,還得需要有別的影片出現,徐元春舉例說,這些影片也要被用 AI 生產出來。當然,難度沒有數字主播這麼高,但也是一項技術挑戰。

最後把所有技術再捆綁和包裝起來實時推送到直播平臺,也是一個巨大的工程挑戰。

對於小冰數字孿生虛擬人技術的先進性和競爭力,團隊很有自信。

數字虛擬人市場上,有的人會做形象,有的人可能自己會做 NLP,提供一些創作的工具,但是,因為其只是整個鏈條中一個環節,其實很難產生實際的效果。

人工智慧的內容生成最大的特點是穩定輸出高併發,整個內容生成流水線一旦啟動,如果任何一個環節掉鏈子,整個內容生成就都卡在那個環節上了。

從技術的完備性角度來講,我們是最完整的,從自然語言處理、計算機語音到計算機視覺再到人工智慧內容生成,有一個完整的技術棧,徐元春說。

而且,積累的大量端到端 know how 經驗,更有利於將虛擬人帶到現實世界,而不僅僅停留在宣傳層面。

真要做這件事情的時候,就會發現,端到端地實際上解決很多問題。換句話說,已經發現的問題遠遠少於那些你都不知道的問題,徐元春說。

事實上,每日經濟新聞這個專案做的時間是比較長的,主要時間不是花在技術,而是場景打造、探索 know-how 上,最終的打造和磨合也花了不少時間。

比如,大多數虛擬主播,播報了一段新聞或者播報了幾十秒的資訊。如果是這樣做的話,就失去了虛擬人的最大價值。

三、釋放產業價值

現在,小冰團隊正透過模型迭代,將訓練時間壓縮到更短。

另外,據徐元春透露,這一次只發布了我們和每日經濟新聞的專案,後面還將陸陸續釋出一些技術。大家能看到實測,比如虛擬主播不僅可以說中文,也可以說其他不同語種。

得益於全新數字孿生虛擬人技術中語音專家模型,虛擬人能夠去理解人類語音,不只是中文,要理解不同語言。這個模型訓練好後,虛擬主播不僅可以說中文,也可以說其他不同的語種,不用再為單獨語種做訓練。

比如,做完數字孿生建模之後,透過最後渲染,虛擬主播可以說中文,也可以說英語,即使原型從來沒有學過英語。

新增一種能力,就像插卡一樣方便。從這個角度來講,小冰的數字孿生虛擬人技術不僅僅是一個把原來的人復刻了,在這種復刻基礎上,它將來會擁有更大的可能性,包括能力。

在數字孿生領域,小冰已經走完第一階段,完成端到端所有的技術和產品化開發,行業使用者可以非常方便的去使用這個平臺,創造自己的虛擬人。

接下來,小冰希望賦能更多行業。在每日經濟新聞,小冰賦予虛擬人撰寫金融資訊的能力,對於其他的虛擬人,小冰可能會賦予其他不同的專業能力,最後放在一個具體場景裡,透過端到端的方式實現出來。

不過,每個行業場景存在區別,要做針對性開發,因此也需要對技術做更多拓展。這個時候,所謂技術佈局,也意味著和很多生態合作伙伴合作賦能。

比如,有些客戶仍然喜歡 3D 建模超寫實技術,但同時也希望這個虛擬人擁有互動能力、聲音的能力,小冰框架仍然可以賦予虛擬人這些能力。

在徐元春看來,這種方式會讓整個虛擬人生態呈現出一個比較完備,不至於完全封閉型的邏輯。

被新冠疫情割裂的 2021 年成為很多人眼中所謂的數字虛擬人元年。

遠端辦公、線上娛樂等線上生活場景使用者暴增,啟用市場對虛擬現實的進一步想象。

在強大的雲計算技術支撐下,內容製作突破限制,人工智慧演算法輔助內容生成,似乎讓虛擬人的想象力可以無限拓展。

與那些希望藉此蹭一把熱度的企業來不同,過去七年,小冰團隊一直堅持在做這種虛擬人,一直在完善各種各樣的技術棧。

並不是因為大家覺得虛擬人市場火了才做。徐元春說,我們一直在這個領域在做自己認為正確的事情。

從產業鏈角度來看,大家也正在慢慢看到,數字虛擬人的格局其實遠遠超過虛擬偶像的範疇。

比如,今年北京冬奧會,測試賽的自由式滑雪空中技巧專案,沒有用人來裁判,而是採用了小冰框架競技體育國際賽事評分系統。

未來,小冰仍然會遵照這樣的佈局和節奏,加速數字虛擬人戰略佈局和研發。

「我覺得,這是一個不變的東西。」徐元春說。