編輯 | 青暮

以前,當我們想擁有一副影象時,首先會做的就是找專業畫師,將我們對圖畫的要求逐一描述,畫師再根據需求醉墨淋漓一番。但這種方式需要耗費一定的時間和人力成本,且成果不一定盡如人意。

如今,基於自然語言生成逼真影象的工具使我們能夠以一種全新的方式輕鬆建立大量的高質量影象。使用自然語言編輯影象的能力進一步允許迭代細化和細粒度控制,這兩者對於現實世界的應用程式都至關重要。

目前,GANs(對抗生成網路)在大多數影象生成任務上擁有最先進的技術,這些技術是透過樣本質量來衡量的,例如FID,Inception Score 和 Precision等指標。

然而,其中一些指標不能完全捕獲生成影象的多樣性,且與最先進的基於似然度的模型相比,GANs捕獲的多樣性較少。此外,如果沒有精心選擇的超引數和正則化器,GANs在訓練中經常翻車。

針對這些問題,OpenAI的兩位研究人員Prafulla Dhariwal和Alex Nichol便著眼於其他體系架構。2021年5月,這兩名學者發表了名為《Diffusion Models Beat GANs on Image Synthesis》的論文,證明了擴散模型在影象合成上優於目前最先進的生成模型的影象質量。

論文地址:https://openreview.net/pdf?id=AAWuCvzaVt

半年多的時間,Alex Nichol 和Prafulla Dhariwal再度攜手,帶領團隊於2021年12月20日釋出了最新研究《GLIDE: Towards Photorealistic Image Generation and Editing with Text-Guided Diffusion Models 》。

論文地址:https://arxiv.org/pdf/2112.10741v1.pdf

以文字“薩爾瓦多·達勒(salvador daĺı)的超現實主義夢幻油畫,畫的是一隻貓在跳棋”為例,GLIDE模型生成如下具有陰影和反射的逼真影象,並以正確的方式組合多個概念,產生新穎概念的藝術效果圖。

文章一出即在推特上引起廣泛關注,收穫了無數業內人士的鮮花和掌聲。

名為Kyle的網友表示,他覺得這項研究跨越了“漸進式增長GAN”到“StyleGAN”的界限。從滿是笨拙的機器學習人工偽造物,到現在突然變得與它模仿的真實物體幾乎無法分辨。

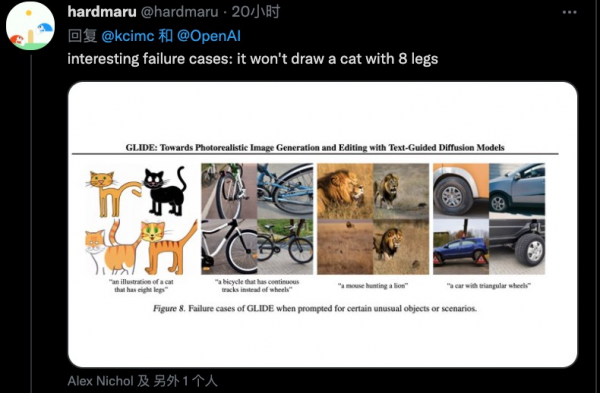

連GLIDE的失敗案例都透著滿滿的優秀感:它不會畫有 8 條腿的貓......

Em......結果是沒見過,但也不是完全沒見過。

1

生成能力超越DALL-E

實驗證明,擴散模型(Diffusion Models)可以生成高質量的合成影象,尤其在與引導技術結合使用時,能夠在保真度上權衡多樣性。

作者們為文字條件下的影象合成問題的擴散模型,對比了兩種不同的指導策略:CLIP guidance 和classifier-free guidance。而後發現,在寫實度和主題相似度方面,後者更受人類評估參與者的青睞,並且經常獲得逼真的樣本。

使用classifier-free guidance的35億引數文字條件擴散模型的樣本收到的評價更高,令來自DALL-E的樣本完全“黯然失色”。GLIDE模型微調後還可以修復影象,出色完成文字驅動的影象編輯任務。

已有的最新文字條件影象模型已經可以做到根據格式多樣的文字中合成影象,甚至可以“理解”語義,按照合理的邏輯組合毫不相關的客體。但在捕捉相應文字並生成逼真影象方面,還略遜一籌。

毋庸置疑,擴散模型是前景大為可觀的生成模型系列,在諸多影象生成任務上達到了最先進的樣本質量基準。

為了在類條件設定中實現真實感,作者們利用分類器指導增強擴散模型,擴散模型以分類器的標籤作為條件。分類器首先在有噪聲的影象上進行訓練,在擴散取樣過程中,使用分類器提供的梯度引導樣本朝向標籤。Salimans等人曾透過使用無分類器的指導,未單獨訓練的分類器中獲得了類似結果,這給研究者們帶來了靈感,在有標籤擴散模型和無標籤擴散模型的預測之間進行插值。

受引導擴散模型生成逼真樣本的能力以及文字到影象模型處理自由形式提示的能力的啟發,研究人員將引導擴散應用於文字條件影象合成問題。首先,作者們訓練了一個 35 億引數擴散模型,該模型使用文字編碼器以自然語言描述為條件。接下來,他們比較了兩種將擴散模型引導至文字提示的技術:CLIP 引導和無分類器引導。使用人工和自動評估,發現無分類器的指導產生更高質量的影象。

研究人員發現GLIDE模型中,無分類器指導生成的樣本栩栩如生,影象還蘊涵著廣泛的世界知識。由人類參與者評估後,普遍給出評價:GLIDE“創造”的效果優於 DALL-E。

2

擴散模型的潛力

在論文《Diffusion Models Beat GANs on Image Synthesis》中,研究人員透過一系列的消融實驗,以找到更好的擴散模型架構,實現無條件的影象合成。對於條件影象合成,則使用分類器指導(利用分類器的梯度以來權衡樣本質量-多樣性)進一步提高了樣本質量。

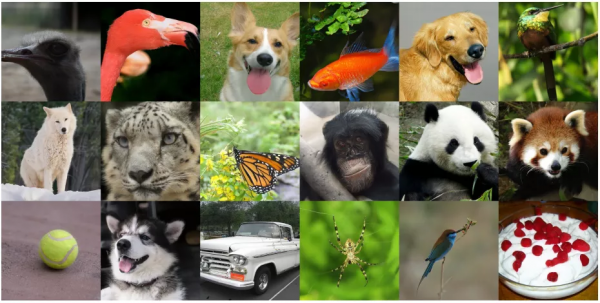

論文的作者們分別在ImageNet 128×128上達到2.97的FID,在ImageNet 256×256上達到4.59的FID,在ImageNet512×512上達到7.72的FID,並且即使每個樣本只有25次正向傳遞,其生成影象質量依然可以匹配BigGAN-deep,同時保持了更好的分佈覆蓋率(多樣性)。

最後,作者團隊發現分類器指導與上取樣擴散模型可以很好地結合在一起,從而將ImageNet512×512上的FID進一步降低到3.85。

DeepMind曾於2018年在一篇 ICLR 2019 論文中提出了BigGAN,當時一經發表就引起了大量關注, 很多學者都不敢相信AI竟能生成如此高質量的影象,這些生成影象的目標和背景都相當逼真,邊界也很自然。

如今,Alex Nichol和Prafulla Dhariwal兩位學者提出的擴散模型,終於可在影象合成上匹敵BigGAN。

從最佳ImageNet512×512模型(FID3.85)中選擇的樣本

擴散模型是一類基於似然度的模型,最近被證明可用於生成高質量影象,同時保留理想的屬性,如更高的分佈覆蓋率、穩定的訓練目標和更好的可擴充套件性。這些模型透過逐步去除訊號中的噪聲來生成樣本,其訓練目標可以表示為一個重新加權的變分下界。

Nichol和Dhariwal發現,隨著計算量的增加,這些模型不斷改進,即使在高難度ImageNet256×256資料集上也能生成高質量的樣本。

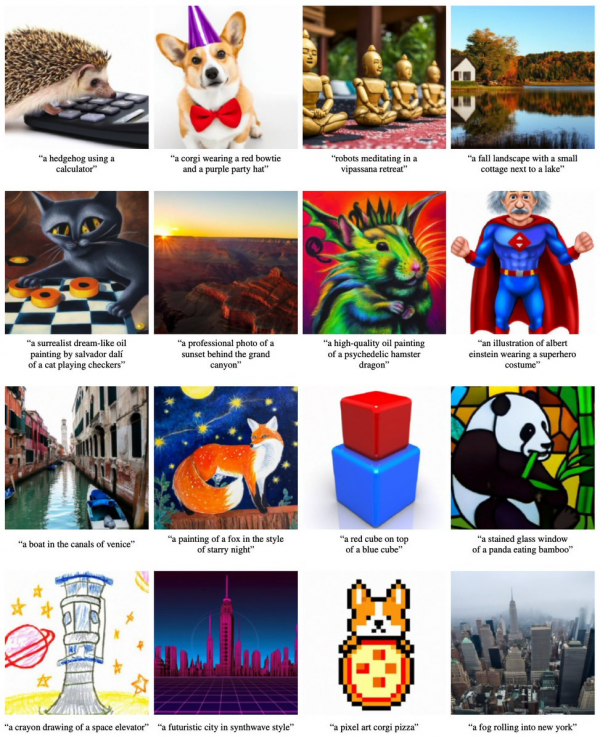

再來看看GLIDE的生成效果。下圖是GLIDE基於不同的文字提示生成的16個影象集,例如“使用計算器的刺蝟”、“戴著紅色領帶和紫色帽子的柯基”等等,如圖所示,生成的影象基本符合文字描述。

美中不足的是,這項研究釋出的較小模型的準確性不如全尺寸模型那麼完美。下圖是由“刺蝟”文字提示生成的16個樣本。

除了圖文轉換,該論文還包括一個互動式系統的原型,用於逐步細化影象的選定部分。這些影象中的一切都是自動生成的,從整個房間開始,對綠色區域進行迭代細化。

在下圖中,研究人員將他們的模型與之前最先進的基於MS-COCO字幕的文字條件影象生成模型進行了比較,發現其模型在無需CLIP 重新排序或挑選的情況下生成了更逼真的影象。對於XMC-GAN,從用於文字到影象生成的跨模態對比學習採集了樣本。對於DALL-E,在溫度0.85下生成樣本,並使用CLIP重新排序從256個樣本中選擇最好的。對於GLIDE,使用2.0刻度的CLIP引導和3.0刻度的無分類器引導。作者沒有為GLIDE執行任何CLIP重新排序或挑選。

研究人員使用人類評估協議將GLIDE與DALL-E進行比較(如下表所示)。請注意,GLIDE使用的訓練計算與DALL-E大致相同,但模型要小得多(35億對120億引數)。此外,它只需要更少的取樣延遲,並且沒有CLIP 重新排序。

研究人員在DALL-E和GLIDE之間執行三組比較。首先,當不使用CLIP重新排序時,比較兩種模型。其次,只對DALL-E使用CLIP重新排序。最後,對DALL-E使用CLIP重新排序,並透過DALL-E使用的離散VAE投影GLIDE樣本。後者允許研究者評估DALLE模糊樣本如何影響人類的判斷。他們使用DALL-E模型的兩個溫度來進行所有的評估,其模型在所有設定中都受到人類評估人員的青睞,即使在非常支援DALL-E的配置中,也允許它使用大量的測試時間計算(透過CLIP重新排序)同時降低GLIDE樣本質量(透過VAE模糊)。

推薦閱讀

GAIR 2021大會首日:18位Fellow的40年AI歲月,一場技術前沿的傳承與激辯

2021-12-10

致敬傳奇:中國並行處理四十年,他們從無人區探索走到計算的黃金時代 | GAIR 2021

2021-12-09

時間的力量——1991 人工智慧大辯論 30 週年紀念:主義不再,共融互生|GAIR 2021

2021-12-12

未來已來,元宇宙比你想象中來得更早丨GAIR 2021

2021-12-12