大資料認知計算在內容安全管控中的應用

杜雪濤

中國行動通訊集團設計院有限公司,北京 100080

摘要:通訊網路中存在海量垃圾和不良資訊,這些資訊需要被閱讀和理解,以便對其進行有效的特徵提取和攔截封堵。基於人工分析的方法已經無法達到目的,需要使用基於大資料的認知計算技術代替人工進行海量的資料分析和理解,幫助人們制訂內容安全管控策略。針對電信詐騙治理、不良訊息治理、變體訊息治理和不良網站治理4個方面遇到的實際問題,分別提出了大資料認知計算的解決方案,並給出了創新性實踐的效果。實踐表明,提出的解決方案能夠快速發現不良資訊,有效地提升內容管控質量。

關鍵詞: 大資料 ; 認知計算 ; 內容安全 ; 詐騙識別

1 引言

隨著人工智慧技術在自然語言處理領域的突破性進展,使用計算機代替人類閱讀和理解海量資料,幫助人們進行科學決策和方案制訂成為可能。基於大資料的認知計算技術應運而生。隨著該技術的不斷成熟,其被應用到醫療、法律、教育和金融等多個領域,成為各行業的研究熱點。

作為關鍵資訊通訊基礎設施的運營者和維護者,運營商有義務對通訊網路中傳播的資訊進行內容安全管控。隨著資訊傳輸速度日益加快,資訊容量越來越大,資訊變化速度越來越高,治理壓力持續加大。面對海量資料,人工分析方法已經無法應對不良資訊的快速演變。因此亟須引入基於大資料分析的認知計算技術,用其代替人工分析,自動總結最新不良資訊的規律和知識,幫助內容安全管控人員快速對新型不良資訊做出正確有效的響應。

雖然認知計算已經被廣泛應用於多個領域,但其與內容安全治理相結合的場景尚不多見。本文討論的內容安全治理特指不良文字內容。目前通訊運營商治理不良文字內容的手段主要分為線上攔截和線下分析兩種。在線上攔截中,可以配置關鍵詞組合策略,對傳送的不良文字訊息進行實時攔截。線上下分析中,可以對海量資料進行大資料分析,最終實現兩個目的:第一,發現線上分析無法識別的隱蔽不良文字訊息,如詐騙資訊與正常通訊內容非常接近,很難透過定義關鍵詞進行識別;第二,最佳化線上的關鍵詞組合策略,發揮線上攔截系統的最大功效,如發現了更加精準高效的關鍵詞,用其替換已有線上關鍵詞。

圍繞上述兩個目的,本文將大資料認知計算技術創新性地應用到4個場景:詐騙資訊識別與易感人群發現、不良關鍵詞知識庫構建、垃圾訊息變體詞自動發現以及不良域名擬態拓展。詐騙資訊識別與易感人群發現是為了發現隱蔽詐騙資訊,後面3個應用場景都是為了有效地最佳化線上關鍵詞組合策略。其中,不良關鍵詞知識庫構建的目的是最佳化關鍵詞本身以及關鍵詞之間的布林邏輯;垃圾訊息變體詞自動發現的目的是生成變體關鍵詞策略,精準攔截變體垃圾資訊;不良網站域名擬態擴充套件的目的是發現未知不良域名,以便將域名配置為關鍵詞,對包含不良域名的不良文字進行精準攔截。

本文基於自然語言處理與機器學習技術提出了大資料認知計算在這4種內容安全治理問題中的解決方案,並結合案例分析展示了認知計算在內容安全治理中的實踐效果。

2 應用場景1——詐騙資訊識別與易感人群發現

2.1 問題背景

電信詐騙給使用者帶來了巨大的經濟損失,其中詐騙訊息是詐騙分子與受害者建立聯絡的重要環節。隨著電信詐騙黑色產業鏈逐步成熟,詐騙日趨呈現專業化、精準化、隱蔽化的特點。詐騙分子透過購買黑產資料獲得受害者個人資訊,並在詐騙過程中準確說出受害者名字,冒充受害者的熟人,從而獲得受害者的信任。不同於其他違法類資訊,該類資訊幾乎不使用敏感詞,使用文字分類技術很難將其與正常訊息進行區分,誤判率較高,治理效果不理想。為了實現對該類資訊的精準識別,需要使用技術手段對犯罪分子使用各種身份群發信息的行為(以下稱為濫用身份行為)進行捕捉。為了實現這一目標,需要使用認知計算技術對海量非結構化資訊內容進行精細化語義理解,識別其中的身份資訊,並使用機器學習技術推斷身份資訊的歸屬。當發現大量身份資訊附著在同一個傳送者身上時,則該傳送者可能是濫用稱謂詐騙者。分析濫用稱謂詐騙者的詐騙物件,可以得到電信詐騙易感人群。

2.2 基於大資料認知計算的解決方案

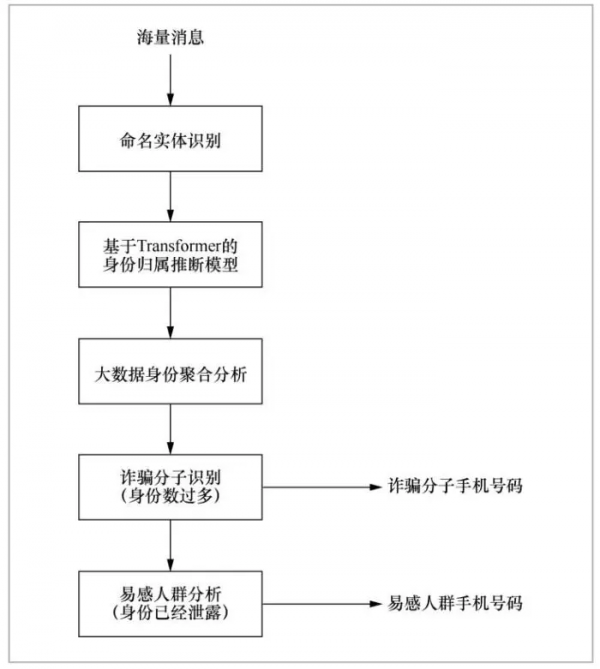

如圖1所示,在識別濫用身份類詐騙時,首先需要使用命名實體識別技術對訊息中的人名、組織機構名稱、QQ號、微訊號、抖音號等資訊進行精準識別。關於命名實體識別的研究成果國內外已有很多,最新的研究成果有基於BERT嵌入、轉移學習、自注意力機制等方法。一個命名實體可能代表了一種身份資訊。當識別出身份資訊後,還需要進一步推斷身份資訊屬於訊息傳送者還是訊息接收者。本文采用基於Transformer的深度神經網路對身份資訊的所有者進行推斷,從而將不同的身份資訊聚合到訊息傳送者和訊息接收者上。選擇Transformer主要有兩個原因:第一,Transformer模型的多頭自注意力網路能夠自動學習輸入文字中詞語之間的任意距離的依賴關係;第二, Transformer模型的位置編碼機制將詞語的位置資訊也融合到詞嵌入中,這就保證稱謂在開頭或結尾時,模型的自注意力網路能夠有效地感知位置資訊,進而透過位置資訊對稱謂的歸屬進行準確的推斷。

命名實體歸屬的推斷通常需要考慮命名實體所在的上下文,如命名實體的前序詞語為“尊敬的”,則顯然該命名實體歸屬於訊息接收者;而若命名實體的前序詞語是“我是”,則歸屬於訊息傳送者。同時命名實體所在訊息位置也直接影響了訊息歸屬,如命名實體在訊息開頭則屬於接收者,在訊息結尾則屬於傳送者。在推斷命名實體歸屬時,Transformer可以充分考慮訊息中的每一個詞對命名實體歸屬的影響,同時還可以透過位置編碼技術考慮命名實體所在的位置資訊,因此能夠準確地推斷出命名實體的歸屬。

可以使用圖資料庫對分析出的海量號碼關聯身份資訊進行儲存,並透過圖計算,快速找到身份資訊過多的訊息傳送者。一般情況下,當一個訊息傳送者使用的身份資訊超過10個時,則可以判定訊息傳送者為詐騙分子。當一個訊息傳送者被判定為詐騙分子後,其所傳送資訊的接收者均為潛在的詐騙受害者。同時若資訊中有資訊接收者的身份資訊,則證明資訊接收者的身份已經洩露,其還有可能被其他詐騙分子當作潛在的詐騙目標,屬於電信詐騙的易感人群。針對該類易感人群,可重點進行反電信詐騙的宣傳教育。

2.3 實踐案例

圖2是透過分析海量真實資料得到的濫用稱謂詐騙示例,每個型別的示例訊息為同一個號碼傳送。加粗的欄位為演算法識別出的稱謂資訊,為了保護個人資訊,示例中的稱謂資訊已被模糊化。從訊息內容可看出,訊息的傳送者稱謂資訊可能會出現在訊息的開頭、中間或結尾,模型都能夠進行較好的稱謂分辨。上述例子中每一種詐騙的傳送者實際上都被模型賦予了20個以上的身份資訊,此處限於篇幅僅各列出3個。

透過分析海量訊息中的命名實體歸屬,將訊息中的命名實體聚合到訊息的傳送者和接收者上,可以快速分析出濫用或偽造身份的詐騙訊息傳送行為。在實踐中,該演算法每天可發現濫用稱謂類垃圾訊息近百萬條,治理成效顯著。另外,由於該方法從詐騙分子偽造身份這一本質特徵進行分析,並不依賴於具體的詐騙套路,故詐騙分子很難透過改變詐騙套路繞過該方法。

綜上所述,透過使用大資料認知計算中的自然語言處理技術,提取海量非結構化文字中的命名實體,再透過機器學習技術使用Transformer模型學習如何推斷命名實體屬於訊息傳送者還是接收者,可以有效地將命名實體按照訊息的傳送者聚類,從而找到具有過多命名實體的訊息傳送者,進而確定詐騙分子的手機號碼。

3 應用場景2——不良關鍵詞知識庫構建

3.1 問題背景

運營商在進行不良文字訊息治理時,通常使用關鍵詞組合策略。關鍵詞組合策略由一系列關鍵詞和“與”“或”邏輯有機構成。當一條資訊中包含策略定義的關鍵詞且滿足策略定義的邏輯組合時,該資訊就會被判定為違規資訊。關鍵詞組合策略通常由人來定義。策略制訂人員需要根據不同的不良文字訊息特徵定義不同的關鍵詞組合策略,過程費時費力,且覆蓋不全面。當策略數量達到上千條時,人工維護每一條策略的生命週期變得不可行。

此外,不同水平的策略制訂人員制訂的策略也存在較大的質量差距。普通策略制訂人員在制訂一條策略時往往聚焦於少量特定不良資訊,只有有經驗的策略制訂人員才會進行策略的適度拓展,提高策略泛化能力。透過大資料認知計算技術,將海量不良資訊凝練成不良關鍵詞知識庫,可以幫助缺乏經驗的策略制訂人員進行適度的拓展發揮。

為了達到上述目的,需要使用認知計算技術分析海量非結構化垃圾文字訊息,使用深度學習與自然語言處理技術自動挖掘垃圾文字中不良關鍵詞之間的“共現”和“替代”關係,並形成知識庫。具體地,具有替代關係的兩個關鍵詞經常在相同的語境中出現,如“美國”和“漂亮國”在政治類訊息中共享相同的語境,可相互替代。若要自動發現具有替代關係的關鍵詞,需要使用深度學習技術計算每個詞語的上下文語境表示,並計算語境之間的相似度,相似度越大,則兩個詞語之間的替代性越強。替代關係可以幫助策略管理人員拓展現有策略的“或”邏輯。

具有共現關係的兩個關鍵詞經常在相同型別的訊息中一同出現:如“代開”和“發票”經常在涉黑類訊息中出現。在進行共現關係挖掘時,不但要考慮兩個詞語在訊息中共同出現的機率,還需要考慮其對不良訊息的判別作用,可以透過機器學習技術構建文字分類模型來評價不同詞語共現特徵對分類結果的影響,影響越大,則共現關係越強。策略管理人員可以透過共現關係拓展策略的“與”邏輯。

3.2 基於大資料認知計算的解決方案

關鍵詞的屬性資訊中的類別傾向性和熱度比較容易使用大資料統計的方法獲得,統計關鍵詞在相應類別下的頻次即可。這裡不再贅述。

關鍵詞的替代關係可以透過基於詞嵌入層的文字分類器來實現。詞嵌入層可以將輸入的關鍵詞轉化為稠密空間中的一個向量表達。當分類器進行訓練時,詞嵌入層將為不同詞語的向量表達進行最佳化,使得不同類別傾向性的詞語距離拉長,相同類別傾向性的詞語距離縮短。當在特定類別下兩個詞語具有相互替代效果時,兩個詞語的距離非常接近。可使用兩個向量的餘弦距離量化關鍵詞替代關係的強弱。帶有詞嵌入層的文字分類模型有很多。例如,Ge L H等人透過詞嵌入模型來最佳化文字分類效能;Liu Q等人將面向特定領域的詞嵌入模型用於文字分類;同時標準Transformer網路也包含詞嵌入層, Shaheen Z等人將Transformer應用於文字分類任務。另外,王玲將詞嵌入與長短期記憶(long short-term memory, LSTM)網路進行組合,形成分類器。對於短訊息分類場景,任選一種結構較簡單的包含詞嵌入層的分類器即可滿足要求。

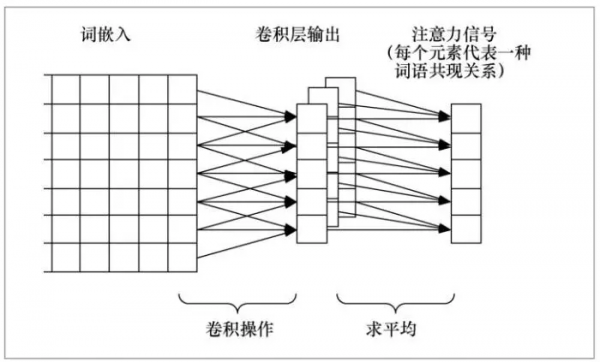

關鍵詞的共現關係可以使用基於卷積與注意力機制神經網路的分類器來實現。卷積視窗的大小決定了共現詞語的個數。卷積特徵圖中的每一個元素代表了一種詞語共現關係。這些共現關係對分類結果會有不同程度的影響,注意力層會將這些影響量化為權重。當分類器輸入一條訊息時,可以透過注意力矩陣權重找到與訊息類別關聯最緊密的詞語共現關係。對每條訊息都提取最重要的詞語共現關係,並進行統計聚合。可以實現對關鍵詞共現關係網路的快速挖掘。將卷積與注意力機制組合的分類器較豐富,如Du J C等人提出了卷積迴圈注意力網路(convolutional recurrent attention network,CRAN);Gao S等人構建了一種層次化的卷積注意力網路,從詞級和句子級兩個層次對文件進行分類;Liu G等人和Zheng J等人將卷積網路、雙向LSTM網路與注意力機制進行了不同的組合嘗試,並獲得了不錯的效果;閆躍等人使用多重注意力機制與卷積網路結合,形成文字分類器。對於訊息類短文字分類,採用卷積迴圈注意力網路已經足夠。

綜上所述,關鍵詞的替代關係與共現關係需要訓練一個同時包含詞嵌入、卷積層和注意力層的神經網路。如圖3所示,卷積迴圈注意力網路將詞嵌入層透過卷積操作後輸出到注意力層,注意力訊號的每一個元素代表了一種詞語共現關係。透過訓練該模型得到詞嵌入表達,同時在輸入訊息時得到訊息中詞語共現關係權重。這些資訊可以用於計算關鍵詞替代關係和共現關係。

3.3 實踐案例

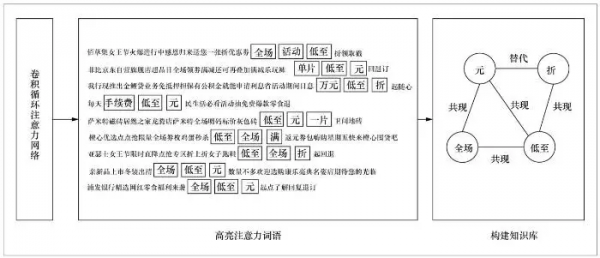

圖4展示了模型在真實短訊息資料中的輸出資料示例。當將海量訊息輸入卷積迴圈注意力網路後,透過觀察注意力網路的最大權重可以得到每條訊息最重要的共現關係。圖4中案例使用的卷積視窗大小為3,因此共現關係表現為3個連續的詞語共同出現的特徵。透過統計海量訊息的共現特徵,可以得到右側的知識庫。知識庫中的節點為共現特徵庫中的詞,節點之間的邊描述詞之間的關係。圖4中“全場”和“低至”出現頻次較高,則可以構建兩者之間的“共現”關係連線。透過進一步計算節點的詞嵌入之間的餘弦相似度,可以獲得替代關係,如“元”和“折”兩者的詞嵌入較為接近,故二者存在替代關係。透過如上知識,可以生成策略“(元|折)&低至”,即“元”和“折”是“或”邏輯,二者與“低至”形成“與”邏輯。

策略制訂人員和管理人員藉助不良關鍵詞知識庫可以快速對最新的不良資訊提取關鍵詞並形成策略,從而提高不良資訊的識別質量。基於該知識庫開發的策略查準最佳化功能能夠平均提升策略查準率15%,基於該知識庫開發策略查全最佳化功能能夠平均提升策略貢獻力10%。基於該知識庫研發的策略自動最佳化流程能夠大大提升策略制訂人員應對新型不良資訊的響應速度(由小時級別提升到分鐘級別)。

綜上所述,在使用大資料與認知計算前,將不良資訊轉化為關鍵詞策略主要依靠人的智慧和經驗,這些智慧和經驗並沒有外化為知識庫作為長期的知識沉澱。本文提出了一種自動從海量資料中自動學習不良詞語“替代”關係和“共現”關係的方法,並將學習到的關係構成不良關鍵詞知識庫,藉助知識庫可實現不良資訊到關鍵詞策略的自動轉化。具體地,本文應用大資料認知計算中的機器學習技術對文字進行自動分類,模型選擇包含詞嵌入層、卷積層和注意力層的神經網路模型。在模型訓練完畢後,可根據模型預測階段得到的神經網路權重反推顯著的不良詞語“替代”和“共現”關係特徵。將這些關係形成知識庫可幫助策略制訂和管理人員自動地完成從不良資訊到關鍵詞策略的高質量轉化。

4 應用場景3——垃圾訊息變體詞自動發現

4.1 問題背景

隨著運營商對垃圾訊息的持續治理,垃圾訊息傳送者開始在訊息中引入大量變體關鍵詞,以規避關鍵詞審查。變體關鍵詞將敏感關鍵詞中的字用同音字、形近字、拼音或拼音首字母、特殊符號等方式進行替換。不同於其他關鍵詞,變體關鍵詞幾乎不會在正常訊息中出現,因此及時準確發現變體關鍵詞,並制訂關鍵詞策略可以高效、準確地實現變體垃圾訊息攔截。

通常一個敏感關鍵詞可以衍生出數十種甚至上百種變體,且變體會隨時間不斷變化。只有及時瞭解敏感關鍵詞變體的發展變化情況,才能快速對最新關鍵詞變體進行響應。但採用人工總結的方式很難實現上述目標,需要使用大資料認知計算技術自動分析海量垃圾資訊,並理解和推斷出其中包含的變體關鍵詞。

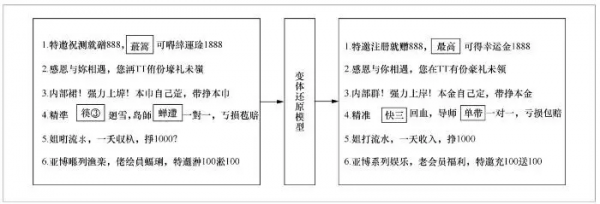

具體地,在給定一條變體垃圾資訊時,首先需要使用深度學習技術對變體垃圾資訊的本體進行智慧還原。該過程同時考慮變體訊息中每個字的發音、字形和所處上下文,對每個字是否需要還原進行判斷,若需要還原,則自動給出還原結果。如“菠菜網站”是“博彩網站”常用的變體訊息,“菠菜”是否要還原為“博彩”首先要看“菠菜”本身的發音,其次還需要看其後面是否為“網站”。

在對變體訊息進行還原後,可對還原後的訊息進行敏感詞分析,並在變體中反推出敏感詞變體。如還原後,資訊中“充值”可能在變體資訊中是“衝值”,那麼“衝值”為“充值”的變體關鍵詞。透過分析海量變體訊息,可以總結大量變體關鍵詞,這些關鍵詞大多不會在正常訊息中出現,故可以將其配置為關鍵詞策略以進行訊息攔截。如策略“(枰邰|坪邰|評苔|蘋苔|坪苔|呯邰)”配置了“平臺”這個關鍵詞的各種變體。訊息中只要包含其中一個變體,則會被立刻攔截。

4.2 基於大資料認知計算的解決方案

變體關鍵詞推斷的靈感來源於拼音輸入法的實現方法。在拼音輸入法中,給定拼音序列,輸入法可以給出拼音序列對應的最可能的中文句子。在拼音輸入法功能中,拼音序列中每一個拼音最終對應輸出的一個文字。這是一個典型的序列到序列的對映學習問題。可以使用LSTM、Transformer等深度學習模型實現對映學習。由於Transformer模型可以更好地處理長距離依賴關係,本文選用Transformer模型。具體地,Transformer可以從拼音序列中任何有幫助的位置來推斷當前拼音對應的文字,其變體還原能力比LSTM更強,這種長距離拼音的推理對於變體還原任務非常重要,會直接影響變體還原的效果。

在給定變體訊息時,首先將變體訊息轉換為拼音序列,再透過深度神經網路推理最可能的原始訊息內容。透過對比還原後的訊息與變體訊息的差異,可以鎖定訊息中出現的變體關鍵詞。變體訊息中可能會有特殊符號,需要為特殊符號分配相應的發音。如給“+”分配發音“jia”。當特殊符號的發音不易確定時,可為其分配一個唯一的虛擬發音,如給“/”分配虛擬發音“zxg”(即“左斜槓”的拼音首字母,虛擬發音可任意指定)。同時,在變體訊息中還會出現拼音本身或英文縮寫,可以在轉換拼音序列時直接保留,不做轉換。

當訊息中的關鍵詞變體為同音變體時,將訊息轉化為拼音序列後,同音文字變體差異被消除,其完全轉化為從拼音序列推測文字內容的任務,因此推測識別率較高。但當變體關鍵詞為形近變體時,變體關鍵詞的發音有可能與原始關鍵詞不同,會干擾模型的推理。

為了解決這一問題,可以透過向輸入拼音中加入智能干擾的方式增強模型的還原能力。此時,輸入拼音序列中每個元素不再是一個拼音,而是多個拼音。其中一個拼音為正確拼音,其他拼音為干擾拼音。在訓練模型時,可完全將不帶變體關鍵詞的訊息作為訓練資料,訊息本身是模型期望的輸出,訊息的輸入為帶智能干擾的拼音序列。具體的智能干擾方式如下。

針對訊息中的每一個字,需要生成n個拼音。其中一個拼音是該字本身的發音,其餘拼音有如下生成規則:當該字有形近字,且拼音與該字不同時,則加入形近字的拼音,可以加入多個;當該字有相似的特殊符號可以表示時,加入特殊符號的拼音。如果上述兩種干擾拼音都加入後仍不足n個,則考慮隨機加入拼音。在模型進行預測時,可將輸入變體訊息的第一個字轉為形近字拼音和特殊字元拼音,若不足n個拼音,則加入一個空拼音,使隨機干擾儘可能變小。綜上所述,透過在訓練時增加更多隨機干擾,模型可以在預測時有更強的還原能力。透過在預測時僅加入文字本身、形近字和形近特殊字元發音,不加入隨機發音,可讓模型專注於對這幾類變體進行推理。

圖5所示為一個對Transformer網路進行改造得到的變體訊息還原網路。與標準Transformer網路不同,該網路在多頭自注意力模組與嵌入層之間加入了拼音融合層。該層主要將干擾發音疊加到原始發音之上,使Transformer網路能夠學習對抗這種干擾發音的疊加。

4.3 實踐案例

圖6所示為變體還原模型對6條真實垃圾訊息的還原結果。其中,第1條訊息中的“蕞篙”被成功恢復為“最高”,屬於同音和形近字雙重變體復原;第4條訊息中的“筷③”被成功恢復為“快三”,包含了特殊字元的變體復原;第4條訊息中的“蟬遰”被成功恢復為“單帶”,屬於形近不同音變體的復原。由此可見,模型能夠支援對形近、同音、特殊字元變體的復原。

表1為從圖6的變體垃圾資訊中自動提取的變體詞列表。變體詞透過對還原後的文字進行分詞後反推而得。其中大部分變體詞是同音變體詞,這也符合真實的垃圾資訊使用變體的情況。變體還原模型同時考慮了變體詞的發音和其形近字的發音,故能夠有效地對這些變體進行還原。此外,這些變體詞在正常訊息中幾乎不可能出現,故可將這些變體詞配置為關鍵詞策略用於對變體垃圾資訊進行快速攔截。

實踐證明,使用變體還原模型可有效地還原垃圾訊息中的大部分變體。透過比較還原前後的文字,可以快速定位敏感關鍵詞的變體。透過該方法可迅速構建出不良關鍵詞變體庫,基於變體詞庫輸出的變體關鍵詞策略在實際應用中一週可以識別和攔截數十萬條變體垃圾資訊,有效地解決了變體垃圾訊息的漏攔問題。

綜上所述,變體垃圾資訊對垃圾資訊的識別造成了巨大幹擾,一些變體甚至可能會迷惑人的稽核判斷。本文利用大資料認知計算技術中的機器學習技術學習拼音序列到文字序列的正確轉化。

5 應用場景4——不良域名擬態拓展

5.1 問題背景

開設賭博、色情網站在國內屬於違法行為,因此不良網站的伺服器通常不在國內,運營商無法對伺服器直接進行處理,僅能對伺服器的域名進行封堵。不良網站建立者為了規避封堵風險,會集中生成一批風格相近的域名,一些域名一旦被封,立刻切換域名,並不影響使用者訪問。

目前運營商發現不良域名的方法是分析使用者訪問域名本身是否具有不良特徵、對應網站中的文字和圖片資訊是否包含敏感內容等。這些方法多是在使用者發生訪問行為後再進行網站識別的。一方面訪問網站的事實已經發生,已經造成了一定的不良影響;另一方面封堵時並沒有考慮被封網站可能有備用域名的問題,封堵不徹底。

一些有經驗的不良網站稽核員可以透過被封堵的不良網站域名規律推測出其他未知的不良網站域名,這樣可以在網路中還沒有出現使用者訪問該域名的記錄的前提下發現這些不良網站,如已知“xx991.com”和“xx993.com”是不良域名,則很可能“992xx.com”也是一個不良域名。這些不良網站的規律千差萬別,採用人工的方式很難全面總結。需要使用認知計算技術自動學習已知的不良網站域名特徵,並自動模仿不良域名的表現形態,舉一反三,生成形態相似的潛在不良域名。具體地,此過程主要涉及使用深度學習技術幫助人們自動學習和理解海量不良網站域名的格式特徵、字元關聯、字元與數字的組合特點,並根據學到的規則自動創造全新的符合規則的潛在不良域名。透過對生成的潛在不良域名進行內容分析,最終確認未知不良網站。

5.2 基於大資料認知計算的解決方案

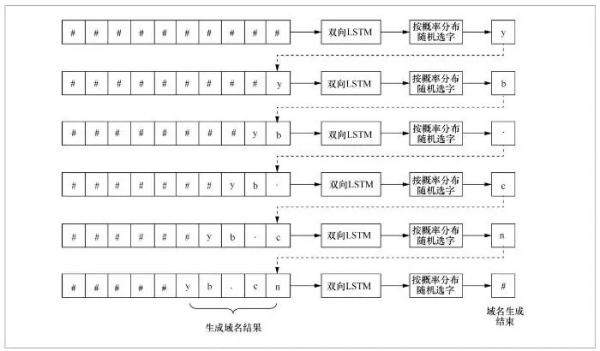

為了實現不良網站的擬態拓展能力,可以使用雙向LSTM模型對已知不良網站的構成特徵進行學習。具體訓練步驟是在給定不良網站域名中的任意n個字元後,預測不良網站域名的下一個字元。若模型能夠在給定任意已知域名的任意n個連續字元後,都可以準確預測下一個字元,則代表模型已經充分學習了已知不良域名的字元構成特徵,就可以進行相同形態域名的智慧生成。

雙向LSTM生成域名的過程如圖7所示。在生成一個域名時,首先向模型中輸入n個空字元(圖7中為10個),則模型會輸出域名的第一個字元,接下來將模型剛輸出的字元加入輸入,則輸入變為n-1個空字元和最新輸出的字元。將該輸入再輸入模型,模型會繼續輸出下一個字元。依此類推,不斷將模型輸出的字元加入輸入中,則輸入一直儲存最近模型輸出的連續n個字元,並不斷輸出下一個字元,直到輸出空字元為止。此時一個域名生成完畢。

採用上述生成方法雖然可以得到形態相似的域名,但生成的域名較大機率為已知不良域名本身。為了讓模型在模擬形態的基礎上發揮自身的創造力,可以在生成下一個字元的過程中加入一些隨機性,即並不總是選擇推測機率最大的字元作為輸出字元,而是按照推測的各種字元的出現機率進行隨機選擇,如圖7所示。

除了使用雙向LSTM模型,很多文字生成模型也可以完成域名生成的任務,資料的訓練方法和文字的生成方法與雙向LSTM模型相同。如許曉泓等人使用Transformer模型完成從資料到文字的生成過程;Pawade D等人使用字級別的RNN-LSTM生成文字;錢揖麗等人提出了基於句子級LSTM編碼的文字標題生成模型等。由於域名結構相對簡單和簡短,不太可能出現字元之間的長距離依賴,故採用雙向LSTM已經足夠實現域名的擬態拓展。

5.3 實踐案例

從訓練資料中找到所有包含“av”和“zy”兩種模式的不良域名,並在模型生成的不良域名中尋找上述兩種特徵,可以分析模型如何利用訓練資料中的模式拓展生成域名。

圖8為雙向LSTM模型的訓練資料模式與拓展資料模式。為了避免傳播不良網站域名,圖8中對不良網站域名進行了模糊化處理,“#”代表任意一個數字,“*”代表任意一個字元。如圖8所示,雙向LSTM模型不但可以模仿訓練資料中的已有模式,還可以創造更多全新的域名模式。按照這些域名模式可以發現更多不良網站。將被確認為不良網站的域名新模式加入訓練資料中,可以加強LSTM對新不良模式的學習,如此迴圈可以形成一個不良域名特徵自動學習更新拓展的閉環。

研究發現,使用不良域名擬態拓展能力學習3 000個不良域名後,每生成10 000個不良域名,平均有大約18個域名是重複的,重複率為0.18%。透過使用爬蟲進行內容驗證,發現平均有2 032個域名是真實存在的,平均有876個域名為真實的不良域名。從生成域名到最終發現不良域名,轉化率大約為8.76%。將不良域名擬態拓展能力應用於實際工作中,每天可以發現上千個活躍的未知色情、賭博類網站,使不良網站的封堵更加主動、徹底、高效。

綜上所述,不良網站通常會註冊風格相似的域名。人為觀察已有不良域名特徵預測未知不良域名工作量巨大,且僅能進行小範圍的嘗試。本文利用大資料認知計算技術中的自然語言生成能力,將域名資訊看作一種自然語言,使用LSTM模型對海量不良域名構建語言模型,並實現了模仿不良域名特徵拓展生成全新不良域名的能力。實踐證明,該演算法能夠發現大量未知的不良域名,實現了不良域名的主動發現、事前發現。

6 結束語

通訊運營商在進行內容安全管控的過程中遇到了諸多需要進行海量資料分析理解的問題。在使用大資料認知計算前,這些任務多采用人工分析的方法,資料處理能力有限,治理效率不高。大資料認知計算技術可以幫助安全管控人員分析理解海量資料,發現更多不良資訊,大幅提高不良資訊的治理效率。本文從不良文字線下分析的兩個目的入手,總結了大資料認知計算在詐騙資訊識別與易感人群發現、不良關鍵詞知識庫構建、垃圾訊息變體詞自動發現、不良域名擬態拓展4個內容安全領域的創新性實踐。

上述大資料創新實踐方案有效地使用大資料認知計算替代了人工,幫助人們理解海量不良資訊的關鍵內容,大力支撐了內容安全管控工作。實踐研究證明,本文提出的應用方案能夠幫助內容安全管控人員快速響應最新不良資訊,全面有效提升整體管控質量。

作者簡介

杜雪濤(1973-),女,中國行動通訊集團設計院有限公司網路規劃與設計最佳化研發中心網信安全產品部教授級高階工程師,主要從事網路與資訊保安研究工作。

聯絡我們:

Tel:010-81055448

010-81055490

010-81055534

E-mail:[email protected]

http://www.infocomm-journal.com/bdr

http://www.j-bigdataresearch.com.cn/

轉載、合作:010-81055537

大資料期刊

《大資料(Big Data Research,BDR)》雙月刊是由中華人民共和國工業和資訊化部主管,人民郵電出版社主辦,中國計算機學會大資料專家委員會學術指導,北京信通傳媒有限責任公司出版的期刊,已成功入選中國科技核心期刊、中國計算機學會會刊、中國計算機學會推薦中文科技期刊,並被評為2018年、2019年國家哲學社會科學文獻中心學術期刊資料庫“綜合性人文社會科學”學科最受歡迎期刊。

關注《大資料》期刊微信公眾號,獲取更多內容