編輯:LRS

【新智元導讀】AI語音生成的特點就是呆板,沒有情緒的起伏。最近Meta AI連發了三篇Textless NLP的論文,不僅開源了textlesslib庫,還展示了AI對話在語音情感轉換的驚人能力!

在日常交流的時候,人們往往會使用一些「非語言」的訊號,比如語調、情感表達、停頓、口音、節奏等來強化對話互動的效果。

像開心、憤怒、失落、睏倦時說同一句話,雖然內容都一樣,但聽起來的感覺肯定是非常不同的,而AI的發聲則比較死板。

目前AI語音生成系統大部分還是根據書面文字來學習發聲,也就是說,模型只能知道說話的內容,卻不知道人類以何種語速、情感來說,對於文字之外富有表現力的語音訊號根本捕捉不到。

所以AI雖然能當主持人播新聞,但在一些特殊的應用場景裡,比如小品、相聲、脫口秀這些語言藝術領域,人工智慧還沒法取代人類來說話。

Meta AI去年推出了一個突破性的自然語言處理模型GSLM,打破了傳統模型對文字的依賴。

GSLM可以透過直接處理原始的音訊訊號來發現結構化的內容,無需使用任何人工標籤或文字,就像人學語言的過程一樣。GSLM能夠讓NLP模型捕捉到口頭語言的表現力,也可以作為下游應用的一種預訓練形式,或者作為一種生成工具,從給定的輸入音訊提示中生成後續音訊。

最近,Meta基於GSLM連發三篇論文,朝著更有表現力的NLP模型向前走了一大步。

開源textlesslib

釋出了一個開源的Textless Python庫,機器學習開發人員可以更快地在GSLM元件(編碼器,語言模型,解碼器)上進行實驗。

論文連結:https://arxiv.org/pdf/2202.07359.pdf

程式碼連結:https://github.com/facebookresearch/textlesslib

Textless NLP是一個活躍的研究領域,旨在使NLP相關的技術和工具可以直接用於口語。透過使用自監督學習的離散語音表徵,Textless NLP技術能夠在那些沒有書面形式的語言上或在基於文字的方法無法獲得的口語資訊中開發出更多有趣的NLP應用。

Meta開源的textlesslib是一個旨在促進無文字NLP研究的庫。該庫的目標是加快研究週期,並降低初學者的學習曲線。庫中提供高度可配置的、現成的可用工具,將語音編碼為離散值序列,並提供工具將這種流解碼迴音頻領域。

語音情感轉換

對於一些表達性的發聲,比如笑聲、哈欠和哭聲,研究人員開發的模型已經能夠捕捉到這些訊號了。這些表達方式對於以人的方式理解互動的背景至關重要,模型能夠辨別出那些有可能傳達關於他們的交流意圖或他們試圖傳達的情感的細微差別,比如是諷刺、煩躁還是無聊等等。

論文連結:https://arxiv.org/pdf/2111.07402.pdf

演示連結:https://speechbot.github.io/emotion/

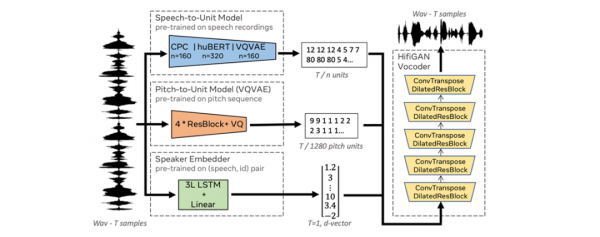

語音情感轉換(Speech Emotion Conversion)是指在保留詞彙內容和說話人身份的情況下修改語音語料的可感知情感的任務。在這篇論文中,研究人員把情感轉換的問題作為一項口語翻譯任務,將語音分解成離散的、不相干的,由內容單元、音調(f0)、說話人和情緒組成的學習表徵。

模型先透過將內容單元翻譯成目標情感來修改語音內容,然後根據這些單元來預測聲音特徵,最後透過將預測的表徵送入一個神經聲碼器來生成語音波形。

這種正規化使得模型不止能發現訊號的頻譜和引數變化,還可以對非語言發聲進行建模,如插入笑聲、消除哈欠等。論文在客觀上和主觀上證明了所提出的方法在感知情感和音訊質量方面優於基線。實驗部分嚴格評估了這樣一個複雜系統的所有組成部分,並以廣泛的模型分析和消融研究作為結論,以更好地強調擬議方法的架構選擇、優勢和劣勢。

比如在一個包含五種情緒表達方式(中立、憤怒、娛樂、睏倦或厭惡)的情緒轉換任務中,模型需要根據輸入音訊轉換到目標情緒,可以看到整個流程就相當於是一個端到端的序列翻譯問題,所以插入、刪除、替換一些非語言的音訊訊號來轉換情感就會更容易。

經過實驗評估可以看到,提出的模型與以往最佳情感語音轉換模型相比,取得了極大的質量提升。事實上,結果與原始音訊的質量非常接近(圖表中以淺綠色為原始音訊)。

有情感的AI對話

Meta AI建立了一個可以讓兩個人工智慧agent之間自發的、實時的閒聊模型,每個agent的行為因素,如偶爾的重疊或停頓都很真實,這對建立像虛擬助手這樣的應用場景來說很重要,可以讓AI更好地理解細微的社交線索和訊號,比如能夠捕捉到與人聊天時的細微的積極或消極反饋。

論文連結:https://arxiv.org/pdf/2203.16502.pdf

演示連結:https://speechbot.github.io/dgslm/

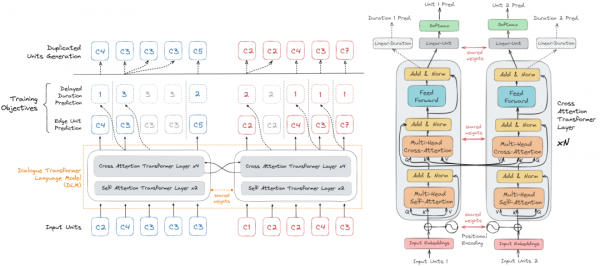

文中提出的dGSLM模型是第一個能夠生成自然口語對話音訊樣本的Textless模型。模型的開發上利用了最近在無監督口語單元發現方面的工作,加上一個帶有交叉注意力的雙塔Transformer架構,在2000小時的雙通道原始對話音訊(Fisher資料集)上訓練,沒有任何文字或標籤資料。dGSLM能夠在兩個通道中同時產生語音、笑聲和其他副語言訊號,讓談話的轉折非常自然。

顛覆傳統NLP

在不久的將來,基於Textless NLP技術構建的下游應用將會呈井噴之勢,由於模型訓練既不需要資源密集型的文字標籤,也不需要自動語音識別系統(ASR),模型可以直接透過音訊訊號進行問答。Meta AI的研究人員認為語音中的親和力可以幫助更好地解析一個句子,這反過來又促進了對意圖的理解,能夠提高問題回答的效能。

其中一個應用場景是語音到語音的翻譯,也可以叫做AI翻譯配音(dubbing)。傳統的流暢通常是基於文字來完成的,需要先將音訊轉換為文字,執行翻譯,再將文字轉換為音訊訊號。

比如大火的「魷魚遊戲」多語言版本就用到了這一技術。

但流程太複雜會使得整個系統變得難以訓練,也會丟掉一些口頭語言的表現力,不僅是因為語調和非語言表達在文字中丟失,還因為語言模型在文字中的訓練缺少了這些訊號處理模組。

而自監督的語音表示方法能夠從原始音訊中學習離散的單元,可以消除對文字的依賴,研究人員認為Textless NLP可以勝過傳統的複合系統(ASR+NLP),也有可能整合非語言發聲和聲調資訊,在音素之上傳達豐富的語義和語用資訊,而這些資訊通常在文字中無法獲得。

隨著世界變得更加數字化,元宇宙中也包含越來越多由人工智慧驅動的應用程式,這些NPC可以創造新的體驗。而這種全新體驗不止侷限於文字的交流,未來將會走向更流暢的互動方式,如語音和手勢等。

所有這些使用表徵和自我監督學習的進步都有可能幫助研究人員擺脫傳統的基於文字的模型,建立更自然、更有吸引力的未來人工智慧系統。

除了缺乏表現力之外,傳統的NLP應用,依靠大量的文字資源,但在世界上只有少數幾種語言有如此大規模的標註資料。

從長遠來看,相信Textless NLP系統的進步也將有助於使人工智慧對更多人具有包容性,特別是對於那些講沒有標準化書寫系統的語言和方言的人,如方言阿拉伯語或瑞士德語。

參考資料:

https://ai.facebook.com/blog/generating-chit-chat-including-laughs-yawns-ums-and-other-nonverbal-cues-from-raw-audio