編輯:小鹹魚 好睏

【新智元導讀】英偉達似乎把明年要發的新GPU提前自曝了!一個出現在論文裡的神秘顯示卡GPU-N有著779TFLOPs的FP16效能,是A100的2.5倍。非常接近傳聞中比A100強3倍的下一代Hopper GH100。

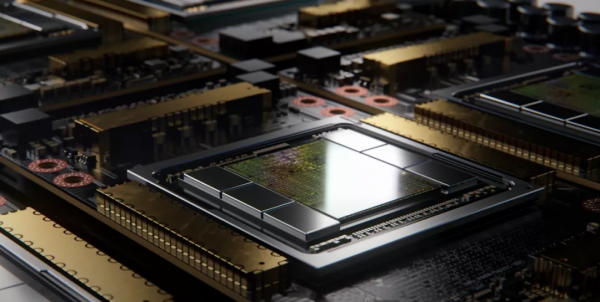

近日,在英偉達團隊發表的新論文中提到了一個神秘的顯示卡:GPU-N。

據網友推測,這很可能就是下一代Hopper GH100晶片的內部代號。

https://dl.acm.org/doi/10.1145/3484505

英偉達在這篇「GPU Domain Specialization via Composable On-Package Architecture」(透過可組合式封裝架構實現GPU領域的專業化)的論文中,談到了下一代GPU設計。

研究人員認為,當前要想提升深度學習效能,最實用的解決方案應該是最大限度地提高低精度矩陣計算的吞吐量。

簡單來說,GPU-N有134個SM單元(A100中為104個SM);8576個CUDA核心(比A100多24%);60MB的二級快取(比A100多50%);2.687TB/秒的DRAM頻寬(可擴充套件至6.3TB/秒);高達100GB的HBM2e(透過COPA實現可擴充套件到233GB),以及6144位記憶體匯流排。

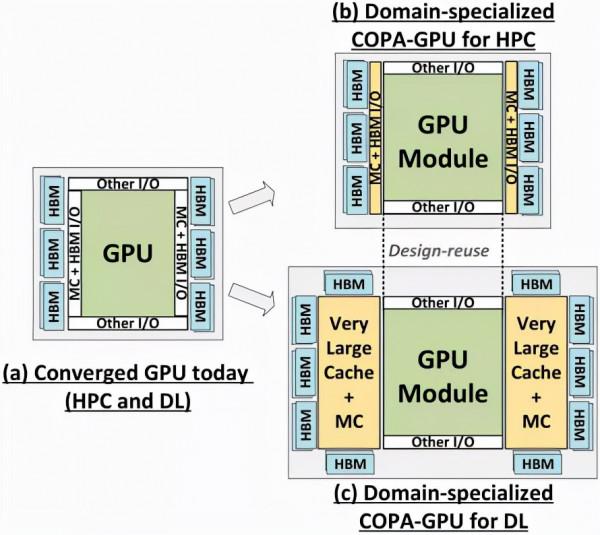

全新COPA-GPU架構

「GPU-N」採用了一種叫COPA的設計。

目前,當GPU以擴大其低精度矩陣計算吞吐量的方式來提高深度學習(DL)效能時,吞吐量和儲存系統能力之間的平衡會被打破。

英偉達團隊最終得出一個結論,基於FP32(或更大)的HPC和基於FP16(或更小)的DL,兩者的工作負載是不一樣的。那麼,執行兩種任務的GPU架構也不應該完全一樣。

而如果非得要求GPU滿足不同的架構要求,去做一個融合設計,會導致任何一個應用領域的配置都不是最優的。

因此,可以給每個領域提供專用的GPU產品的可組合的(COPA-GPU)架構是解決這些不同需求的最實用的方案。

COPA-GPU利用多晶片模組分解,可以做到最大限度地支援GPU模組複用,以及每個應用領域的記憶體系統定製化。

英偉達表示,COPA-GPU可以透過對基線GPU架構進行模組化增強,使其具有高達4倍的片外頻寬、32倍的包內快取和2.3倍的DRAM頻寬和容量,同時支援面向HPC的縮減設計和麵向DL的專業化產品。

這項工作探索了實現可組合的GPU所必需的微架構設計,並評估了可組合架構為HPC、DL訓練和DL推理提供的效能增益。

實驗表明,與一個融合的GPU設計相比,一個對DL任務進行過最佳化的COPA-GPU具有16倍大的快取容量和1.6倍高的DRAM頻寬。

每個GPU的訓練和推理效能分別提高了31%和35%,並在擴充套件的訓練場景中減少了50%的GPU使用數量。

從紙面上的效能來看,「GPU-N」的時鐘頻率為1.4GHz(與A100的理論值相同),可以達到24.2 TFLOPs的FP32(是A100的1.24倍)和779 TFLOPs的FP16(是A100的2.5倍)。

與AMD的MI200相比,GPU-N的FP32的效能還不到一半(95.7 TFLOPs vs 24.2 TFLOPs),但GPU-N的FP16的效能卻高出2.15倍(383TFLOPs vs 779TFLOPs)。

|

規格 |

NVIDIA V100 |

NVIDIA A100 |

GPU-N |

|

SMs |

80 |

108 |

134 |

|

GPU頻率(GHz) |

1.4 |

1.4 |

1.4 |

|

FP32(TFLOPS) |

15.7 |

19.5 |

24.2 |

|

FP16(TFLOPS) |

125 |

312 |

779 |

|

L2快取(MB) |

6 |

40 |

60 |

|

DRAM頻寬(GB/s) |

900 |

1,555 |

2,687 |

|

DRAM容量(GB) |

16 |

40 |

100 |

根據以往的資訊可以推斷,NVIDIA的H100加速器將基於MCM解決方案,並且會基於臺積電的5nm工藝。

雖然不知道每個SM中的核心數量,但如果依然保持64個的話,那麼最終就會有18,432個核心,比GA100多2.25倍。

Hopper還可以利用更多的FP64、FP16和Tensor核心,這將極大地提高效能。

GH100很可能會在每個GPU模組上啟用144個SM單元中的134個。但是,如果不使用GPU稀疏性,英偉達不太可能達到與MI200相同的FP32或FP64 Flops。

此外,論文中還談到了兩種基於下一代架構的領域專用COPA-GPU,一種用於HPC,一種用於DL領域。

HPC變體採用的是非常標準的設計方案,包括MCM GPU設計和各自的HBM/MC+HBM(IO)晶片,但DL變體真的是一個很特殊的設計。

DL變體在一個完全獨立的晶片上安裝了一個巨大的快取,與GPU模組相互連線。具有高達960/1920 MB的LLC(Last-Level-Cache),HBM2e DRAM容量也高達233GB,頻寬高達6.3TB/s。

但是網友表示,英偉達似乎已經決定將重點放在DL效能上,因為FP32和FP64(HPC)效能的增長僅僅是來源於SM數量的增加。

這很可能在最後達不到傳聞中的3倍效能。

鑑於英偉達已經發布了相關的資訊,Hopper顯示卡很可能會在2022年GTC的大會上亮相。

規格預測

|

Tesla V100 (SXM2) |

NVIDIA A100 (SXM4) |

NVIDIA H100 (SMX4?) |

|

|

GPU |

GV100 (Volta) |

GA100 (Ampere) |

GH100 (Hopper) |

|

製程 |

12nm |

7nm |

5nm |

|

電晶體 |

21.1億 |

54.2億 |

TBD |

|

晶片尺寸 |

815平方毫米 |

826平方毫米 |

TBD |

|

SMs |

80 |

108 |

134 |

|

TPCs |

40 |

54 |

TBD |

|

FP32 CUDA核心 |

5120 |

6912 |

8576 |

|

FP64 CUDA核心 |

2560 |

3456 |

4288 |

|

張量核心 |

640 |

432 |

TBD |

|

紋理單元 |

320 |

432 |

TBD |

|

頻率 |

1530 MHz |

1410 MHz |

~1400 MHz |

|

TOPs(DNN/AI) |

125 TOPs |

1248 TOPs |

TBD |

|

FP16計算 |

30.4 TFLOPs |

312 TFLOPs |

779 TFLOPs |

|

FP32計算 |

15.7 TFLOPs |

19.4 TFLOPs |

24.2 TFLOPs |

|

FP64計算 |

7.80 TFLOPs |

19.5 TFLOPs |

24.2 TFLOPs |

|

視訊記憶體型別 |

4096-bit HBM2 |

6144-bit HBM2e |

6144-bit HBM2e |

|

視訊記憶體容量 |

16 GB @ 900 GB/s |

最高 40 GB @ 1.6 TB/s 最高 80 GB @ 1.6 TB/s |

最高 100 GB @ 2.687 TB/s |

|

L2快取 |

6144 KB |

40960 KB |

81920 KB |

|

TDP |

300W |

400W |

~450-500W |

參考資料:

https://wccftech.com/mysterious-nvidia-gpu-n-could-be-next-gen-hopper-gh100-in-disguise-with-134-sms-8576-cores-2-68-tb-s-bandwidth-simulated-performance-benchmarks-shown/