作者 | Doreen

01 介紹

深度學習的飛速發展為影象處理帶來技術突破的同時,也為虛假影象和影片的泛濫創造了條件。

利用深度學習演算法偽造的影象和影片很難用肉眼區分出來,若這些影象和影片被不良分子利用,將對社會和個人造成一定的損失。

因此,尋找一個有效的演算法識別偽造的影象和影片顯得尤為重要。

傳統的虛假影片的檢測方法是利用雜湊演算法進行影象檢索,由於相似影片的雜湊編碼相互聯絡緊密,很難區分出細節部分,這給識別工作造成了較大的困難。

針對這個問題,研究人員提出了利用基於vision Transformer模型的影片雜湊檢索方法有效地識別了影片中的可疑部分。

02 相關工作

目前,鑑定深度學習偽造影片的方式主要有兩類,一類是透過偽造內容和源內容在視覺上的不一致性來區分出可疑部分,另一類是藉助兩者不同的資料特徵來區分出偽造目標。

前一種方法用人眼就能清楚地識別偽造內容,但對於偽造技巧高超的目標,僅憑視覺難以準確地區分出可疑部分。

第二種方法雖不依賴視覺特徵,僅利用資料特徵就能識別高質量的偽造影片,但在一些特殊的情況下很難提供有效的證據證明影片的可疑部分。

因此,將視覺特性和資料結合起來成為研究人員關注的焦點。

基於深度學習模型的影象雜湊網路已經在識別偽造影象中取得了較好的成果,但在影片方面的應用比較少。

因此,作者提出將Vision Transformer模型與影片雜湊檢索法結合起來用於標註影片中的可疑部分。

03 方法

1、訓練影片的雜湊中心

將高維度的資料在漢明空間中轉換成緊湊的二進位制雜湊編碼後可以高效地進行資料儲存和檢索。因此,有效地對影片進行雜湊編碼是影片鑑別的首要條件。

作者首先將1個源影片和一組偽影片送入vision Transformer模型令其生成雜湊中心集。

vision Transformer的結構如圖1(a)所示,包括2個Transformer編碼模組和2個相似的注意力模組分支(即雜湊分支和鑑別器)。

第一個Transformer編碼器主要是對影片的空間資訊進行編碼,第二個模組則是對影片的時間資訊進行編碼。

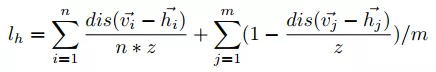

編碼後的資料透過其中一個分支的tanh函式生成了一個雜湊編碼集並將其二值化為雜湊中心集,如公式(1)所示,z是雜湊編碼的長度,x是雜湊編碼。

相比靜態的影象,影片在隨機載入的過程中生成雜湊中心集比較困難。

為了解決這個問題,作者將模型的輸入調整為1個源影片和2個偽影片。

為了評價雜湊中心集的準確性,作者在另一個分支的鑑別器模組中借用K-means演算法中的損失函式(如公式(2))來衡量每輪訓練後的損失。

其中n是標記為不同標籤的不同種類的樣本數量,m是標記為同種標籤的同一類別的樣本數量,v是雜湊中心,h是雜湊編碼。

該損失函式的設計思想是儘可能擴大不同類別的雜湊編碼差異,同時減小同一類別的雜湊編碼差異。

圖1 ViHash與Generator模組的結構圖(圖片來自論文:Vision Transformer Based Video Hashing Retrieval for Tracing the Source of Fake videos. https://arxiv.org/abs/2112.08117)

2、利用生成器標記影片的可疑部分

使用vision Transformer訓練影片的雜湊中心雖然可以識別出偽造的影片,但雜湊中心缺乏影片的空間資訊,難以標記偽造影片的可疑部分。

因此,作者提出使用Generator模組對偽造部分進行精確定位(即標記可疑部分)。

Generator模組包括一個Encoder和一個Decoder(如圖1(b)所示),兩者分別由4個卷積層組成。

為了進一步強化空間資訊,在這兩者之間加入了兩個Transformer block(結構如圖1(c)所示)。在Decoder模組中,作者使用了上取樣使被標記的可疑部分的細節更豐富。

文中,作者使用了公式(3)描述了被標記的部分。

其中,i是影片的幀數,f是偽造影片,s是源影片,g(x)是一個將每幀影象的畫素對映到0至255之間的函式,λ是一個與影片相關的常量(不同影片的λ不同)。

04 實驗

由於偽造影片的數量有限,作者採用DeepFace-Lab,Faceswap,Faceswap-GAN,Recycle-GAN和ALAE這5種方法生成了一個包含200個影片(一共5558774幀)的DFTL(Deepfake Tracing and Localization)資料集,然後對比ViTHash模型與CSQ方法在檢索相似影片方面的準確率。

為了進一步定位偽造影片的可疑區域,作者採用FGVC、DFGVI、STTN、OPN、CPNET和DVI這6種方法擴充套件了公開資料集DAVIS2016,生成了200個訓練集和100個測試集的偽造影片(一共33550幀),並將Generator模型與DMAC方法進行了對比。

1、雜湊編碼的長度與鑑別準確率的關係

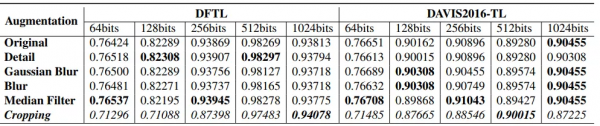

準確的雜湊編碼是識別偽造影片的前提,為了說明雜湊編碼的長度與實驗結果的關係,作者將幾種偽造的影片進行64bit至1024bit的雜湊編碼,並對比了雜湊編碼長度與鑑別結果之間的關係,如表1所示。

表1 雜湊編碼長度與鑑別準確率的關係(表格來自論文:Vision Transformer Based Video Hashing Retrieval for Tracing the Source of Fake videos.https://arxiv.org/abs/2112.08117)

從表1可以清楚地看出,在相同長度的雜湊編碼下,鑑別各類偽造影片的準確率變化不大。

隨著雜湊編碼的長度增加,鑑別準確率也隨之提高。但到了1024bit時,準確率有所下降。

由此可以得出512bit的雜湊編碼是比較合適的選擇。

2、與現有的其他方法的對比

與作者提出的VTL(Video Tracing and Tampering Localization)方法類似,CSQ (Central Similarity Quantization)是透過生成雜湊中心對影象、影片進行檢索。

從表2的結果來看,CSQ在DFTL資料集上對相似影片的鑑別率小於10%,VTL透過對雜湊中心的訓練則能達到98.2%。

在IOU這個指標上,VTL與DMAC方法在DFTL和DAVIS2016-TL兩個資料集上都表現不佳,尤其是在DFTL資料集上,DMAC僅有0.06。

表2 VTL與現有方法的結果對比(表格來自論文:Vision Transformer Based Video Hashing Retrieval for Tracing the Source of Fake videos.https://arxiv.org/abs/2112.08117)

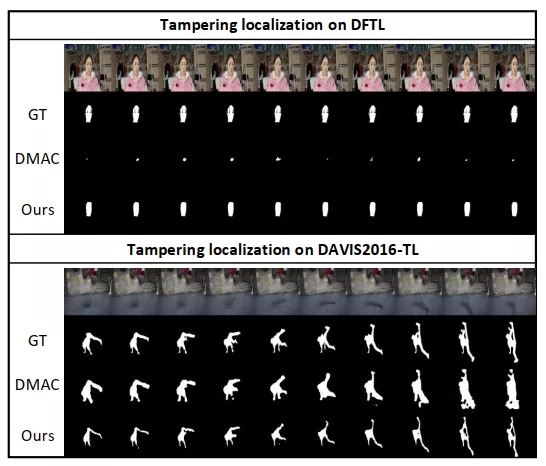

為了進一步視覺化結果,作者展示了DMAC和VTL方法對影片可疑部分的標記影象,如圖2所示。

從圖2中可以清楚地看出兩者在DFTL資料集上都不能有效地提取出可疑目標;在DAVIS2016-TL資料集上,VTL提取的目標比DMAC有更豐富的細節。

圖2 標記幾幀影象的可疑區域(圖片來自論文:Vision Transformer Based Video Hashing Retrieval for Tracing the Source of Fake videos.https://arxiv.org/abs/2112.08117)

05 結論

在傳統鑑偽的基礎上,作者提出了將基於視覺特性和基於資料特性的方式結合起來的VTL方法定位影片的可疑部分。

首先透過ViTHash模型生成影片的雜湊中心,並與源影片的雜湊中心進行對比,鑑別是否為偽造影片。

然後利用Generator模型的卷積模組和Transformer模組進一步強化畫素的空間資訊,將源影片與偽造影片進行精確對比從而找到兩者不同的部分。

透過實驗發現,利用ViTHash+Generator的VTL方法雖然能準確地鑑定出虛假影片,但在標記其可疑部分方面則效果不佳。

為了解決這個問題,可以考慮根據源影片的內容提取特定的特徵對其進行資料增廣,並將其與偽造影片的類似內容進行對比,進而更精準地標記出偽造部分。

參考文獻

1. Vision Transformer Based Video Hashing Retrieval for Tracing the Source of Fake videos. https://arxiv.org/abs/2112.08117

2. L. Yuan et al., "Central Similarity Quantization for Efficient Image and Video Retrieval," 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020, pp. 3080-3089

3. P. Zhuang, H. Li, S. Tan, B. Li and J. Huang, "Image Tampering Localization Using a Dense Fully Convolutional Network," in IEEE Transactions on Information Forensics and Security, vol. 16, pp. 2986-2999, 2021

私信我領取目標檢測與R-CNN/資料分析的應用/電商資料分析/資料分析在醫療領域的應用/NLP學員專案展示/中文NLP的介紹與實際應用/NLP系列直播課/NLP前沿模型訓練營等乾貨學習資源。