編輯/綠蘿

我們生活在大資料時代。我們每天產生的大量資訊在科學技術、經濟和管理的各個領域都有重要的應用。例如,現在越來越多的公司從多個來源收集、儲存和分析大規模資料集,以獲得業務洞察力或衡量風險。

然而,這些大型或海量資料集通常無法用獨立計算機處理,這在計算方法和統計理論方面對傳統的資料分析提出了新的挑戰。

近日,華東師範大學教授周與香港中文大學的研究人員開發了一種新演算法——「分而治之」,有望解決這些計算問題。

該研究以「Linear expectile regression under massive data」為題,發表在 KeAi 期刊《Fundamental Research》上。

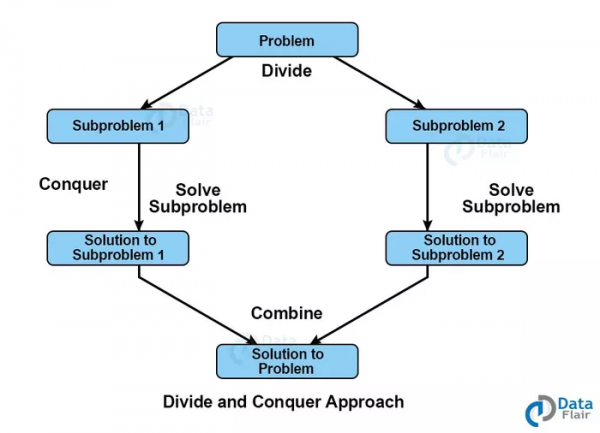

該研究作者之一週勇教授解釋說:「最先進的數值演算法已經存在,例如最優子取樣演算法和分治法。與對小規模、資訊量大的資料點進行取樣的最優子取樣演算法相比,分治法將大資料集隨機劃分為子資料集,並在多臺機器上分別處理。雖然分治法在使用計算資源提供大資料分析方面是有效的,但在整合結果時通常需要一種強大而高效的元方法。」

在這項研究中,研究人員專注於線性期望迴歸模型的大規模推理,該模型在風險管理中具有廣泛的應用。他們提出了一種通訊有效的分而治之的演算法,其中來自子系統的彙總統計資料與置信度分佈相結合。周教授解釋說:「這是一種強大而有效的整合結果的元方法。更重要的是,我們研究了機器數量和樣本量之間的關係。我們發現對機器數量的要求是統計準確性和計算效率之間的權衡。」

周教授補充說:「我們相信我們開發的演算法可以極大地幫助解決大規模資料帶來的計算挑戰。」

論文連結:https://doi.org/10.1016/j.fmre.2021.08.012

相關報道:https://www.eurekalert.org/news-releases/936932