作者:董婉萍 溫剛

編輯:好睏

【新智元導讀】近年來,機器學習頂會論文數目井噴,審稿壓力巨大,其同行評審制度備受質疑。賓大教授針對此挑戰提出了由論文作者協助的新型同行評審機制。

你是否已經受夠了NeurIPS,ICLR,ICML等會議的審稿意見?

你是否有過最好的論文被拒稿,但是相對差的論文反而被接收的經歷?

相信對眾多機器學習、人工智慧領域的從業者來說,這種現象已經見怪不怪了。

人工智慧專家Ian Goodfellow在Twitter上抱怨同行評審(peer review)

機器學習的成功依賴於大型會議,這一領域發展非常迅速。而期刊審稿週期相對較長,因此大部分最新的工作都首先發表在會議上,像NeurIPS,ICLR,ICML等,這對機器學習的發展壯大起了很重要的作用。

一般來說,學術會議會邀請某一領域的專家審稿 - 即透過同行評審制度 - 決定論文是否值得發表。可以說,頂會現在的成功,很大程度上也要歸功於同行評審制度。

反之,如果研究工作不經過可靠的同行評審就發表,可能會帶來許多問題:大多數人,即非專家,無法分辨研究結果的好壞對錯;也會對研究造成混亂,後人可能會引用錯誤的結果、結論,這無疑也會阻礙機器學習領域研究的進步。

因此,隨著研究人員及論文的數量成倍增加,同行評審的可靠性在今天變得更加重要。對這一制度可靠性的分析和相關的改進方法,也漸漸成為一個熱門話題,並引起學術界和業界的關注。

如何改進同行評審的機制,提高審稿流程的可靠性呢?

近日,賓夕法尼亞大學沃頓商學院和計算機系的蘇煒傑教授在今年NeurIPS上發表的一篇文章為改進同行評審提供了新的思路,提出一個簡單實用的方法,結合了統計和最佳化的思想。

該研究認為,既然增加審稿人數,或給每個審稿人分配更多的論文不現實,那我們可以要求投稿作者提供資訊來協助我們決策,「人盡其才,物盡其用」。然而,又要保證投稿人不會為了自身利益提供不實資訊。 那麼, 應該如何設計這一機制呢?

論文地址:https://arxiv.org/abs/2110.14802

蘇煒傑教授針對性地提出了一種新機制:保序機制(Isotonic Mechanism),並從理論上保證了該機制既能激勵投稿人提供真實的資訊,又能增加審稿結果的可靠性。

背景

正所謂「成也蕭何,敗也蕭何」,同行評審本應是高質量、高影響力研究的過濾器。然而,隨著近年來人工智慧和機器學習會議大火,投稿數量激增,同行評審制度似乎有一點變味了。

例如,在2014年著名的NeurIPS實驗中,人們觀察到評審分數具有驚人的高度隨意性。從理論上講,如果重新審稿,NeurIPS 2014年錄用的一半以上的文章將被拒稿!

2014NeurIPS實驗中第二組委員會對第一組委員會評審意見的結果,

隨機選擇的被第一組接受的論文中,50.9%被第二組拒絕

究其原因,是海量的投稿導致專業審稿人員數量不足,會議不得不讓很多沒發過論文的新手來審。以及人均審稿數目增加,使得審稿人員在每篇論文上花費的時間大大減少,一篇論文往往幾分鐘時間就被判了死刑!

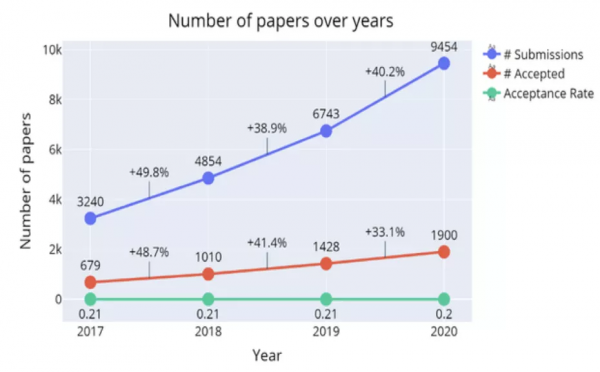

像NeurIPS這一機器學習頂會的投稿量已經從2014年的1673篇增長到今年的9122篇,很多研究人員個人就提交了10篇甚至更多,然而合格的審稿人增長數量根本不可能這麼快。

這導致同行評審的質量直線下降,飽受詬病,無法達到它的初衷。如果不改革同行評審制度,從長遠來看,勢必會削弱公眾對機器學習的信心,也會阻礙人工智慧的發展。

ML/AI會議論文的爆炸式增長

海報地址:http://www-stat.wharton.upenn.edu/~suw/paper/iso_poster.pdf

當然,學術界早已注意到同行評審制度的相關缺陷,也提出了一些改進的舉措:從志願審稿改為僱傭審稿,或者更加公開的評審(如ICLR在OpenReview上進行審稿),等等。然而,它們要麼不切實際,要麼會帶來新的問題。

同行評審仍然是「可用的最差系統」。

保序機制(Isotonic Mechanism)簡介

假設投稿人投出了n篇論文,其真實分數為R1, R2, …, Rn,假設投稿人知道這些真實分數的排序(數學上表示為1, 2, …, n的置換)。

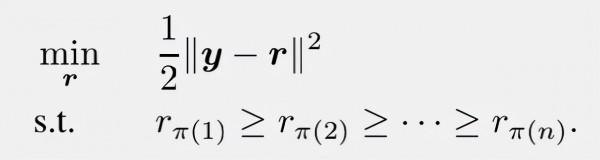

那麼,機制要求投稿人彙報自己對這n篇論文打分的排序π,再結合審稿人給出的原始平均分數y1, y2, …, yn,解一個凸問題並給出最終分數。

形式上,這個凸最佳化問題為:

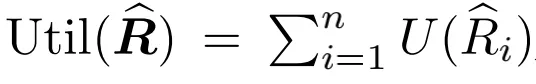

另外,該機制還假設投稿人是理性的。即投稿人彙報排序π的最終目的是讓自己的利益最大化。數學上,表現為投稿人希望機制得出的最終分數可以最大化如下效用函式:

這裡假設U是一個不減凸函式。

保序機制的理論保證

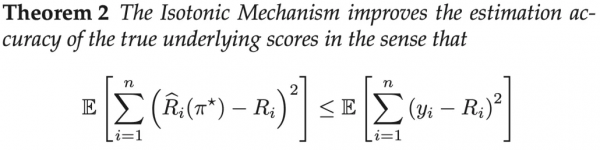

我們先將對假設的介紹和對合理性的討論稍稍後放,以便於突出文章的主要結果,也就是保序機制相對於原始分數在理論上的優越性:

1. 投稿人的最佳策略是如實報告他/她的論文原始分數的真實排序;甚至在投稿人不能完全確定所有真實分數排序時,報告所知道的所有真實資訊也是其最優選擇。

2. 機制所提供的調整後的最終分數確實嚴格地比審稿人提供的原始分數要準確。

僅僅是彙報分數的排序,就會提高準確度,其實用性不言而喻。不僅如此,文章作者還進一步對更一般的情況做了推廣,文章對投稿人只知道真實分數的分塊排序、機制的穩健性(魯棒性)、效用函式不能表示成n個論文各自效用之和的三種情況進行拓展討論,充分的展示了保序機制強大的校正功能,以及豐富的現實意義。

到這裡,我們再回頭看一下假設。除了對函式U的要求,還要求投稿人自己對真實資訊必須有一定的瞭解(這樣才能進行協助),以及審稿人打分相對真實分數的噪聲在置換下的分佈是不變的(可交換性)。這些假設也都是比較實際的。

需要格外注意函式U是凸的假設,對以上結論的成立是至關重要的。這似乎與傳統經濟學理論中的邊際效益遞減矛盾。但這裡效用衡量的不是「量」的大小,而是決定了論文是否會被作為海報、口頭報告,甚至是全會報告的分數。對很多研究者,追求會議論文更大的影響力反映了他們真實的需求,因此效用函式的凸性有其合理性。

保序機制的提出背景

保序機制(Isotonic Mechanism)命名的由來是因為對應的凸問題正是統計學中「保序迴歸(Isotonic Regression)」的問題形式。

保序迴歸在觀念上是尋找一組非遞減的片段連續線性函式,即保序函式,使其與樣本儘可能的接近。

保序迴歸:https://en.wikipedia.org/wiki/Isotonic_regression

另一方面,這篇文章寫完提交NeurlPS後不久,大會組織者要求所有作者對他們的文章做一個質量排序,這與保序機制不謀而合。這篇文章非常「及時」,儘管最後並沒有用它在今年NeurIPS來做決定。

文章與NeurIPS 2021會議的巧合

值得注意的是,提出該機制的蘇煒傑教授差不多有半數文章發表在統計、最佳化和資訊理論等領域的期刊,也有大量論文發表在機器學習頂會上,對二者的審稿質量以及錄用文章質量的差異深有體會。

一般來說,擁有巨量投稿數量的機器學習頂會的錄用文章平均質量要比期刊差很多。同時機器學習的一個特點是一個作者或研究組經常一次提交多篇論文,比如強化學習研究員Sergey Levine向ICLR 2020一次就提交了32篇論文!而保序機制的理論也表明文章數目n越大,提升也越大。

值得注意的是,保序機制的理論證明用到了凸函式和優超不等式等不少數學技巧,熟悉數學競賽的同學想必不會陌生。

總結與展望

本文提出了透過利用投稿人提供的資訊改進同行評審制度的「保序機制」,即激勵投稿人報告真實的排序,從而獲得更好的決策。

該機制便於實施,且具有理論的最優性保證,如果能在現實中使用該機制,很有希望在一定程度上緩解當前的機器學習頂會的低質量評審問題。

然而,利用額外的作者資訊來改善同行評審是一個新型的研究方向,在投入實際應用前還需要一定的努力。對保序機制而言,未來還有一些工作需要完成:

- 雖然效用函式為凸一定程度上符合研究者的偏好,但是對於一些追求中稿數量的研究者,效用函式可能是一些特殊的非凸函式(例如階梯狀的函式)。如何改進技巧應用到這種問題上?

- 當前改進同行評審已經有一些初見成效的工作,如何將他們結合進來?

- 保序機制的準確性是使用L2誤差來衡量的。有沒有更符合實際情況的誤差函式?

- 如何應對投稿人策略性地利用保序機制,例如故意提交低質量論文變相抬高分數?

- 在跨學科評審和多個審稿人多個作者的情況下,如何保證噪聲的可交換性,如何對應修改保序機制?

- 保序機制要求提供論文質量的排序是否有附帶好處?比如要求作者對自身論文質量有更清楚的認識,或許會減少會議論文常見的「guest authorship」。

無論如何,該機制針對的是一個有關機器學習領域前途的重大問題。如果該問題能解決,將產生巨大的影響力,甚至可以將這種評級制度出圈應用到各種評價環節,具有十分重大的現實意義。

作者簡介

文章作者蘇煒傑是賓夕法尼亞大學沃頓商學院統計與資料科學系和工學院計算機系助理教授。任賓大機器學習研究中心聯合主任。分別於北京大學和斯坦福大學獲得本科和博士學位。曾獲得NSF CAREER Award和斯隆研究獎。

參考資料:

https://arxiv.org/pdf/2110.14802.pdf

https://www.toutiao.com/i7039916197835506209/?timestamp=1639147753&app=news_article&group_id=7039916197835506209&use_new_style=1&req_id=202112102249130101310380762754C599&wid=1639647590857

https://arxiv.org/pdf/2109.09774.pdf

https://www.reddit.com/r/MachineLearning/comments/r24rp7/d_peer_review_is_still_broken_the_neurips_2021/

https://hub.baai.ac.cn/view/10481

https://zhuanlan.zhihu.com/p/90666675

https://cloud.tencent.com/developer/article/1172713

http://eprints.rclis.org/39332/