編輯:LRS 好睏

【新智元導讀】以後再也不能說人類比AI還懂常識了!最近由微軟黃學東坐鎮,清華姚班畢業生髮布了一個新系統KEAR,成功刷榜各大常識問答排行榜,常識問答效能首次超越人類,甚至非英文的常識他也懂!

AI模型一直為人詬病的一點就是隻會「死學習」,只能根據給定的訓練樣本來進行預測,稍微問一點「常識性」的問題它都回答不了。

比如你問GPT-3:太陽有幾個眼睛?

它會毫不猶豫的告訴你:當然是一個眼睛!

雖然常識資訊沒有體現在輸入文字中,但如果不懂常識的話,那回答只能是驢唇不對馬嘴。

為了解決這類常識性錯誤,研究人員藉助ConceptNet建立了一個專門針對常識問答的資料集CommonsenseQA,要求模型必須得了解常識才能夠正確回答問題。

每個問題包含五個候選答案,其中有兩個是干擾項,對AI模型來說屬於是難上加難了。

例如給定一個問題:你的狗喜歡吃什麼?(What is a treat that your dog will enjoy?)

候選答案可能是沙拉(salad)、撫摸(petted)、喜愛(affection)、骨頭(bone)、關心(lots of attention)等。人在與狗交往的過程中,可以瞭解到大部分狗都喜歡吃骨頭,從而推理出你的狗在候選答案中也更傾向於骨頭,但AI模型並不懂。

所以想要正確回答這個問題,必須要懂得如何利用外部知識。

然後CommonsenseQA的作者拿了一個當時橫掃各大排行榜的模型BERT-LARGE來做測試,結果慘不忍睹,準確率只有55.9%,而人類的回答準確率已經達到了88.9%了。

時間來到三年後,最近來自微軟的華人團隊發表了一篇論文,提出了一個KEAR(Knowledge External Attention for commonsense Reasoning)系統,將CommonsenseQA常識問答的效能抬到了新高度,準確率達到89.4%,成功超越人類,堪稱AI常識領域的里程碑模型了。

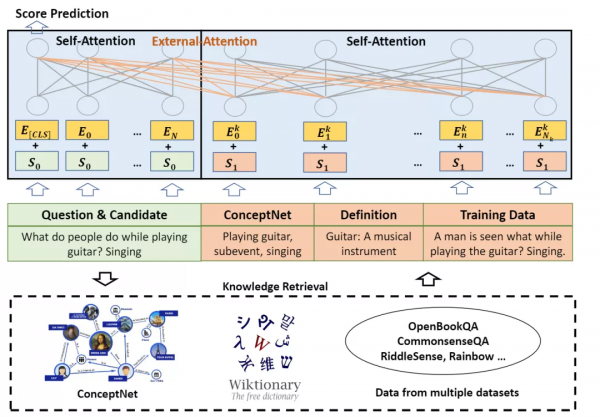

相比傳統AI模型需要大規模資料來訓練,這篇論文提出了一種外部注意力機制(external attention mechanism)來增強Transformer架構,能夠把外部知識資訊整合到預測的過程中,從而減少了模型對大引數量的需求,讓AI系統更加民主化(democratization),也就是說可以降低AI模型研究的門檻,不用從老黃那買特別多的顯示卡,也能實現SOTA效能。

大體來說,KEAR模型在回答「你的狗喜歡吃什麼」這個問題的時候,它會首先從ConceptNet實體鏈中檢索出「狗— desires — petted, affection, bone, lots of attention」,這樣就排除了一個錯誤答案沙拉。

然後KEAR會從Wiktionary中檢索出骨頭的定義:構成大多數脊椎動物骨架的複合材料(a composite material making up the skeleton of most vertebrates);

從CommonsenseQA資料集中的訓練資料中檢索出「狗喜歡吃什麼?骨頭」(What do dogs like to eat? bones)。

再將檢索到的知識和輸入的知識進行級聯後,KEAR將其作為DeBERTa模型的輸入,最後可以推理出正確答案:骨頭!

可以看到,對於人類來說最簡單的一個問題,AI模型要完成卻需要大量的外部資訊才能正確回答。

由於CommonsenseQA只是英文常識問答的資料,文中還探索了一下其他語言的常識推理是否依然有效。

研究人員首先將非英語問題翻譯成英語,然後在英語的語料資料中檢索知識,然後將知識文字翻譯成源語言,經過外部注意力機制後再翻譯獲得答案,即翻譯-檢索-翻譯(TRT)。

結果也是在X-CSR基準上的兩個任務X-CODAH和X-CSQA都取得了第一名。

不止於自注意力

時至今日,大部分AI模型基本都在源文字上使用自注意力機制,透過把大量的資料餵給模型進行訓練,從而使模型記住輸入的文字。

雖然Transformer的效果很好,但缺點也很明顯:

- 時間和空間複雜度太高,需要大量的顯示卡和視訊記憶體

- 資料量不夠的情況下,Transformer表現不夠好

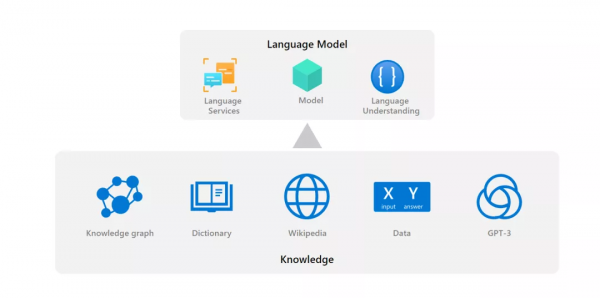

另一方面,Transformer本質上還是黑盒模型,沒辦法讓他像人類一樣進行文字理解和推理,知道AI為什麼產生這樣的預測是很重要的,KERA透過利用知識圖譜、字典和公開可用的機器學習資料的常識性知識,能夠一定程度地反應答案的來源及模型推理過程。

外部注意力的實現方法也很簡單,將輸入(input)和知識(knowledge)級聯起來作為新的輸入,然後將整體作為H0經過自注意力機制即可。

其中K(nowledge)的來源包括知識圖譜ConceptNet, 字典和訓練資料。

可以看到,自注意力和外部注意力的主要區別就是輸入是否只來源於輸入文字,即透過向外部注意力機制提供不同來源的相關背景和知識,包括知識圖譜、字典、語料庫和其他語言模型的輸出,然後讓模型同時對輸入進行自注意力和對知識進行外部注意力,就能達到引入外部知識的效果。

引入的外部資訊以符號(symbol)的方式儲存,如純文字或知識圖譜條目,從而能夠提升Transformer在語言理解方面的能力。

並且KEAR使用的輸入和知識的文字級聯不會對Transformer模型結構產生任何改變,使現有的系統可以很容易地使用外部注意力。

因為世界上的知識也是在動態變化的,所以外部注意力的另一個好處是,使用者可以很容易地更新知識源來改變模型的預測輸出。

透過引入最新的常識,例如將線上更新的知識圖譜輸入到模型中,可以使模型的決策過程變得更加透明和可解釋。

而用多模組聯合最佳化、加上外注意力引入知識庫也是微軟人工智慧認知服務提質量的核心方向。

作者介紹

文章的第一作者是徐一翀,本科畢業於清華大學姚班,於卡內基梅隆大學取得博士學位,主要研究方向為互動式機器學習,自然語言處理和深度學習。目前是微軟AI Cognitive Services研究組的高階研究員。

朱晨光是微軟認知服務研究組的首席研究負責人。他領導知識和語言團隊,從事文字總結、知識圖譜和麵向任務的對話方面的研發工作。他於2016年在斯坦福大學獲得計算機科學博士學位和統計學碩士學位,在此之前於清華大學姚班獲得計算機科學學士學位。

黃學東是微軟AI認知服務工程和研究團隊的領導人,IEEE/ACM院士(IEEE/ACM Fellow) ,微軟首位「華人全球技術院士」、微軟首席語音科學家、微軟雲計算與人工智慧事業部認知服務團隊全球技術院士/全球人工智慧首席技術官。他先後獲得湖南大學學士學位,清華大學碩士學位和英國愛丁堡大學博士學位。

參考資料:

https://arxiv.org/abs/2112.03254