計算機視覺物件跟蹤涉及估計影片序列中物件的軌跡,並且在自動駕駛汽車、機器人和人機介面等領域具有實際應用。雖然當今越來越深入和複雜的神經網路已經推進了視覺物件跟蹤的最新技術,但在提高跟蹤架構的效率以提高視覺物件跟蹤效能方面所做的工作相對較少。

在新論文 Efficient Visual Tracking with Exemplar Transformers 中,蘇黎世聯邦理工學院的一個研究團隊提出了 Exemplar Transformers,這是一種用於實時視覺物件跟蹤的新型高效轉換器層,比其他基於轉換器的模型快 8 倍。

尺度點積注意(SDPA)與範例注意(EA)之比較。在SDPA中,注意圖(紅色)是一個N × N的矩陣,而在EA中,注意圖的維數可以簡化為S × E矩陣,在我們的實驗中,S=1。在SDPA中,V是輸入X的投影,而在EA中,V對應於透過將輸入X與學習過的矩陣Wv進行卷積計算得到的樣本。樣本X對應於卷積的各自特徵對映。因此,在SDPA中計算單個輸出畫素X'(紫色部分)的計算複雜度為O(N),其中N為序列長度。相比之下,EA中單個輸出畫素的計算具有計算複雜度O(E),在我們的實驗中E =4,遠小於N= HW。

受標準“Scaled Dot Product Attention”泛化的啟發,研究人員提議將 Exemplar Attention 作為提議的 Exemplar Transformer 層次的關鍵構建塊。雖然原始 Transformer 的 self-attention 與影象大小或輸入序列成二次方縮放,但該團隊根據上述假設重新設計了模組的運算元,以減少特徵向量的數量並實現顯著的加速。

研究人員將他們提出的變換器層合併到基於 Siamese 的跟蹤架構 E.T.Track 中,用 Exemplar Transformer 層替換跟蹤器頭中的卷積層。Exemplar Transformer 層增加的表達能力顯著提高了效能和魯棒性,對執行時間的影響可以忽略不計。

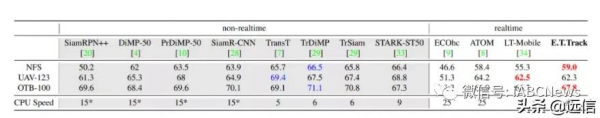

在AUC評分方面,NPS、OTB-100和UAV1資料的總體情況。兩個標記在同一個CPU上。對於這些模型來說,CPU需要的是兩相或兩側的軌跡,它們通常是在這些模型的跟蹤速度(在FPS中)上。

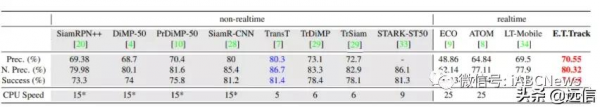

與TrackingNet測試集[24]上最先進的跟蹤器進行比較,該測試集由511個序列組成。根據精度(Prec.)、歸一化精度(N. Prec.)和成功率(AUC評分)的百分比對跟蹤器進行比較。整體最佳分數用藍色突出顯示,而實時最佳分數用紅色突出顯示。既不是基於Transformer也不是被認為是實時跟蹤器的模型的CPU速度由a *表示。因為它們與我們的比較無關,而且它們都使用ResNet-50作為骨幹,所以我們只是簡單地對ResNet-50的前向傳遞進行基準測試,以獲得這些模型的跟蹤速度(在FPS中)的上限。

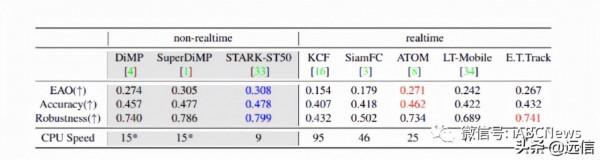

與最先進的VOT-ST2020[19]跟蹤器進行比較。從期望平均重疊(EAO)、精度和魯棒性等方面比較了兩種跟蹤方法。我們只將我們的模型與其他預測跟蹤器進行比較。整體最佳分數用藍色突出顯示,而實時最佳分數用紅色突出顯示。既不是基於轉變器也不是被認為是實時跟蹤器的模型的CPU速度由a *表示。

研究人員在六個基準資料集上將 E.T.Tracker 與當前最先進的方法進行了比較:OTB-100、NFS、UAV-123、LaSOT、TrackingNet 和 VOT2020。所提出的模型取得了令人吃驚的效能,達到了 59.1% 的 AUC 分數(比流行的 DiMP 跟蹤器提高了 2.2%),並且比 LightTrack 的移動的版本高出 3.7%。E.T.Tracker 在精度方面僅落後於基於複雜跟蹤器 TrSiam 2.2%,歸一化精度為 2.32%,AUC 為 3.12%,而在 CPU 上的執行速度提高了近 8 倍。

研究表明,所提出的方案 Exemplar Attention 方法可以產生顯著的加速和成本顯著降低,而 Exemplar Transformer 層可以顯著提高視覺跟蹤模型的魯棒性。該團隊認為 E.T.Track 也是第一個基於跟蹤架構,能夠在計算受限的裝置(例如標準 CPU)上實時執行。