來源:Github

編輯:David

【新智元導讀】2021年是人工智慧繼續突飛猛進的一年。近日,Github上有人總結出了今年最有趣、最驚豔的38篇關於AI和機器學習論文,值得收藏。

1、Zero-Shot Text-to-Image Generation

https://arxiv.org/pdf/2102.12092.pdf

文字到影象的生成傳統上側重於為固定資料集的訓練尋找更好的建模假設。本文描述了一種基於Transformer的簡單方法來完成此任務,將文字和影象標記自迴歸建模為單個數據流。憑藉足夠的資料和規模,當以零樣本方式進行評估時,我們的方法與以前的特定領域模型相比具有競爭力。

2、VOGUE: Try-On by StyleGAN Interpolation Optimization

https://vogue-try-on.github.io/static_files/resources/VOGUE-virtual-try-on.pdf

給定目標人物的影象和穿著服裝的另一個人的影象,我們會自動生成給定服裝中的目標人物。我們方法的核心是姿勢條件 StyleGAN2 潛在空間插值,它無縫地結合了每個影象的興趣區域,即體型、頭髮和膚色來自目標人物,而帶有褶皺的服裝 、材料屬性和形狀來自服裝影象。

3、Taming Transformers for High-Resolution Image Synthesis

https://compvis.github.io/taming-transformers/

本文將 GAN 和卷積方法的效率與Transformer的表達能力相結合,為語義引導的高質量影象合成提供了一種強大且省時的方法。

4、Thinking Fast And Slow in AI

https://arxiv.org/abs/2010.06002

本文從人類能力中汲取靈感,提出了走向更通用和更值得信賴的人工智慧(AGI)和人工智慧研究社群的 10 個問題。

5、Automatic detection and quantification of floating marine macro-litter in aerial images

https://doi.org/10.1016/j.envpol.2021.116490

來自巴塞羅那大學的研究人員開發了一種基於深度學習的演算法,能夠從航拍影象中檢測和量化漂浮的垃圾。他們還製作了一個面向網路的應用程式,允許使用者在海面影象中識別這些垃圾。

6、ShaRF: Shape-conditioned Radiance Fields from a Single View

https://arxiv.org/abs/2102.08860

試想一下,如果只拍攝物件的照片並將其以 3D 格式插入到您正在建立的電影或影片遊戲中,或者插入到 3D 場景中進行插圖,那該有多酷。

7、Generative Adversarial Transformers

https://arxiv.org/pdf/2103.01209.pdf

本文利用了強大的 StyleGAN2 架構中Transformer的注意力機制,使其更加強大!

8、We Asked Artificial Intelligence to Create Dating Profiles. Would You Swipe Right?

https://studyonline.unsw.edu.au/blog/ai-generated-dating-profile

你會在 AI 的個人資料頁面上仔細檢視嗎?你能區分真人與機器嗎?這項研究揭示了在約會應用程式上使用AI,會發生什麼事情。

9、Swin Transformer: Hierarchical Vision Transformer using Shifted Windows

https://arxiv.org/abs/2103.14030v1

Transformers 會取代計算機視覺中的 CNN 嗎?在不到 5 分鐘的時間內,你就可以透過這篇關於 Swin Transformer 的新論文,瞭解如何將 Transformer 架構應用於計算機視覺任務。

10、IMAGE GANS MEET DIFFERENTIABLE RENDERING FOR INVERSE GRAPHICS AND INTERPRETABLE 3D NEURAL RENDERING

https://arxiv.org/pdf/2010.09125.pdf

本文提出了名為 GANverse3D 的模型,只需要一張影象,就可以建立可以自定義和動畫的 3D 影象。

11、Deep nets: What have they ever done for vision?

https://arxiv.org/abs/1805.04025

本文將公開分享有關用於視覺應用的深度網路、它的成功之處,以及我們必須解決的侷限性等一切內容。

12、Infinite Nature: Perpetual View Generation of Natural Scenes from a Single Image

https://arxiv.org/pdf/2012.09855.pdf

檢視合成的下一步,就是永久檢視生成,目標是創造出一張能夠飛入其中的圖片,還能在影象內的美景進行探索!

13、Portable, Self-Contained Neuroprosthetic Hand with Deep Learning-Based Finger Control

https://arxiv.org/abs/2103.13452

本文提出了一種由人工智慧驅動的神經介面,截肢患者可以以栩栩如生的靈巧和直覺來控制神經假肢。

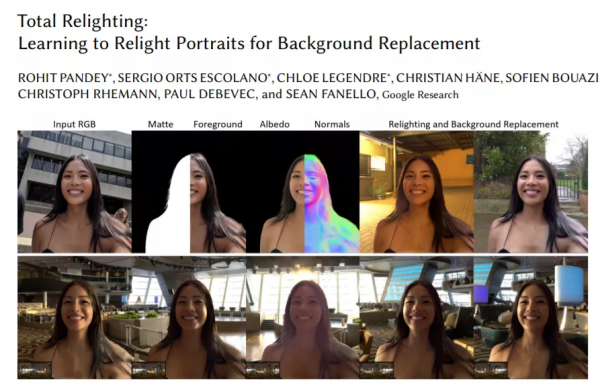

14、Total Relighting: Learning to Relight Portraits for Background Replacement

https://augmentedperception.github.io/total_relighting/total_relighting_paper.pdf

你有沒有想過改變圖片的背景,但讓它看起來很逼真?這並不簡單。你不能只是在家裡拍一張自己的照片,然後換成海灘背景。圖片看起來會很假,任何人都會馬上看出「這是PS的」。本文提出的方法可能會完美解決這個問題。

15、LASR: Learning Articulated Shape Reconstruction from a Monocular Video

https://openaccess.thecvf.com/content/CVPR2021/papers/Yang_LASR_Learning_Articulated_Shape_Reconstruction_From_a_Monocular_Video_CVPR_2021_paper.pdf

本文提出一種方法,可以僅以短影片作為輸入,生成人類或動物移動的 3D 模型。事實上,模型實際上明白,生成的目標是一個奇怪的形狀,可以移動,但仍然需要和原影片保持附著,因為這仍然是「一個目標」,而不僅僅是多目標的集合。

16、Enhancing Photorealism Enhancement

http://vladlen.info/papers/EPE.pdf

本文中,英特爾的研究人員提出一個 AI模型,可實時應用於影片遊戲,並讓每一幀影象看起來更自然。

如果你認為這「只是另一個 GAN」,將影片遊戲的圖片作為輸入,並按照自然世界的風格對其進行修改,其實並非如此。你可以在遊戲圖形上花費更少的精力,使其穩定和完整,然後使用此模型改進圖形風格。

17、DefakeHop: A Light-Weight High-Performance Deepfake Detector

https://arxiv.org/abs/2103.06929

如何在 2021 年準確識別Deepfake假影片?這篇新論文可能會提供答案。可能是「再次使用人工智慧」。以後,「眼見為實」可能很快就會變成「AI說真才是真」。

18、High-Resolution Photorealistic Image Translation in Real-Time: A Laplacian Pyramid Translation Network

https://arxiv.org/pdf/2105.09188.pdf

本文提出一種基於機器學習的新方法,實時將任何樣式的影象翻譯成指定風格的 4K 影象!

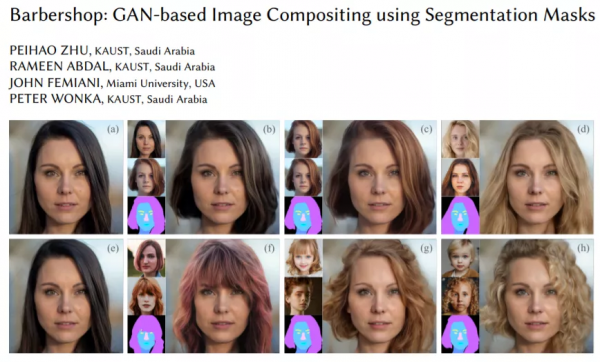

19、Barbershop: GAN-based Image Compositing using Segmentation Masks

https://arxiv.org/pdf/2106.01505.pdf

這篇文章本身並不是一項新技術,而是關於 GAN 的一個令人興奮的新應用。這個 AI 可以改變你的髮型,看看改變前後的對比吧。

20、TextStyleBrush: Transfer of text aesthetics from a single example

https://arxiv.org/abs/2106.08385

2021年,在異國旅行的你走進一家餐館,面對看不懂的選單,你甚至不需要開啟谷歌翻譯,只要簡單地使用 Facebook AI 的這篇文章中的新模型,就可以翻譯選單影象中的每個文字。

21、Animating Pictures with Eulerian Motion Fields

https://arxiv.org/abs/2011.15128

本文中的AI模型拍攝一張照片,瞭解哪些粒子應該在移動,並將圖片轉換為無限迴圈的動畫,同時完全保留圖片的其餘部分,創建出逼真的影片。

22、CVPR 2021最佳論文獎: GIRAFFE - Controllable Image Generation

http://www.cvlibs.net/publications/Niemeyer2021CVPR.pdf

本文使用修改後的 GAN 架構,可以在不影響背景或其他目標的情況下移動影象中的目標。

23、GitHub Copilot & Codex: Evaluating Large Language Models Trained on Code

https://arxiv.org/pdf/2107.03374.pdf

OpenAI 的這個新模型,可以從單詞生成程式碼。

24、Apple: Recognizing People in Photos Through Private On-Device Machine Learning

https://machinelearning.apple.com/research/recognizing-people-photos

蘋果使用在您的裝置上多種基於機器學習的演算法,讓使用者在 iOS 15 上實現準確規劃和組織自己的影象和影片。

25、Image Synthesis and Editing with Stochastic Differential Equations

https://arxiv.org/pdf/2108.01073.pdf

是時候告別複雜的 GAN 和用於影象生成的Transformer架構了!來自斯坦福大學和卡內基梅隆大學的研究人員可以從任何基於使用者的輸入中生成新影象。即使是毫無藝術基礎的人,現在也可以從草圖中生成漂亮的影象。

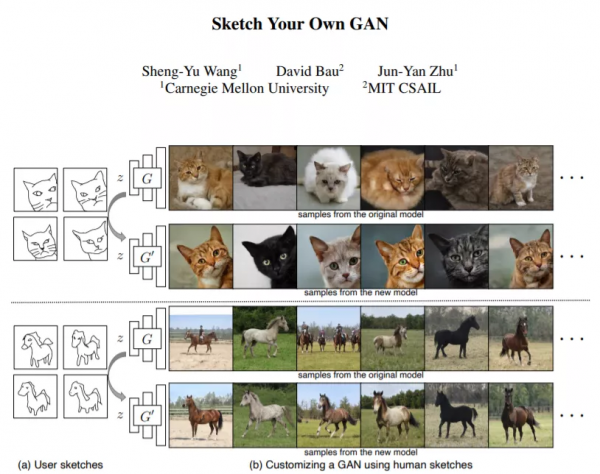

26、Sketch Your Own GAN

https://arxiv.org/abs/2108.02774

透過按照草圖生成影象,讓每個人都可以更輕鬆地進行 GAN 訓練!事實上,藉助這種新方法,您可以根據最簡單的知識型別來控制 GAN 的輸出:手繪草圖。

27、Tesla's Autopilot Explained

https://www.louisbouchard.ai/tesla-autopilot-explained-tesla-ai-day/

本文中,特斯拉人工智慧總監安德烈·卡帕西等人展示了特斯拉的自動駕駛系統是如何透過他們的八個攝像頭採集影象,實現道路上導航。

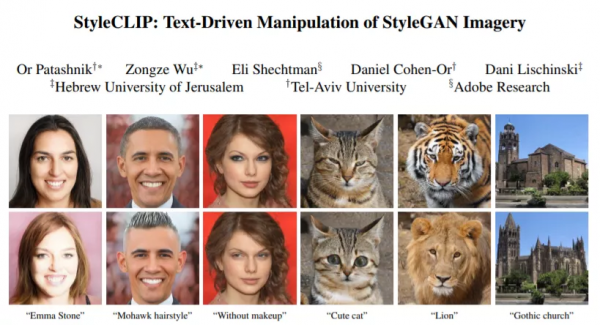

28、Styleclip: Text-driven manipulation of StyleGAN imagery

https://arxiv.org/abs/2103.17249

AI 可以生成影象,透過反覆試驗,研究人員可以按照特定的樣式控制生成結果。現在,有了這個新模型,只使用文字就能做到這一點!

29、Time Lens: Event-based Video Frame Interpolation

http://rpg.ifi.uzh.ch/docs/CVPR21_Gehrig.pdf

TimeLens 模型可以理解影片幀之間的粒子運動,以人眼無法捕捉的速度重建影片。事實上,本文中的模型效果達到了目前智慧手機都無法達到的效果。

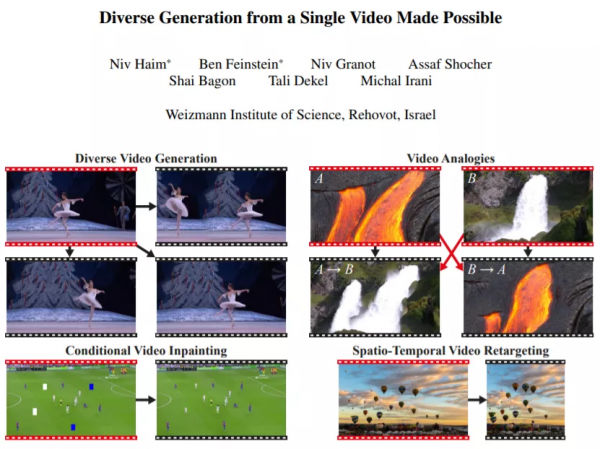

30、Diverse Generation from a Single Video Made Possible

https://arxiv.org/abs/2109.08591

你有沒有想過編輯影片?比如刪除或新增某人、更改背景、更改解析度以適應特定的縱橫比,無需對原影片進行壓縮或拉伸它。本文中的這項新研究。可以幫助你在單個影片中以高畫質格式完成所有這些工作。

31、Skillful Precipitation Nowcasting using Deep Generative Models of Radar

https://www.nature.com/articles/s41586-021-03854-z

DeepMind 剛剛釋出了一個生成模型,能夠在 89% 的情況下優於廣泛使用的臨近預報方法,其準確性和實用性通過了 50 多位氣象學家的評估!這個模型專注於預測未來 2 小時內的降水,實現效果出奇地好。

32、The Cocktail Fork Problem: Three-Stem Audio Separation for Real-World Soundtracks

https://arxiv.org/pdf/2110.09958.pdf

你是否曾在收看影片或電視節目時完全聽不見演員的聲音,或者音樂太大聲?嗯,這個問題可能永遠不會再發生了。三菱和印第安納大學剛剛釋出了一個新模型和一個新資料集,用於識別並處理關於影片配樂聲音的問題。

33、ADOP: Approximate Differentiable One-Pixel Point Rendering

https://arxiv.org/pdf/2110.06635.pdf

想象一下,從拍攝的一堆照片中生成一個 3D 模型或一段簡單流暢的影片。現在,這個目標可以實現了。

34、(Style)CLIPDraw: Coupling Content and Style in Text-to-Drawing Synthesis

https://arxiv.org/abs/2111.03133

只需要拍一張你要複製樣式的圖片,再輸入你要生成的文字,本文中的演算法就會自動生成一張新的圖片。

35、SwinIR: Image restoration using swin transformer

https://arxiv.org/abs/2108.10257

您是否曾經拍下過非常喜歡的影象,但現在只有一張小圖了?如果能把它的清晰度提高四到八倍該有多好。本文中的方法可以將影象的解析度提高4倍,使其看起來更加平滑。而且可以在幾秒鐘內自動完成,幾乎適用於任何影象。

36、EditGAN: High-Precision Semantic Image Editing

https://arxiv.org/abs/2111.03186

本文中的影象編輯工具可以從草稿中控制任何特徵,只會編輯你想要的內容,保持影象的其餘部分不變。這是一款NVIDIA、MIT 和 UofT 提出的基於 GAN 的草圖模型的 SOTA 影象編輯工具。

37、CityNeRF: Building NeRF at City Scale

https://arxiv.org/pdf/2112.05504.pdf

本文中的模型稱為 CityNeRF,是從 NeRF 發展而來的。NeRF 是最早使用輻射場和機器學習從影象構建 3D 模型的模型之一。但效率不高,而且只適用於單一規模。本文中,CityNeRF可同時應用於衛星和地面影象,為任何視點生成各種 3D 模型比例。

38、ClipCap: CLIP Prefix for Image Captioning

https://arxiv.org/abs/2111.09734

CLIP 是一種將影象與文字作為指南連結的模型。一個非常相似的任務稱為影象字幕,聽起來很簡單,但實際上也同樣複雜。它體現了機器生成影象自然描述的能力。簡單標記您在影象中看到的物件很容易,但理解單個二維圖片則是另一回事,這個新模型做得非常好。

參考資料:

https://github.com/louisfb01/best_AI_papers_2021#6