不知道還有多少小夥伴記得,一加8 Pro上的那顆濾光鏡頭。

一加本以為依靠它實現的秋意濾鏡是創新是好玩,但是偏偏就因為它有一定的穿透能力,讓一加8 Pro陷入了透視風波。

在這種情況下,沒人願意去了解事情的真相是什麼,一加自己也是百口莫辯。總之,隨著一陣拳打腳踢,一加最終還是透過OTA更新鎖死這顆攝像頭的功能。

講真啊,黑馬也是萬萬沒想到事情會發展成這個樣子。

這或許是在意料之外,或許也在意料之中。黑馬本以為從此手機廠商就不會再次觸碰此類話題,沒想到,卻有廠商在無意之中,再次讓手機擁有了“透視”功能。

近日,就有外網小夥伴發現,用最新的iPhone 13 Pro人像模式拍照,拍出來的人居然沒有頭了!

喏,這個“無頭騎士”就長這樣。

納尼!

難不成iPhone拍照的真實程度,已經上升到哲學的角度了嗎?或者說,它拍出了我們看不見的世界?

打住,我們要相信科學!

透過這張照片我們可以看見,人物頭部位置的樹葉,並非是憑空生成,它確實就是來自人物後面的背景。

所以,這到底是怎麼回事呢?難不成,iPhone真的有“透視”功能?

莫非是網友的相機bug造成影象缺失?

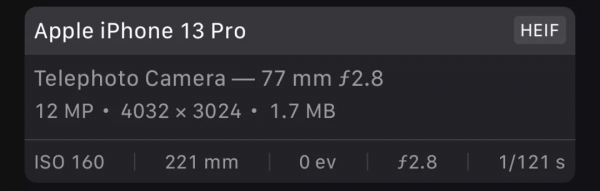

根據網友提供的照片引數可以看出,這張照片的拍攝引數非常的正常。感光度正常、光圈正常、曝光時間也是正常的。

那麼,問題到底出在哪呢?

這時候,就有網友懷疑是不是人像模式的演算法問題了。

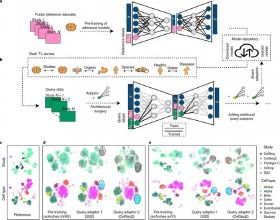

眾所周知,蘋果為了更好的拍照效果,推出了一個技術:Deep Fusion,簡稱深度融合。

它的執行原理也很簡單,在拍照的時候一次性拍攝多張照片,最後透過AI演算法將這些照片合成為一張。聽起來像是HDR,但實際上比HDR更好。

根據蘋果技術部負責人的解釋是:

當你按下快門時、相機先用較高快門速度捕捉4張短時曝光的照片(把畫素凍結下來避免後續使用時產生模糊的影像)。之後再拍攝4張標準曝光時長的照片。而在快門被按下的瞬間,系統還會拍攝一張長時曝光的照片(獲得更多暗部細節)。

接下來,手機先對畫面元素生成一系列權重評估,譬如天空、牆壁和地板等紋理不多的素材分得較低權重,對面板、衣服、織品等則給予較高權重,高權重元素會從某一張該元素細節最豐富的短時曝光照片中獲得細節、從合成長時間照片裡獲取色調、顏色和亮度,並用最高精度的高畫質演算法進行融合,而低權重的元素區域估計直接就拿合併長時間圖片畫素來做或使用低精度的快速演算法進行融合(節省資源和時間)。

黑馬簡單總結就是,手機拍攝多張照片,然後系統根據照片內容劃分權重,最後將這些照片合成為一張照片。

有網友就在想了,會不會是拍攝過程中人物突然出現變動導致AI演算法將其標記為低權重畫素,然後低權重畫素被拋離了呢?

目前為止,網友們最認同的就是這種說法,畢竟iPhone總不可能真的透視吧!

不過在黑馬看來,這個解釋其實說不太通。

雖然深度融合確實拍攝多張照片合成一張,理論上來說,只要人動得夠快就能躲開後面幾張照片的拍攝從而導致合成數據缺失的情況,但是我們透過人物下半部分可以看見,人物肩膀位置的輪廓非常清晰,換言之,就是沒有大幅度的移動。

在這種情況下,能把腦袋藏起來的人,可不多。(博爾特不帶閃也辦不到)

沒有大幅度的移動又能拍攝到人物背後的場景,事情突然就變得哲學了起來……

當然了,黑馬也嘗試了一下復現這種情況,不過很可惜的是,無論怎麼嘗試都沒有出現過。

可能有人會說,萬一是拍攝者手抖呢?

好吧!

黑馬也在拍攝時故意手抖了一下,發現這樣也只會讓照片變得模糊,並不會拍攝到人物後面的場景。

所以,問題到底出在哪裡呢?

在黑馬看來,這可能是手機多攝像頭同時拍攝合成失敗留下的案例。

因為手機幾顆攝像頭的焦段不同,獲取的畫面資訊深度也不同。

當讓距離相機較遠,同時背景距離人物也較遠時,就可能造成臨近的攝像頭看到的資訊不一樣,也只有這樣才能解釋得通,為什麼人物不動,手機也可以拍攝到人物背後的場景。

(注意左邊杯子的杯柄)

當然了,這只是黑馬的個人猜想,目前並沒有官方出面解釋該問題。大家也可以在評論想想看,到底是什麼原因讓iPhone突然能透視的?

特此宣告:轉載本篇文章是出於傳遞更多資訊為目的。若有來源標註錯誤或不小心侵犯到您的合法權益,請作者持證明與本網聯絡,我們將及時做出更正,謝謝。郵箱:[email protected]