編輯:袁榭 好睏

【新智元導讀】OpenAI首席科學家宣佈AI已有微弱自主意識的風波,現在仍在擴大化。支援方的MIT學者在自己論文圖表上畫條線,稱當下AI的大計算量已達到產生自主意識的突破閾值,在訊息出圈後不得不澄清:「我開玩笑的」。

OpenAI大佬聲稱AI已經有自主意識的推特,讓全業界都炸了鍋,而引發的罵戰還在繼續擴大化。

當然,這種學界對罵,一般是口說無憑、拿出論文/資料效果立馬變樣,不亞於街頭罵戰時一方突然掏出手槍的效果。

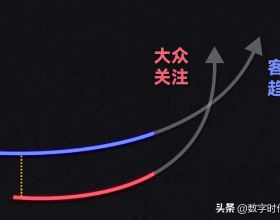

MIT的訪問研究學者塔米·貝西羅格魯在佈滿了機器學習模型的圖表上畫了「一條線」,界線以上即是模型「有微弱意識」的程度。

這張圖出自在他與別人合著的預印本論文「Compute Trends Across Three Eras of Machine Learning」裡,其中記錄了自1950年代「機器學習」概念產生以來的業界幾乎所有重大的研究。

開個玩笑,別當真

這個推特一出,差點要引發不亞於之前的聲浪。

2月17日早上,貝西羅格魯不得不澄清:「大家淡定,之前我在圖上畫線那條推特是開玩笑的,線是假的,研究是真的。我倒是希望自己發現了AI獲取自主意識的秘訣,可惜天不假人。」

不過,這個情勢顯然已經不再由他自己掌控了。

供職於IFP智庫與愛荷華州立大學的學者馬特·克蘭西回覆:「不好意思,你這裡現在已經出圈了,正式成為罵戰的陣線之一。」

儘管對有自主意識的電腦的恐懼可以追溯到1927電影《大都會》裡的「機器人瑪麗婭」,但研究者常常會嘲笑這個概念。

因為這種事發生的可能性實在太過渺茫,而且在擔心終結者活過來之前,各種「人工智障」的普通AI已經需要避免被不當使用了。

《大都會》劇照

薩茨克維爾與現任老闆山姆·奧特曼(Sam Altman)、著名網紅馬斯克當年合創的OpenAI,現在是業界當之無愧的研發火車頭。其開發的GPT系列模型,是全球AI人都豔羨的著名先進模型。

資料報道網站「用資料呈現世界」(Our World in Data)有AI系統訓練計算量的逐年與分領域趨勢圖。

在1952年的古代,計算次數每秒過萬已是尖端科技巔峰。而當下的大型尖端模型,每秒浮點計算次數動輒每秒1千萬億億次,為了跑這種大模型,Meta等大公司被逼到建造之前只有國家政府才捨得投資的超級計算機了。

因此當OpenAI的領軍人表示AI有自主意識時,已被當代AI進步眩目的公眾更加迷惑和反對,也在情理之中。

如果沒其他收穫的話,至少這次罵戰讓研究者們更加關注「何為自主意識」的定義了,或許對推動研究會有少許助益。

不過網友表示,這種罵戰已經快成了定期的八卦專案。「每五年就會來一次,每次都是瞎編故事和模糊定義引數,大家已經看乏了。」

機器學習的三個時代十年後,計算機視覺會有多大的進步?機器會不會比我們寫小說寫得更好?哪些工作我們將能夠實現自動化?

想要回答這些問題是十分困難的,然而,有一個因素卻貫穿始終,它在時間上的規律性令人吃驚——計算量。

為此,來自阿伯丁大學、聖安德魯斯大學、麻省理工學院、圖賓根大學和馬德里康普頓斯大學等機構的研究人員對里程碑式的ML模型隨時間變化的計算量需求做了的詳細調查:

1. 一個由123個里程碑式的機器學習系統組成的資料集,並標註了訓練這些系統所需的計算量。

2. 將計算量的趨勢歸納為三個不同的時代:前深度學習時代(Pre Deep Learning Era)、深度學習時代(Deep Learning Era)和大規模時代(Large-Scale Era)。

論文連結:https://arxiv.org/abs/2202.05924

簡而言之,在深度學習興起之前,機器學習模型的訓練計算量有一個緩慢增長的時代。

2010年左右,這一趨勢加速發展,此後一直沒有放緩。

另外,在2015年到2016年,出現了大規模模型的新趨勢,增長速度確定,但增速超過了過去時代速度的兩個數量級。

1952年至2022年期間,n=118個里程碑式的ML模型的趨勢

主要結果

向深度學習的過渡

作者發現,在深度學習出現之前和之後有兩個非常不同的趨勢機制。

在此之前,訓練ML系統所需的計算量每17至29個月翻一番。隨後,整體趨勢加快,每4到9個月翻一番。

前深度學習時代的趨勢大致符合摩爾定律:電晶體密度大約每兩年翻一番,不過通常被簡化為計算效能每兩年翻一番。

深度學習時代通常被認為是在2012年隨著AlexNet的誕生而開始的,而作者認為,根據現有的證據,2010年是最符合這個時代開始的時間。

不過在這個界定上,不管是選擇2010年還是2012年,都不會對整體的結果產生顯著影響。

1952年至2022年期間,n=118個里程碑式的ML系統的訓練計算量的趨勢

1952年至2022年ML模型的對數線性迴歸結果

大規模時代的趨勢

資料表明,在2015-2016年左右,出現了大規模模型的新趨勢。

這個新趨勢從2015年底的AlphaGo開始,一直持續到現在。這些大規模的模型是由大公司訓練的,他們更高額的訓練預算大概是打破之前趨勢的原因。

另外,常規規模模型的趨勢繼續不受干擾。這個趨勢在2016年之前和之後都是連續的,並且計算量有持續的發展速度,每5到6個月翻一番

大規模模型的計算量增加的趨勢顯然比較緩慢,每9到10個月翻一番。

不過,由於關於大規模模型的資料有限,作者推測,明顯的放緩可能是噪聲的結果

2010年至2022年期間,n=99個里程碑式ML系統的訓練計算量的趨勢

2010年至2022年之間資料的對數線性迴歸結果

不同領域的趨勢

不同領域的機器學習模型依賴於不同的架構,因此可以自然地預期它們會受到不同的擴充套件規律的影響。

由此,作者調查了視覺、語言、遊戲和其他12個領域的機器學習模型訓練計算量增加趨勢。

視覺和語言領域的趨勢隨著時間的推移似乎相當一致,並按照與整個資料集相同的倍增模式增長。

然而,在遊戲領域中卻無法找到一致的趨勢。作者猜測,可能的原因是資料太少,而不同的遊戲本質上是屬於不同領域的,此外,也可能是因為沒有像其他領域那樣得到系統性的推動。

2010年至2022年期間每個領域訓練計算量的趨勢

每個領域從2009年到2022年的趨勢

總結

在本文中,作者透過策劃100多個里程碑式的ML系統的訓練計算量資料集來研究計算量的趨勢,並使用這些資料來分析這一趨勢是如何隨時間增長的。

在前深度學習時代(1952年到2010年),計算量增長緩慢。

2010年左右,隨著過渡到深度學習時代,這一趨勢加快了。

2015年底,大公司開始釋出跨時代的大規模模型,如AlphaGo,標誌著大規模時代的開始。

用這三個時代來框定趨勢,有助於解釋在資料中觀察到的不連續現象,並讓人更好地理解更好地理解最近的ML進展是由規模的增加所推動的,從而改善對先進ML系統發展的預測。

不過,有些遺憾的是本文並沒有詳細剖析用於訓練機器學習模型的另一個關鍵可量化資源——資料集。

作者表示會將在未來的工作中研究資料集大小的趨勢以及它們與計算趨勢的關係。

而本想借機宣傳一下論文的貝西羅格魯,恐怕學到的要比其他合著者們更多:「貝西羅格魯法則:不管研究者的推特笑話有多明顯,只要你夠資深,總有傳媒會當真」。

參考資料:

https://wordpress.futurism.com/mit-researcher-conscious-ai/amp

https://arxiv.org/abs/2202.05924

https://twitter.com/tamaybes/status/1493682157914578944