夢晨 發自 凹非寺

量子位 | 公眾號 QbitAI

你知道變化盲視嗎?說的是環境明明出現大的變化,人卻很難察覺到。

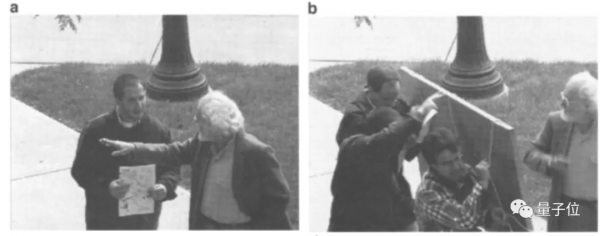

變化大到找你問路的陌生人偷偷換了一個,你都沒感覺,對話還能繼續下去。

實驗很簡單,先讓A隨機找人問路,這時有人舉著廣告牌喊著“借過借過”把兩人隔開。

之後A舉著廣告牌溜了,換成B留下接著問,兩個人長相、身高、穿著、聲音都不一樣。

無辜路人卻毫無察覺,還會繼續給B指路。

這個實驗最早出現在1998年,後來又被無數電視節目、網路影片復刻過,只有少數人能感覺出不對勁。

(搜“變化盲視”或“Change Blindness”就能找到很多)

以往對這個詭異的現象,科學家都是從注意力分配等方面找原因。

現在,一項發表在Science子刊的新研究,從認知神經科學的角度提出了全新解釋。

原來是從大腦加工視覺資訊的底層機制上就出了問題。

研究者設計了新的實驗,分析結果後提出:

大腦處理視覺資訊有延遲,而是把最近一段時間看到的畫面作平均混合後才更新一次。

重新整理的時間大概在15秒。

大腦在偷懶?

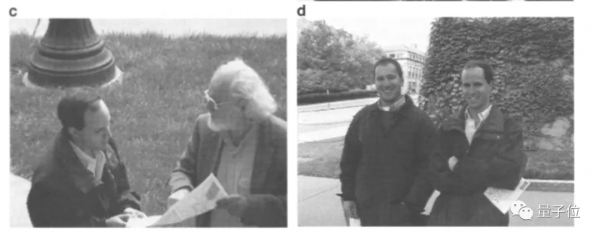

為了排除注意力不集中的影響,這次實驗方法不再讓環境突然變化,而是使用了連續變化的影象。

他們找來兩組人,分別回答一張年輕的臉和一張年老的臉是多少歲。

再找第三組人觀看這張臉逐漸變老的30秒影片,問他們年齡增加了多少。

結果47名觀看了影片的人會顯著低估年齡的變化,平均低估了5歲左右。

繼續驗證,把影片倒過來,讓第四組人看從老變年輕,結果這些人對變化同樣有低估。

為了讓實驗更精確,研究人員後續還做了更多實驗排除其他影響因素。

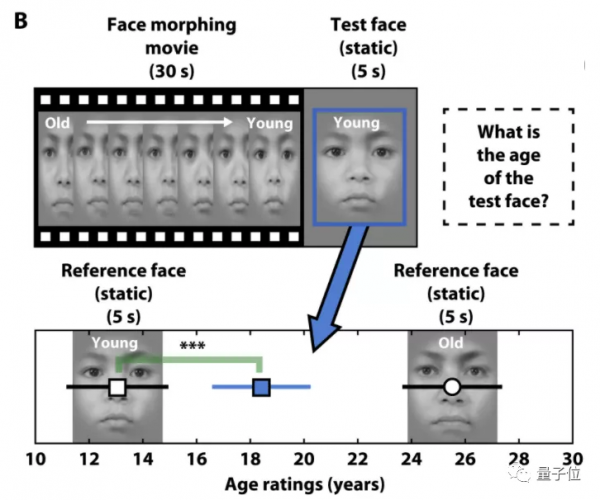

比如改變影片中面孔年齡變化的梯度,從逐漸變化到突然變化。結論是變化的梯度越大,參與者受到影片開頭的影響越小。

這進一步說明了參與者對面孔年齡的判斷依據不僅與開頭影象有關,而是整個影片都有影響。

另外還有給影片加上隨機噪聲、把年齡變化換成性別變化等等,總共12組對比實驗,這裡不再一一展示。

總之,研究根據所有實驗結果計算得出:

人們看不到最新的實時影象,而是最近15秒左右所有資訊做平滑處理的結果。

論文作者Mauro Manassi和David Whitney,來自UC伯克利。

他們認為這種大腦這種機制算是一種“偷懶”,或拖延症,不過有兩點好處。

一個是可以節能。

實時處理每一幀視覺資訊需要不停調動大量的視覺神經元,消耗太大。

另一個是帶來穩定的認知。

如果實時更新影象,人類會感覺世界過於混亂和不穩定。

光影、透視的輕微變化都會讓人無法確定眼前物體與之前是否為同一個,根本沒法正常生活。

但是也有壞處

這種延遲和模糊機制在大部分日常生活場景中都有積極作用,但當需要絕對精確的視覺資訊時也會產生問題。

同一個團隊的另一項研究發現,當放射科醫生檢查X光片時,不僅基於當前片子做判斷,還受之前片子的影響。

由此產生的錯誤率在3%-5%左右,會對患者造成誤診,影響治療甚至危及生命。

不知道這是否意味著,把這些要求精確性的任務交給沒有延遲機制的AI來做,會更有優勢?

最後,可以來試試你自己會不會變化盲視,看看用多長時間能找出這張圖片前後的不同。

論文地址

https://www.science.org/doi/10.1126/sciadv.abk2480

參考連結:

[1]https://theconversation.com/everything-we-see-is-a-mash-up-of-the-brains-last-15-seconds-of-visual-information-175577

[2]https://link.springer.com/article/10.1186/s41235-021-00331-z

— 完 —

量子位 QbitAI · 頭條號簽約

關注我們,第一時間獲知前沿科技動態