本書前兩部分主要探討監督學習(supervised learning)。在監督學習的過程中,我們只需要給定輸入樣本集,機器就可以從中推演出指定目標變數的可能結果。監督學習相對比較簡單,機器只需從輸入的資料中預測合適的模型,並從中計算出目標變數的結果。

監督學習一般使用兩種型別的目標變數:標稱型和數值型。標稱型目標變數的結果只在有限目標集中取值,如真與假、動物分類集合{爬行類、魚類、哺乳類、兩棲類、植物類、真菌 };數值型目標變數則可以從無限的數值集合中取值,如 0.100、42.001、1000.743等 。

數值型目標變數主要用於迴歸分析,將在本書的第二部分研究,第一部分主要介紹分類。

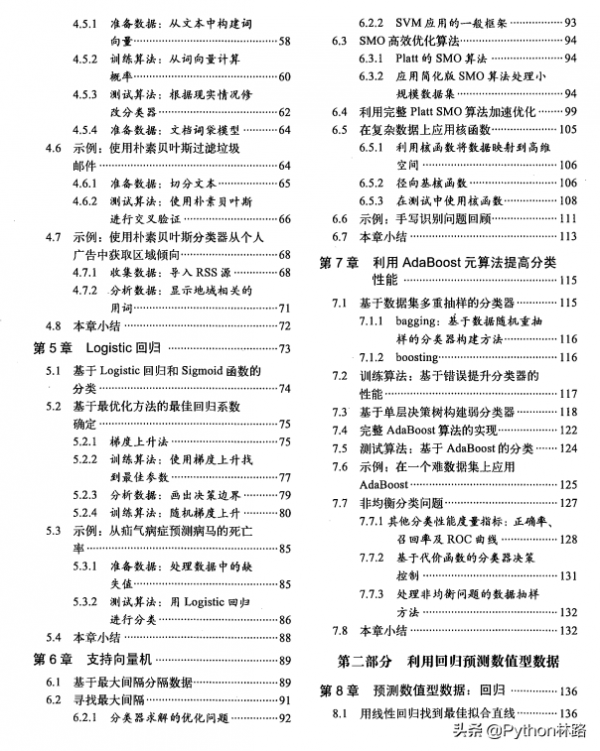

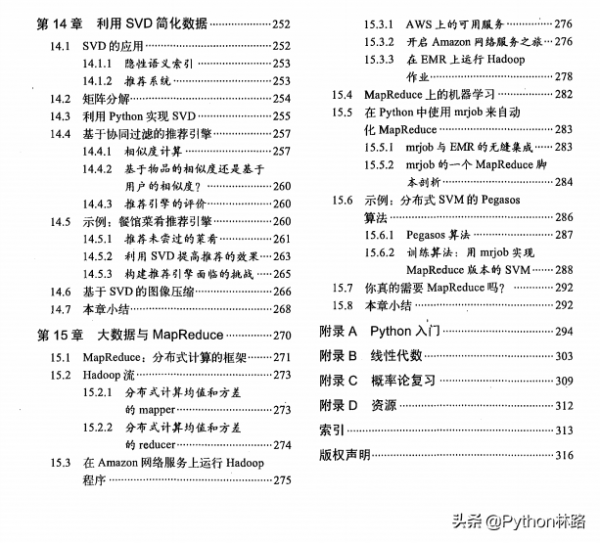

由於文章的篇幅有限,所以下面只能為大家展示部分內容和部分目錄內容~

目錄大綱:

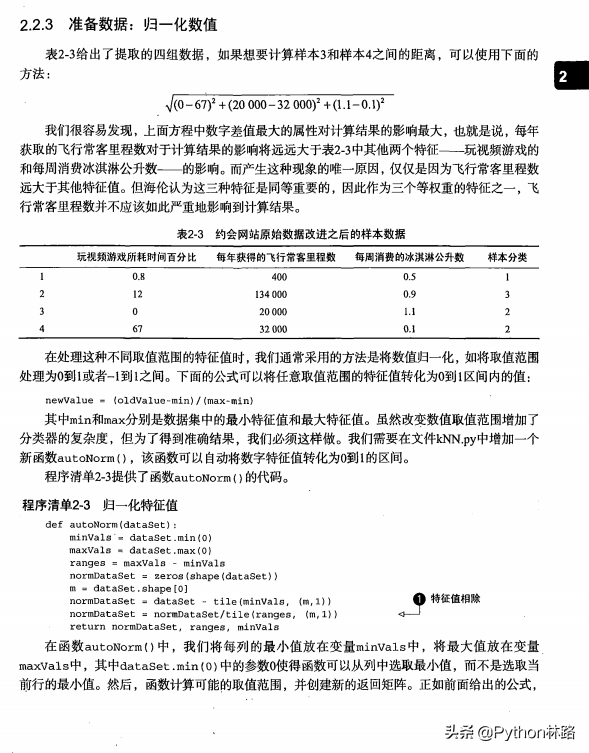

示例:使用k-近鄰演算法改進約會網站的配對效果:

我們很容易發現,上面方程中數字差值最大的屬性對計算結果的影響最大,也就是說,每年獲取的飛行常客里程數對於計算結果的影響將遠遠大於表2-3中其他兩個特徵—— 玩影片遊戲的和每週消費冰淇淋公升數——的影響。

而產生這種現象的唯一原因,僅僅是因為飛行常客里程數遠大於其他特徵值。但海倫認為這三種特徵是同等重要的,因此作為三個等權重的特徵之一,飛行常客里程數並不應該如此嚴重地影響到計算結果。

Logistic迴歸:

——基於最最佳化方法的最佳迴歸係數確定

下面首先介紹梯度上升的最最佳化方法,我們將學習到如何使用該方法求得資料集的最佳引數。接下來,展示如何繪製梯度上升法產生的決策邊界圖,該圖能將梯度上升法的分類效果視覺化地呈現出來。最後我們將學習隨機梯度上升的演算法,以及如何對其進行修改以獲得更好的結果

第二部分:利用迴歸預測數值型資料

本書的第二部分由第8章和第9章組成,主要介紹了迴歸方法。迴歸是第1〜7 章監督學習方法的延續。前面說過,監督學習指的是有目標變數或預測目標的機器學習方法。迴歸與分類的不同,就在於其目標變數是連續數值型。

第 8 章介紹了線性迴歸、區域性加權線性迴歸和收縮方法。第 9 章則借用了第3 章樹構建的一些思想並將其應用於迴歸中,從而得到了樹迴歸。

使用Apriori演算法進行關聯分析:

Apriori演算法是發現頻繁項集的一種方法。Apriori演算法的兩個輸入引數分別是最小支援度和資料集。該演算法首先會生成所有單個物品的項集列表。

接著掃描交易記錄來檢視哪些項集滿足最小支援度要求,那些不滿足最小支援度的集合會被去掉。然 後 ,對剩下來的集合進行組合以生成包含兩個元素的項集。接下來,再重新掃描交易記錄,去掉不滿足最小支援度的項集。該過程重複進行直到所有項集都被去掉。

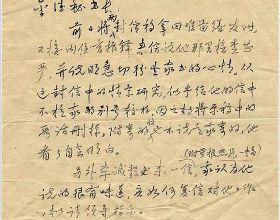

配套學習實操原始碼程式碼:

最後需要領取這本【AI殺瘋了!中科院士親傳的機器學習實戰專案 附配套學習原始碼程式碼!】的小夥伴麻煩幫忙點贊+轉發文章後,私信我【001】即可獲取!