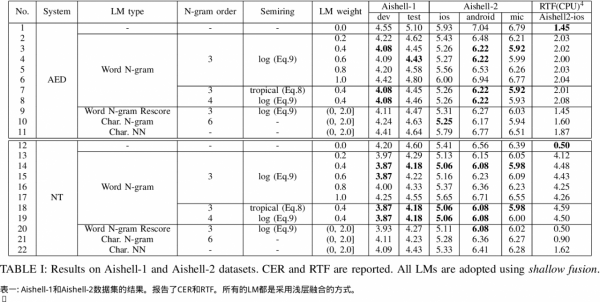

儘管端到端(E2E)自動語音識別(ASR)取得了快速進展,但事實表明,將外部語言模型(LMs)納入解碼可以進一步提高E2E ASR系統的識別效能。為了與E2E ASR系統中採用的建模單元保持一致,子詞級(如字元、BPE)LM通常被用來與當前的E2E ASR系統合作。然而,使用子詞級LMs會忽略詞級資訊,這可能會限制E2EASR中外部LMs的強度。儘管已經有一些方法被提出來在E2E ASR中加入字詞級外部LMs,但這些方法主要是針對有明確字詞邊界的語言如英語而設計的,不能直接應用於像普通話這樣的語言,在普通話中,每個字元序列可能有多個對應的詞序列。為此,我們提出了一種新的解碼演算法,在這種演算法中,一個詞級格子被即時構建,以考慮每個部分假設的所有可能的詞序列。然後,透過將生成的格子與外部詞N-gram LM相交來獲得假設的LM分數。所提出的方法在基於注意力的編碼器-解碼器(AED)和神經感測器(NT)框架上都得到了檢驗。實驗表明,我們的方法始終優於子詞級LM,包括N-gram LM和神經網路LM。我們在Aishell-1(CER 4.18%)和Aishell-2(CER 5.06%)資料集上取得了最先進的結果,在21K小時的普通話資料集上,CER相對減少了14.8%。

《Improving Mandarin End-to-End Speech Recognition with Word N-gram Language Model》

論文地址:http://arxiv.org/abs/2201.01995v1