出品 | AI科技大本營(ID:rgznai100)

人們透過聆聽和觀察說話者的嘴唇動作來感知言語。

那麼,AI 也可以嗎?

事實上,研究表明視覺線索在語言學習中起著關鍵的作用。相比之下,人工智慧語言識別系統主要是建立在音訊上。而且需要大量資料來訓練,通常需要數萬小時的記錄。

為了研究視覺效果,尤其是嘴部動作的鏡頭,是否可以提高語音識別系統的效能。Meta 的研究人員開發了 Audio-Visual Hidden Unit BERT (AV-HuBERT),這是一個透過觀看學習和聽人們說話來理解語言的框架。

Meta 聲稱 AV-HuBERT 比使用相同數量轉錄量的最佳視聽語音識別系統準確率高 75%。此外,該公司表示,AV-HuBERT 使用十分之一的標記資料優於以前最好的視聽語言識別系統,這使得它可能對音影片資料很少的語言具有潛在的用途。

Meta AI 研究科學家 Abdelrahman Mohamed 表示:“在未來,像 AV-HuBERT 這樣的 AI 框架可用於提高語音識別技術在嘈雜的日常條件下的效能,例如,在聚會上或在熙熙攘攘的街頭中進行的互動。智慧手機中的助手、增強現實眼鏡和配備攝像頭的智慧揚聲器,例如 Alexa Echo Show 也可以在這項技術中受益。”

目前,Meta 已將相關程式碼開源到 GitHub。

AV-HuBERT

Meta 並不是第一個將人工智慧應用於讀唇語問題的公司。2016年,牛津大學的研究人員建立了一個系統,該系統在某些測試中的準確率幾乎是經驗豐富的唇讀者的兩倍,並且可以實時地處理影片。2017年,Alphabet 旗下的 DeepMind 在數千小時的電視節目中訓練了一個系統,在測試集上可以正確翻譯約 50%的單詞而沒有錯誤,遠高於人類專家的 12.4%。

但是牛津大學和 DeepMind 的模型,與許多後續的唇讀模型一樣,在它們可以識別的詞彙範圍內受到限制。這些模型還需要與轉錄本配對的資料集才能進行訓練,而且它們無法處理影片中任何揚聲器的音訊。

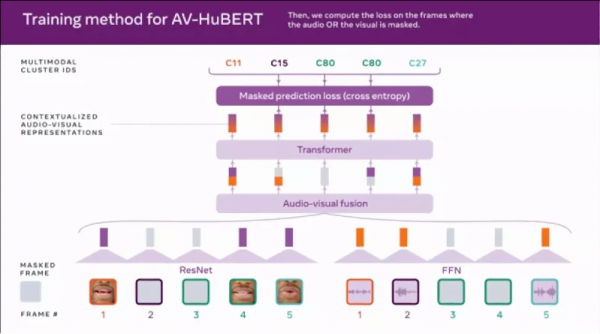

有點獨特的是, AV-HuBERT 利用了無監督或自我監督的學習。透過監督學習,像 DeepMind 這樣的演算法在標記的示例資料上進行訓練,直到它們可以檢測到示例和特定輸出之間的潛在關係。例如,系統可能會被訓練在顯示柯基的圖片時寫出單詞「dog」。然而,AV-HuBERT 自學對未標記的資料進行分類,處理資料以從其固有結構中學習。

AV-HuBERT 也是多模態的,因為它透過一系列的音訊和唇部動作提示來學習感知語言。透過結合說話過程中嘴唇和牙齒的運動等線索以及聽覺資訊,AV-HuBERT 可以捕捉這兩種資料型別之間的細微關聯。

最初的 AV-HuBERT 模型在 30 小時的 TED Talk 影片上進行了訓練,大大少於之前最先進模型的 31,000 小時的訓練時間。但是,儘管在較少的資料上進行了訓練,AV-HuBERT 的單詞錯誤率 (WER)(衡量語音識別效能的指標)在可以看到但聽不到說話者的情況下略好於舊模型的 33.6%,前者為 32.5%。(WER 的計算方法是將錯誤識別的單詞數除以總單詞數;32.5% 轉化為大約每 30 個單詞出現一個錯誤。)在 433 小時的 TED 演講訓練進一步將 AV-HuBERT 的 WER 降低到 28.6%。

一旦 AV-HuBERT 很好地瞭解了資料之間的結構和相關性,研究人員就能夠在未標記的資料上進一步訓練它。上傳到 YouTube 的 2,442 小時名人英語影片,這不僅使 WER 下降到 26.9%,而且 Meta 表示,它表明只需要少量標記資料來訓練特定應用程式(例如,當多人同時說話時)或不同語言的框架。

事實上,Meta 聲稱當背景中播放響亮的音樂或噪音時,AV-HuBERT 在識別一個人的語音方面比純音訊模型好約 50%,當語音和背景噪音同樣響亮時,AV-HuBERT 的 WER 為 3.2%,而之前的最佳多模式模型為 25.5%。

潛在的缺點

在許多方面來看,AV-HuBERT 象徵著 Meta 在用於複雜任務的無監督、多模式技術方面不斷增長的投資。

Meta 表示 AV-HuBERT 可以為開發“低資源”語言的對話模型開闢可能性。該公司建議,AV-HuBERT 還可用於為有語言障礙的人建立語音識別系統,以及檢測深度偽造和為虛擬現實化身生成逼真的嘴唇運動。

在各方面資料上,新方法的變現著實很精彩,但也有學者有一些擔憂。

其中,華盛頓大學的人工智慧倫理學專家Os Keye就提到,對於因患有唐氏綜合徵、中風等疾病而導致面部癱瘓的人群,依賴讀唇的語音識別還有意義嗎?

在微軟和卡內基梅隆大學的一篇論文中,提出了人工智慧公平性研究路線圖,指出類似於 AV-HuBERT 的面部分析系統的某些方面可能不適用於患有唐氏綜合症、軟骨發育不全(損害骨骼生長)和“導致特徵性面部差異的其他條件”等。

Mohamed 強調 AV-HuBERT 只關注唇部區域來捕捉唇部運動,而不是整個面部。他補充說,與大多數 AI 模型類似,AV-HuBERT 的效能將“與訓練資料中不同人群的代表性樣本數量成正比”。

“為了評估我們的方法,我們使用了公開可用的 LRS3 資料集,該資料集由牛津大學研究人員於 2018 年公開提供的 TED Talk 影片組成。由於該資料集不代表殘疾說話者,因此我們沒有預期效能下降的特定百分比,”Mohamed 說。

Meta 表示,它將“繼續在背景噪聲和說話者重疊很常見的日常場景中進行基準測試和開發改進視聽語音識別模型的方法。”

參考連結:

https://venturebeat.com/2022/01/07/meta-claims-its-ai-improves-speech-recognition-quality-by-reading-lips/