機器之心專欄

北京航空航天大學、商湯科技、京東探索研究院等

來自北航、商湯科技和京東探索研究院等機構的研究者提出了第一個在大規模資料集 ImageNet 上面向模型結構和訓練技巧且針對多種噪音型別的模型魯棒性評測基準——RobustART。該 benchmark 全面評測了 44 種經典的手工設計和 1200 種 NAS 取樣得到的模型架構以及 10 餘種模型訓練技巧對於魯棒性的影響。

以深度學習為代表的人工智慧技術,在計算機視覺、語音識別、自然語言處理等方向上已經取得了巨大進展,在我們生活中的多個領域得到了廣泛的應用併發揮了極其關鍵的作用。然而,由於現實應用場景的開放性,以大資料訓練和經驗性規則為基礎的傳統人工智慧(如深度學習)方法面臨著輸入樣本含有噪音的挑戰,如:自然噪音、對抗噪音等。這些微小的噪音對於深度學習模型的魯棒性和安全性產生了很大的挑戰,其對於社會穩定甚至是公共安全都可能產生極大的影響。

哪種模型對於噪音更加魯棒?哪些模型架構和元件對於噪音有更強的抵禦能力?對於這些問題的研究能夠幫助我們更好地認識和理解模型魯棒性的本質,從而幫助研究人員進行更加魯棒的模型架構設計。進一步,這對於推進工業級魯棒模型的評測和落地應用、並最終服務於國家相關智慧模型魯棒評測標準的推進和開展具有十分重大的意義!因此,來自北京航空航天大學、商湯科技和京東探索研究院的研究人員聯合加州大學伯克利分校、牛津大學以及約翰斯 · 霍普金斯大學提出了第一個在大規模資料集 ImageNet 上面向模型結構(ARchitecture Design)和訓練技巧(Training Technique)且針對多種噪音型別的模型魯棒性評測基準——RobustART。

該 benchmark 全面評測了 44 種經典的手工設計和 1200 種 NAS 取樣得到的模型架構以及 10 餘種模型訓練技巧對於魯棒性(對抗噪音、自然噪音、系統噪音等)的影響。並透過海量且深入的實驗探究,得出了大量的有價值實驗結果和眾多啟發性的結論,如:

(1)對於 Transformer 和 MLP-Mixer,對抗訓練可以全面提升其全部噪音魯棒性和任務本身的效果;

(2)在模型大小一致的前提下,對於自然噪音和系統噪音魯棒性:CNN>Transformer>MLP-Mixer,對於對抗噪音魯棒性,Transformer>MLP-Mixer>CNN;

(3)對於一些輕量化的模型族,增加其模型大小或者增加訓練資料並不能提升其魯棒性等。這些分析和結論將對人們認識模型魯棒性機理並設計安全穩固的模型架構產生重要的意義。

RobustART benchmark(1)提供了一個包含 leaderboard、資料集、原始碼等詳實資訊在內的開源平臺;(2)開放了 80 餘種使用不同模型結構和訓練技巧的預訓練模型,以便於研究人員進行魯棒性評估;(3)貢獻了嶄新的視角和大量的分析結論,讓研究人員更好地理解魯棒模型背後的內在機制。

RobustART 將作為核心組成部分,整合到北航團隊先前研發的人工智慧演算法與模型安全評測環境「重明」 系統當中,併發布「重明」2.0 版本(「重明」 是國內領先的智慧安全評測環境,曾受邀在國家新一代人工智慧開源社群 OpenI 啟智開源開放平臺釋出,並榮獲 OpenI 社群優秀開源專案)。在未來,RobustART 將持續為整個社群提供更加完善、易用的開源魯棒性評估和研究框架。同時也將助力於工業級模型的評測和魯棒模型的落地應用,最終也希望能夠服務於國家相關智慧模型魯棒評測標準的推進和任務的開展。

- 論文地址:https://arxiv.org/pdf/2109.05211.pdf

- RobustART 開源平臺網址:http://robust.art/

- 重明平臺網址:https://github.com/DIG-Beihang/AISafety

一、概要

目前的魯棒性 benchmark 主要聚焦於評估對抗防禦方法的效果,而忽略了模型結構和訓練技巧對於魯棒性的影響。而這些因素對模型魯棒性十分重要,一些細微的差別(如訓練使用的資料增強方法的不同)就可能掩蓋防禦方法帶來的魯棒性影響,從而造成對模型魯棒性的錯誤評估和認識。因此,該論文提出了 RobustART 來全面地評測不同模型結構和訓練技巧對於魯棒性的影響,並在對抗噪音(AutoAttack、PGD 等)、自然噪音(如 ImageNet-A, -O, -C, -P)和系統噪音(如 ImageNet-S)下進行了全面評估。下表給出了在研究的 44 種經典網路模型中,在不同噪音下魯棒性前五名的模型(為了公平比較,所有模型的訓練設定都已對齊):

二、考慮模型結構和訓練技巧的魯棒性 benchmark

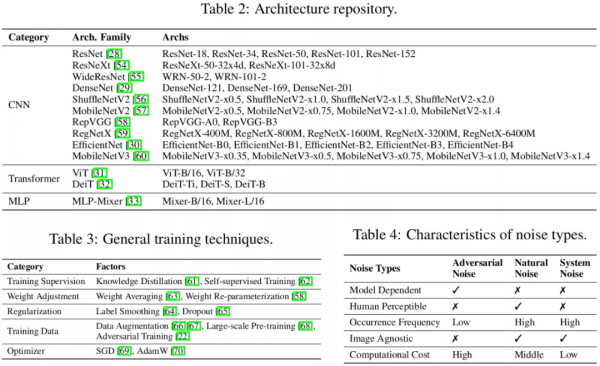

為了更好地探究模型魯棒性的內在本質,該研究將影響模型魯棒性的原因劃分成模型結構和訓練技巧這兩個正交因素,進而構建了一套完整的 benchmark 設定,即(1)對不同網路結構的模型,使用同樣的訓練技巧進行訓練(2)對於同一種網路結構的模型,使用不同的訓練技巧進行訓練。這種細分的消融研究更有助於人們理解某些具體的模型結構或者訓練技巧對於魯棒性的影響。下表分別展示了研究中用到的模型結構、訓練技巧、以及噪音型別。

針對模型結構這一因素,該研究儘可能多地覆蓋了常用的神經網路模型。對於 CNNs,有經典的大型結構如 ResNet、ResNeXt、WideResNet、DenseNet;輕量化網路如 ShuffleNetV2、MobileNetV2;重引數化的結構 RepVGG;基於神經架構搜尋(NAS)的模型如 RegNet、EfficientNet、MobileNetV3 以及使用 BigNAS 超網取樣得到的子網路;對於非 CNN 網路,有 ViT 和 DeiT,以及最近的基於 MLP 結構的 MLP-Mixer。總計 44 種典型的手工設計的網路模型和 1200 種超網取樣出的子網模型,在實驗中它們的訓練設定都將被對齊。

針對訓練技巧這一因素,該研究選取了較為主流的一些技巧進行探究,有知識蒸餾、自監督訓練、權重平均、權重重引數化、標籤平滑、Dropout、資料增強、大規模預訓練、對抗訓練、不同的最佳化器等。在實驗中選取部分模型結構,透過比較使用某訓練技巧進行訓練和不使用該技巧訓練對模型魯棒性的影響來探究該訓練技巧對魯棒性起到的作用。

為了全面完整地對模型魯棒性進行評估,該研究選用了三種不同型別的噪音來對模型進行測試:對抗噪音、自然噪音、系統噪音。其中,對於對抗噪音選用了 8 種主流的對抗攻擊方法,覆蓋了不同的攻擊強度和黑白盒攻擊:FGSM、PGD-

、AutoAttack-

、

、以及基於遷移的對抗攻擊;對於自然噪音選用了 4 種主流的資料集:ImageNet-C、ImageNet-P、ImageNet-A、ImageNet-O;對於系統噪音選用了 ImageNet-S 資料集。此外,對於每種噪音都選擇了相應的評估指標進行測評。

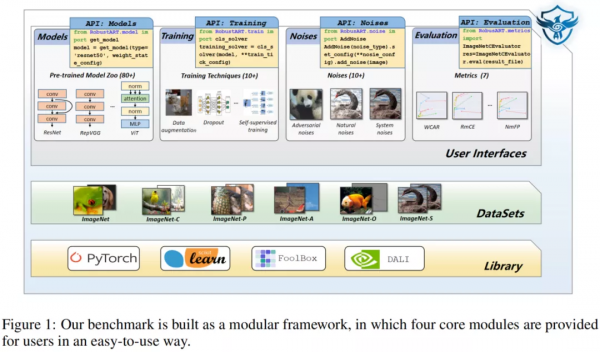

RobustART 整體採用了層次化和模組化的框架設計,如下圖所示,底層使用了 Pytorch 作為深度學習框架,並使用了 FoolBox、ART 等對抗工具庫,且提供了多種資料集的支援。使用者介面層次主要分為 Models、Training、Noises、Evaluation 這四大模組,每個模組提供了可呼叫的 API 供使用者使用。透過使用 RobustART 的開源框架,使用者可以(1)方便地使用提供的程式碼復現結果以及進行更加深入的分析;(2)透過提供的 API 新增新模型、訓練技巧、噪音、評估指標等來進行更多的實驗;(3)使用提供的預訓練模型和研究結果進行下游的應用或者作為比較的基線。

三、實驗結果與分析

3.1 模型結構對於魯棒性的影響

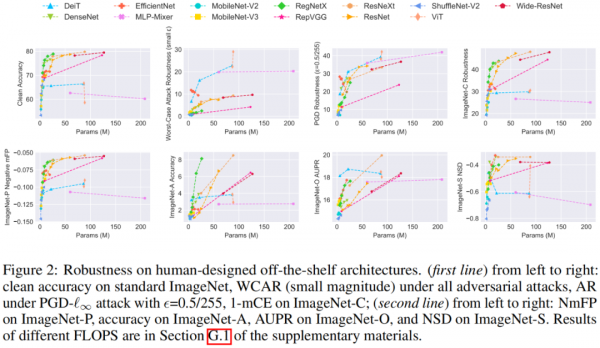

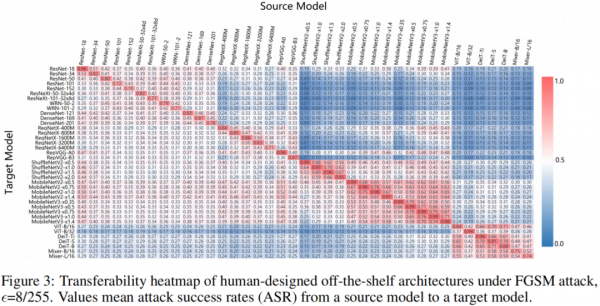

該研究首先選用了來自 13 個模型族的共 44 個典型的網路模型,使用對齊的實驗設定對它們進行訓練,然後對它們進行魯棒性評估。下面兩張圖分別展示了所有模型在各種噪音下模型大小與魯棒性的關係以及在面對遷移性對抗攻擊時的熱力圖:

透過圖中各模型間魯棒性的對比,可以看到:

- 對於幾乎所有模型族(除了 MobileNetV2 等輕量化的模型族),增大模型大小能夠同時提高泛化性以及對於對抗、自然、以及系統噪音的魯棒性。

- 在模型大小類似的情況下,不同的模型結構可能有著截然不同的魯棒性,這也意味著模型結構對於魯棒性是非常重要的。具體的,ViT、MLP-Mixer 這類非 CNN 的模型在對抗噪音下表現更為優秀,而傳統的 CNN 模型(如 ResNet、ResNeXt)則對於自然噪音和系統噪音更加魯棒。

- 不同的噪音對於最終魯棒性的評估結果影響很大,對於同一型別的噪音(如對抗噪音),不同的攻擊方法可能導致不同的模型魯棒性結果;甚至對於同一種對抗攻擊,不同的噪音大小也可能會導致魯棒性評估結果的不同。

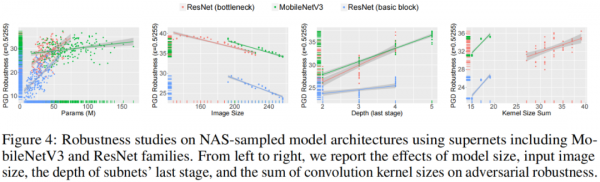

除了 44 個典型的網路模型,該研究還從 BigNAS 超網中取樣了 1200 個子網,探究子網模型引數(如模型大小、輸入圖片大小、深度、卷積核大小等)對於魯棒性的影響,如下圖所示:

可以看出模型大小、卷積核大小、模型最後一個 stage 的深度對於對抗魯棒性有著正向的影響,而輸入圖片的大小則對對抗魯棒性有負面的影響。

3.2 訓練技巧對於魯棒性的影響

該研究針對 10 餘種特定的訓練技巧,選取部分模型來評估有 / 無這些技巧對於模型的魯棒性影響,部分結果如下圖所示:

從實驗結果可以得出較多有意義的結論,如:

- 對抗訓練:對於 CNNs,對抗訓練提升了模型的對抗魯棒性,然而降低了 Clean 資料集上的泛化性以及對於自然噪音和系統噪音的魯棒性;該研究還首次發現了對於 ViTs 和 MLP-Mixer,對抗訓練顯著提升了 Clean 資料集上的泛化性以及對於所有三種噪音的魯棒性,這對於對抗訓練在真實場景中的實際應用有重大意義。

- ImageNet-21K 預訓練:該技巧提升了模型對於自然噪音的魯棒性,卻降低了對於對抗噪音和系統噪音的魯棒性。

- 資料增強:該技巧降低了模型在對抗噪音上的魯棒性,並在大多數情況下提升了模型對於自然噪音的魯棒性。

- AdamW 最佳化器:相比於基礎的 SGD 最佳化器,該技巧略微降低了 ResNet、RegNetX 等大型模型的魯棒性,卻明顯提升了 MobileNetV3 和 ShuffleNetV2 等輕量化模型在 Clean 資料集上的泛化性以及對於所有三種噪音的魯棒性。

四、展望

在深度學習模型大量應用於人臉識別、自動駕駛等關鍵領域的今天,人們越發意識到人工智慧安全的重大意義,而人工智慧安全相關的研究和標準也亟待進一步推進和落實。本研究所提出的 RobustART 為我們帶來了一個全面、標準的模型魯棒性評估的開源平臺和框架,並在此基礎上進行了大量的實驗研究,得出了大量有啟發性的結論。這將幫助我們進一步認識和理解模型魯棒性與結構、訓練技巧之間的關係,讓我們對魯棒性有了更加全面深入的認識。該研究將與現有的面向防禦的魯棒性 benchmark 互補,共同構建完善的魯棒性基準,推動魯棒性研究生態系統在機器學習社群中的長遠發展。