如果讓你穿越成為一名詩人,你會選擇誰?

喜歡豪邁的可能會選擇辛棄疾、喜歡婉約的沒準會選擇秦觀,但在眾多著名詩人中,李白可能是呼聲最高的,畢竟無論是名氣、才氣還是仙氣來說,李白都是首屈一指。不過也正因為“詩仙”的級別太高,千百年來我們都是高山仰止,可望而不可及。如果給你一個能夠成為“詩仙”的機會,你心動不心動?

沒錯,今天它來了——在10月26日舉辦的2021人工智慧計算大會(AICC 2021)上,浪潮資訊宣佈對全球最大中文AI巨量模型“源1.0”進行開放開源,這樣每個人都有機會成為自己心目中的那個“李白”。

“自然語言處理”這個問題一直是人工智慧領域的熱門,而這次開源的全球最大中文AI巨量模型“源1.0”也正是基於此。說到這裡,可能不少人都會想起IBM曾經的Waston智慧計算機,早在10年前的2011年,Waston就在一檔名為《危險邊緣》(Jeopardy)的答題比賽中擊敗人類獲得了冠軍;隨後在2018年,IBM Project Debater計算機更是對壘人類冠軍Noa Ovadia和辯論專家Dan Zafri,並取得了一勝一敗的成績,雙方打成平手。

但這畢竟是外語,準確的說是英語。許多人都說漢語博大精深,的確在表意能力上含義更豐富一些,特別是談到古詩、對聯等韻律形式的時候,對於漢語的運用要更高一些。因此漢語的“自然語言處理”應用起來也更為複雜,也就需要更龐大的資料庫支援智慧訓練。

這也正是全球最大中文AI巨量模型“源1.0”的價值所在。“為了訓練源1.0,我們研發了容量為5TB的、業界最大規模的中文高質量資料集。為了這個資料級的獲取,我們清洗了接近860TB的網際網路資料,也經過一系列的粗濾、精濾,專家評審等過程”,在談到為“源1.0”模型進行資料準備的時候,浪潮人工智慧研究院首席研究員吳韶華感慨萬千。

當然海量資料只是“源1.0”實現的必要條件之一,結合這些資料浪潮資訊還需要基於強大的AI平臺進行計算。為此,“源1.0”大模型總共用了2457億的引數,使用了具備2128塊GPU的高效能算力叢集,計算量達到了4095 PD(PetaFlop/s-day)的規模,實現了業界最高。在大會現場,香港中文大學(深圳)校長講座教授黃愷也將“源1.0”與業界著名的英文語言模型GPT-3進行對比,並給出了自己的判斷。

在他看來,作為後起之秀的“源1.0”無論在引數量還是在效能、無論在覆蓋範圍還是應用生態上都要高於後者——“源1.0”的引數量比GPT-3多出40%,語料庫總體積達到 5TB,是GPT-3 的近10倍;浪潮資訊推出了深度學習平行計算框架Caffe-MPI、TensorFlow-Opt等多種應用,針對大型伺服器進行最佳化,減少多GPU場景下效能損失。

正如我們在使用翻譯軟體的時候需要考慮準確度一樣,在“自然語言處理”中精度也是大家關注的焦點。據悉,“源1.0”實現了中文權威的自然語言處理任務CLUE零樣本學習和小樣本學習的榜單上分別排名第一。在零樣本學習榜單中,“源1.0”超越業界最佳成績18.3%,在文獻分類、新聞分類,商品分類、原生中文推理、成語閱讀理解填空、名詞代詞關係6項任務中獲得冠軍;在小樣本學習的文獻分類、商品分類、文獻摘要識別、名詞代詞關係等4項任務獲得冠軍。在成語閱讀理解填空專案中,源1.0的表現已超越人類得分。

“比人類的表現更好”,這對於人工智慧來說已經是非常積極的評價了,上一次獲得這個公開評價的還是在圍棋界大殺四方的谷歌AlphaGo。很顯然,對於“吟詩作賦”、“奮筆疾書”這類文字工作來說,“源1.0”也同樣具備類似的地位和能力,也成為了文化領域的“AlphaGo”。

水到渠成,以“智算”迎接行業發展挑戰

相對於獲得多項應用的“第一”,“源1.0”的價值還在於其象徵意義。

對於“源1.0”的擁有者浪潮資訊來說,以往許多人提到這個名字的第一印象就是計算力的提供者,這種印象也得益於浪潮資訊多年來獲得的種種成就,比如蟬聯中國伺服器市場佔有率第一名,比如提出了“計算力就是生產力”的行業論斷。正因為如此,大眾對於浪潮資訊的定義更多是一家“偏硬”的廠商,這也就讓“源1.0”的開源變得讓人出乎意料,也讓我對未來浪潮資訊的發展方向產生了好奇。

“源1.0”的開源是否意味著軟體及應用在浪潮資訊的比重會增加呢?對此,浪潮資訊副總裁、浪潮資訊AI&HPC產品線總經理劉軍從兩個方面給出了回答。“為什麼是浪潮做,為什麼浪潮能做好,為什麼浪潮會選擇來做這個?因為浪潮已經站在了這個制高點,從產業發展的策略以及我們自身競爭優勢和能力儲備來說,浪潮資訊已經實現了對於算力、演算法、資料三駕馬車協同的創新,也有更多的產業的使用者、研究者與合作伙伴,大家可以攜手進行巨量模型的開發,使得人工智慧產業更加迅速、更加健康的發展”。

這是一個水到渠成的過程。在中國市場,浪潮資訊是最早在AI領域進行重度投入的企業,也是AI伺服器出貨量的第一名。而正如劉軍所說,浪潮資訊看到了算力、演算法的價值,也透過技術研發與生態建設打造了屬於自己的AI生態圈。這次“源1.0”的開源同樣可以視為是對生態系統的新一輪建設,可以讓更多的開發者與使用者加入到“源1.0”社群當中,而這也正是劉軍口中說的“責任感與使命感”。

或許這也是AI領域的“時勢造英雄”。說到時勢,如今的AI發展已經不再是隻考慮硬體研發的初級階段,伴隨著開發者隊伍的壯大,如何為開發者提供有價值的、有發揮空間的平臺,如何在雙方的互動中實現良性增長,這也是眾多AI公司都在考慮的問題。

行業變革在即,計算系統創新刻不容緩

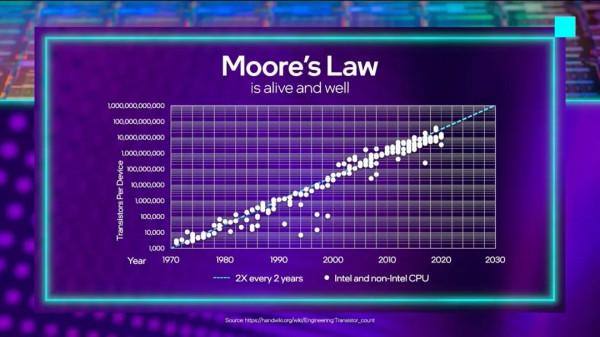

如果你參加的行業會議足夠多,那麼你可能在多種場合都聽到過“摩爾定律終結”之類的論調。儘管連當年提出這一觀點的摩爾本人都認為“摩爾定律”不應該有這麼長的生命力,但至少在目前看來整個行業的確已經不再像當初預想的那樣發展,因為人工智慧帶來了“多元化、巨量化、生態化”的三大趨勢,這也將開創未來行業發展的新格局。

多元化表現得最為明顯。如果倒數5年,整個算力中心市場還都是在x86架構統治下,我們還在考慮如何讓CPU和GPU協同發揮最大的效能。但是伴隨著多元算力的發展,如今包括x86、ARM、RISC-V、FPGA、GPU等一眾算力都可以承擔AI計算的重任,比如最近熱門的蘋果筆記本就是ARM應用的最佳體現。

而為了應對多元化算力的挑戰,浪潮資訊不僅要解決x86架構的應用問題,更需要為AI伺服器進行穩定性、可靠性等應用的全面適配,還要保障演算法框架與應用最佳化、大規模算力部署時的能效控制等多種問題。尤其是對於AI專用晶片的出現也讓原有的算力架構進行了轉變。

“我們能造出效能強大的火箭發動機,但要想造出安全、高效能的運載火箭,還要在迴圈、控制、結構等很多領域做大量的工作。晶片到計算系統同樣如此,需要完成體系結構、訊號完整性、散熱、可靠性等大量系統性設計工作。”中國工程院院士、浪潮首席科學家王恩東給出了生動的比喻。

巨量化同樣是未來行業的一大特性,這也是由人工智慧資料應用的特性來決定的。正如我們剛剛談到的全球最大中文AI巨量模型“源1.0”那樣,出色的人工智慧應用必然需要海量的資料進行訓練,就比如在如今的網際網路平臺每天都承載著數萬億次的呼叫量,數百萬小時的語音識別,超過百億張影象識別,超過萬億句自然語言理解等等。如此巨量的算力呼叫對算力中心的應用支撐能力帶來了極大的挑戰,也需要算力提供商與時俱進的提供解決方案。

生態離散化則是AI應用的第三個重點,如果從最終效果來考量,它也是決定企業AI戰略成敗的關鍵。目前,AI晶片架構五花八門,指令集不同,無法相容,而面向晶片的程式設計庫又跟晶片繫結,靈活性差;小公司只做了其中一個環節,這造成生態的縱向不通;大公司希望構建封閉的系統,這造成了生態的橫向不通……因此對於產業來說,生態離散化已成為制約人工智慧技術上水平、應用上規模、產業上臺階的瓶頸所在。

當然對於這些問題,王恩東院士也給出了專業性的建議,他表示一方面要“重視智算系統的創新,加大人工智慧新型基礎設施建設,把從技術到應用的鏈條設計好,從體系結構、晶片設計、系統設計、系統軟體、開發環境等各個領域形成既分工明確又協同創新的局面”,而另一方面則是要“開放標準建設,透過統一的、規範的標準,將多元化算力轉變為可排程的資源,讓算力好用、易用。”

應該說,“源1.0”的開源已經為浪潮資訊乃至整個AI產業的生態應用開了一個好頭,我們也有了屬於中國人自己的、最大的巨量模型。未來在“多元化、巨量化、生態化”的態勢下,AI產業需要的也是越來越多的相關模型,透過前沿的AI晶片創新技術分享,推動開放合作、共享共贏的產業AI應用落地,推動整個社會AI應用的普惠化和全覆蓋。

那些曾經只能在影視作品中看到的AI場景,應該不會太遠了吧。