(本文關鍵詞:Deepfake技術 人工智慧 危害性 分析)

在人們的心目中,銀行是一個管理制度嚴格、工作細緻嚴謹的地方。我們經常會聽到銀行職員成功阻止了某位老年人向詐騙分子鉅額轉賬等類似報道。然而這一次,阿聯酋一家銀行卻被一個利用“深度偽裝(Deepfake)”技術的詐騙團伙騙取了3500萬美元的資金。

圖片來源於網際網路

一、事件始末

2020年初,阿聯酋的一位銀行經理接到了一家大公司董事打來的電話。該董事聲稱其所在的公司正在進行一項大型收購,所以需要這家銀行授權向美國的幾個賬戶轉賬3500萬美元,並表示已經發送一封來自律師的電子郵件來確認這筆轉賬。該銀行經理能夠分辨出這位董事的聲音,因為他們之前交談過,並且在收件箱中看到了來自董事和律師的電子郵件,他認為一切程式看起來都是合法的,於是確認了這筆轉賬。

然而這位大公司的“董事”的聲音實際上是詐騙團伙利用一種名為“深度偽裝(Deepfake)”的人工智慧技術合成的,聽起來很像本人的聲音。阿聯酋有關部門目前正在尋求美國警方的幫助,以追回丟失的資金。據悉,這些資金已被詐騙分子轉移到他們在全球各地的至少17個賬戶上。

這並不是Deepfake語音技術第一次被用於網路詐騙犯罪。無獨有偶,2019年3月,一家總部位於德國的英國能源公司的管理者也曾被Deepfake技術所騙,損失了約25萬美元。詐騙團伙利用Deepfake技術生成了德國母公司CEO的聲音,並命令英國分公司的經理緊急匯款。可笑的是,攻擊者在第一次詐騙成功得手後,故技重施,兩天後再次給這名經理打電話,並指示其追加10萬美元匯款。 但這次,英國分公司經理察覺到了一些可疑之處,並阻止了再次被騙。

圖片來源於網際網路

二、何為Deepfake技術

到底什麼是Deepfake技術?這種技術為什麼如此厲害,連銀行經理、公司高管都會被矇騙上當?

Deepfake是由“deep machine learning”(深度機器學習)和“fake photo”(假照片)組合而成,本質是一種深度學習模型在影象合成、替換領域的技術框架,屬於深度影象生成模型的一次成功應用。

其實該技術的最初版本在2017年底就被提出了,當時在構建模型的時候使用了Encoder-Decoder自編解碼架構,在測試階段透過將任意扭曲的人臉進行還原,整個過程包含了:獲取正常人臉照片—>扭曲變換人臉照片—> Encoder編碼向量—> Decoder解碼向量—> 還原正常人臉照片五個步驟。後來,在Encoder-Decoder的框架之上,又引入了GAN(生成對抗網路)技術,不但降低了同等條件下的模型引數量和模型複雜度,同時使生成的人臉更為清晰,大大降低了對原圖的依賴,顯著提升了換臉的效果,從而形成了目前基於GAN技術的Deepfake改進版。

簡而言之,只要提供足夠多的照片或聲音素材,Deepfake就能夠實現以假亂真的變臉或變聲,還自帶動態捕捉,可以直接在影片甚至實時影像中進行面部更換。

三、Deepfake技術被濫用究竟有何威脅?

每項新技術的產生都具有兩面性。一方面,Deepfake技術應用在影視文化行業等領域的想象空間極大;另一方面,利用Deepfake技術實施詐騙、用於政治爭鬥和誹謗他人等,使該技術從誕生之初就伴隨著肖像權、版權和倫理層面的爭論。

一是用於網路詐騙

就像前面提到的這兩起網路詐騙事件一樣,預計,今後網路犯罪分子將會積極利用Deepfake技術實施詐騙活動。在使用 Deepfake技術製作的影片中,可能會檢測到細微的奇怪之處,但以目前的技術水平生成的聲音檔案與真實聲音非常相似,真假難辨。

安全公司Cato Networks的網路安全高階主管伊泰·毛爾(Etay Maor)表示:“目前已經出現了很多類似Deepfake技術這種可以生成深度偽裝語音的開源工具。網路犯罪分子的目的是賺錢。只要能賺錢,他們願意肆無忌憚地學習和使用任何新技術。如果Deepfake技術被反覆用於這種大規模的詐騙技術,那麼這些開源工具也將會如此,攻擊者沒有理由不使用它們。雖然Deepfake技術合成的影片尚不完善,但語音合成技術已經足夠成熟,且使用起來並不難。”

二是用於政治目的

在Deepfake技術剛出現時,專家們就擔心它們會被惡意用於政治活動中。也就是說,他們擔心別有用心者模仿政客的臉和聲音製作出虛假影片,散佈不負責任的言論,從而引發社會轟動。

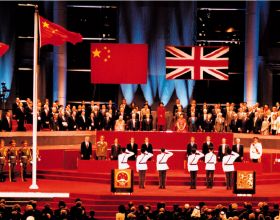

圖片來源於網際網路

2018年4月,美國網路媒體Buzzfeed在Youtube上上傳了一條影片,令人大吃一驚。影片的內容是前任美國總統奧巴馬辱罵時任美國總統特朗普。在該影片中,前美國總統奧巴馬稱特朗普是個十足的笨蛋。其實,這是Buzzfeed為了警示人們Deepfake技術的危險性而與電影導演喬丹·皮爾(Jordan Peele)一同製作的影片。該影片製作得十分巧妙,一般人很難辨別其真偽。因此, 如果Buzzfeed沒有公開該影片的真實意圖,此事件將會引起軒然大波。

三是用於誹謗他人

利用女明星、成功人士等公眾人物的臉製作虛假色情影片引發關注,這是Deepfake技術的慣用伎倆,任何熟悉網際網路的人都不會對此感到驚訝。2019年10月,荷蘭網路安全公司Deep trace釋出了一份統計報告顯示,利用Deepfake技術製作的影片中96%都涉及色情,並且大部分受害者都是娛樂圈女星。

四是損害大眾的信任

Deepfake技術可能構成的最大威脅是,它們的存在令人們對合法影片和真實新聞增加了一份不信任感。Deepfake技術具有前所未有的篡改內容的能力,這對消費者、品牌方、決策者、政治家和所有作為資訊提供者的媒體蒙上了一層“不信任”的陰影。並且隨著AI和深度學習技術的不斷髮展,虛假音影片的製作也將變得更加容易、更為“真實”。因此,Deepfake技術破壞信任和傳播假訊息的潛力也前所未有地增強了。

圖片來源於韓國安全新聞網站

四、我們該如何預防此類詐騙

此次阿聯酋銀行詐騙事件不是Deepfake語音技術第一次被用於網路詐騙犯罪,也不會是最後一次。類似的事件將來還會發生,而且規模可能會更大。那麼,我們該如何預防呢?

一是引入零信任

安全公司Cato Networks的網路安全高階主管伊泰·毛爾將這兩次利用Deepfake技術成功詐騙的事件描述為“最終與信任相關的事件”。他表示:“對於冒充認識的人傳送電子郵件要錢和直接打電話要錢的人來說,這是兩件完全不同的事情。因為語音中包含的資訊比文字多得多,除了說話的內容外,還有聲音的音色、語調、語氣等其他資訊。如果連這些資訊都和原始資訊相似,則它更有可能被信任。沒有人能不上當受騙。”

毛爾認為,在Deepfake技術變得如此普遍的當下,別無他選,只能在所有環境下引入零信任。毛爾強調:“這不只是與引入新技術或最新技術相關要素的問題,而是必須在我們所有的情況和環境下建立一種‘確認並相信’的文化。”

二是運用人工智慧識別

有專家認為,由於Deepfake技術仍在不斷改進,最終會變得更加強大,以至於人類無法正確識別。但經過訓練的人工智慧可能會識別出深度偽造的行為,因為克隆受害者的面孔和聲音往往包含一些錯誤,例如數字噪音或人類不可能發出的一些聲音等。

三是加強個人資訊保護

有人認為,現在只需要5分鐘的樣本音訊,即可製造出合成語音;但也有部分人持不同意見,認為至少需要2至3個小時的音訊樣品,才能合成出像樣的深度假聲。這可能僅是一種對判斷Deepfake聲音的完成度存在分歧而已,歸根結底,虛假音影片的製作都必須以一定數量原聲素材為基礎。只要我們注意保護好個人資訊,不要將個人的音影片資料外洩,就會降低被利用的風險。

四是立法保護

僅在技術層面打擊這一技術的濫用是不夠的,我們還需要法律的支援。我國《民法典》之人格權編規定,任何組織或者個人不得以醜化、汙損,或者利用資訊科技手段偽造等方式侵害他人的肖像權。這意味著即便沒有營利目的和主觀惡意,未經本人同意的AI換臉和模仿聲音同樣有可能構成侵權。

另外,我國《網路音影片資訊服務管理規定》中,作為網路影片規範強化的要點,明確規定利用Deepfake或假想現實等技術進行的虛假音影片傳播的行為是非法的。

(資料來源:韓國安全新聞網站、軟體測試網、簡書等相關文章。本文參考內容均來源於網路,僅供讀者瞭解和掌握相關情況參考,不用於任何商業用途。如果相關作者認為摘選不妥,請聯絡我們刪除。)