10 月 19 號蘋果又開了一場釋出會,這次的新 MacBook Pro 確實足夠炸裂,英特爾原地爆炸。

兩款全新晶片 M1 Pro 和 M1 Max 的出現甚至讓我預見了未來 PC 陣營的洗牌,以後筆記本和桌面級晶片將會不斷的向 ARM 架構靠攏,這彷彿是改變世界的蘋果又回來了。

不能說是彷彿,其實在蘋果,那個滿腦子改變世界的喬布斯精神一直都在。

從 iPhone X 開始,蘋果就在為未來的技術預埋硬體,當時庫克在釋出會上說 2017 年時 iPhone 已經度過了第一個十年,而接下來的蘋果將進入下一個十年發展期。

這裡注意,下一個十年蘋果在做的可不只是醜陋的劉海和單純的技術迭代,而是已經在為下一個“one more thing”預埋技術。

它正在悄無聲息的佈局在 2017 年開始的每一部 iPhone 中,在其生效之時,iPhone8 開始的每一位使用者都能從中獲益!

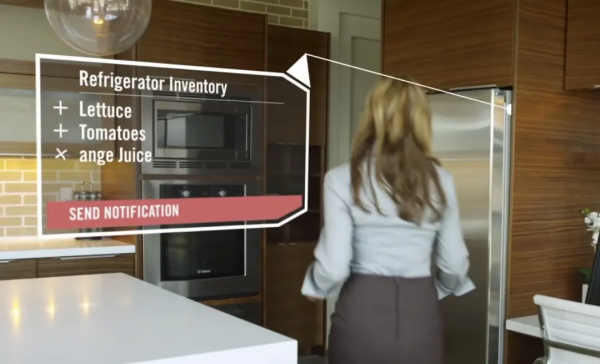

這個技術就是“AR 增強現實”技術,這個技術能將虛擬資訊與現實世界巧妙的融合,就如這臺虛擬的 iPhone13 Pro。

可別小看 AR 技術,這個能讓蘋果花大功夫深耕的東西必定不是泛泛之輩,未來輕量化 AR 眼鏡出現的時候,人們可以很自然的使用虛擬資訊與現實中的事物互動,這必將深刻改變我們的生活!

比如 AR 眼鏡可以直接在現實世界中新增地圖導航圖示和路況提醒,特別直觀,開車都不用聽地圖 APP 的語音和看手機了,蘋果佈局的這個技術,說是下一次“王炸”也不過分。

而且蘋果為未來的新功能預埋硬體,也不是一次兩次了,比如 AirPods Pro 中就預埋了剛釋出時用不到陀螺儀和 U1 晶片,於是……

一年後,你的 AirPods Pro 透過一個韌體更新突然支援了空間音訊。

兩年後,你的 AirPods Pro 透過一個韌體更新突然支援了離線定位功能。

AirPods Pro 使用者極度舒適。

那麼這裡我就為大家盤點一下蘋果為了佈局 AR 提前做了哪些事。

1.仿生晶片

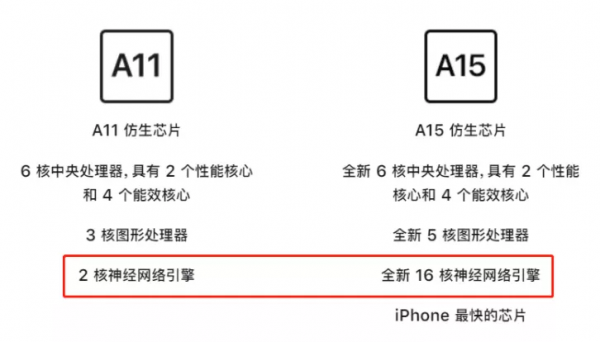

有留意的朋友可以發現,從 2017 年的 A11 開始,蘋果的晶片正式更名為“仿生晶片”。

具體表現就是加入了“神經網路引擎”,這玩意可以幫助手機完成一些機器學習的工作。

比如以前的手機識別一張照片,它只能識別出照片中每個畫素點的顏色,而無法識別照片中到底有什麼東西;

但是有了機器學習之後,手機就能“理解”照片中的事物了,比如圖中的人臉和手機,如果再“聰明”一點,或許還能分辨出周明的 iPhone13 Pro 是假的……

如果你持有仿生晶片的 iPhone 或者iPad,你可以透過設定開啟“旁白”功能,然後再開啟“放大器”APP,“放大器”就會語音朗讀出鏡頭所拍到的內容,人、物品和場景,甚至是天氣都能識別,這是一個盲人輔助功能,但是 A11 晶片之前版本的 iPhone 無法做到。

實際上這個功能CPU和GPU也能幹,只是效率太低了,一用手機就熱,專業的事就需要專業的“人”幹,從 A11 到 A15,“神經網路引擎”從 2 核升級到了 16 核,算力從 6000 億次每秒升級到 15.8 萬億次每秒,前後翻了 26 倍。

有人說蘋果為了數量極少的盲人能做這麼多,哎呦我真是太感動了。

但實際上這只是蘋果佈局 AR 過程中順手做的一件善事。

目前來看,“神經網路引擎”雖然還有別的功能,但對於一般人真的沒什麼用,即便是全部砍掉,我們也幾乎不會有感知,蘋果之所以費這麼大勁升級它的效能,唯一說得通的解釋就是:蘋果在為未來佈局。

AR需要將虛擬資訊與現實世界融合,就必須要讀懂畫面中事物。

2.LiDAR

iPad Pro2020/2021款、iPhone 12/13Pro 和 Pro Max 等旗艦產品上都搭載的 LiDAR 鏡頭,我們一般叫鐳射雷達,主要功能是測距和探測,1971 年阿波羅 15 號飛船就是用的這個技術掃描繪製了月球表面的影象。

可這玩意對普通人沒什麼用。

可巧的是蘋果的鐳射雷達依然是從 2017 年開始佈局的,2017 年,蘋果為菲尼薩公司(Finisar)投資了 3.9 億美元以研發鐳射雷達。

2020 款的 iPad Pro 搭載鐳射雷達時,蘋果就官宣了這是為 AR 技術而搭載,為此還未 iPad Pro 增加了一顆超廣角鏡頭以捕獲更寬廣的畫面。

而到了 2021 年,蘋果又給這家公司投了 4.1 億美元,目的是為了量產,按這個節點,明年 iPhone14 基礎款就能夠搭載鐳射雷達鏡頭了。

3.精確定位

也就是 U1 晶片,前邊的 AirPods Pro 已經提到過了,這是 iPhone11 上開始搭載的,作用就是精確定位,不論是座標還是方向,按蘋果的話說,就是“空間感知能力”。

這個就很好理解了,如果 AR 技術不能將現實中的物品精準,那體驗自然是很差的。

試想一下,你在玩遊戲的時候,你看到對手的模型跟他實際的位置是不一樣的,那還玩個毛。

4.Apple Watch手勢操作

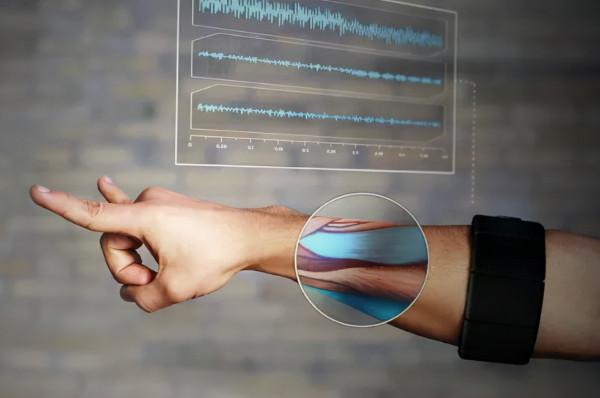

在 watchOS 8 更新後,Apple Watch 就增加了一個新功能:AssistiveTouch。

這個功能可以讓人們在不觸控顯示屏或任何按鍵的情況下,透過手勢操作 Apple Watch,手錶利用光學感測器、陀螺儀、加速計等感測器配合機器學習,識別出我們捏住、握緊這些動作。

於是我們就可以解放雙手了。

這個技術類似 MYO 腕帶,它可以用各種手勢玩遊戲、翻 PPT、操控無人機等,而且非常靈敏和準確。

目前的一些 AR 眼鏡是依靠捕獲手部的動作操控虛擬資訊,但前提條件是你的手必須在攝像頭範圍內,不光難受,侷限性還非常大。

為了解決這一問題,現在很多 AR 或 VR 裝置都會給你兩個傻大黑粗的操控器,但雙手依然無法解放。

如果將 Apple Watch 手勢操控的技術加入到 AR 領域,那麼對 AR 的互動升級將是翻天覆地的。

5.iGlasses

iGlasses 是蘋果 AR 眼鏡的暫定名稱,蘋果早在 2006 年就申請了相關專利,並在 2012 年曝光了這款眼鏡的概念圖,當時這款眼鏡在造型上還是蠻科幻的。

但現在都快 2022 年了,還是不見蹤影。

不過現在似乎又離釋出的日子不遠了,以最近曝光的蘋果 AR 眼鏡造型來說,可能會是這種普通眼鏡的造型,特別低調。

不過按這個體積,初代蘋果 AR 眼鏡應該跟初代 Apple Watch 一樣,算力全靠與之連線的 iPhone。

雖然對於蘋果的 AR,目前來說也只能是猜測,AR 技術對未來的影響有多大,我們不得而知,蘋果在幾乎沒有回報的情況下,不知做了多少年,就光是做這件事的魄力和定力,都是值得敬佩的。

很多人說蘋果在吃老本,我認為不對,蘋果正在使用者看不見的地方默默耕耘。

哪一天 AR 眼鏡真正成熟之後,蘋果就能依靠多年在裝置上預埋的硬體和龐大的使用者群體,快速的把新技術鋪開,將科技的便利第一時間帶給人們,而蘋果本身也能得到巨大的利潤。

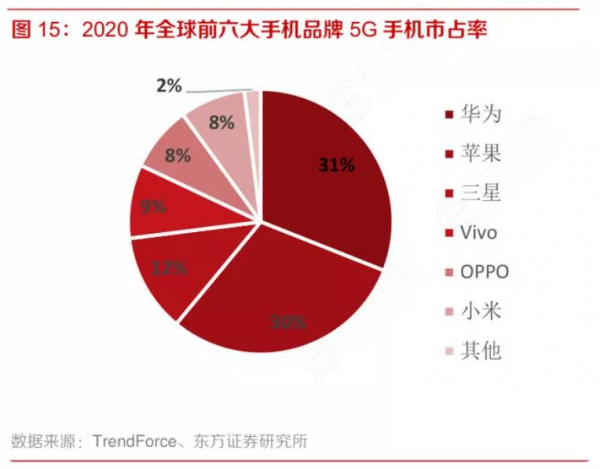

反觀國內的部分安卓廠商,只是在硬體上瘋狂堆料,一昧的賺快錢。

雖然我們國家有同樣魄力的華為,卻遭到了海外流氓無情的制裁,倘若哪天華為能衝破枷鎖,其涅槃之時,便是傲視群雄之日!

啟發

雖然說這件事跟我們老百姓關係不大,但我們也可以從裡面得到一些啟發。

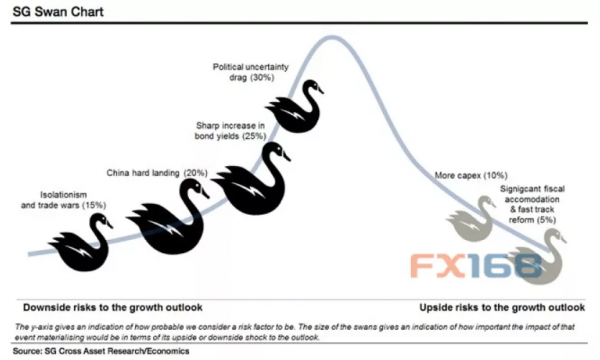

比如我們生活中很多進步都不是線性增長的,而是“跳躍式”進步的,比如掙錢這事,今年掙10萬,明天可能就直接翻倍掙20萬,後年突然又撞大運,可能做的專案火了,撞到了一隻“黑天鵝”啥的,一下子就掙100萬了。

而我們平時要做的,就是主動的去提高這種撞見“黑天鵝”的機率。

而對於我們來說,提高這個機率最簡單的方法就是多學習、多看書,多去做一些不同的事,厚積薄發!