論文標題:A Mesoscale Plasticity for Efficient AI Learning

在人工智慧領域,目前人工神經網路中被廣泛使用的反向傳播演算法(Backpropagation,BP)採用全域性最佳化策略,這種端到端的學習方法效能卓越,但學習過程能量消耗大,且缺乏靈活性。中科院腦智卓越中心徐波、蒲慕明聯合研究團隊近期藉助生物網路中發現的介觀尺度自組織反向傳播機制(Self-backpropagation,SBP),在更具效率和靈活性的類腦區域性學習方法方面取得了重要進展。

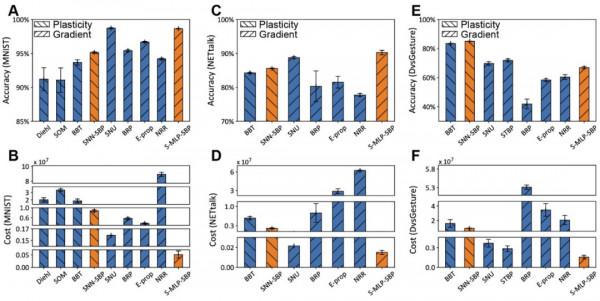

SBP的發現最早可以追溯到1997年。蒲慕明團隊在Nature雜誌上撰文發現海馬體內的神經元可以將長時程抑制(Long-term depression,LTD)可塑性自組織地傳播到三個方向,分別是突觸前側向傳播(Presynaptic lateral spread)、突觸後側向傳播(Postsynaptic lateral spread)、反向傳播(Backpropagation)[1],這個發現就是自組織反向傳播神經可塑性機制(SBP)。後續研究證實,SBP現象具有普遍性,不僅覆蓋更多的神經區域如視網膜-頂蓋系統[2],還覆蓋更多的可塑性型別[3],如長時程增強(Long-term potentiation,LTP)。該機制的發生歸結於生物神經元內分子調製訊號的天然逆向傳遞,被認為是可能導致生物神經網路高效反饋學習的關鍵[4]。研究團隊受到該機制的啟發,對SBP的反向傳播方向(第三個方向)單獨構建數學模型(圖1A),重點描述了神經元輸出突觸的可塑性可以反向傳播到輸入突觸中(圖1B),可塑性的發生可以透過時序依賴突觸可塑性(Spike timing-dependent plasticity,STDP),也可以透過人工區域性梯度調節。在標準三層脈衝神經網路(Spiking neural network,SNN)的學習過程中,SBP機制可以自組織地完成前一層網路權重的學習,且可以結合短時突觸可塑性(Short-term plasticity,STP)、膜電位平衡(Homeo-static membrane potential)等,形成更強大的SNN組合學習方法(圖1C)。在一類人工神經網路(Artificial neural network,ANN)如受限玻爾茲曼機網路(Restricted Boltzmann machine,RBM)的學習中(圖2A),SBP機制也可以替換迭代過程中部分BP機制,實現交替的協作最佳化(圖2B-E)。針對SNN和RBM的不同,團隊又分別設定了兩種不同的能量函式約束,來保證訓練過程中網路引數學習的平穩性。此外,研究團隊針對性地提出了一種統計訓練過程中能量消耗的新方法(圖3)。在圖片分類(MNIST)、語音識別(NETtalk)、動態手勢識別(DvsGesture)等多類標準資料集上,SBP機制透過組合其它可塑性機制,實現了更低能耗和更高精度的SNN區域性學習(圖4)。在ANN-RBM的學習中,SBP機制也可以大量的替換BP機制實現全域性和區域性交叉學習,在降低計算能耗同時卻不損失精度(圖5)。研究人員認為,SBP是一類介觀尺度的特殊生物可塑性機制,該機制同時在SNN和ANN中獲得了廣泛的組合最佳化優勢,對進一步深入探索類腦區域性計算具有很大的啟示性。生物智慧計算的本質,很可能就是靈活融合多類微觀、介觀等可塑性機制的自組織區域性學習,結合遺傳演化賦予的遠端投射網路結構,實現高效的全域性最佳化學習效果。該工作可以進一步引導生物和人工網路的深度融合,最終實現能效比高、可解釋性強、靈活度高的新一代人工智慧模型。相關工作(Self-backpropagation of synaptic modifications elevates the efficiency of spiking and artificial neural networks)於2021年10月20日(美東時間)線上發表於《科學》子刊《Science Advances》上。中國科學院自動化研究所類腦智慧研究中心張鐵林副研究員為第一作者,徐波研究員為通訊作者,程翔(博士生)、賈順程(博士生)、蒲慕明研究員和曾毅研究員為共同作者。相關研究工作得到了國家自然科學基金委、先導B等專案的資助。

相關論文地址見:https://www.science.org/doi/10.1126/sciadv.abh0146

(A),SBP可塑性機制。(B),SBP在SNN中的區域性反向傳播。(C),SBP和其它可塑性機制在SNN中的組合最佳化。

(A),SBP和BP在RBM中的組合最佳化。(B),SBP和BP的交替協作流程。(C),RBM中的標準Sleep Phase。(D),含有SBP的Wake Phase。(E),含有BP的Wake Phase。

(A),平均迭代次數。(B),每次迭代中的演算法複雜度。

圖4:在MNIST、NETtalk、DvsGesture三個資料集上的效能對比。

(A,C,E),SBP分別取得了基於梯度和基於可塑性方法的SNN最優效能。(B,D,F),SBP分別取得了基於梯度和基於可塑性方法的SNN最低能耗。

(A-C),在MNIST資料集中,SBP可以少量降低RBM的訓練誤差(A),可以同時平衡精度和能耗得到最優的Wake Phase次數(B),且可以顯著降低訓練能耗(C)。(D-I),在NETtalk和DvsGesture資料集中,SBP得到了和在MNIST中類似的結論。

參考文獻:

[1] Fitzsimonds, R. M., Song, H. J. & Poo, M. M. Propagation of activity-dependent synaptic depression in simple neural networks. Nature 388, 439-448, (1997).

[2] Du, J. L. & Poo, M. M. Rapid BDNF-induced retrograde synaptic modification in a developing retinotectal system. Nature 429, 878-883, (2004).

[3] Du, J. L., Wei, H. P., Wang, Z. R., Wong, S. T. & Poo, M. M. Long-range retrograde spread of LTP and LTD from optic tectum to retina. Proceedings of the National Academy of Sciences of the United States of America 106, 18890-18896, (2009).

[4] Bi, G. & Poo, M. Synaptic modification by correlated activity: Hebb's postulate revisited. Annual Review of Neuroscience, 24, 139-166, (2001).