來源:Facebook AI

編輯:LRS

【新智元導讀】長久以來CV的訓練一直停留在二維資料上,三維資料因為標註成本高等原因都需要專業人員來開發專用模型。Facebook在ICCV 2021 釋出兩個3D模型3DETR和DepthContrast,將模型的通用性全面升級,也許標誌著CV研究全面進入三維時代!

從大規模的資料中進行預訓練,在計算機視覺中得到了廣泛應用,也是在特定任務上得到高效能模型的基礎。

但這種方法有一個致命缺陷,那就是如果目標資料型別還沒有大量標註資料的話,就沒辦法使用這種模式。

例如3D 掃描、識別的標註資料集就很稀缺,主要是因為3D 資料集的標註十分耗時,並且用於 3D 理解的模型通常依賴於與用於訓練的特定 3D 資料集的手工架構設計。

在 ICCV 2021 上,Facebook AI提出了兩個新模型3DETR和DepthContrast,這兩個互補的新模型可促進3D理解並更容易上手。新模型建立了簡化的3D理解的通用架構,並且能夠透過不需要標籤的自監督學習方法來解決這些問題。

程式碼目前也已開源。

出於各種原因,目前的CV 模型還主要集中在二維圖片,但構建機器以瞭解有關世界的 3D 資料非常重要。例如自動駕駛汽車需要 3D 理解才能移動並避免撞到障礙物,而 AR/VR 應用程式可以幫助人們完成實際任務,例如可以視覺化沙發是否適合客廳。

來自 2D 影象和影片的資料表示為規則的畫素網格,而 3D 資料則反映為點座標。由於 3D 資料更難獲取和標記,因此 3D 資料集通常也比影象和影片資料集小得多。這意味著它們通常在整體大小和它們包含的類或概念的數量方面受到限制。

以前,專注於 3D 理解的從業者需要大量的領域知識來調整標準的 CV 架構。單檢視 3D 資料(取自一臺同時記錄深度資訊的相機)比多檢視 3D 更容易收集,後者利用兩個或更多相機記錄同一場景。多檢視3D資料往往是透過對單檢視3D進行後處理生成的,但是這個處理步驟有失敗的可能,一些研究人員估計,由於源影象模糊或相機運動過度等原因,這個失敗率可能高達 78%。

DepthContrast 主要解決了這些資料上的問題,因為它可以從任何 3D 資料(無論是單檢視還是多檢視)訓練自監督模型,因此消除了處理小型未標記資料集的挑戰。一般的CV 模型即使是對大量 2D 影象或影片進行預訓練也不太可能為 AR/VR 等複雜應用產生準確的 3D 理解。

https://arxiv.org/abs/2101.02691

自監督學習一直是研究界和FAIR的主要興趣領域, DepthContrast也是業界在不使用標記資料的情況下學習強大3D表示的最新嘗試。這項研究繼承自FAIR 之前的工作PointContrast,也是3D的一種自我監督技術。

現在獲得3D資料的機會很多。感測器和多檢視立體演算法通常為影片或影象提供補充資訊。然而,理解這些資料以前一直是一個挑戰,因為3D資料具有不同的物理特性,這取決於它的獲取方式和位置。

例如,與來自室外感測器(如 LiDAR)的資料相比,來自商用手機感測器的深度資料看起來非常不同。AI研究中使用的大多數3D資料都是以單檢視深度圖的形式獲取的,這些資料透過為3D registration的步驟進行後處理以獲得多檢視3D。先前的工作依賴於多檢視3D資料來學習自監督特徵,訓練目標主要考慮3D點對應關係。

雖然將單檢視資料轉換為多檢視資料的失敗率很高,但DepthContrast表明僅使用單檢視3D資料就足以學習最先進的3D特徵。

使用3D資料增強可以從單檢視深度圖生成略有不同的3D深度圖。DepthContrast透過使用對比學習來對齊從這些增強深度圖獲得的特徵來實現這一點。

並且研究結果表明該學習訊號可用於預訓練不同型別的3D架構,例如PointNet++和Sparse ConvNets。

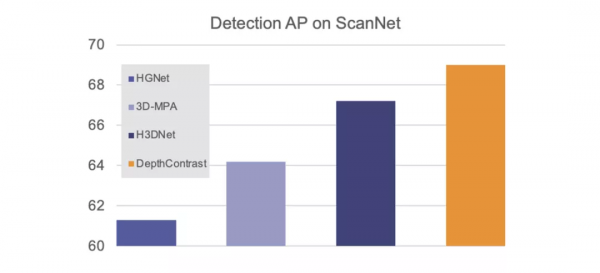

更重要的是,DepthContrast可以應用於任何型別的3D資料,無論是在室內還是室外,單檢視還是多檢視。我們的研究表明,使用DepthContrast預訓練的模型在ScanNet 3D檢測基準上絕對是最先進的。

DepthContrast的功能在形狀分類、物件檢測和分割等任務的各種3D基準測試中提供了增益。

DepthContrast表明自監督學習也有希望用於3D理解。事實上,DepthContrast分享了學習增強不變特徵的基本原理,該原理已被用於支援自監督模型,例如Facebook AI的SEER。

第二個工作3DETR是3D Detection Transformer的縮寫。該模型是一種基於Transformer的簡單三維檢測和分類架構,可作為檢測和分類任務的通用三維模型,該模型簡化了用於訓練3D檢測模型的損失函式,更容易實現。它的效能也相當於或超過了依賴於手動調整的3D架構和損耗函式的現有最先進的方法。

https://arxiv.org/abs/2109.08141

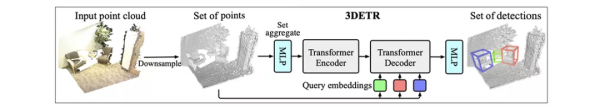

3DETR將三維場景(表示為點雲或一組XYZ點座標)作為輸入,併為場景中的物件生成一組三維邊界框。這項新的研究建立在VoteNet和Detection Transformers(DETR)的基礎上,其中VoteNet是FAIR在3D點雲中檢測物體的模型,DETR是Facebook AI為重新定義物體檢測挑戰而建立的一種更簡單的架構。

為了實現2D檢測的飛躍,Facebook AI之前的研究確定了兩個重要的變化,需要解決Transformer的3D理解工作,還需要非引數查詢嵌入和傅立葉編碼。因為點雲在大量空白空間和噪聲點之間具有不同的密度,所以這兩種設計決策都是必需的。

3DETR使用兩種技術來處理此問題,與DETR和其他變壓器模型/DETR中使用的標準(正弦)嵌入相比,傅立葉編碼是表示XYZ座標的更好方法。

其次,DETR使用一組固定的引數(稱為查詢)來預測物件的位置,研究結果發現此設計決策不適用於點雲。取而代之的是,我們從場景中取樣隨機點,並預測相對於這些點的物件。實際上沒有一組固定的引數來預測位置,而是隨機點取樣適應3D點雲的不同密度。

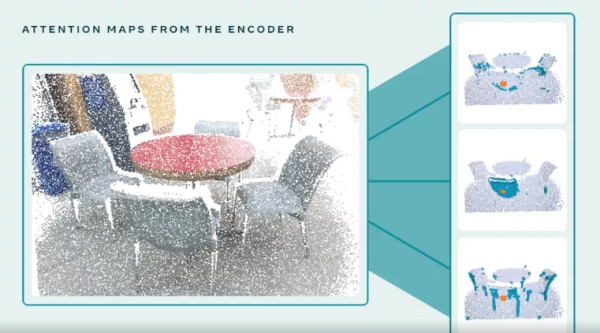

使用點雲輸入,Transformer編碼器生成場景中物件形狀和位置的座標表示透過一系列的自注意操作來捕獲識別所需的全域性和區域性上下文。例如,它可以檢測3D場景的幾何特性如放置在圓桌周圍的椅子的腿和靠背。

Transformer解碼器將這些點特徵作為輸入並輸出一組 3D 邊界框,它對點特徵和查詢嵌入應用了一系列交叉注意操作。解碼器的自注意力表明它專注於物件以預測它們周圍的邊界框。

Transformer編碼器也足夠通用,可以用於其他3D任務,例如形狀分類。

總的來說,3DETR比之前的工作更容易實現。在3D基準測試中,3DETR的效能與之前手工製作的3D架構相比也有優勢。它的設計決策也與之前的3D工作相容,使研究人員能夠靈活地將3DETR中的元件適應他們自己的pipeline。

從幫助機器人導航世界到為使用智慧手機和未來裝置(如AR眼鏡)的人們帶來豐富的新VR/AR體驗,這些模型都具有巨大的潛力。

隨著手機中3D感測器的普及,研究人員甚至可以從自己的裝置上獲取單檢視3D資料來訓練模型。深度對比技術是以自我監督的方式使用這些資料的第一步。透過處理單檢視和多檢視資料型別,DepthContrast大大增加了3D自監督學習的潛在使用案例。

自監督學習仍然是跨文字、影象和影片學習表示的強大工具。現在,大多數智慧手機都配備了深度感測器,這為提高3D理解和創造更多人可以享受的新體驗提供了重要機會。

參考資料:

https://ai.facebook.com/blog/simplifying-3d-understanding-using-self-supervised-learning-and-transformers/