在最近的一次深入採訪中,蘋果高管談到了iPhone 13系列新電影模式。蘋果公司全球產品營銷副總裁Kaiann Drance和人機介面團隊設計師Johnnie Manzari與TechCrunch談論了電影模式以及公司如何在沒有明確目標的情況下執行這個想法。

Johnnie Manzari表示:“我們沒有一個關於該功能的想法,我們只是好奇電影製作,這就導致了這條有趣的道路,然後我們開始學習更多的東西,並與整個公司的人進行更多的交流,以幫助我們解決這些問題。”

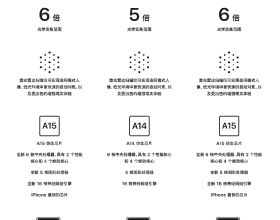

Kaiann Drance表示,該功能在很大程度上依賴於蘋果新的A15仿生晶片和神經引擎。為影片帶來高質量的深度,比照片要難得多。與照片不同,影片被設計為隨著拍攝者的移動而移動,包括手的抖動,這意味著蘋果將需要更高質量的深度資料,以便電影模式可以跨主體、人、寵物和物體工作,而且蘋果需要這種深度資料不斷地跟上每一幀。實時渲染這些自動對焦的變化是一個沉重的計算工作負荷。

在開始研究電影模式之前,蘋果團隊花時間研究電影攝影技術,以瞭解更多關於焦點轉換和其他光學特性。該團隊一開始就對影象和電影製作的歷史有著深深的敬畏和尊重。當他們開發"Portrait Lightning"概念時,蘋果設計團隊研究了安迪-沃霍爾等經典肖像藝術家和倫勃朗等畫家。

電影模式的開發過程也是如此,團隊與世界上一些最好的電影攝影師和攝像師進行了交流。然後他們繼續與攝影指導、攝像師和其他電影製作專業人士合作。當然,蘋果設計師意識到,這些技術需要高水平的技能,不是一般iPhone使用者可以輕易做到的。

這就是蘋果公司的作用。該公司解決了技術問題,並透過凝視檢測等修復手段解決了問題。有些問題是透過機器學習解決的,這就是為什麼該模式在很大程度上依賴於iPhone內建的神經引擎。這種型別的功能開發代表了蘋果所能提供最好的東西。