公平性學習在近些年來受到學術界和工業界的廣泛關注,其旨在於保護或隱藏某些敏感屬性(例如,性別、種族、地域)並同時保持原有的學習效用。在本次講座中,作者簡單介紹了不同公平性定義,並聚焦於群組公平性,並介紹群組公平性在聚類分析、異常點檢測和屬性選擇中的應用。

本期AI TIME 青年科學家系列,直播間邀請到了美國布蘭迪斯大學計算機系助理教授劉洪甫,帶來分享——《無監督學習的公平性研究》。

嘉賓介紹

劉洪甫:美國布蘭迪斯大學計算機系助理教授,於2011年和2014年分別獲得北京航空航大大學經濟管理學院資訊管理與資訊系統學士和管理科學與工程專業碩士學位。同年,換專業攻讀美國東北大學計算機工程專業博士。二年半完成博上學業後,加入美國布蘭迪斯大學(波士頓五大名校之一, Us News排名Top 42)計算機系。主要研究方向為人工智慧、機器學習、資料挖制。目前已經成功發表頂級會議和期刊論文60餘篇;現為人工智慧、機器學習,資料探勘等領域的頂級會議期刊常駐審稿人。

背 景

1

什麼是公平性?

在機器學習中,當資料集中包含敏感屬性集(比如性別、種族、地域等)時,不同的場景下相同演算法的預測結果可能是把不同的。公平性學習是在保護或隱藏某些敏感屬性並同時保持原有的學習效用。

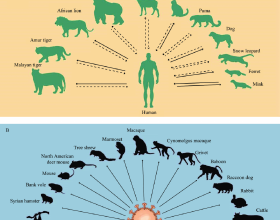

舉個例子,無監督學習中的聚類分析演算法是把樣本點聚成不同的簇群(clusters),使得每個簇群的樣本點儘可能地相似,不同簇群的樣本點儘可能相異,即類內距離儘可能小,類間距離儘可能大。而公平性聚類分析中,我們希望每個簇群的敏感屬性(sensitive attributes)的分佈要儘可能均勻,比如一個簇群中男女比例儘可能均衡,這樣就可以隱藏“性別”這個敏感屬性,使得這個簇群不會受到攻擊;反之,如果一個簇群中全是男性,那就得到這個簇群的敏感屬性(性別)的分佈,那就可以在樣本點中新增基於該敏感屬性的干擾,攻擊該模型。

公平性的定義是很寬泛的,敏感屬性除了性別、種族等,還可以是一些常見的屬性。比如在交通系統的車輛識別場景下,車輛的顏色可以看作一個敏感屬性,那公平性就體現在識別時不會因為車輛顏色而使演算法的效率改變。

2

公平性分類

前面提到了一些公平性的例子,但具體公平性的定義就有很多種,包括individual fairness,group fairness,Equalized odds等等,本次分享主要是基於group fairness所定義的公平性,下面介紹一下individual fairness和group fairness的定義。

(1)individual fairness

individual fairness是基於單個樣本點而言的,公平性定義為如果樣本點a和樣本點b各項屬性都是很相近的,那這兩個樣本點的分類決策結果也需要很相近。距離就是假設舞蹈生a和舞蹈生b的舞蹈水平相近,a和b分別來自兩個不同的省份,那a和b都要被某所藝術學校錄取或者不錄取。

(2)group fairness

假設S是一個敏感屬性,基於group fairness來講,公平性就是對於S和非 S兩個群體的個體來說,被分配到各個類別的比例是一樣的。舉例就算之前的性別的例子,對於一個簇群,男女比例是均衡的,即男性或女性不會影響是否被分配到該簇群。

公平性的定義

3

實現公平性的技術方法

實現公平性的技術可以稱為fairness/debiasing techniques。導致不公平的原因不是唯一的,資料集的不平衡(男女比例不均衡)以及演算法模型本身有偏差都會導致最終分類決策的結果不公平。解決不公平性大致有三種方式

(1) Pre-pocessing——Focus on data bias:透過加權、資料生成等進行資料預處理來生成樣本均衡的資料集。

(2) In-processing——將公平性學習於演算法結合在一起,實現一個公平性演算法模型。

(3) Post-processing——使用傳統unfair的演算法模型得到分類預測結果,然後對結果進行修正。

1、 公平性的評價指標

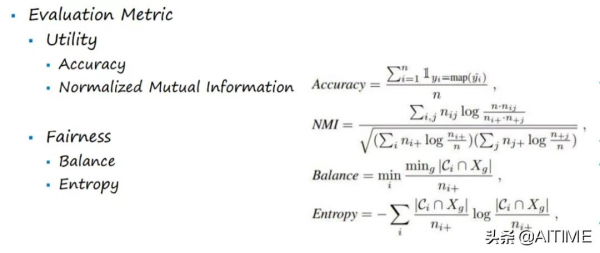

採用Utility和Fairness兩個評價指標,既要考慮實現公平性之後演算法模型與之前對比的學習效益變化,也要考慮模型實現的公平程度。

公平性聚類分析

聚類分析是一個應用很廣泛的機器學習演算法方向,比如客戶分群,城市規劃,異常點檢測等等。

聚類的應用舉例

1

什麼是公平性聚類分析?

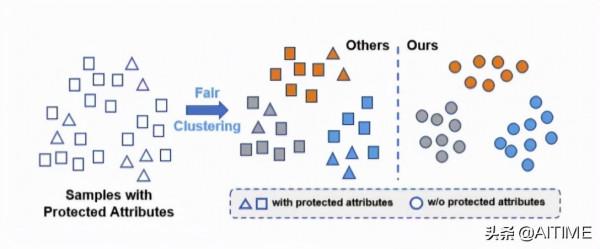

公平性聚類分析旨在隱藏或保護敏感屬性,使得聚類的結果的每個簇群中的敏感屬性都比例均衡。如下圖所示,未經公平性聚類的簇群(Others)中敏感屬性的分佈是不均衡的,而經過公平性聚類的簇群隱藏了敏感屬性。

公平性聚類

2

公平性聚類方法

傳統的公平性研究會把公平性聚類歸納為Constrained Clustering(受限聚類),首先我們需要一個好的聚類結果,然後滿足一定限制,並在原來的樣本空間進行聚類。

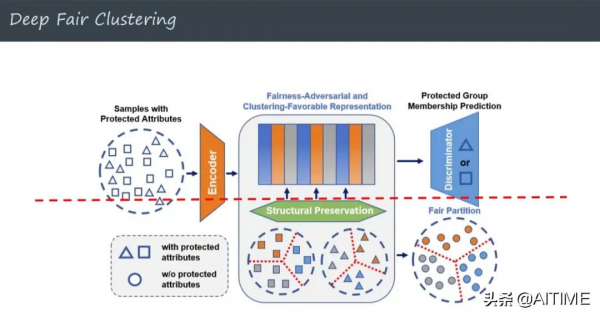

引入深度學習之後,考慮利用Encoder(編碼器)進行特徵學習,將一個空間下的特徵轉換到另一個空間,從而得到保護敏感屬性的特徵表示。後面接入一個Discriminator(判別器)來判斷是否能對敏感屬性有所區別。這裡面存在一個tradeoff:假設所有的input透過Encoder之後都轉換為相同的特徵時,敏感屬性和非敏感屬性都會被隱藏掉,那最終聚類結果也會很差,即公平性指標中的Utility指標下降到極點;假設所有的input透過Encoder之後經Discriminator仍然能判斷出敏感屬性的特徵,那說明Fairness指標也未提高。

Deep fair clustering中提出一個structural preservation結構來解決上述的tradeoff問題,其原理是將敏感屬性中每個屬性值的樣本點都進行一個聚類,期望所有樣本點一起聚類的結果與敏感屬性中每個屬性值的樣本點的聚類結果相近。

Deep fair clustering

下面是Deep fair clustering的目標函式:

Deep fair clustering最最佳化公式表示

3

Deep fair clustering實驗

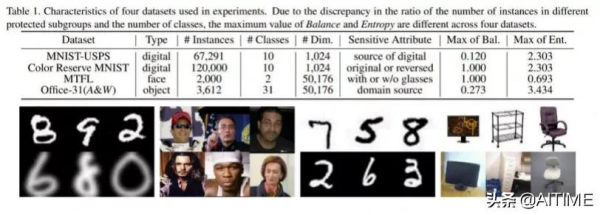

資料集:

Table1指出了採用的資料集和不同資料集的敏感屬性等資訊。

評價指標:

公平性評價指標

實驗結果:

在4個數據集中都採用傳統方式和深度學習進行實驗結果對比。深度學習的方式明顯要由於傳統的受限聚類。

論文:Deep Fair Clustering for Visual Learning [CVPR-20]

公平性異常點檢測

異常點檢測的應用場景也很多,例如銀行卡詐騙,網路入侵,高質量客戶挖掘等。對於無監督異常點檢測有兩種方式:Hard和Soft。Hard是給出兩種結果——是異常點,不是異常點;Soft是會對樣本點進行打分排序,透過閾值區分是否為異常點。

異常點示意圖

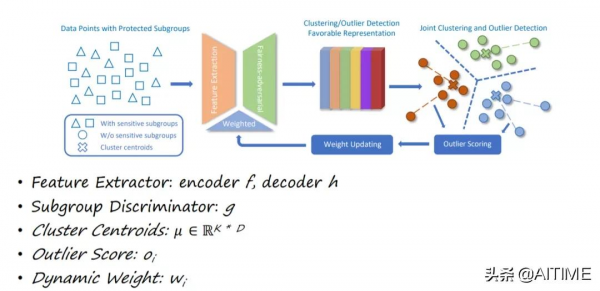

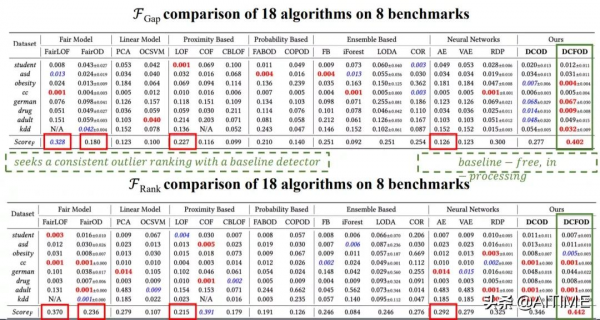

公平性異常點檢測模型採用特徵學習和公平對抗訓練,透過動態權重調節異常點對聚類的不利影響。透過提出兩個公平性指標來加強異常點檢測中的公平性度量,這兩個指標用於測試檢測到的異常點中的子群精度差距和子群分佈偏移。在8個真實公共資料集上進行的大量實驗表明,在與17種無監督離群點檢測方法的競爭中,DCFOD(Deep Clustering based Fair Outlier Detection)方法在所有指標上都具有明顯的優勢,包括最近提出的公平異常點檢測方法和其他傳統離群點檢測演算法。

下面就是DCFOD演算法的框架,首先將將樣本點經過Encoder轉換到另一個空間,而後進行特徵對抗來隱藏敏感屬性。然後對新生成的特徵進行聚類,將每個簇群中的樣本點與聚類中心的距離進行排序,離聚類中心較遠的點就看作異常點。異常點被設定低的權重,然後反饋到前面的特徵轉換的過程。

演算法框架

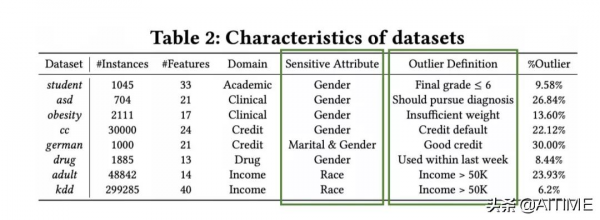

資料集:

對比分析方法:

評價指標:

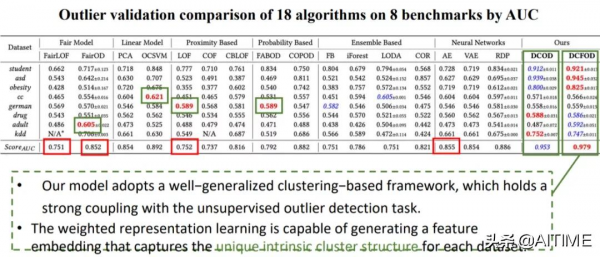

實驗結果:

可以看出,論文中的演算法模型在以上兩個評價指標的效果都是非常優秀的,都在0.95+。

公平性特徵選擇

特徵轉換將一個空間的特徵轉換到另一個空間,原則上會相對特徵選擇對樣本點的特徵進行更好的公平性解釋。而特徵選擇會保留原始特徵的解釋,比如使用主成分分析(PCA)進行降維後並不理解特徵表達的具體含義。

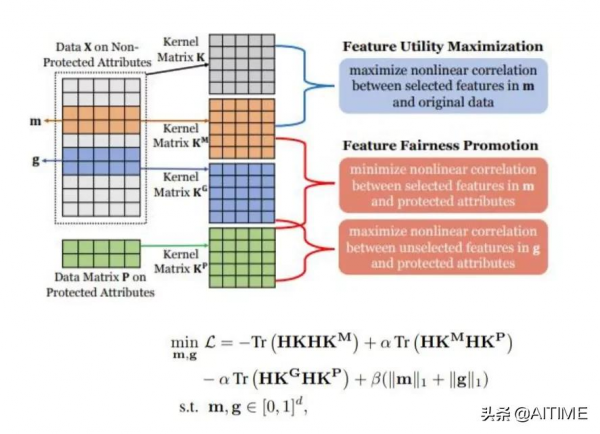

下圖描述了論文公平性特徵選擇的過程和相關損失函式,我們期望選擇的特徵是對演算法用支援作用的,並且與敏感屬性儘可能無關,而未選擇的特徵與敏感屬性儘可能相關。

資料集和評價指標:

實驗結果:

論文:Fairness-Aware Unsupervised Feature Selection [CIKM-21]

關於二元公平性:

探索和減少圖連線中的偏差

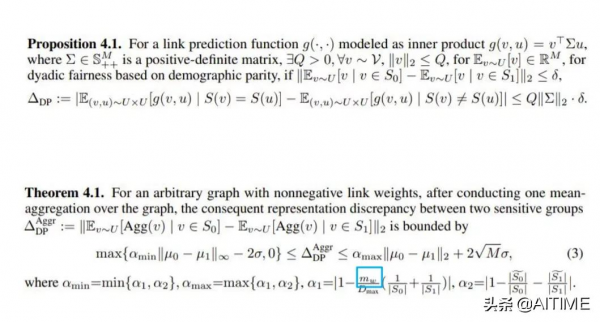

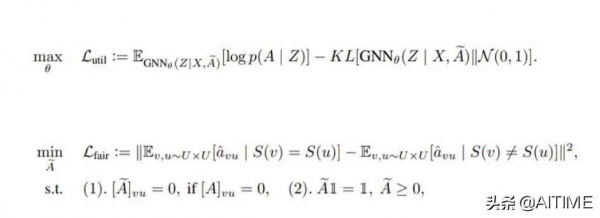

前面三篇論文是針對向量資料進行的group fairness的研究,現在是基於圖資料進行的二元公平性(Dyadic Fairness)的研究分析。我們研究了基於圖資料的link prediction。

Dyadic Fairness定義

下圖的公式具體解釋了圖的連結如何影響公平性:

公平性圖連線:

實驗結果:

論文在不同的資料集都進行了統計分析,其中在UNC28這個資料集上進行了不同二元公平性圖連線的對比實驗。

論文:On Dyadic Fairness: Exploring and Mitigating Bias in Graph Connections[ICLR-2020]

總結

本次分享我們主要關注群組公平性的研究,從聚類分析、異常點檢測、特徵選擇三個方向來介紹無監督群組公平性的實現方法,並都取得了不錯的結果。