機器之心釋出

機器之心編輯部

清華大學和位元組跳動智慧創作語音團隊業內首次提出神經網路配音器,讓 AI 根據配音指令碼,自動生成與畫面節奏同步的高質量配音。

影視配音是一項技術含量很高的專業技能。專業配音演員的聲音演繹往往讓人印象深刻。現在,AI 也有望自動實現這種能力。

近期,清華大學和位元組跳動智慧創作語音團隊業內首次提出了神經網路配音器(Neural Dubber)。這項研究能讓 AI 根據配音指令碼,自動生成與畫面節奏同步的高質量配音。相關論文 Neural Dubber: Dubbing for Videos According to Scripts 已入選機器學習和計算神經科學領域頂級學術會議 NeurIPS 2021。

- 論文地址:https://arxiv.org/abs/2110.08243

- 專案主頁:https://tsinghua-mars-lab.github.io/NeuralDubber/

配音(Dubbing)廣泛用於電影和影片的後期製作,具體指的是在安靜的環境(即錄音室)中重新錄製演員對話的後期製作過程。配音常見於兩大應用場景:第一個是替換拍攝時錄製的對話,如拍攝場景下錄製的語音音質不佳,又或者出於某種原因演員只是對了口型,聲音需要事後配上;第二個是對譯製片配音,例如,為了便於中國觀眾欣賞,將其他語言的影片翻譯並配音為中文。

清華大學和位元組跳動智慧創作語音團隊的這項研究主要關注第一個應用場景,即 “自動對話替換(ADR)”。在這一場景下,專業的配音演員觀看預先錄製的影片中的表演,並用適當的韻律(例如重音、語調和節奏)重新錄製每一句臺詞,使他們的講話與預先錄製的影片同步。

為了實現上述目標,該團隊定義了一個新的任務,自動影片配音(Automatic Video Dubbing, AVD), 從給定文字和給定影片中合成與該影片時序上同步的語音。

此前,行業內的很多研究是,根據給定語音生成與之同步的說話人的面部影片(Talking Face Generation)。而 AVD 任務正好相反,是用於生成與影片同步的語音,更加適用於真實的應用場景,因為影視作品拍攝的影片往往質量很高,並不希望再對其進行修改。

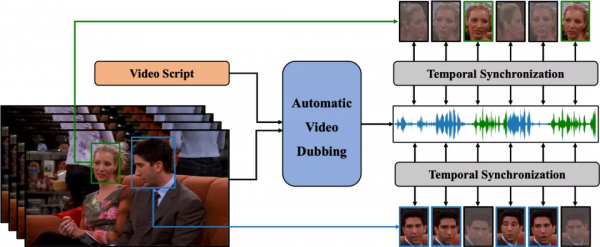

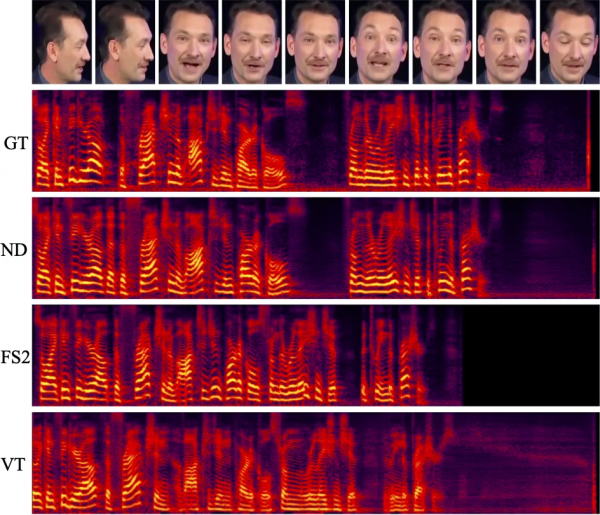

圖 1:自動影片配音(AVD)任務示意圖。給定文字和影片作為輸入,AVD 任務旨在合成與影片在時間上同步的語音。這是兩個人互相交談的場景。面部圖片是灰色的,表示當時這個人沒有說話。

清華大學和位元組跳動智慧創作語音團隊提出的神經網路配音器(Neural Dubber)旨在解決自動影片配音(AVD)任務。這是第一個解決 AVD 任務的神經網路模型:能夠從文字中端到端地並行合成與給定影片同步的高質量語音。神經網路配音器是一種多模態文字到語音 (TTS) 模型,它利用影片中的嘴部運動來控制生成語音的韻律,以達到語音和影片同步的目的。此外,該工作還針對多說話人場景開發了基於影象的說話人嵌入 (ISE) 模組,該模組使神經網路配音器能夠根據說話人的面部生成具有合理音色的語音。

具體的技術方法如下:

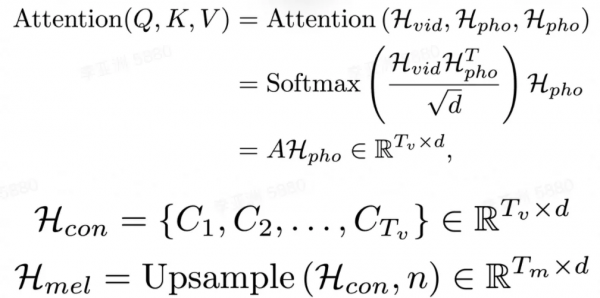

神經網路配音器(Neural Dubber)將 AVD 任務具體建模成如下形式:給定音素序列和影片幀序列,模型需要預測與影片同步的梅爾頻譜序列。

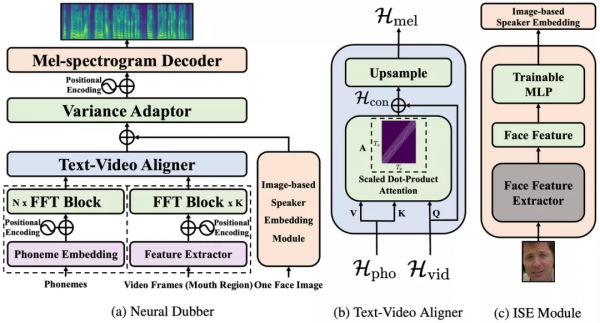

圖 2:神經網路配音器(Neural Dubber)的模型結構。

神經網路配音器(Neural Dubber)的整體模型結構如圖 2 所示。首先,神經網路配音器應用音素編碼器和影片編碼器分別處理音素序列和影片幀序列。編碼後,音素序列變成音素隱表示序列,影片幀序列變成影片隱表示序列。然後,音素隱表示序列和影片隱表示序列被輸入到文字影片對齊器(Text-Video Aligner),得到經過擴充套件後的梅爾頻譜隱表示序列,它與目標梅爾頻譜序列的長度相同。該工作在文字影片對齊器中解決了音素和梅爾頻譜序列長度不一致的問題。在多說話人場景時,模型會從影片幀序列中隨機選擇的一張人臉影象,輸入到基於影象的說話人嵌入(Image-based Speaker Embedding, ISE)模組以生成基於影象的說話人嵌入。梅爾頻譜隱表示序列會與 ISE 相加,並輸入到可變資訊介面卡(Variance Adaptor)中以新增一些方差資訊(例如,音高、音量(頻譜能量))。最後,梅爾頻譜解碼器(Mel-spectrogram Decoder)將隱表示序列轉換為梅爾頻譜序列。

文字影片對齊器(Text-Video Aligner)

文字影片對齊器(圖 2(b))可以找到文字和嘴部運動之間的對應關係,利用這種對應關係可以進一步生成與影片同步的語音。

在文字影片對齊器中,注意力模組學習音素序列和影片幀序列之間的對齊方式,並生成文字影片上下文特徵序列。然後執行上取樣操作以將此序列從與影片幀序列一樣長擴充套件到與目標梅爾頻譜序列一樣長。

注意力模組中,影片隱表示序列用作查詢。因此,注意力權重由影片顯式地控制,並實現了影片幀和音素之間的時序對齊。獲得的影片幀和音素之間的單調對齊有助於合成出的語音在細粒度(音素)級別上和影片同步。

之後,將文字影片上下文特徵序列擴充套件到與目標梅爾頻譜序列一樣的長度。這樣音素和梅爾頻譜序列之間的長度不匹配問題,就在沒有音素和梅爾頻譜細粒度對齊監督的情況下得到解決。由於影片幀和音素之間的注意力機制,合成語音的速度和韻律由輸入影片顯式地控制,使得能夠合成與影片同步的語音。

基於影象的說話人嵌入(Image-based Speaker Embedding)

在真實的配音場景中,配音演員需要為不同的表演者改變音色。為了更好地模擬 AVD 任務的真實情況,該研究提出了基於影象的說話人嵌入模組(圖 2(c)),目標是在多說話人的場景中利用說話人的面部特徵對合成語音進行不同音色的調節。就像人們可以從他人的外表(性別、年齡等)大致推斷出對方說話的音色。

基於影象的說話人嵌入是一種新型的多模態說話人嵌入,能夠從人臉圖片生成說話人嵌入,該嵌入蘊含了影象中所能體現的說話人的聲音特徵。ISE 模組利用影片中人臉和語音的天然對應關係,採用自監督的方式進行訓練,不需要說話人身份的監督。ISE 模組學習到人臉和聲音特徵的相關性,讓神經網路配音器(Neural Dubber)能夠產生具有合理音色的語音。合理指的是聲音特徵與從說話人面部推斷出的各種屬性(例如,性別和年齡等)相符。

實驗和結果

在單說話人資料集 Chemistry Lectures 和多說話人資料集 LRS2 上的實驗表明,神經網路配音器(Neural Dubber)可以生成與 SOTA 的 TTS 模型在音質方面相當的語音。最重要的是,定性和定量評估都表明,神經網路配音器可以透過影片控制合成語音的韻律,並生成與影片同步的高質量語音。

評價指標

由於 AVD 任務旨在給定文字和影片合成與該影片同步的語音,因此語音質量和音影片同步度是重要的評估標準。定性評價上,該研究在測試集進行平均意見分數(MOS)評估,以衡量語音質量和音影片同步度。定量評價上,該研究採用兩個指標:Lip Sync Error - Distance (LSE-D) 和 Lip Sync Error - Confidence (LSE-C)。

單說話人場景

研究者首先在單說話人資料集上進行實驗,將 Neural Dubber 與以下幾個系統進行比較,包括 1) GT,真實音影片資料;2) GT (Mel + PWG),先將真實音訊轉換為梅爾頻譜圖,然後使用 Parallel WaveGAN (PWG) 將其轉換回音訊;3) FastSpeech 2 (Mel + PWG);4) Video-based Tacotron (Mel + PWG)。為了進行公平比較,2)、3)、4) 和 Neural Dubber 中的使用相同預訓練的 Parallel WaveGAN。

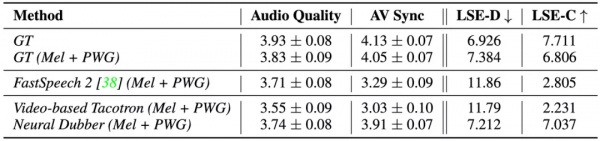

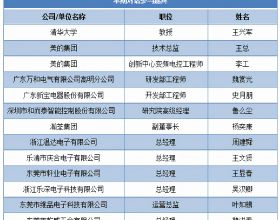

表 1:單說話人場景下自動影片配音的測評結果。

從結果(如表 1 所示)可以看出,Neural Dubber 在音訊質量上與 FastSpeech 2 不相上下,這表明 Neural Dubber 可以合成高質量的語音。此外,在音影片同步度方面,Neural Dubber 明顯優於 FastSpeech 2 和 Video-based Tacotron,而且與 GT (Mel + PWG) 系統相媲美,這表明 Neural Dubber 可以用影片控制語音的韻律並生成與影片同步的語音。然而, FastSpeech 2 和 Video-based Tacotron 都無法生成與影片同步的語音。

圖 3: 由以下系統合成的音訊的梅爾頻譜圖:Ground Truth (GT)、Neural Dubber (ND)、FastSpeech 2 (FS2) 和 Video-based Tacotron (VT)。

圖 3 展示了一個定性比較,其中包含由上述系統生成的音訊的梅爾頻譜圖。結果表明 Neural Dubber 生成的音訊的韻律十分接近於真實音訊的韻律,即與影片同步度很高。

多說話人場景

該研究還在多說話人資料集 LRS2 上進行了相同的定性和定量評估。

表 2: 多說話人場景下自動影片配音的測評結果。

從結果(如表 2 所示)可以看出, Neural Dubber 在音訊質量方面明顯優於 FastSpeech 2,展示了 ISE 在多說話人場景中的有效性。定性和定量評估表明,在音影片同步度方面,Neural Dubber 比 FastSpeech 2 好得多,並且與 GT (Mel + PWG) 系統相當。這些結果表明,Neural Dubber 可以解決比單說話人場景更具挑戰性的多說話人場景下的自動影片配音(AVD)問題。

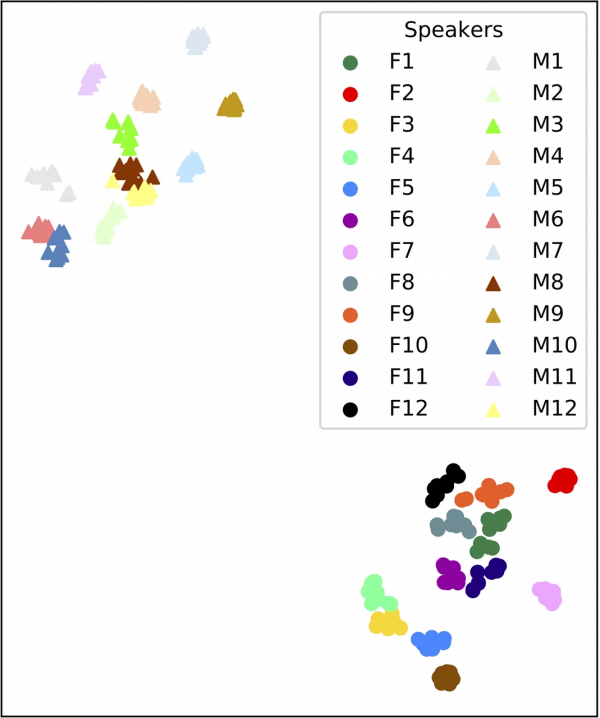

為了展示 ISE 使得 Neural Dubber 能夠透過人臉影象控制生成語音的音色。該研究用 Neural Dubber 生成了一些由不同說話者人臉影象作為輸入的音訊片段。研究者從 LRS2 資料集的測試集中隨機選擇 12 名男性和 12 名女性進行評估,每個人選擇了 10 張具有不同頭部姿勢、光照和化妝的人臉影象。

圖 4: 說話人嵌入的視覺化。

從圖 4 可以看出,由同一說話人的影象生成的語音形成一個緊密的簇,不同說話人的簇彼此分離。此外,由不同性別的人臉影象合成的語音之間存在明顯差異。

與基於嘴部運動的語音生成方法的對比

與基於嘴部運動的語音生成(Lip-motion Based Speech Generation )模型 Lip2Wav 對比,Neural Dubber 在自動影片配音任務下的優越性十分顯著。

研究者使用 STOI 和 ESTOI 來評估語音可懂度,使用 PESQ 來評估語音質量,使用單詞錯誤率 (WER) 評估語音發音準確度。

表 3: Lip2Wav 和 Neural Dubber 在單說話人場景下的比較。

如表 3 的結果所示,Neural Dubber 在語音質量和可懂度方面均超過 Lip2Wav。最重要的是,Neural Dubber 的 WER 比 Lip2Wav 低 4 倍左右。這表明 Neural Dubber 在發音準確度上明顯優於 Lip2Wav。Lip2Wav 的 WER 高達 72.70%,說明它誤讀了很多內容,這在 AVD 任務中是不可接受的。總而言之,Neural Dubber 在語音可懂度、音質和發音準確度方面明顯優於 Lip2Wav,更適合自動影片配音任務。

清華大學 MARS Lab 多模態學習實驗室簡介:MARS Lab 多模態學習實驗室,是清華大學交叉資訊院下的交叉學科人工智慧實驗室,由趙行教授組建和指導。團隊特別感興趣如何讓機器像人一樣的能夠透過多種感知輸入進行學習、推理和互動。團隊的研究涵蓋了多模態學習的基礎問題及其應用。

位元組跳動智慧創作語音團隊簡介:位元組跳動智慧創作 - 語音團隊 (Speech, Audio and Music Intelligence, SAMI) 致力於語音、音訊、音樂等技術的研發和產品創新,使命是透過多模態音訊技術賦能內容創作和互動,讓內容消費和創作變得更簡單和愉悅。 團隊支援包括語音合成、音訊處理和理解、音樂理解和生成等技術方向,並以中臺形式服務於公司眾多業務線以及向外部企業開放成熟的能力和服務。

專案主頁:https://tsinghua-mars-lab.github.io/NeuralDubber/