2021 年 10 月 13 日,來自麻省理工學院、加州大學伯克利分校、伊利諾伊大學香檳分校、華盛頓大學、帝國理工學院的六名頂級人工智慧科學家、計算機視覺科學家在 ICCV 2021 大會期間進行了題為「A discussion about deep learning vs classical methods and their roles in computer vision」的學術討論。

參與討論的嘉賓包括 Aude Oliva(MIT-IBM Watson 人工智慧實驗室)、Svetlana Lazebnik(伊利諾伊大學香檳分校)、Jitendra Malik(加州大學伯克利分校)、Andrew Davison(帝國理工大學)、Richard Szeliski(華盛頓大學)、Alexei Efros(加州大學伯克利分校)。

01 深度學習 vs 傳統方法

Richard Szeliski 首先拋磚引玉,發表了題為「Deep vs Classical Methods」的簡短演講。Richard 提到,在設定人工智慧專業課程時,一個廣為討論的話題是:我們是否應該講授深度學習之前的傳統方法?還是直接透過深度學習解決所有的問題?

為此,Richard 在過去的四年中持續更新他的計算機視覺教科書(https://szeliski.org/Book)。相較於早先的版本,該書加入了訊號處理、最佳化技術等章節,這些知識經常被用於計算機視覺的各個領域。在「Deep Learning」和「Recognition」兩個章節中,Richard 分別介紹了深度學習的基本原理(傳統的網路架構),以及一些更加複雜的技術(例如,分割、目標檢測、視覺和語言)。

實際上,在華盛頓大學「計算機視覺」的課程安排中,老師們會首先介紹經典的訊號處理演算法,接著介紹神經網路和深度學習。在此基礎上,老師們會進而講解一些經典的技術和應用(例如,3D 計算攝影、神經渲染等)。

密歇根大學的計算機視覺課程 EECS 442 將期中的很大一部分內容設定為深度學習相關的內容,但在此之前也會介紹經典的訊號處理、特徵提取技術。最後,教師會講解 3D 視覺和經典計算機視覺的內容。此外,這門課的任課教師 Justin Johnson 還專門針對神經網路開設了一門課程,更為詳細地介紹了迴圈神經網路、Transformer 等內容。

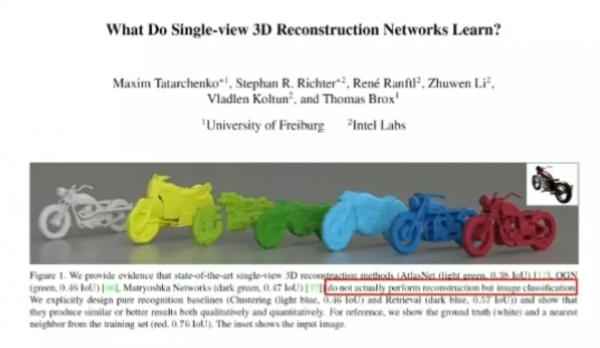

儘管深度學習已經成為了計算機視覺領域的主流方法,但是僅僅依靠深度學習技術是否能解決所有的計算機視覺問題呢?在論文「What Do Single-view 3D Reconstruction Networks Learn?」中,在基於 ShapeNet 進行 3D 重建時,網路只是在識別物件的類別,然後細化形狀,並沒有很好地利用影象的底層資訊。

以視覺定位任務為例,一些基於深度學習的方法只是記住了圖片出現的場景,在定位時進行猜測。如果查詢並沒有沿著路徑,則迴歸的結果可能始終會被引導到出發點。該過程中並沒有任何的 3D 推理,沒有利用 3D 幾何結構。

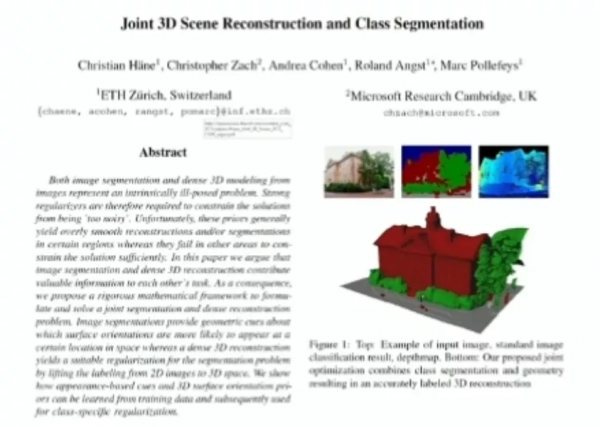

另一方面,利用語義資訊完成 3D 重建等任務也是一條很好的思路。論文「Joint 3D Scene Reconstruction and Class Segmentation」發表於 2013 年,那時是深度學習興起的早期階段。透過識別建築和樹的部位,該方法可以更好地進行 3D 重建,這說明有時引入語義資訊是十分有效的。

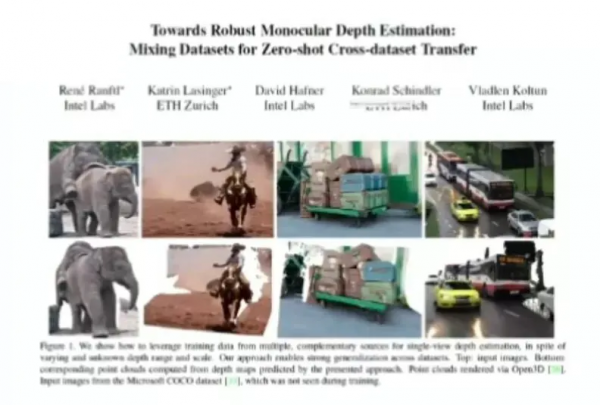

在單目深度估計任務中,我們往往在 KITTI 資料集或一些駕駛場景中進行訓練和測試。大多數的神經網路模型只是識別物體在影象中的位置,然後為其賦予一個相應的深度。如果我們將一個網路沒見過的物體(例如,冰箱或狗)放在路的中間,神經網路可能會完全忽略掉該物體。在駕駛場景下使用這種神經網路模型的安全性值得商榷。

當我們可以用一個很大的資料集訓練時,神經網路往往可以表現出很好的效能。然而,如果我們在某個資料集上訓練網路,該網路在不被重新訓練的情況下會在另外的資料集上表現出怎樣的效能?

經典方法(例如光流法)和用於提取特徵的神經網路技術可以很好地結合起來。因此,許多深度學習技術使傳統方法獲得了新生。論文「PWC-Net」的作者使用前饋神經網路代替了經典的能量最小化方法,該模型執行速度更快,也更可靠。此外,在論文「Fast Image Processing with Fully-Convolutional Networks」中,作者使用全卷積網路代替一系列經典的計算攝影技術,加速了其運算過程。

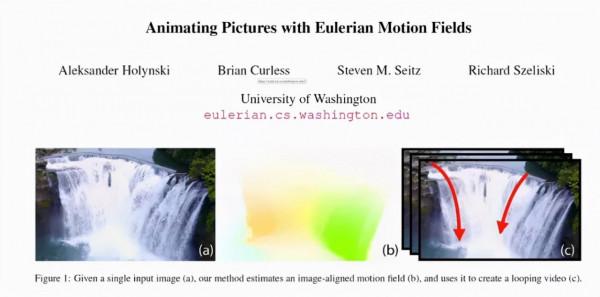

在論文「Animating Picture with Eulerian Motion Fields」中,Richard 等人透過提取神經網路特徵,接著將這些特徵解碼為彩色畫素來合成影象。

在 Richard 看來,從事 CV 研究的學生和工程師不僅僅要會使用深度學習方法,也要學習其它型別的 CV 技術。如果我們可以從數學上對幾何、光學、物理等性質建模,就要大膽地使用這些方法,它們的效能和泛化能力更強。尤其是當我們擁有的資料十分有限時,使用基於學習的方法就要特別小心。有時,神經網路及其特徵提取過程相較於傳統方法更快。

Richard Szeliski 是華盛頓大學的兼職教授、美國國家工程院院士、ACM Fellow和 IEEE Fellow。Szeliski 在計算機視覺、基於影象的建模、基於影象的渲染和計算攝影的貝葉斯方法領域進行了開創性的研究,這些領域處於計算機視覺和計算機圖形的交叉點。

Szeliski 1988 年獲得卡內基梅隆大學計算機科學博士學位。他於 2015 年加入 Facebook,擔任計算攝影小組的創始董事,並於 2020 年退休。在加入 Facebook 之前,他在微軟研究院以及其他幾個工業研究實驗室工作了二十年 。

他在計算機視覺、計算機圖形學、神經網路和數值分析方面發表了 180 多篇研究論文,並撰寫了《計算機視覺:演算法與應用》和《低階視覺不確定性的貝葉斯建模》。他是 CVPR'2013 和 ICCV'2003 的程式主席,曾擔任 IEEE Transactions on Pattern Analysis and Machine Intelligence 和 International Journal of Computer Vision 編委的副主編,以及Foundations and Trends in Computer Graphics and Vision的創始編輯。

02 在馬爾CV三層次之前,先回答廷伯根四問

計算機視覺是「數學」、「科學」、「工程」的結合。許多論文將這些元素融合在了一起。

David Marr 最重要的觀點是將視覺作為一種科學來思考。上世紀 70 年代末期,他指出我們應該從三個層次理解計算機視覺任務:(1)計算理論:底層的物理約束(2)演算法(3)硬體上的演算法實現。實際上,早在上世紀 50、60 年代,1973 年的諾貝爾生理和醫學獎得主、生物學家廷伯根就做了一系列工作,有助於我們在如今思考基於學習的計算機視覺和傳統方法之間的關係。

簡而言之,廷伯根最為著名的貢獻是圍繞動物展現出特定行為的方式和原因提出了四個基本問題:(1)行為的動因和機理(2)行為隨年齡、經驗、環境的發展(3)進化對行為的影響(4)行為對生存的作用。

試想一下,人類視覺系統如何感受到「深度」?

從機理層面上來說,神經網路中存在視網膜、感光神經元等元件,它們會產生多層計算。我們看到的兩幅(雙目)圖的差別讓我們可以感受到「深度」。

從行為發展(發育)的角度來說,嬰兒初生之時,其感官系統並不能很好地工作,隨著時間的遷移,孩子會學會一些技能,學會觀察物體的運動。那麼,在現實世界中,我們應該如何訓練這樣的神經網路?

以上兩個問題與行為的方式(How)有關,但是我們還需要回答關於「Why」的問題,探究人類為什麼會發展出這樣的行為。從生物進化的角度來說,發展出雙目系統的捕食者可以捕獲只有一側有眼睛的獵物。從功能的角度來說,這些行為對物種的生存是有益的。

從計算機視覺的角度來看,我們需要思考如何構建某種神經架構來捕獲這些資訊,還需要考慮究竟是使用監督學習、無監督學習,還是自監督學習來完成該任務。上述這些問題是互補的。

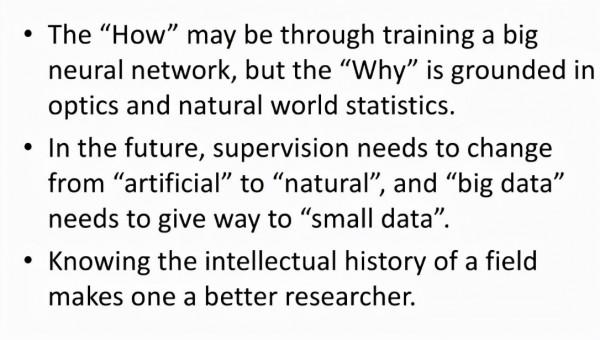

在 Jitendra 看來,我們可以透過訓練一個大型的神經網路來獲得工程應用所需要的能力。但是其背後的原理需要透過光學和自然世界中的統計結果來解釋。這有助於我們應對計算機視覺領域發生的巨大變化。如今,我們正處於從監督學習正規化轉向自監督學習、弱監督學習等正規化的過程中。

此外,我們正處於大資料的「陷阱」中。未來,監督訊號將從「人工」走向「自然」,我們使用的「大資料」在更多情況下將轉變為「小資料」。因此,少樣本學習是十分重要的,而這就要求我們設計更多新的網路架構。

溫故而知新,瞭解智慧學科的發展歷史有助於我們成為更好的研究者!

Jitendra Malik 1986 年 1 月加入加州大學伯克利分校,他目前是電氣工程和計算機科學系的 Arthur J. Chick 教授。他還是生物工程系、認知科學和視覺科學組的教員。2002-2004年任計算機科學系主任,2004-2006年和2016-2017年任EECS系主任。2018 年和 2019 年,他在 Menlo Park 擔任 Facebook AI Research 的研究總監和站點負責人。

Malik 教授的研究小組致力於計算機視覺、人類視覺計算建模、計算機圖形學和生物影象分析等許多不同的主題。

他於 1980 年獲得 IIT Kanpur 電氣工程最佳畢業生金獎,並於 1989 年獲得總統青年研究員獎。他的論文獲得了無數最佳論文獎,其中包括五項時間檢驗獎 - 因在 CVPR 發表的論文而獲得的 Longuet-Higgins 獎(兩次)和在ICCV發表的論文而獲得的 Helmholtz 獎(3次)。他獲得了 2013 年 IEEE PAMI-TC 計算機視覺傑出研究員獎,2014 年 K.S.國際模式識別協會傅獎、2016年ACM-AAAI艾倫紐厄爾獎、2018年IJCAI人工智慧卓越研究獎、2019年IEEE計算機學會計算機先鋒獎。他是 IEEE Fellow和 ACM Fellow 。他是美國國家工程院院士和美國國家科學院院士,美國藝術與科學院院士。

03 討論環節

Q1:這十年來,從經典方法到深度學習方法的轉變是如何發生的?請問 Svetlana,在你的研究過程中,這一過程是自頂向下的,還是自底向上的?也就是說,導師們發現了深度學習的強大,並將其介紹給了學生們;還是學生們將這一技術推薦給了導師?

Svetlana:我的經歷也許與許多研究者相似。我記得「Alexnet」是深度學習時代到來的重要里程碑,它在 ImageNet 競賽中一舉奪冠,並在 ECCV 2012 上發表了研究論文。Alexei 當時還和 Yann LeCun 等人就此事進行了爭論,Alexei 對神經網路持懷疑態度,他認為用這些網路進行分類任務並不具有說服力,使用神經網路完成檢測任務才可以說服他。就我個人而言,一開始我也懷疑自己是否能夠參與這類研究,因為這些方法就好像魔法,其中有太多的奧秘。我不知道這些結果是否可以復現,是否會被研究社群所接受。

令人高興的是,這些年過去了,我的懷疑被證明是錯誤的。人們發明了 Caffe 等好用的程式包,2013、2014 年前後,學生們開始研究此類方法,那時你甚至只需為自己的特定資料集訓練一個 Alexnet 或者使用現成的特徵就可以發表研究論文。而如今,研究走進了深水區,競爭越來越激烈,我又變得悲觀了起來。

Svetlana Lazebnik 在2006 年獲得伊利諾伊大學計算機科學博士學位。2007 年至 2011 年在北卡羅來納大學教堂山分校擔任助理教授後,她返回伊利諾伊大學任教,目前擔任計算機科學系正教授。她獲得的獎項包括 NSF CAREER 獎(2008 年)、微軟研究院研究獎(2009 年)、斯隆研究獎(2013 年),並當選 IEEE Fellow(2021 年)。她於2006年發表在 CVPR 的關於空間金字塔匹配的論文獲得了 2016 年 Longuet-Higgins 獎,該論文對計算機視覺有重大影響。她曾擔任 ECCV 2012 和 ICCV 2019 的程式主席,目前擔任國際計算機視覺雜誌的主編。她的主要研究主題包括場景理解、大規模照片集的建模、影象和文字的聯合表示以及視覺識別問題的深度學習技術。

Q2:Lana 提到了當年 Alexei 和 Yann 爭論的軼事,請問 Alexei 現在回過頭怎麼看待當時的爭論?

Alexei:2011 年前後,我曾去紐約大學呆了幾個月,在 Yann LeCun 那裡試圖理解神經網路。那時,我認為人們還沒有準備好步入深度學習時代,神經網路在 ImageNet 上的效果並不能說服我,我認為分類任務比檢測任務簡單得多。然而,大概一年之後,RCNN 橫空出世,他們證明了深度學習在檢測任務上也是可行的。

我是一個非常保守的研究者,不會輕易投身於所謂的研究潮流(例如,圖模型、VAE 等)中。儘管我和 Jitendra 等人做了很多與深度學習的誕生相關的關鍵工作,但是我那時沒有立刻開展深度學習研究。我一直在等待深度學習成為一種工具,我所擅長的是解決視覺問題,而非研究網路架構。

後來,我和同事們聽說神經網路受益於 ImageNet 預訓練,在 Pascal 資料集上有很好的效果。然而,Pascal 資料集中的資料分佈與 ImageNet 是截然不同的。因此,我猜想預訓練所帶來的效能提升可能並不是由於 ImageNet 的標籤,而是由於畫素中的資訊。

那時,我對 Jitendra 說 1 年之內會出現一些無需 ImageNet 的標籤來預訓練 RCNN 的工作,這實際上也是自監督學習的動機之一。在 ICCV 2015 上,大量有關自監督學習的文章湧現了出來。如今,自監督學習成為了重要的預訓練方式。

Alyosha Efros(Alexei Efros)是加州大學伯克利分校的教授。他於 2003 年從加州大學伯克利分校獲得博士學位,並在牛津、CMU 和 INRIA/Paris 度過了一段時間,然後於 2013 年回到伯克利。Alyosha 是資料、畫素、最近鄰和簡單有效的事物的忠實粉絲,而對複雜(尤其是機率)模型、語義標籤和語言持懷疑態度。

Q3:Andrew Davison 是 SLAM 領域的專家。請問深度學習對你們研究小組的工作有何影響?

Andrew:我很早就聽說過深度學習相關的研究,但那時這與我的研究興趣相去甚遠。直到 2016 年,我才在論文中加入了深度學習的相關技術,用它來解決一些之前難以解決的問題,向 3D 地圖加入一些語義資訊。在深度學習出現之前,我們可能會透過隨機森林等方法來完成該任務。在當時,深度學習這類新的技術取得了巨大成功,人們開始常識使用該技術進行深度估計等任務。相較於傳統方法,深度學習技術有時更快也更準確。

因此,我們開始研究如何在 SLAM 領域使用深度學習技術代替手動設計的先驗,在這個方向發表了一系列文章。具體而言,我們透過深度學習進行深度預測和多檢視最佳化等工作。然而,大約 2018 年之後,人們發現深度學習技術存在一些系統性誤差,網路預測出的深度和方向可能是錯誤的,我們需要透過多檢視的方式來解決這些問題。在我看來,透過深度學習提取的畫素級特徵向量比手動設計的特徵要更加強大,但有時我們也需要回到更傳統的幾何學、機率化的多檢視最佳化研究上來。

Andrew Davison 是倫敦帝國理工學院機器人視覺教授兼戴森機器人實驗室主任。他的長期研究重點是 SLAM(同步定位和對映)及其向通用「空間 AI」的演變:計算機視覺演算法,使機器人和其他人工裝置能夠對映、定位並最終理解周圍的 3D 空間並與之互動。他與他的研究小組和合作者一直在開發具有突破性意義的系統,包括 MonoSLAM、KinectFusion、SLAM++ 和 CodeSLAM,最近的獎項包括 ECCV 2016 最佳論文和 CVPR 2018 最佳論文榮譽提名獎。他還積極參與將這項技術轉化為實際應用,特別是透過他與戴森合作設計了戴森 360 Eye 機器人吸塵器內部的視覺對映系統。他當選了2017年英國皇家工程院院士。

Q4:Oliva 是人類感知和認知神經科學領域的專家,就你們的領域而言,深度學習對你們的研究帶來了哪些變化?有何前景?

Oliva:在認知神經科學領域,我們對此持樂觀態度,積極擁抱這種改變。事實上,早在 2011 年我很幸運地將實驗室的研究領域從神經科學拓展到了計算機科學。那時,我們開始討論 Alexnet。

從神經科學家的角度出發,我們認為神經網路是複雜的黑盒。我們開發了一系列方法來研究大腦黑盒的功能。當我們看到一些關於人工神經網路的論文時,一些神經科學家認為人工意義上的大腦為我們帶來了一個新的研究領域。他們使用神經科學的方法來研究深度學習模型。

我的研究小組試圖為對深度學習模型中的每一層進行評估,提供一些可解釋性,並在神經科學的啟發下設計一些深度學習模型。此外,我有一些從事計算神經科學的同事開始比較各種物種和人造神經網路,我認為深度學習極大促進了計算神經科學的發展。

Aude Oliva博士是 MIT-IBM Watson AI Lab 的 MIT 主任,也是 MIT Quest Corporate 和 MIT Schwarzman 計算學院的主任,領導與行業的合作,將自然和人工智慧研究轉化為更廣闊世界的工具。她還是計算機科學和人工智慧實驗室的高階研究科學家,她負責領導計算感知和認知小組。她的研究是跨學科的,涵蓋人類感知和認知、計算機視覺和認知神經科學,並專注於所有三個領域交叉的研究問題。

Q5:在機器機器學習、計算機視覺、自然語言處理等任務中,有一些不易察覺的研究領域正在悄然萌芽。「幾何深度學習」就是其中一個研究方向,相較於傳統的 CNN,幾何深度學習引入了一些其它型別拓撲的歸納偏置,為編碼先驗知識提供了新的方式。幾何深度學習有助於傳統方法在深度學習時代煥發新生。另一方面,「具身人工智慧」(行為主義人工智慧)也是具有廣闊前景的研究方向。請問在深度學習領域中,未來有哪些具有潛力的研究方向?

Jitendra:我曾經與同事們針對圖神經網路開展過一些研究。我認為,這一領域的研究將會與如今的 Transformer 結合起來,這是因為 Transformer 可以更將靈活地透過位置編碼等方式構建各種約束。我認為,人們對此類架構的研究正在進行中,我們還沒有看到其最終的形態。CNN 和 Transformer 在近年來掀起了兩波研究浪潮,今後還會有更多新的思路會引入其它的歸納偏置。在我看來,引入合適的歸納偏置對於解決少樣本學習問題十分重要。

就我個人而言,我對具身人工智慧的研究充滿熱情,我認為深度學習與其是相輔相成的。如前文所述,計算機視覺領域的問題可以被劃分為多個層次,我們不應混淆它們。深度學習的強大之處在於,我們可以將一些可微的引數化的功能模組連線起來,使用 SGD 等方法進行梯度下降訓練。神奇之處在於,這些過引數化的模型確實奏效,它們往往不會被困在區域性最小值,可以在許多工上取得成功。深度學習的成功與你是否使用監督學習、自監督學習、強化學習無關。

我認為,具身人工智慧是人工智慧的另一個層次,它將視覺和動作結合了起來。典型的應用場景包括機器人、AR 等,人們需要投入更多的資金和資料,來實現這個 1950 年代就產生的夢想。

Q6:以前,計算機視覺工程師們需要花費大量時間設計針對特定領域、特定物體的運算元、時空度量。但現在,「特徵工程」在有些研究者眼中或許已經稍顯落伍了。現在流行的對比學習等方法用到了一些特徵增強手段。或許,未來特徵增強也會落伍,如何看待這種變化?

Svetlana:我對此持開放態度。從長遠的角度來看,研究社群需要保持繁忙。15 年前,大家都在設計手工的運算元,現在大家都在做手工的神經網路設計、資料增強,也許在下一個 5 到 10 年,大家都會投身到手工設計元學習技術。我認為這都是可以接受的,重點在於要保持大的研究願景。

實際上,和計算機視覺一樣,神經網路也有著悠久的歷史,Alexnet 等模型的誕生也有其歷史淵源。神經網路只是我們可以利用的工具之一,我們要做的是維持合適的概念框架,讓各種工具發揮作用。

Alexei:除了 ICCV 之外,計算機視覺領域還有一個頂級會議叫做 CVPR(computer vision and pattern recognition)。我認為這個名字起的非常好,因為我們的研究一方面涉及計算機視覺、另一方面也涉及模式識別。在我看來,這兩個部分分別對應是否需要使用資料。

我曾經去牛津大學做過博士後研究,VGG 組確實是做幾何計算機視覺的好地方,但是計算機視覺和模式識別並不應該嚴格地被二分開來。我們需要意識到的是,資料是非常重要的,但資料也並不是全部,我們要將 CV 和 PR 結合起來。

Q7:相對而言,深度學習對 SLAM 研究社群的影響似乎還沒有那麼大。實際上,目標跟蹤和各種濾波器也可以被用於 SLAM 領域。如何看待 SLAM 領域中各種工具的變化呢?

Andrew:我認為這些工具仍然在發展中。但是顯然,深度學習在 SLAM 領域中並沒有完勝傳統方法。我個人喜歡從整體應用的角度來思考 SLAM 問題,它是具身 AI 或實時感知、三維場景理解的一部分。在擁有足夠的資料、網路規模足夠大的情況下,人們也許會透過端到端的學習識別地圖,建立模型。具體的實現細節(基於學習技術或人工設計)都只是一些計算的模式,相較於此,我更加關注整體過程的可行性。我更加關注如何將這些技術融入到整體的計算框架中,解決有趣的問題。

Richard:正如 Lana 所說,神經網路的歷史可以追溯到上世紀 50 年代。但是神經網路技術直到 2012 年才在大量真實任務上具備可觀的效能。傳統的計算機視覺課程中並沒有深度學習的部分,那時我們會教學生如何設計線性、非線性濾波器。而深度學習方法可以透過多層網路學習出濾波器的權重。

我們可以從分析和經驗兩個方面來看待視覺識別任務。「經驗」指的是神經網路可以記住資料,構建一個在資料中完成內插的系統。然而,這種系統並不一定具有很好的外推能力。如果你可以透過經典的數學、集合、光學方法建模,我認為你需要積極嘗試這些方法,而不應該假設神經網路可以解決任何問題。

Jitendra:我們不妨考慮一下經濟學領域。人類是經濟學中複雜的實體。我們往往會透過機器學習等基於資料的技術來解決經濟學中的預測問題。但是當我們想要理解預測結果時,我們會使用一些簡化的模型進行分析。

我認為,對於未來的深度學習研究而言,對模型的理解是十分必要的。機器學習理論似乎並不能勝任這項工作(例如,雙下降現象)。神經網路似乎在學習過程中會記住資料,形成經驗。現在許多論文所做的工作是針對以往的工作進行資料增強、調整訓練引數,而取得的 1-2 個百分比的效能提升可能是由於完全無關的因素,而不是由於論文所提出的核心思想。

如今深度學習模型正變得越來越大,這樣一來,只有谷歌、Facebook、亞馬遜、微軟這樣的單位可以從事下一代研究,這對研究社群來說並不是一個好的現象。我希望研究社群可以出現一些創新的思路,我們或許可以從歷史中尋找一些靈感。

Q8:現在的深度學習模型引數量越來越大(例如,GPT-3),訓練成本越來越高,我們是否有必要回過頭研究那些曾經看似複雜的傳統方法?如何看待記憶引擎?

Oliva:十年前,我們進行了大量的記憶實驗,讓人們在數小時內看上千張圖片,然後測試他們的記憶。令人驚訝的是,他們可以記住 90% 的影象。我們可以構建一種複雜的系統來研究人類的大腦,構建起認知科學到計算機科學的橋樑,透過實驗的方法來研究這些模型。

--AI科技評論