前不久,亞馬遜科技宣佈全面推出Amazon Elastic Compute Cloud(Amazon EC2)DL1例項,該例項由英特爾於2019年收購的Habana Labs的Gaudi加速器提供支援。

Habana與亞馬遜之間的這項合作其實從去年開始就已經展開了,在去年的Invent大會上,Gaudi就已經打入了亞馬遜的EC2。到了今年10月,採用了Gaudi的AWS EC2例項正式被投入應用,並被命名為DL1例項。這也標誌這亞馬遜首個不基於GPU的AI訓練例項正式被投入使用。

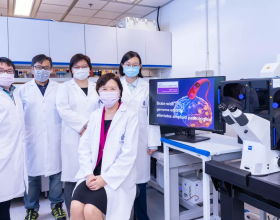

Habana Labs為Amazon EC2 DL1例項搭載Gaudi AI加速器並提供強勁動力,新的例項專為深度訓練模型而設計。(來源:英特爾)

不基於GPU的AI訓練

目前,AI雲端訓練大多是由GPU所支援的,GPU能夠支援更大規模的資料模型,讓AI開發者能夠在更短時間內實現更多AI突破。

而由海量資料構成的AI時代所促生的大量新興應用場景,他們往往更需要針對特定場景所設計的晶片,因此,AI訓練晶片也成為了除GPU以外的選擇。需要注意的是,AI訓練是基於大量資料來構建的,而為了提高模型的預測準確性,資料科學家和機器學習工程師正在構建越來越大、越來越複雜的模型。為了保持模型的預測準確性和高質量,這些工程師需要經常調整和重新訓練他們的模型。而這需要大量的高效能計算資源,也導致了基礎設施成本增加。

從實際情況中看,據Habana介紹,市場上對雲端和本地部署資料中心的AI訓練有大量需求。根據AI/機器學習基礎設施的使用者的反饋中顯示,56%的AI/機器學習客戶表示成本是最大的問題。而Gaudi正是為了解決這個問題而設計的。

“Gaudi是為最佳化AI訓練而定製的處理器,而GPU是以AI工作量為導向的圖形處理器”,Habana Labs中國區總經理於明揚介紹:“Gaudi專為高效和低成本的人工智慧效能而設計,也為人工智慧和可程式設計的Tensor Core Processors(張量核心處理器)而定製。”

亞馬遜方面也同樣公佈了一些關於張量核心處理器的描述,其首席佈道師Jeff Barr表示:“這些是專為ML訓練而設計的VLIW SIMD(超長指令字/單指令多資料)處理單元,TPC是C可程式設計的,儘管大多數使用者會使用更高級別的工具和框架。”

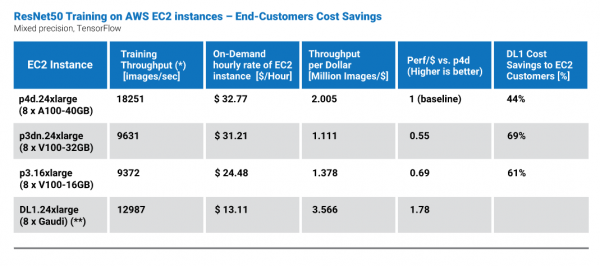

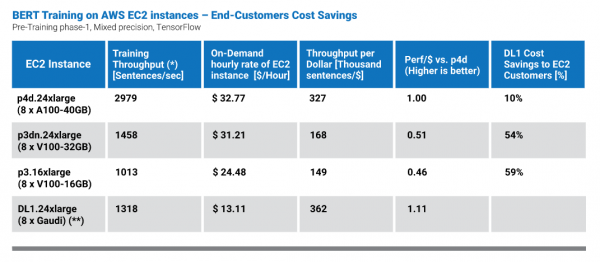

根據英特爾官方資料顯示,定製化的AI訓練晶片與通用GPU相比,新的DL1例項使用專門構建的Gaudi加速器,透過以更低的成本提供更高的計算效率來加速機器學習模型訓練。DL1例項配備多達8個Gaudi加速器、256 GB高頻寬記憶體、768 GB系統記憶體、第二代亞馬遜自定義英特爾至強可擴充套件(Cascade Lake)處理器、400 Gbps網路吞吐量和多達4TB的本地NVMe貯存。

採用了這種設計的晶片,使得Gaudi在效能表現上不輸GPU。所以,當Habana將這些功能進行疊加後,這些創新轉化為比用於訓練常見機器學習模型的最新GPU驅動的Amazon EC2例項高40%的價效比。從而,解決了雲端和資料中心市場在佈局AI訓練時對成本的顧慮。

Gaudi如何實現高性價比

Gaudi的架構採用了全新的設計以提高效率,實現了更高的資源利用率並且包含更少的系統元件,降低了AI訓練成本。

首先從成績上看,Habana在其新聞稿中稱,Habana認識到MLPerf效能基準測試的重要性,使用者可以查詢在6月份釋出的針對8個基於Gaudi的系統進行基準測試的1.0提交結果,與DL1.24xlarge非常類似。

這裡所提到的MLPerf HPC 1.0是用於衡量高效能計算中 AI 效能的行業基準測試,該測試作為業內最權威的AI基準測試,吸引了很多國際廠商、研究機構參與其中,在資料中心推理、邊緣推理、叢集訓練和單機訓練各類AI場景下,不斷突破AI系統性能。

但在此次MLPerf提交結果中,Habana並沒有應用資料封裝或層融合等額外的軟體最佳化功能來提高效能。對此,於明揚表示:“Habana這樣做的原因是公司將重心放在了客戶需求以及 AWS的合作上面。新聞稿中的表格體現了價效比指標,客戶可以瞭解即使沒有這些最佳化,客戶也可以進行更多培訓並減少支出。對客戶而言,重要的是:客戶可以做多少AI訓練,以及花費是多少。”

在這次評估中,我們考慮了兩種流行的模型:ResNet-50 和 BERT-Large。

於明揚補充道:“我們必須積極提升我們的軟體能力。我們現在支援24種流行的AI模型,並且能夠透過我們的Gaudi解決方案集有效地為業界最大的CSP AWS提供服務。”

Gaudi的價值主張立足於價效比和易用性。Habana提供的架構選項旨在提升效率,不會讓終端使用者遷移到Gaudi的工作產生困難。根據Habana官方介紹,客戶可以使用隨附的 Habana SynapseAI SDK 快速輕鬆地開始使用 DL1 例項,該 SDK 與領先的機器學習框架(例如 TensorFlow 和 PyTorch)整合,幫助客戶將他們當前在基於 GPU 或基於 CPU 的例項上執行的現有機器學習模型無縫遷移到 DL1 例項,只需更改最少的程式碼。

除此之外,Habana還建立了開發者社群和開源來支援使用者在“易用性”方面的需求。在這些方面的提高,使得采用Gaudi的AI訓練可以實現較高的價效比。

Gaudi還能做什麼

Gaudi所具有的價效比優勢,也讓很多廠商願意去嘗試採用AI晶片來完成AI訓練。從應用場景上看,Gaudi新例項支援自然語言處理和計算機視覺應用程式,包括物件檢測和影象分類。

Gaudi正在處理的一些應用程式和類別,應用案例具體還包括:

1.物件檢測和分割:缺陷檢測(工業領域)、錯誤檢測和工業管理(零售領域)、醫學掃描和影像(醫療領域)

2.影象分類:自動駕駛汽車細分(交通領域)、照片和影片識別(網站和客戶端領域)

3.自然語言處理:主題查詢、問答處理、情感分析

據瞭解,Gaudi參考模型儲存庫包含 20 個高需求模型。而從Habana所規劃的路線圖來看,Habana還將繼續對其進行擴充套件,包括其軟體功能。

(Habana Gaudi最佳化路線圖)

另外,據Habana團隊透露,他們正在開發下一代Gaudi2 AI處理器,新處理器會將Gaudi架構從16nm提升到7nm。同時,公司方面也表示:“為了我們的最終客戶的利益,進一步提高性價比,同時保持相同的架構和完全利用我們與Gaudi構建的相同SynapseAI軟體和生態系統。”

Gaudi2 AI處理器將於2022年推出,它可以提供7奈米處理器的效率,同時,使用Gaudi最佳化軟體的使用者還將能夠在Gaudi2上使用相同的軟體,最大化使用者已付出的投資。

從Habana與亞馬遜聯手合作,到現在他們之間的合作專案開始逐漸落地,並得以應用,便可以預見雲端AI訓練的一股新勢力正在崛起。