近日,兩年一度的計算機視覺領域頂級學術會議 ICCV (InternationalConference on Computer Vision) 圓滿閉幕。本次大會中,美團入選2篇接收論文,一篇論文獲HTCV研討會最佳論文提名獎,拿下兩項知名挑戰賽亞軍,涵蓋了人臉技術、人體技術、模型最佳化、低功耗等多個領域。並首次聯合中科院計算所、北京智源、巴塞羅那大學共同舉辦了LargeFineFoodAI(大規模細粒度食品分析)技術研討會,吸引了來自不同時區的眾多參會者積極參與及討論,在國際舞臺推動計算機視覺技術應用於食品分析領域,幫大家吃得更好,生活更好。

ICCV是計算機視覺三大頂會中公認級別最高的,其論文錄用率非常低。今年ICCV共收到有效投稿6236篇,1617篇被收錄,接收率僅為25.9%。在這些論文中,中國學者幾乎拿下了“半壁江山”,佔比45.7%,超過第二名美國近一倍,是第三名英國的近13倍。

美團舉辦大規模細粒度食品分析領域研討會 專家齊聚探討人工智慧助力食品健康

研討會由專家特邀報告、挑戰賽彙報及論文報告三個部分組成。在研討會上,專家學者針對食品智慧分析領域給出了有洞察力的剖析及新的問題定義,共同探討了計算機視覺為食品領域賦能的發展方向和應用,促進了計算機視覺、食品科學、營養健康等跨領域的融合。

來自美國加州大學歐文分校教授、未來健康研究所創始主任Ramesh講述了定製化食品模型的重要性。在模型設計中將個人偏好與身體所需的食物進行有效平衡,針對性地給每個使用者推薦最貼合其營養均衡的食物。東京大學資訊與通訊工程系Kiyoharu教授介紹了一款新型的食物日誌工具- FoodLog Athl,它可用於與飲食相關的醫療保健及飲食評估服務,該工具支援食物影象識別、營養膳食評估、食物營養值測算等功能。巴塞羅那大學數學與計算機科學學院Radeva教授探討了不確定性估計的必要性並展示了食品影象識別中不確定性建模的方法。另外,美國卡耐基梅隆大學和普渡大學投稿的論文也被選中在研討會上進行報告。

美團舉辦2項食品領域挑戰賽 推進學術交流

同時,美團還組織了首屆“大規模食品影象識別和檢索”挑戰賽,吸引了國內外眾多有實力的團隊參與,包括清華大學、中國科技大學、南京理工大學、巴塞羅那大學、新加坡南洋理工大學等高校,阿里巴巴、深蘭科技、OPPO、歡聚時代等公司在內的143個國內外團隊參加比賽。

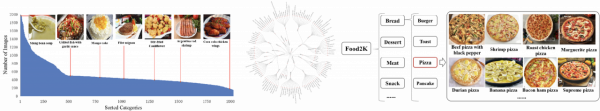

作為國內領先的生活服務平臺,美團率先提出藉助計算機視覺演算法對食品影象進行細粒度分析,快速響應和滿足商戶和使用者大量多樣的線上食品影象稽核、管理、瀏覽、評價等需求。兩個賽道的資料集均源自美團自建菜品影象資料集“Food2K”,包含1,500個類別和大約800,000張影象。其中每張影象均由不同個人,採用不同裝置,在不同環境場景下拍攝獲取,是難得的可以公正評價演算法魯棒性和效果的圖片資料。相比其他主流食品影象識別資料集,“Food2K”完全人工標註,噪聲比控制在1%以內,資料分佈與真實場景相符,並構建了統一的食品劃分標準體系,該體系涵蓋中西方12大類食品下屬的2000類食物(以披薩為例,細分為如鮮蝦披薩、榴蓮披薩等類別)。

食品細粒度識別及檢索技術相比於通用影象識別及檢索難度更大,由於許多不同型別的食品外觀看起來非常相近,而同一種類型的食品由於烹飪方法不同看起來差異較大。另外,光線、拍攝角度、拍攝背景的不同都會對演算法的精度產生影響,即便是專業人員也很難快速準確的進行辨別。最終根據比賽結果及技術方案,來自歡聚時代、南京理工大學、OPPO的參賽團隊分獲識別賽道的前三名,來自深蘭科技、中國科技大學以及OPPO的參賽團隊分獲檢索賽道的前三名。

美團在ICCV2021的成績單:2篇論文被頂會接收、在低功耗及ReID領域研討會上論文被接收,並榮獲挑戰賽亞軍

在本屆ICCV大會上,美團共入選了兩篇論文。分別為:

論文題目:《Trash to Treasure: Harvesting OOD Data with Cross-Modal Matching for Open-Set Semi-Supervised Learning》

摘要:本文針對開集半監督學習場景提出了一個通用的開集半監督影象分類訓練框架,透過設計一個相容影象分類任務目標的多模態匹配機制,為後續半監督影象分類任務剔除無標註資料中的離群樣本,同時使用自監督學習技術,充分利用所有的無標註資料(包含離群樣本),以增強模型特徵提取器對影象高階語義的理解能力。

論文題目:《Learn to Cluster Faces via Pairwise Classification》

摘要:本文提出一種基於配對分類(Pairwise Classification)的快速人臉聚類方法,可以解決大規模資料推理對記憶體的依賴和效率的問題,同時,為降低聚類任務離群點所導致的簇中心估計偏移的影響,提出一種基於位次加權的樣本密度值(Rank-Weighted Density)計算方式,用於指導預測階段配對的選擇,可運用基於k近鄰中位次排序的單調遞減函式給樣本間相似度進行加權,更準確地估計簇中心,進一步提高了聚類的精度。在MS1M、IJB-B等公開資料集上,均取得了SOTA的效能。

在第五屆lpcv低功耗視覺國際比賽和VIPriors行人重識別挑戰賽中榮獲亞軍。

另外,同樣在ReID領域的HTCV研討會上,獲得最佳論文提名獎:

論文題目:《Transformer Meets Part Model: Adaptive Part Division for Person Re-Identification》

摘要:基於區域性劃分的方法已經成為了行人重識別領域的最主流方法,主要有兩種實現方式:一是將行人劃分成幾個固定區域,但是行人影象不對齊會導致效能下降;二是引入額外的行人姿態估計或者行人分割模型,但是需要更多的計算量和標註資料。受到最近Vision Transformer的啟發,本文提出一種自適應的區域性劃分方法,無需額外標註,僅需極少的額外計算量,就可以自動提取不同的重要區域性特徵。目前該方法在Market-1501,CUHK03、DukeMTMC ReID和MSMT17四個最主流資料集上都達到了國際領先水平。

順應AI潮流 為數字中國建設貢獻力量

美團AI以“幫大家吃得更好,生活更好”為核心目標,致力於在實際業務場景需求上探索前沿人工智慧技術,並將之迅速落地在實際生活服務場景中。美團視覺智慧部致力於構建世界一流的視覺核心技術能力與平臺服務。當前,視覺智慧部技術佈局已涵蓋影象處理、文字識別、影片分析、人臉/人體識別、無人駕駛視覺感知等多個領域,在積累了國際/國內領先技術成果的同時,兼顧方法創新與成果轉化,深度賦能零售、智慧交通、物流倉儲、無人配送等業務場景。

" 十四五 " 規劃中提出 : 要堅定不移建設數字中國,加快數字化發展。在數字化浪潮席捲而來的當下,人工智慧將已成為全新賽點,AI也成為中國經濟發展的關鍵一環。美團也正發揮人工智慧技術能力,持續探索更多的應用場景和應用空間,讓更多的使用者享受到科技帶來的紅利,為數字中國建設貢獻力量。