機器之心報道

機器之心編輯部

來自微軟的研究者另闢蹊徑,提出了一種新的計算機視覺基礎模型 Florence。在廣泛的視覺和視覺 - 語言基準測試中,Florence 顯著優於之前的大規模預訓練方法,實現了新的 SOTA 結果。

面對多樣化和開放的現實世界,要實現 AI 的自動視覺理解,就要求計算機視覺模型能夠很好地泛化,最小化對特定任務所需的定製,最終實現類似於人類視覺的人工智慧。計算機視覺基礎模型在多樣化的大規模資料集上進行訓練,可以適應各種下游任務,對於現實世界的計算機視覺應用至關重要。

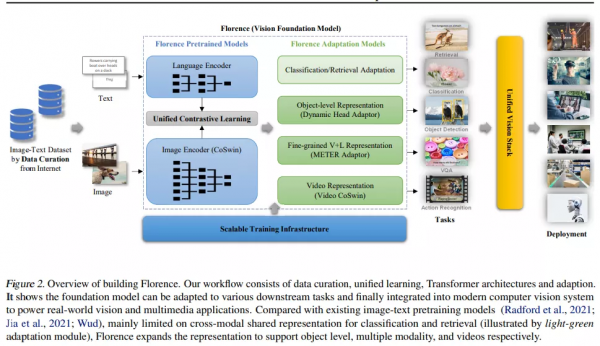

現有的視覺基礎模型,如 CLIP (Radford et al., 2021)、ALIGN (Jia et al., 2021) 和悟道 2.0 等 ,主要側重於將影象和文字表徵對映為跨模態共享表徵。近日來自微軟的研究另闢蹊徑提出了一種新的計算機視覺基礎模型 Florence,將表徵從粗粒度(場景)擴充套件到細粒度(物件),從靜態(影象)擴充套件到動態(影片),從 RGB 擴充套件到多模態。

透過結合來自 Web 規模影象 - 文字資料的通用視覺語言表徵, Florence 模型可以輕鬆地適應各種計算機視覺任務,包括分類、檢索、目標檢測、視覺問答(VQA)、影象描述、影片檢索和動作識別。此外,Florence 在許多遷移學習中也表現出卓越的效能,例如全取樣(fully sampled)微調、線性探測(linear probing)、小樣本遷移和零樣本遷移,這些對於視覺基礎模型用於通用視覺任務至關重要。Florence 在 44 個表徵基準測試中多數都取得了新的 SOTA 結果,例如 ImageNet-1K 零樣本分類任務,top-1 準確率為 83.74,top-5 準確率為 97.18;COCO 微調任務獲得 62.4 mAP,VQA 任務獲得 80.36 mAP。

論文地址:https://arxiv.org/pdf/2111.11432v1.pdf

Florence 模型在有噪聲的 Web 規模資料上以同一個目標進行端到端訓練,使模型能夠在廣泛的基準測試中實現同類最佳效能。在廣泛的視覺和視覺 - 語言基準測試中,Florence 顯著優於之前的大規模預訓練方法,實現了新的 SOTA 結果。

方法

構建 Florence 生態系統包括資料管護、模型預訓練、任務適配和訓練基礎設施,如圖 2 所示。

資料管護

由於大規模資料多樣化對基礎模型非常重要,因此該研究提出了一個包含 9 億個影象 - 文字對的新資料集用於訓練。由於網路爬取資料通常是具有噪音的自由格式文字(例如,單詞、短語或句子),為了獲得更有效的學習,該研究使用了 UniCL,這是 Yang 等人最近提出的「統一影象文字對比學習物件」,這種方法已經被證明其比對比和監督學習方法更優越。

模型預訓練

為了從影象 - 文字對中學習良好的表示,該研究使用了包括影象編碼器和語言編碼器的兩塔式(two-tower)架構。對於影象編碼器,該研究選擇了分層 Vision Transformer 。該研究所提架構在繼承了 Transformer self-attention 操作效能優勢的同時,這些分層架構對影象的尺度不變性進行了建模,並且具有相對於影象大小的線性計算複雜度,這是進行密集預測任務必不可少的屬性。

任務適配

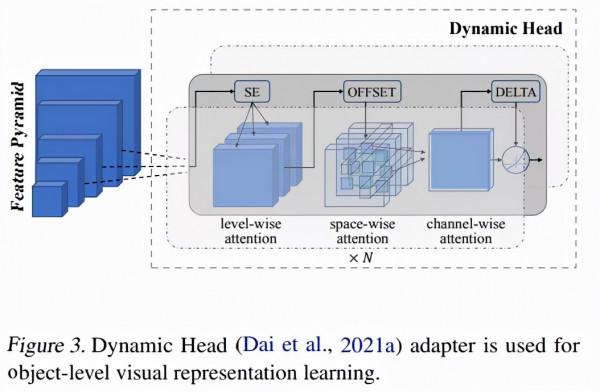

該研究使用 dynamic head adapter(Dai et al., 2021a)、提出的 video CoSwin adapter 從靜態圖到影片的時間、METER adapter 從影象到語言的模態變化,透過以上該研究將學習到的特徵表示沿空間(從場景到物件)進行擴充套件。Florence 旨在透過小樣本和零樣本遷移學習來有效適配開放世界,並透過很少的 epoch 訓練(例如在檢索中)進行有效部署。使用者可以根據自己的需求進行定製。

Dynamic Head (Dai et al., 2021a) adapter 用於物件級視覺表示學習。

圖 4. METER (Dou et al., 2021) 用作 Florence V+L 適配模型,使用影象文字匹配 (ITM) 損失和掩碼語言建模 (MLM) 損失進行訓練。

訓練基礎設施

從能源和成本方面考慮,以儘可能低的成本構建基礎模型是至關重要的。該研究開發了可擴充套件的訓練基礎設施,以提高訓練效率。Florence 訓練基礎設施由 ZeRO 、啟用檢查點、混合精度訓練、梯度快取等多項關鍵技術組成,從而大大減少了記憶體消耗,提高了訓練吞吐量。

實驗結果

該研究進行了多項實驗,表明了 Florence 顯著優於之前的大規模預訓練方法。

分類中的零樣本遷移

該研究在 ImageNet-1K 資料集和 11 個下游資料集上評估了 Florence 模型。表 1 顯示了這 12 個數據集的結果,比較的模型包括 CLIP ResNet 、CLIP Vision Transformer 模型以及 FILIP-ViT,結果顯示 Florence 在其中 9 個數據集上表現出色。該研究在 ImageNet-1K 上的零樣本遷移方面取得了顯著的提高,即 top-1 準確率為 83.74%(比 SOTA 結果高 5.6%),top-5 準確率為 97.18%。

線性評估

線性評估考慮了 11 個分類基準,這些基準同樣也適用於零樣本分類遷移。該研究將 Florence 與具有 SOTA 效能的模型進行了比較,包括 SimCLRv2、ViT、Noisy Student 和 CLIP 。

結果表明,Florence 優於現有的 SOTA 結果,不過在 CIFAR10、CIFAR100 這兩個資料集上效能不如 EfficientNet-L2 。

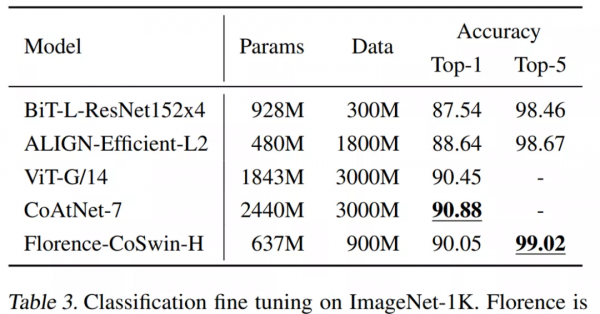

ImageNet-1K 微調評估

該研究在 ImageNet ILSVRC-2012 基準(Deng et al., 2009)上評估了持續微調的效能,Florence 與幾種模型的比較結果如下表 3 所示。Florence 模型的 Top-1 和 Top-5 準確率均優於 BiT(Kolesnikov et al., 2020)和 ALIGN(Jia 等人,2021 年)。Florence 的結果比 SOTA 模型(Dai et al., 2021c)稍差,但其模型和資料規模都比 Florence 大了 3 倍。

小樣本跨域分類

下表 4 顯示了 Florence 模型適應 CDFSL 基準的結果。與採用整合學習(ensembes learning)和直推學習(transductive learning)的挑戰基準獲勝者(Liu et al., 2020,下表中用 CW 指代)相比,Florence 採用單一模型,沒有對測試資料進行轉換,但獲得了更優的結果。

影象 - 文字檢索

表 5 展示了 Florence 在 Flickr30k 和 MSCOCO 資料集上在文字和影象檢索任務上的零樣本遷移和微調效能。結果表明,在這兩個資料集上,Florence 優於之前所有的微調結果。此外,該方法對檢索微調更有效。

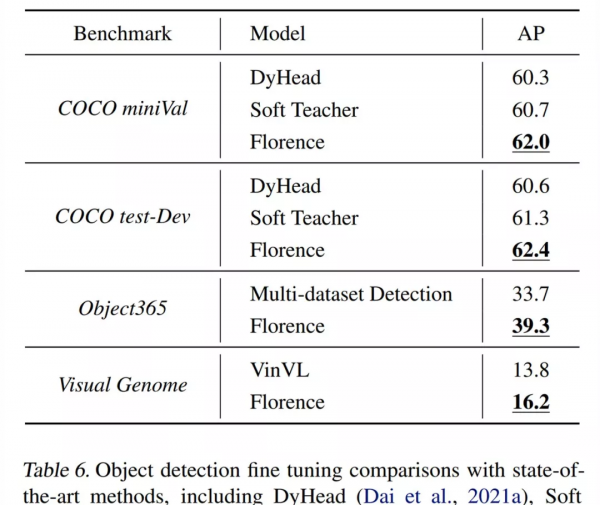

目標檢測和零樣本遷移

目標檢測是計算機視覺中最突出的應用之一。與現有的大規模預訓練模型(如 CLIP、ALIGN 和 Wu Dao 2.0)相比,Florence 更適用於目標檢測任務,因為它的適應性有助於學習物件級視覺表徵。研究者透過微調目標檢測和零樣本遷移任務對來 Florence 的物件級視覺表徵效能進行評估。

具體地,研究者在 3 個流行的目標檢測資料集上評估了微調效能,它們分別是 COCO(Lin et al., 2015)、Object365(Shao et al., 2019)和 Visual Genome(Krishna et al., 2016)。下表 6 展示了與 SOTA 結果的比較,可以看到,Florence 在這些目標檢測基準上取得了新的 SOTA 結果。

為了評估 Florence 對新的、多樣性和麵嚮應用的任務的遷移性,研究者遵循 (Li et al., 2021b) 設計了一個「開放式目標檢測基準」,該基準聚合了來自 Roboflow2 的 11 個公共資料集,涵蓋了細粒度魚類 / 象棋檢測、無人機視野檢測和 thermal 目標檢測等多樣性場景。下表 7 表明,Florence 模型能夠有效地實現到這些任務的零樣本遷移。

視覺語言(V+L)表示學習

研究者在具有挑戰性的 VQA (Goyal et al., 2017) 任務上對預訓練模型進行了微調,該任務是根據影象上下文來回答問題。下表 8 展示了與當前方法的比較,結果表明 Florence 實現的了新的 SOTA 效能。與使用了 1.8B 影象到文字對的 SimVLM 模型(Wang et al., 2021)相比,Florence 僅使用 900M 資料即可以預訓練影象編碼器,20M 資料即可以預訓練視覺語言預訓練(VLP),但取得的結果更好。這也證明了 Florence 的資料效率。

零樣本文字到影片檢索

研究者在 MSR-VTT (Xu et al., 2016) 資料集上執行了零樣本文字到影片評估,他們報告了在 1K-A test(Yu et al., 2018,包含 1k 個影片和字幕對)上的結果, 並在下表 9 中與當前 SOTA 方法進行了比較。結果表明,CLIP6(Radford et al., 2021)和 Florence 這兩個影象到文字預訓練模型在 R@1 指標上遠遠優於其他所有 SOTA 方法。

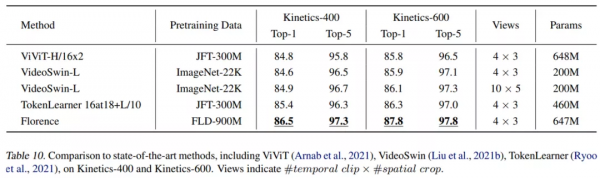

影片動作識別

研究者在微調影片動作識別任務上對 Florence 進行評估。下表 10 展示了 Florence 與當前 SOTA 方法的比較,結果表明在 Kinectics-400 和 Kinectics-600 兩個資料集上,分別比 SOTA 方法提升 1.1% 和 1.5%。