機器之心報道

編輯:澤南

各家廠商都有自己的 AI 晶片,但華為率先做到了從晶片到應用,再到雲服務的高度協同。

手機上的 NPU 推出了四年,時間已不算短,人工智慧應用得怎麼樣了?

現在很多手機晶片上都有 AI 計算單元,每個人都可以有自己的答案。不過用華為手機的人,獲得的體驗經常比其他使用者好一點:他們的手機有更強的訊號,均衡的能效比,還有融合在系統中,提供便利的各種 AI 功能。

華為的產品還支援最新 AI 演算法,你也許會發現,同樣的 App 在華為手機上多了一些專屬的能力,如實時影片超解析度、影片風格遷移、本地化的輸入法預測等等。

今天,人工智慧不是「元宇宙」這樣遙不可及的概念,而是已被每天數億人大量使用的普遍技術,它甚至改變了很多人開啟 App 的方式。

這些 AI 技術的效果超出了人們的最初想象。

用低清流量,看「高畫質影片」

我們對於「影片超解析度」的印象,大多還停留在英偉達 GPU 對於遊戲大作的幀率加成上。自從 RTX 系列顯示卡誕生以來,深度學習超取樣技術 DLSS 大幅提升了玩家的遊戲體驗。這種技術可以透過深度學習把低解析度影象自動「腦補」成高解析度,輸出 4K 解析度的畫面時,只需生成 1080P 的畫面再用 AI 來轉化,可以減小顯示卡負擔,提升效率。

打遊戲有這麼大的提升,在手機上看短影片和直播能不能加入超清效果呢?HUAWEI HiAI Foundation 已經讓很多應用實現了這個能力。

「在超解析度任務上,傳統演算法需要 CPU 和 GPU 對影象進行二次加工計算,功耗極高,效果就像是『調亮了一點』,並不明顯,」華為技術專家表示。「若想解決算力、IO、功耗等問題需要結合 HUAWEI HiAI Foundation 和 NPU 來完成。我們與很多廠商合作,在當前主流的 App 上集成了畫質增強功能。」

原畫面、AI 超解析度演算法和低解析度 + 銳化處理的對比。

今年 3 月,在愛奇藝 App 最新發布的版本中,愛奇藝與 HUAWEI HiAI Foundation 合作,在帶有 NPU 機型的應用上率先提供了「增強畫質」功能。該功能可讓影片在 480P 解析度播放過程中,保持相同流量消耗的情況下體驗到更高畫質品質的視覺效果。

這項功能適配了從 Nova 6 到 Mate 40 系列等多個華為機型。

開啟畫質增強功能後,480P 及以下清晰度的影片可以秒變高畫質,大致相當於 1080P 的水平。

「增強畫質」是基於愛奇藝自研超分演算法部署在麒麟晶片 NPU 引擎(神經網路處理器)和 HUAWEI HiAI Foundation 上的功能,可以在畫面輪廓清晰度、畫面通透性、色彩飽和度等方面實現明顯提升。

透過這一能力,手機可以在本地完成影片實時增強畫質處理,在不影響幀率的情況下把清晰度提升兩倍,有效解決了影片播放卡頓問題,在地鐵或高鐵等訊號弱,網路不流暢的場景下,也能看高畫質影片。

在愛奇藝、優酷等主流影片 App 平臺上,HUAWEI HiAI Foundation 加持的超解析度效能最高可以提升 80%,功耗最高可降低 45%。

在手機上實現異構計算

除了影象技術,手機上還能直接跑一個完整的輸入法預測模型。譬如,在百度輸入法華為版中,其使用的 AI 演算法結構複雜,但透過任務拆分,工程師們把模型推理的計算工作分配到 NPU 和 CPU 上進行異構計算,並進行了極致的最佳化,把輸入法預測任務從雲端完全轉移到了手機上。

百度語音語義的模型技術較新,結構也很複雜,最近的很多 AI 應用都是如此。從最早的 CNN、LSTM,再到近期流行的 Transformer 結構,人們對 AI 專用計算單元的算力需求正在快速提高。另一方面,不同廠家硬體的差別明顯,AI 計算的架構也在不斷演進,如何充分利用好算力是開發者面臨的挑戰。

讓晶片上的 CPU、GPU 和 NPU 協同參與 AI 計算,是目前發展的趨勢。「在語音語義類業務上如果用異構方式執行模型推理,其效能要比單 NPU 或單 CPU 執行提升超過 40% 以上,很多業務適合透過異構方法執行,」華為技術專家表示。「NPU 善於處理 CNN 等經典神經網路,但業界近期獲得應用的網路型別變化較快,很多新模型使用 CPU 加 NPU 聯合計算可以獲得更高效率。」

華為提供的工具可以大幅提升 AI 演算法的執行效率,快手和抖音也因此受益:兩家短影片應用在接入 HUAWEI HiAI Foundation 後模型精度得以提高,透過充分利用算力實現了更加真實的 AI 特效,增加了業務場景。

對於應用開發者們來說,給應用接入異構計算能力並不需要訓練專用的演算法,也不需要重新構建一個 App,只需呼叫幾個介面就可以完成了,如果開發者使用的機器學習平臺接入了 HUAWEI HiAI Foundation,這個過程甚至可以是無感的,開發者無需進行操作即可獲得麒麟晶片 AI 算力的最佳化。

原生 AI 加速,每天執行超 600 億次

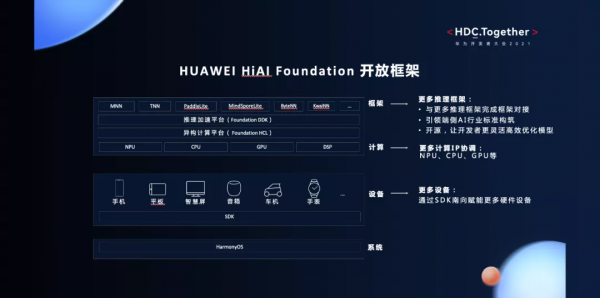

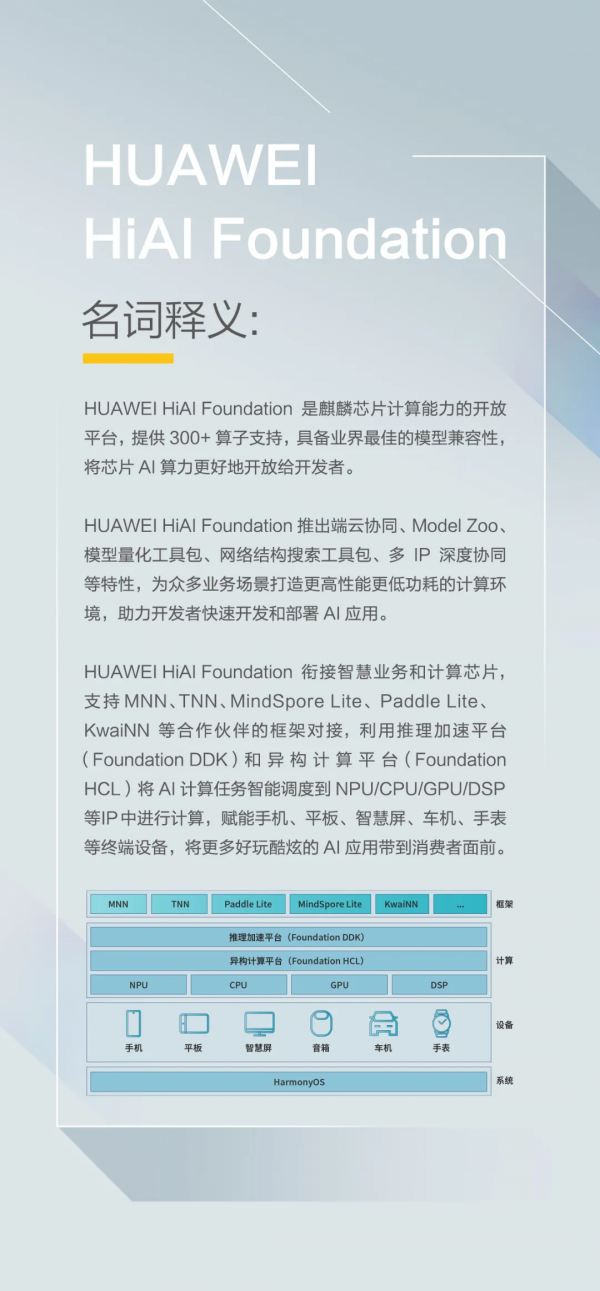

為開發者開啟新世界大門的 HUAWEI HiAI Foundation 是麒麟晶片 AI 計算能力的開放平臺,其目標是全面開放 NPU 能力。它可以自動把開發者手中的 AI 模型輕量化成移動版,整合到 APP 上,並獲得手機晶片異構算力的原生最佳化加速。

2017 年 9 月,華為釋出了首款自帶神經網路計算單元 NPU 的移動晶片麒麟 970。2018 年 3 月,HUAWEI HiAI Foundation 隨之釋出。經過幾年發展,HUAWEI HiAI Foundation 已經從僅支援手機擴充套件到了全場景硬體,還可以做到一次開發多端執行。計算能力上看,則可以協同 NPU/CPU/GPU/DSP 實現異構計算,大幅提升了效率。

在 HUAWEI HiAI Foundation 的最新版本上,新增的能力主要有三個方面:提供 AI 模型效能最佳化快速升級的端雲協同;開放為開發者提供更多可選模型結構的 Model Zoo;還有模型量化工具包,可以快速壓縮 App 中 AI 模型的體積。

經過多代持續打磨,HUAWEI HiAI Foundation 的相容性和易用性已經相當成熟。人們熟知的鴻蒙 OS 的使用者已經超過了 1.5 億,是史上發展最快的終端作業系統。而作為麒麟晶片計算能力的開放平臺,HUAWEI HiAI Foundation 的應用範圍也是前所未有 ,它現在的日呼叫量高達 600 億次。

相比 TensorFlow Lite GPU、Android NN 等端側 AI 計算生態,HUAWEI HiAI Foundation 已經成為了業內最流行的 AI 架構,而且領先幅度正變得越來越大。

每天百億呼叫量意味著海量的智慧業務正在端側應用,充分發揮了麒麟晶片的 AI 算力,為使用者帶來了前所未有的體驗。隨著 AI 生態的不斷演進,技術應用的經驗也會為未來的改進打下基礎,助力下一代晶片的研發。

黑科技:端雲協同

僅僅方便開發,體驗好還不夠。與高通、聯發科等公司提出的工具相比,華為的優勢在於「端雲協同」。

深度學習演算法由很多計算單元組成,我們稱這些計算單元為運算元(Operator,簡稱 Op)。從廣義上講,對任何函式進行某一項操作都可以認為是一個運算元。在深度學習框架中,運算元對應層中的計算邏輯,例如:卷積層(Convolution Layer)中的卷積演算法,是一個運算元;全連線層(Fully-connected Layer)中的權值求和過程也是一個運算元。

對於構建 AI 應用來說,運算元提升了效率,然而大多數手機中的運算元庫集成於系統中,加入新功能要等手機系統幾個月一次的更新,這是很多 AI 新演算法難以落地的原因。

HUAWEI HiAI Foundation 選擇把運算元庫放到雲端,當有新開發的運算元時,只需要對比一下舊的運算元庫,把更新運算元下載到手機端裡就可以讓所有手機支援新技術了。這種端雲協同的方式既提高了開發者工作效率,又擴大了應用範圍,運算元更新的頻率可以和 App 更新的速度同步。

相比之下,其他廠商釋出的深度學習框架,其運算元更新速度通常是以年為單位的。

作為連線底層硬體算力和應用之間的橋樑,HUAWEI HiAI Foundation 目前支援超過 300 個通用運算元,TensorFlow、PyTorch 等主流深度學習框架,國內開源深度學習平臺,以及很多廠商的自用框架。硬體支援從麒麟 810 到麒麟 9000——內建華為自研 NPU 的所有晶片。

從一篇頂會論文到手機上的 App,AI 新技術的引入是一個複雜的工程化過程,需要保證效能、功能要求,進行多輪最佳化。由於海思和華為終端聯合運作的方式,在 HUAWEI HiAI Foundation 上晶片廠商與開發者直接進行合作,在一些關鍵問題上能真正做到效果最優,這是其他競爭對手無法比擬的。

把更多 AI 搬到手機上

HUAWEI HiAI Foundation 未來的發展方向,是讓移動端 AI 模型更簡單、更安全、能效更優,構築全面開放的智慧生態,讓開發者能夠快速地利用華為強大的 AI 處理能力,為使用者提供更好的智慧應用體驗。

機器學習模型在最初的研究階段可能需要泰坦 GPU 進行訓練,A40 進行推理,谷歌能讓機器學會「閱讀理解」的 BERT 模型在剛剛釋出時體積達到了 500MB 但手機 App 上,自然語言處理模型只有 50 到 100MB 的空間,模型必須被大幅壓縮。

HUAWEI HiAI Foundation 推出的 NAS 模型搜尋技術,能讓開發者只需要將自己的模型、資料集作為引數提交給工具,隨後就能透過自動搜尋獲得能在端側執行,效果與原模型效果相當的模型出來。該技術目前主要面向影象識別、分類、檢測等任務,在指定任務中可以自動搜尋出效率最優的模型,且搜尋結果能夠實現在 NPU 上效能、功耗比最優。

另一方面,HUAWEI HiAI Foundation 提供的端側算力讓很多原先必須部署在雲端的演算法落在了本地,所有資料形成閉環,業務資料、照片、語音資訊等敏感內容不離開使用者,保證了資料安全。越來越多的端側 AI,會持續強化這一趨勢。

未來,各類應用對 AI 的需求會越來越擁擠,華為還在繼續努力,讓麒麟晶片帶來更大價值。

2021 年,我國網民人均手機 App 安裝總量是 66 款,每人每天使用 App 的時長已超過 5.1 小時,這是一個前所未有的數字。人工智慧技術帶來的便利,是手機承擔起越來越多工的原因之一。

還記得 2017 年,華為釋出第一款帶有 NPU 的晶片麒麟 970 的時候,有很多人會問「它能做什麼?」現在,問題已經變成了「這件事,麒麟晶片能不能也來做?」

昨天人們還在開的腦洞,已經被 HUAWEI HiAI Foundation 一步步實現了。